Allgemeine Einführung

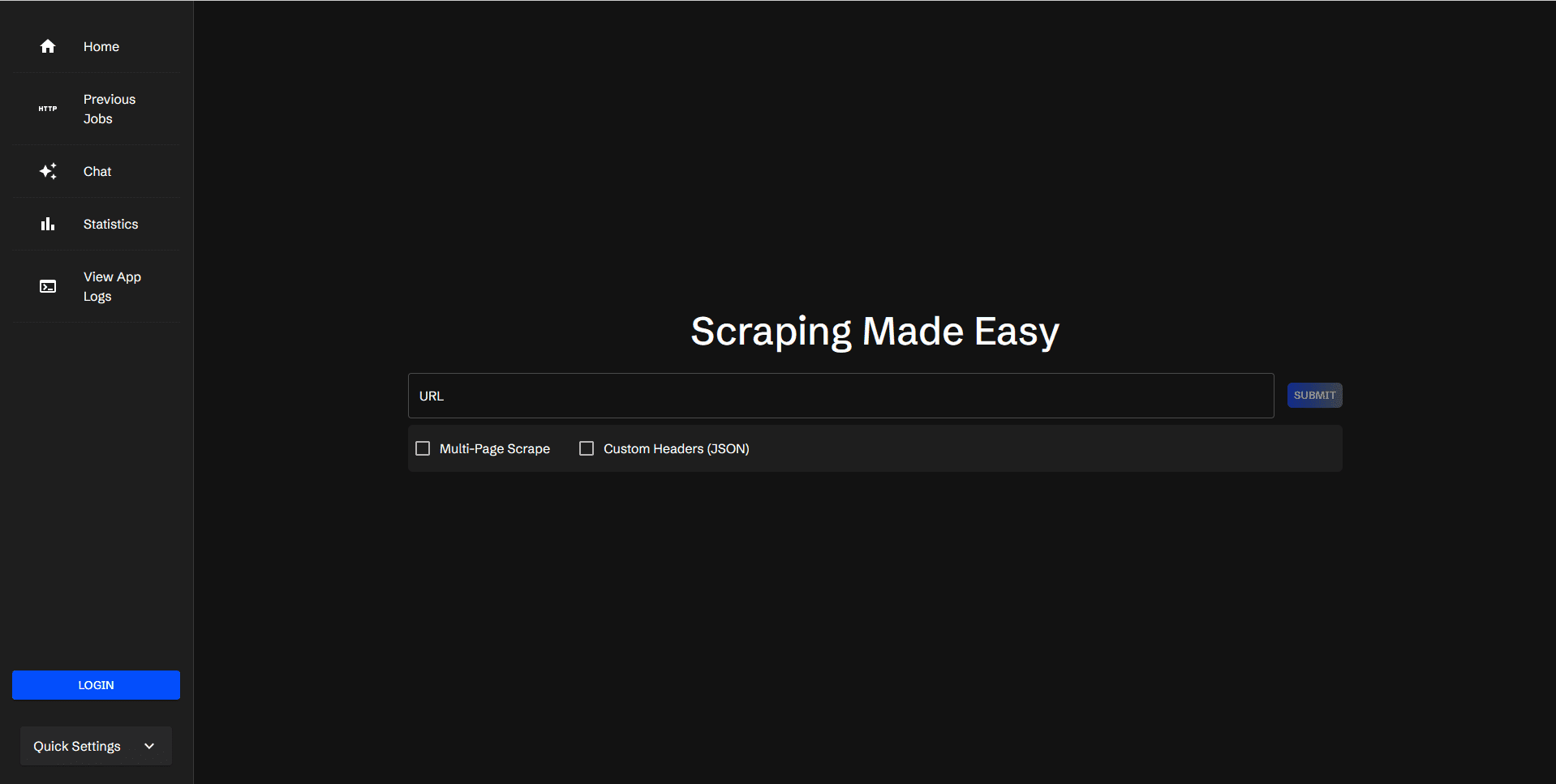

Scraperr ist ein selbstgehostetes Tool zum Scrapen von Webdaten, mit dem Sie XPath-Elemente zum Scrapen von Webdaten angeben können. Benutzer übermitteln eine URL und die entsprechenden Crawling-Elemente, und die Ergebnisse werden in einer Tabelle angezeigt, die als Excel-Datei heruntergeladen werden kann.Scraperr unterstützt Benutzeranmeldung, um Crawling-Aufgaben zu verwalten, und bietet Protokollanzeige und Statistiken.

Funktionsliste

- URLs für Web-Crawling anmelden und in die Warteschlange stellen

- Hinzufügen und Verwalten von Crawl-Elementen mit XPath

- Crawlen aller Seiten unter demselben Domainnamen

- Hinzufügen benutzerdefinierter JSON-Header zum Senden von Anfragen

- Anzeige der Ergebnisse der erfassten Daten

- Laden Sie die CSV-Datei mit den Ergebnissen herunter

- Wiederholen Sie die Erfassungsaufgabe

- Anzeigen des Status von Aufgaben in der Warteschlange

- Setzen von Lesezeichen und Anzeigen von mit Lesezeichen versehenen Aufgaben

- Benutzeranmeldung/-registrierung zur Organisation von Aufgaben

- Anwendungsprotokolle anzeigen

- Aufgabenstatistik anzeigen

- KI-Integration zur Unterstützung der Einbeziehung von Crawl-Ergebnissen im Rahmen eines Dialogs

Hilfe verwenden

Ablauf der Installation

- Klon-Lagerhaus:

git clone https://github.com/jaypyles/scraperr.git - Setzen von Umgebungsvariablen und Tags: In der

docker-compose.ymlDatei, um zum Beispiel Umgebungsvariablen und Bezeichnungen zu setzen:scraper. Bezeichnungen. - "traefik.enable=true" - traefik.http.routers.scraperr.rule=Host(`localhost`)" - "traefik.http.routers.scraperr.entrypoints=web" scraperr_api. Umgebung. - LOG_LEVEL=INFO - MONGODB_URI=mongodb://root:example@webscrape-mongo:27017 - SECRET_KEY=Ihr_geheimer_Schlüssel - ALGORITHMUS=HS256 - access_token_expire_minutes=600 - Starten Sie den Dienst:

docker-compose up -d

Verwendung Prozess

- URL zum Crawlen einreichen::

- Nachdem Sie sich bei Scraperr angemeldet haben, gehen Sie auf die Seite Scraping-Aufgaben.

- Geben Sie die zu crawlende URL und das entsprechende XPath-Element ein.

- Nachdem Sie eine Aufgabe eingereicht haben, stellt das System sie automatisch in die Warteschlange und beginnt, sie zu erfassen.

- Verwalten von Crawl-Elementen::

- Auf der Crawl-Aufgabenseite können Sie XPath-Elemente hinzufügen, bearbeiten oder löschen.

- Unterstützt das Crawlen aller Seiten unter derselben Domain.

- Crawl-Ergebnisse anzeigen::

- Sobald die Erfassung abgeschlossen ist, werden die Ergebnisse in einer Tabelle angezeigt.

- Der Benutzer kann eine CSV-Datei mit den Ergebnissen herunterladen oder die Aufgabe erneut ausführen.

- Aufgabenverwaltung::

- Die Benutzer können den Status von Aufgaben in der Warteschlange überprüfen, Lesezeichen setzen und mit Lesezeichen versehene Aufgaben anzeigen.

- Bietet die Ansicht Aufgabenstatistik, in der Statistiken für ausgeführte Aufgaben angezeigt werden.

- Log-Ansicht::

- Auf der Seite Anwendungsprotokolle können die Benutzer die Systemprotokolle mit detaillierten Informationen über die Erfassungsaufgabe einsehen.

- KI-Integration::

- Unterstützung für die Einbindung von Kriechergebnissen in Dialogkontexte, derzeit unterstützt Ollama und OpenAI.