SadTalker: Fotos zum Sprechen bringen | Mouth Sync Audio | Synthesised Mouth Sync Video | Free Digital People

Allgemeine Einführung

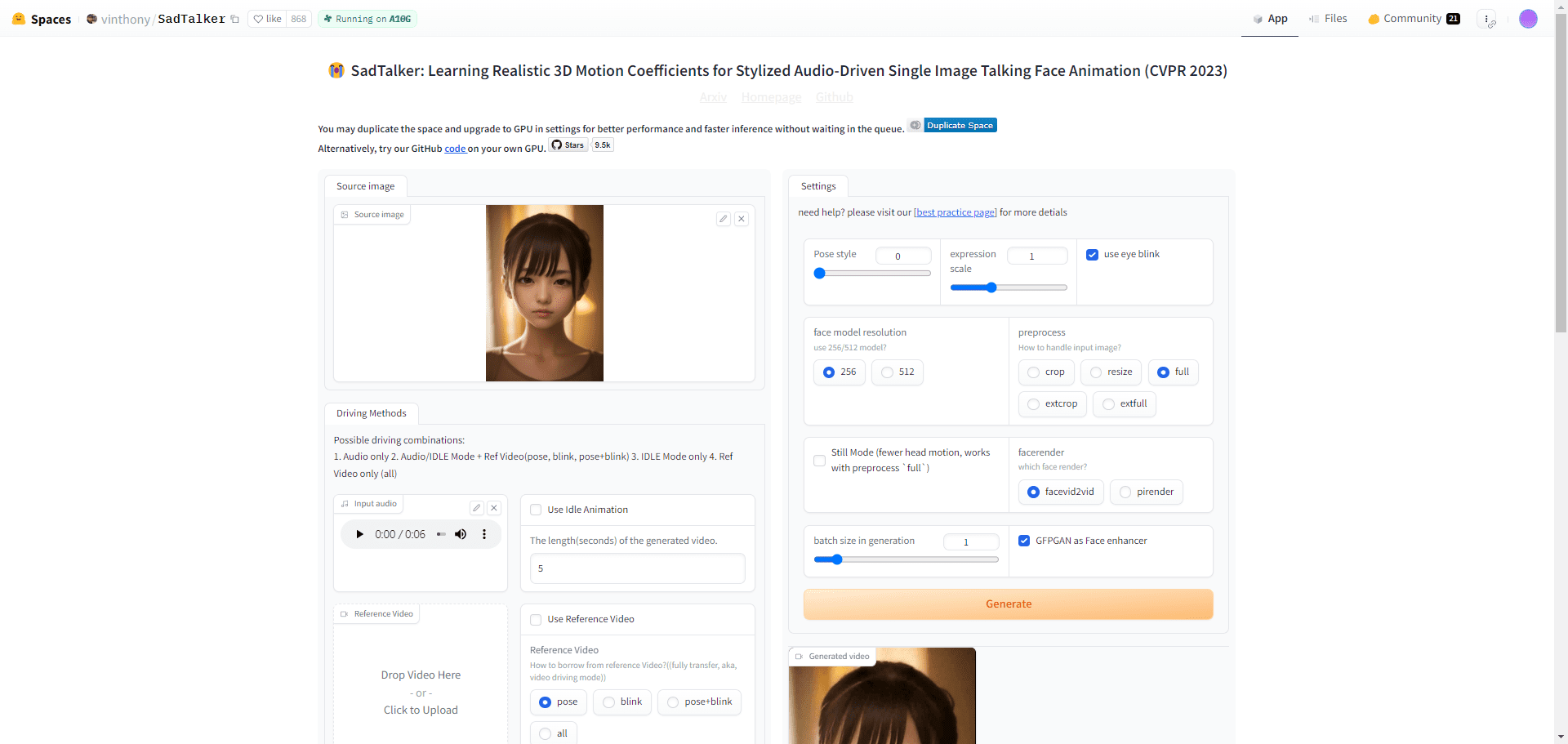

SadTalker ist ein Open-Source-Tool, das ein einzelnes Porträtfoto mit einer Audiodatei kombiniert, um realistische Videos mit sprechenden Köpfen für eine Vielzahl von Szenarien zu erstellen, z. B. für personalisierte Nachrichten, Bildungsinhalte und mehr. Der revolutionäre Einsatz von 3D-Modellierungstechnologien wie ExpNet und PoseVAE zeichnet sich durch die Erfassung von subtilen Gesichtsausdrücken und Kopfbewegungen aus. Benutzer können die SadTalker-Technologie sowohl für persönliche als auch für kommerzielle Projekte wie Nachrichten, Unterricht oder Marketing verwenden.

Empfohlene Erweiterungen:SVLS: SadTalker erweitert, um digitale Personen anhand von Porträtvideos zu erzeugenDer jüngste Neuzugang auf der Liste ist eine videogestützte digitale Person, die von einer fotogestützten digitalen Person zu einer videogestützten digitalen Person aufgerüstet wurde und durch die Einfügung von Bildern flüssiger sprechen kann.

Funktionsliste

Synchronisierung von Gesichtsbewegungen und Mimik mit Hilfe von Audio

- Konvertieren von Porträtfotos in bewegte Videos

- Synchronisierte lippensynchrone Animation von Audiodateien

Unterstützt Ganzkörpermodus und Ausdrucksverstärkerfunktion

Bietet eine konfigurierbare WebUI-Schnittstelle

Die Technologie kann über die Discord-Integration genutzt werden

Bereitstellung einer detaillierten Entwicklungs- und Nutzungsdokumentation

Unterstützt Windows, Linux/Unix und macOS

Hilfe verwenden

Installieren Sie die erforderlichen Programme Anaconda, Python und git

Folgen Sie der Dokumentation, um die Umgebung zu installieren und das Modell herunterzuladen

Erstellung von Animationen über die native WebUI oder die Befehlszeilenschnittstelle

Achtung!

- Wählen Sie ein klares, frontales Porträtfoto für beste Ergebnisse

- Verwenden Sie klare Audiodateien, um eine genaue Lippensynchronisation zu gewährleisten.

Abhängig von den im Internet verfügbaren Ressourcen sind hier die grundlegenden Schritte zur Verwendung von SadTalker aufgeführt:

- Vorbereitung der Umwelt:

- Wenn Sie keine Python-Umgebung haben, installieren Sie Anaconda.

- Installieren Sie NVIDIA cuda-toolkit, um die GPU-Beschleunigung auf Computern mit NVIDIA-Grafikkarten zu nutzen. Die Verarbeitung wird langsamer, wenn nur die CPU verwendet wird.

- Installation von Modellen und Bibliotheken:

- Laden Sie die erforderlichen Modell- und Bibliotheksdateien herunter und installieren Sie sie. Diese Dateien müssen normalerweise in einem bestimmten Verzeichnis abgelegt werden, zum Beispiel

./checkpoints/vielleicht./gfpgan/weights/.

- Laden Sie die erforderlichen Modell- und Bibliotheksdateien herunter und installieren Sie sie. Diese Dateien müssen normalerweise in einem bestimmten Verzeichnis abgelegt werden, zum Beispiel

- Installation der FFMPEG-Videobibliothek:

- Installieren Sie FFMPEG, das für die Erstellung von Videos erforderlich ist.

- Installation der TTS-Sprachumwandlungsbibliothek:

- Installieren Sie die edge-tts-Bibliothek, um Text in Sprache umzuwandeln.

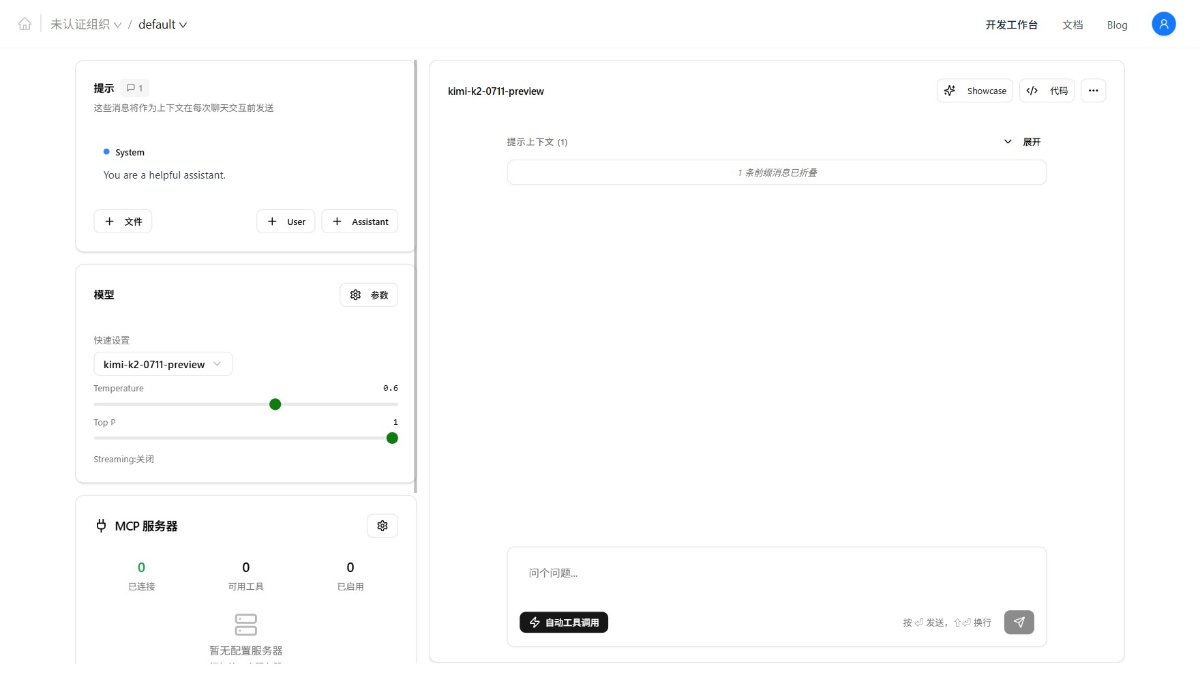

- Verwendung der Web-UI:

- Mit einem Klick auf das

webui.batStarten Sie die Web-UI von SadTalker. - Laden Sie in der Web-UI das Bild in den angegebenen Bereich hoch und legen Sie die Parameter für die Umwandlung der digitalen Person fest.

- Nachdem Sie ein digitales menschliches Video erstellt haben, können Sie die Ergebnisse in der Benutzeroberfläche ansehen.

- Mit einem Klick auf das

- Verwendung der Befehlszeile:

- Wenn mehr Optionen gewünscht werden, kann SadTalker über ein Kommandozeilenskript verwendet werden.

- Wenn Sie die Befehlszeile verwenden, können Sie Folgendes ausführen

task.shDatei zur einfachen Erstellung von Aufgaben.

- caveat:

- Achten Sie bei der Verwendung darauf, dass das Bild von guter Qualität ist, um optimale Ergebnisse zu erzielen.

- Wenn ein Fehler auftritt, z. B.

libiomp5md.dllKonflikte, versuchen Sie, sie in derapp.pySetzen von Umgebungsvariablen inKMP_DUPLICATE_LIB_OK=TRUEum es zu reparieren.

Die obigen Schritte basieren auf Anleitungen im Internet und auf Erfahrungen von Benutzern, und die genaue Vorgehensweise kann variieren. Es wird empfohlen, dass Sie die offizielle SadTalker-Dokumentation und die Community-Tutorials für die aktuellsten und detailliertesten Anleitungen zu Rate ziehen.

SadTalker-Installation

SadTalker Windows Downloads

SadTalker läuft online und kostenlos auf der WebUI

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...