Wie konvertiere ich die von Dify bereitgestellte API in ein Format, das mit der OpenAI-Schnittstelle kompatibel ist?

Ja, das habe ich. Dify Diejenigen unter Ihnen, die Dify kennen, sollten wissen, dass es sich zwar um eine großartige KI-App handelt, die API jedoch nicht mit Open AI kompatibel ist, was es für einige Apps unmöglich macht, eine Schnittstelle zu Dify herzustellen.

Was kann man dagegen tun?

Es ist möglich, "Transit-APIs" zu verwenden, von denen die bekanntesten sind Eine API: Multi-Modell-API-Verwaltung und Lastausgleich, Verteilungssystem Es kann verschiedene KI-Modelle zusammenfassen und sie dann in OpenAI-APIs für den Vertrieb vereinheitlichen, aber es unterstützt noch nicht den Zugang zu Dify, so dass es zwar einen Ausweg gibt, aber das obige Problem nicht lösen kann.

Zu diesem Zeitpunkt ein großer Schuss, auf der Grundlage der One API, um die zweite Öffnung zu tun, ist der Projektname Neue APIDieses Projekt unterstützt Dify vollständig, so dass wir endlich mit der Dify-API spielen können!

Nach erfolgreicher Bereitstellung können wir über IP + Port darauf zugreifen:

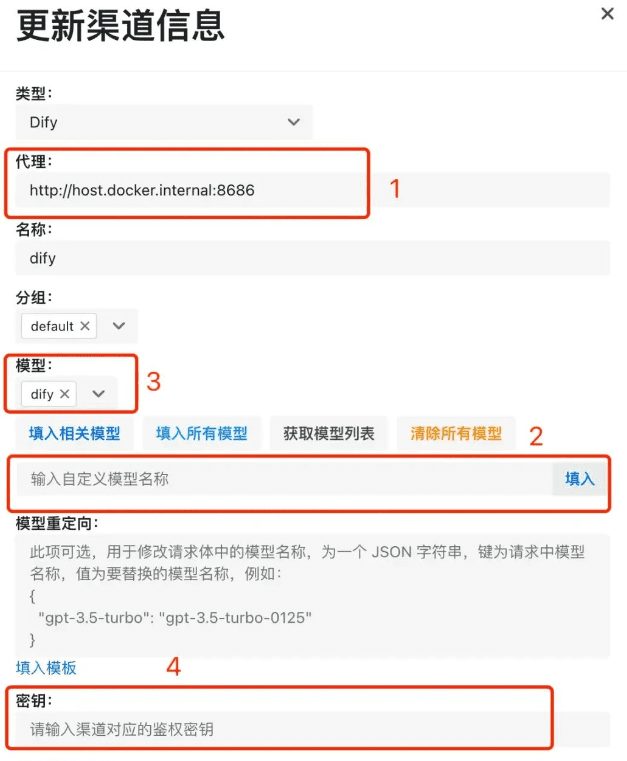

- Nachdem wir den Dify-Typ überprüft haben, müssen wir die Adresse des Dify-Dienstes eingeben. Wenn Ihr new-api-Dienst und dify beide auf einem einzigen Rechner über Docker bereitgestellt werden, dann denken Sie daran, die Adresse des

http://host.docker.internal:你的端口号Der Screenshot ist mein Beispiel, also kopieren Sie ihn nicht einfach. Wenn Sie nicht die Docker-Deployment-Methode verwenden, müssen Sie in den Dify-Dienst diehttp:// ip + 端口号Es kann losgehen; - Da wir auf dify zugreifen, müssen wir für die Modellauswahl lediglich einen benutzerdefinierten Modellnamen eingeben, z. B. dify, und dann am Ende auf die Schaltfläche "Ausfüllen" klicken;

- Unabhängig davon, ob es sich um ein benutzerdefiniertes Modell oder ein anderes ausgewähltes Modell handelt, muss es an Position 3 im Screenshot angezeigt werden, und wenn es nicht angezeigt wird, ist es nicht konfiguriert;

- Nach dem Absenden werden die Daten in der Kanalliste angezeigt ~~

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...