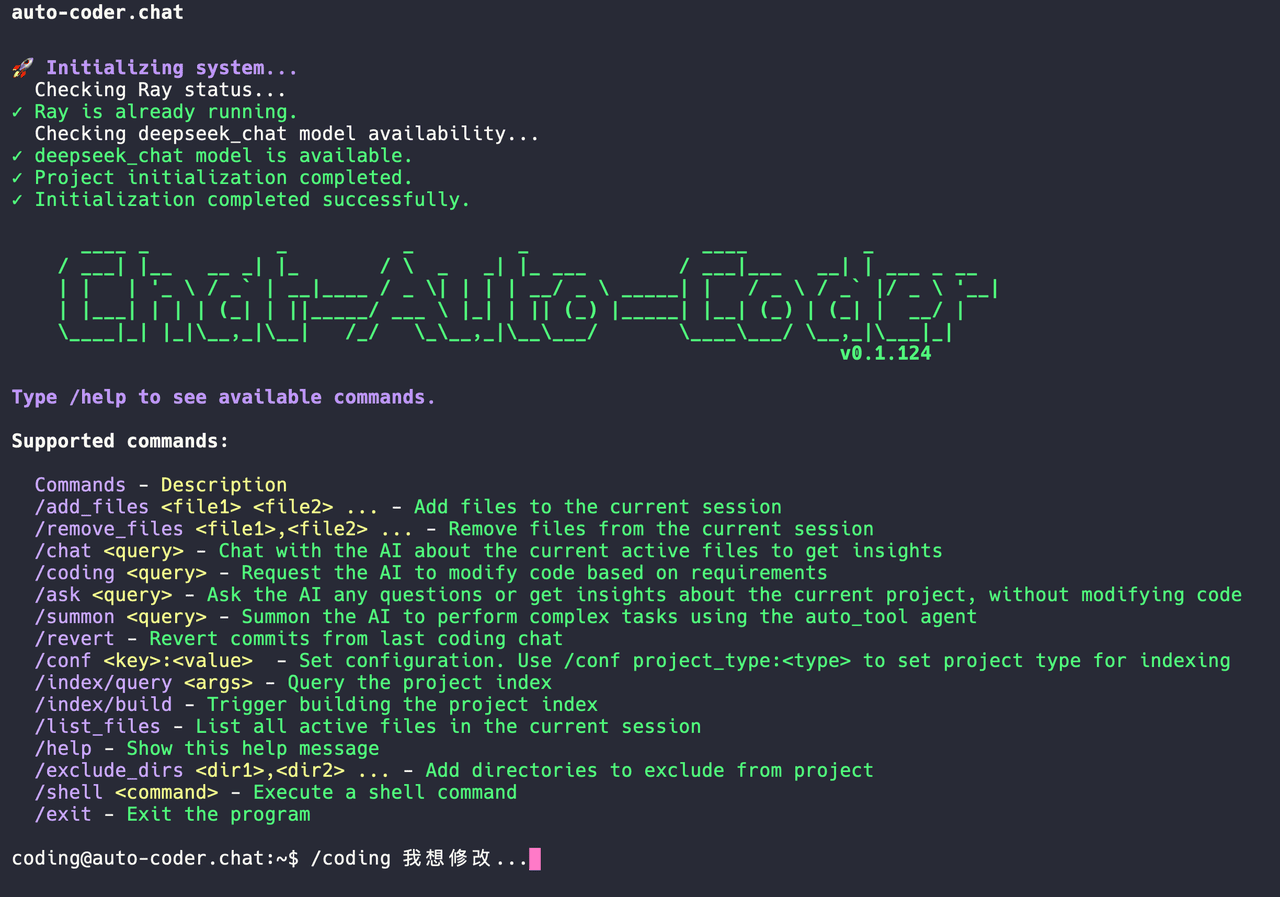

Research Rabbit: Web-Recherche und Berichtserstellung unter Verwendung des nativen LLM, das automatisch in benutzerdefinierte Themen eindringt und Zusammenfassungen erstellt.

Allgemeine Einführung

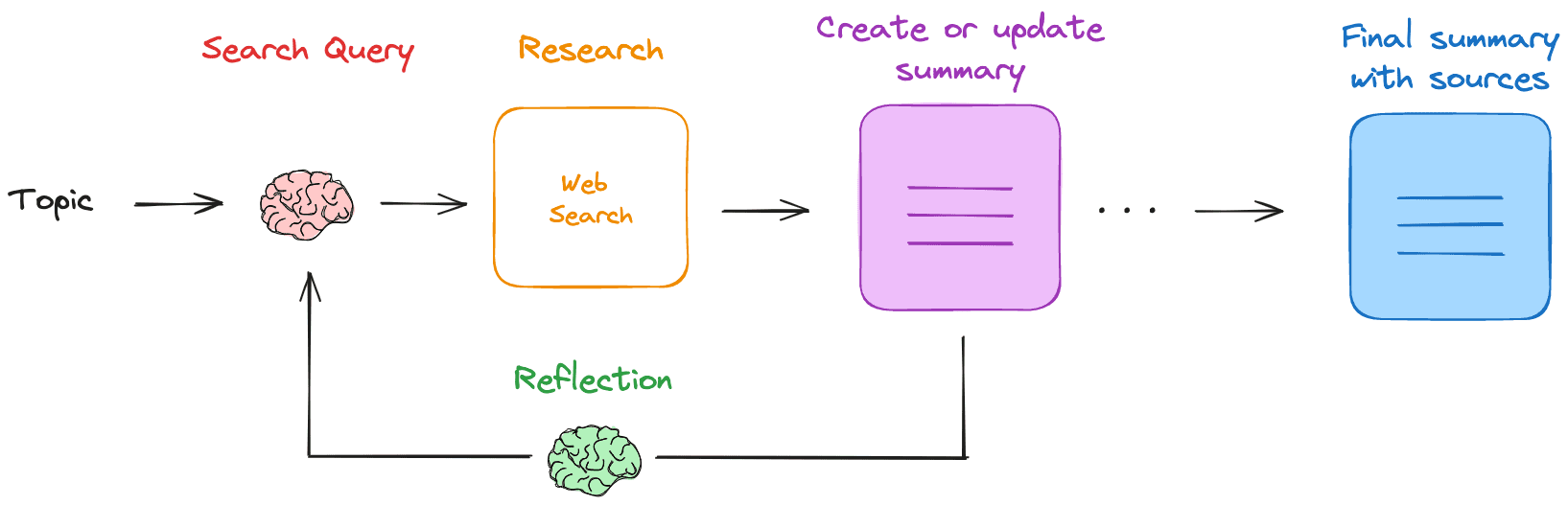

Research Rabbit ist ein nativer LLM (Large Language Model) basierter Assistent für Web-Recherche und Zusammenfassungen. Nachdem der Benutzer ein Forschungsthema angegeben hat, erstellt Research Rabbit eine Suchanfrage, erhält relevante Web-Ergebnisse und fasst diese zusammen. Es wiederholt diesen Prozess, füllt Wissenslücken auf und erstellt schließlich eine Markdown-Zusammenfassung, die alle Quellen enthält. Das Tool läuft vollständig lokal, so dass Datenschutz und Sicherheit gewährleistet sind.

Funktionsliste

- Suchanfragen generierenGenerierung von Suchanfragen auf der Grundlage der vom Benutzer eingegebenen Themen.

- Suche im InternetVerwenden Sie eine konfigurierte Suchmaschine (z. B. Tavily), um relevante Ressourcen zu finden.

- Zusammenfassende ErgebnisseZusammenfassung von Websuchergebnissen unter Verwendung lokaler LLM.

- reflektierende ZusammenfassungIdentifizieren Sie Wissenslücken und generieren Sie neue Suchanfragen.

- eine iterative AktualisierungWiederholte Recherchen und Zusammenfassungen zur schrittweisen Verfeinerung der Recherche.

- lokaler BetriebAlle Vorgänge werden lokal durchgeführt, um den Datenschutz zu gewährleisten.

- Markdown-ZusammenfassungGenerieren Sie eine endgültige Markdown-Zusammenfassung mit allen Quellen.

Hilfe verwenden

Einbauverfahren

- Lokale LLM ziehenLLM: Ziehen Sie die erforderlichen lokalen LLMs aus Ollama, zum Beispiel

ollama pull llama3.2. - Tavily-API-Schlüssel erhaltenTavily registrieren und API-Schlüssel erhalten, Umgebungsvariablen setzen

export TAVILY_API_KEY=<your_tavily_api_key>. - Klon-Lager: Lauf

git clone https://github.com/langchain-ai/research-rabbit.gitKlon-Lagerhaus. - Installation von Abhängigkeiten: Wechseln Sie in das Projektverzeichnis und führen Sie

uvx --refresh --from "langgraph-cli[inmem]" --with-editable . --python 3.11 langgraph devInstallieren Sie die Abhängigkeit. - Startup-Assistent: Starten Sie den LangGraph-Server und rufen Sie die

http://127.0.0.1:2024Sehen Sie sich die API-Dokumentation und die Web-UI an.

Verwendungsprozess

- LLM konfigurierenLLM: Legen Sie den Namen des lokalen LLM fest, der in der LangGraph Studio Web UI verwendet werden soll (Standard).

llama3.2). - Festlegung der Tiefe der ForschungKonfigurieren Sie die Tiefe der Iterationen der Studie (Standardwert 3).

- Geben Sie ein Forschungsthema einStarten Sie den Recherche-Assistenten, indem Sie auf der Registerkarte Konfiguration das Recherchethema eingeben.

- Ansicht ProzessDer Assistent erstellt eine Suchanfrage, führt eine Websuche durch, fasst die Ergebnisse mit LLM zusammen und wiederholt den Vorgang.

- Die Zusammenfassung erhaltenSobald die Recherche abgeschlossen ist, erstellt der Assistent eine Markdown-Zusammenfassung mit allen Quellen, die der Nutzer einsehen und bearbeiten kann.

Hauptfunktionen

- Suchanfragen generierenNach der Eingabe eines Themas erstellt der Assistent automatisch eine Suchanfrage.

- Suche im InternetDer Assistent verwendet die konfigurierte Suchmaschine, um relevante Ressourcen zu finden.

- Zusammenfassende ErgebnisseDer Assistent verwendet das lokale LLM, um die Suchergebnisse zusammenzufassen und einen vorläufigen Bericht zu erstellen.

- reflektierende ZusammenfassungDer Assistent identifiziert Wissenslücken in der Zusammenfassung und erstellt neue Suchanfragen, um die Recherche fortzusetzen.

- eine iterative AktualisierungDer Assistent führt iterativ Recherchen und Zusammenfassungen durch, um die Recherche schrittweise zu verfeinern.

- Erzeugen von Markdown-ZusammenfassungenSobald die Recherche abgeschlossen ist, erstellt der Assistent eine endgültige Markdown-Zusammenfassung mit allen Quellen, die der Nutzer einsehen und bearbeiten kann.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...