Abstracts - Wir freuen uns, die Einführung von reise-3 im Gesang antworten Reise-3-Leicht eingebettete Modelle, die in Bezug auf Abrufqualität, Latenzzeit und Kosten neue Maßstäbe gesetzt haben.reise-3 Durchschnittliche Leistungsverbesserung von 7,55% gegenüber OpenAI v3 large in allen Evaluierungsdomänen, einschließlich Code, Recht, Finanzen, mehrsprachige und lange Kontexte, zusammen mit einer 2,2-fachen Kostenreduzierung und einer 3-fachen Reduzierung der Einbettungsdimensionen, was zu einer 3-fachen Reduzierung der VektorDB-Kosten führt.Reise-3-Leicht Es verbessert die Abrufgenauigkeit um 3,82% gegenüber OpenAI v3 large, reduziert die Kosten um den Faktor 6 und verringert die Dimensionalität der Einbettung um den Faktor 6. Beide Modelle unterstützen eine Kontextlänge von 32K-Token, was viermal mehr ist als bei OpenAI.

In den letzten neun Monaten haben wir die Voyage 2-Serie von eingebetteten Modellbaukästen herausgebracht, die Funktionen wie die reise-groß-2 Solche modernen Allzweckmodelle sowie eine Reihe von bereichsspezifischen Modellen wie reise-code-2, undreise-gesetz-2, undreise-finanzen-2 im Gesang antworten reise-mehrsprachig-2Alle diese Modelle werden anhand von Daten aus ihren jeweiligen Bereichen angemessen trainiert. Zum Beispiel.reise-mehrsprachig-2 Hervorragende Leistung in Französisch, Deutsch, Japanisch, Spanisch und Koreanisch sowie klassenbeste Leistung in Englisch. Wir haben das Modell auch auf spezifische Anwendungsfälle und Daten für bestimmte Organisationen abgestimmt, wie z. B. Harvey.ai des gesetzlichen Einbettungsmodells.

Wir freuen uns nun, die Voyage 3-Reihe mit eingebetteten Modellen vorstellen zu können, darunter reise-3 im Gesang antworten Reise-3-Leichtund wird in ein paar Wochen verfügbar sein reise-3-groß. Diese Modelle übertreffen die Konkurrenz in Bezug auf die Abrufqualität und senken gleichzeitig den Preis und die Folgekosten von vectorDB erheblich. Im Einzelnen.reise-3 Mit den folgenden Merkmalen:

- Die Leistung war im Durchschnitt 7,55% höher als die von OpenAI v3 large in allen acht Bewertungsbereichen (Technik, Code, Web, Recht, Finanzen, Mehrsprachigkeit, Schutz und langer Kontext).

- Kosten 2,2x weniger als OpenAI v3 large, 2,2x weniger als Cohere Englisch v3 ist 1,6 Mal niedriger und kostet $0,06 pro 1 Million Token.

- Einbettungsdimension als OpenAI (3072) und E5 Mistral (4096) ist 3-4 mal kleiner (1024), was die Kosten der VektorDB um den Faktor 3-4 reduziert.

- Unterstützt 32K-Token-Kontextlängen, verglichen mit 8K bei OpenAI und 512 bei Cohere.

Reise-3-Leicht ist ein leichtgewichtiges Modell, das für Latenzzeiten und niedrige Kosten optimiert ist und unter anderem folgende Merkmale aufweist

- Die durchschnittliche Leistung über alle Domänen hinweg ist 3,82% höher als bei OpenAI v3 large.

- Die Kosten sind 6,5 Mal niedriger als bei OpenAI v3 large, nämlich $0,02 pro 1 Million Token.

- Sie übertrifft OpenAI v3 small um 7,58% zum gleichen Preis.

- Die Einbettungsdimension ist 6-8 mal kleiner (512) als bei OpenAI (3072) und E5 Mistral (4096), was die Kosten der VektorDB um das 6-8 fache reduziert.

- Unterstützt 32K-Token-Kontextlängen, verglichen mit 8K bei OpenAI und 512 bei Cohere.

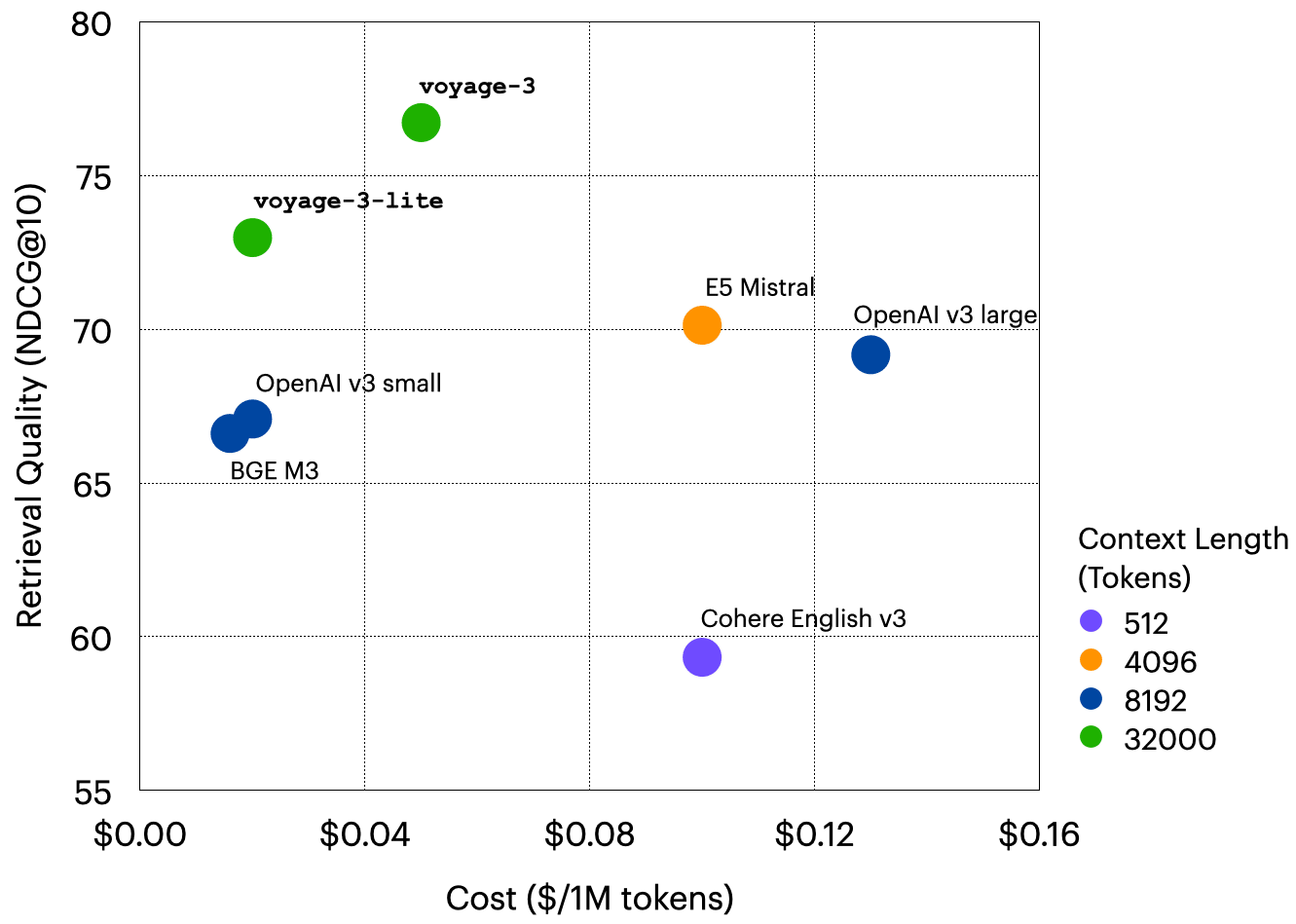

Die folgende Tabelle fasst wichtige Aspekte dieser Modelle und einiger ihrer Konkurrenten zusammen und wird von einer grafischen Darstellung des Verhältnisses zwischen Abrufqualität und Kosten begleitet2 .

| Modellierung | Dimension (math.) | Kontext Länge | Kosten (pro Million Token) | Qualität des Abrufs (NDCG@10) |

|---|---|---|---|---|

| reise-3 | 1024 | 32K | $0.06 | 76.72 |

| Reise-3-Leicht | 512 | 32K | $0.02 | 72.98 |

| OpenAI v3 groß | 3072 | 8K | $0.13 | 69.17 |

| OpenAI v3 klein | 1536 | 8K | $0.02 | 67.08 |

| Cohere Englisch v3 | 1024 | 512 | $0.10 | 59.33 |

| E5 Mistral | 4096 | 4K | $0.10 | 70.13 |

| BGE M3 | 1024 | 8K | $0.016 | 66.61 |

reise-3 im Gesang antworten Reise-3-Leicht ist das Ergebnis einer Reihe von Forschungsinnovationen, darunter verbesserte Architekturen, Destillation aus größeren Modellen, mehr als 2 Billionen hochwertige Token des Pre-Trainings und des Abgleichs der Abfrageergebnisse durch menschliches Feedback.

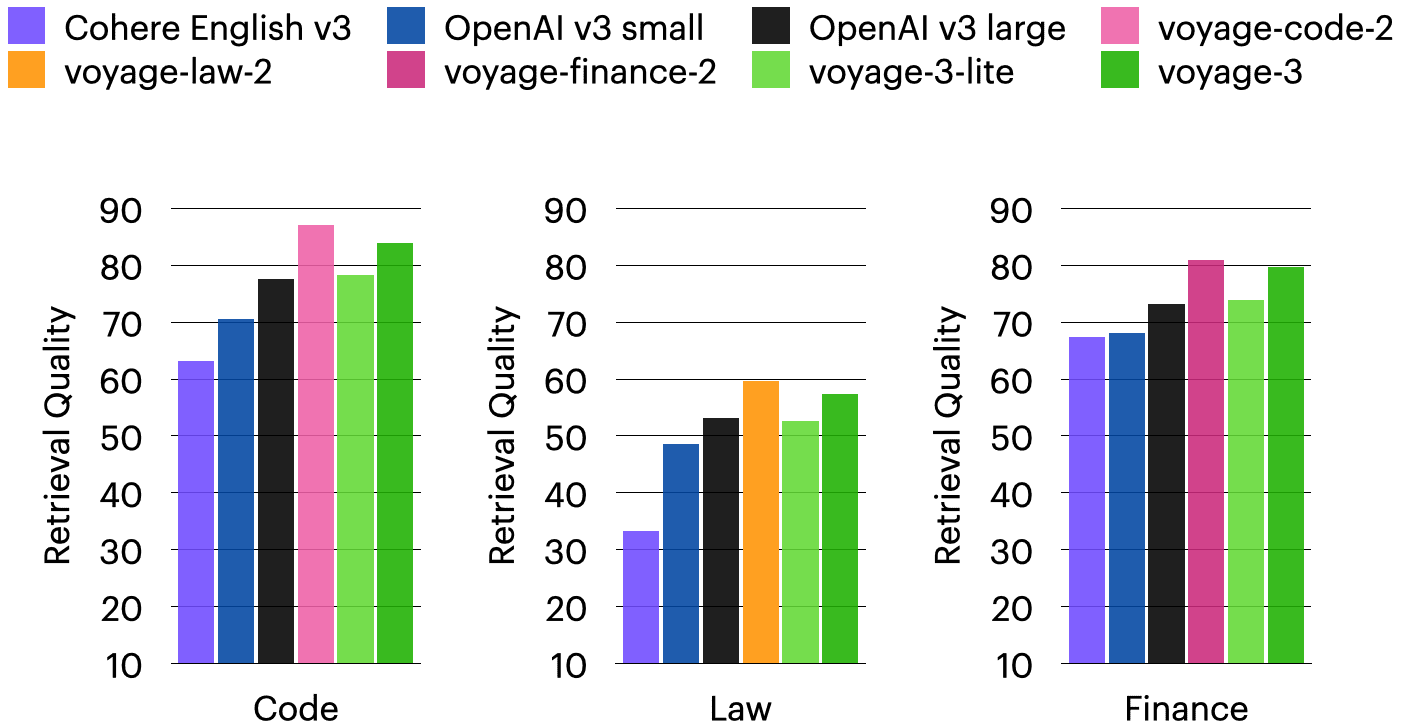

Empfehlungsschreiben. Jeder generische eingebettete Benutzer kann ein Upgrade auf reise-3 eine höhere Suchqualität zu geringen Kosten, oder sie entscheiden sich für Reise-3-Leicht Weitere Kosteneinsparungen. Wenn Sie sich besonders für die Suche in den Bereichen Code, Recht, Finanzen und Mehrsprachigkeit interessieren, bietet Ihnen die Voyage 2-Familie der domänenspezifischen Modelle (reise-code-2, undreise-gesetz-2, undreise-finanzen-2 im Gesang antworten reise-mehrsprachig-2) bleiben die beste Wahl in ihren jeweiligen Bereichen, auch wenn die reise-3 Die Leistung ist ebenfalls sehr wettbewerbsfähig (siehe Abschnitt unten). Wenn Sie bereits Voyage Embedding verwenden, fügen Sie einfach einen neuen Abschnitt in der Voyage API Der Anruf wird Modell Der Parameter wird angegeben als "voyage-3" vielleicht "voyage-3-lite"die für Korpus und Abfragen verwendet werden können.

Einzelheiten der Bewertung

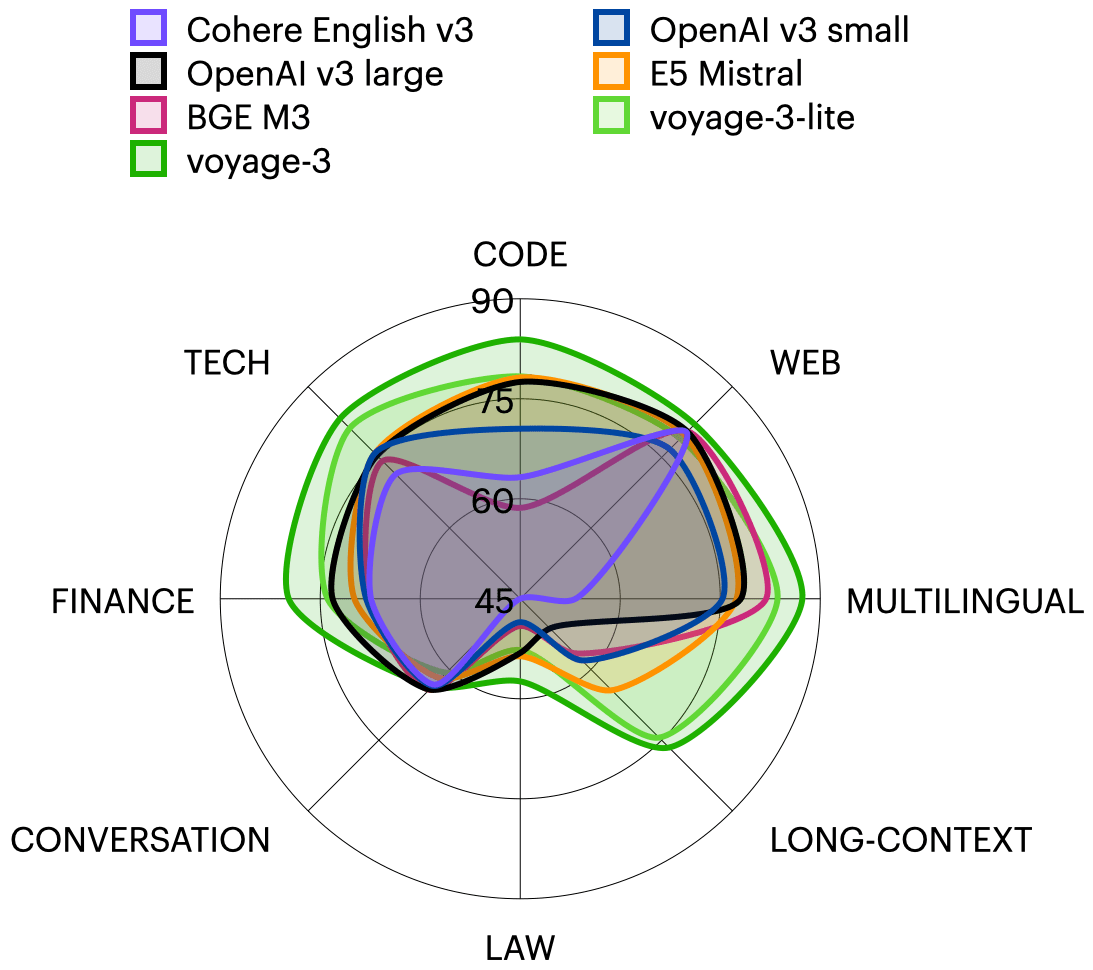

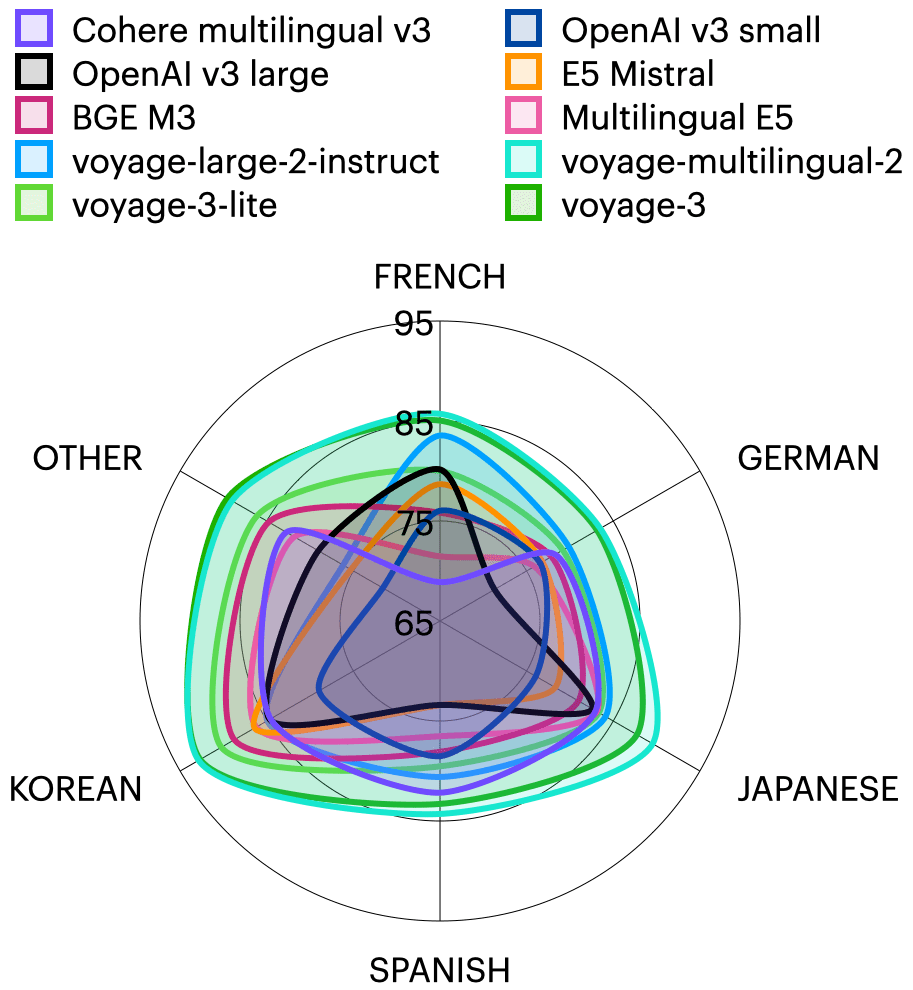

Datensatz. Wir evaluierten 40 domänenspezifische Retrieval-Datensätze für acht Domänen, darunter technische Dokumente, Code, Recht, Finanzen, Web-Reviews, mehrsprachige, lange Dokumente und Dialoge. Jeder Datensatz enthält ein abzufragendes Korpus und eine Reihe von Abfragen. Der Korpus besteht in der Regel aus Dokumenten in einem bestimmten Bereich, z. B. StackExchange-Antworten, Gerichtsurteile, technische Dokumente usw.; die Abfragen können Fragen, Zusammenfassungen langer Dokumente oder einzelne Dokumente sein. In der nachstehenden Tabelle sind die Datensätze in acht Kategorien zusätzlich zu mehrsprachig aufgeführt. Der Bereich Mehrsprachigkeit umfasst 62 Datensätze in 26 Sprachen, darunter Französisch, Deutsch, Japanisch, Spanisch, Koreanisch, Bengalisch, Portugiesisch und Russisch. Die ersten fünf dieser Sprachen haben mehrere Datensätze, während die übrigen Sprachen jeweils einen Datensatz pro Sprache enthalten und in der Kategorie SONSTIGE in der nachstehenden mehrsprachigen Radartabelle gruppiert sind.

| Formular | Beschreibungen | Datensatz |

|---|---|---|

| Fähigkeiten | technisches Dokument | Cohere, 5G, OneSignal, LangChain, PyTorch |

| Kodierung | Codeschnipsel, Dokumentenketten | LeetCodeCpp, LeetCodeJava, LeetCodePython, HumanEval, MBPP, DS1000-nur Referenz, DS1000, apps_5doc |

| Gesetzgebung | Rechtssachen, Gerichtsurteile, Gesetzbücher, Patente | LeCaRDv2, LegalQuAD, LegalSummarisation, AILA-Casedocs, AILA-Satzung |

| Finanzen | SEC-Berichte, Finanz-QA | RAG Benchmark (Apple-10K-2022), FinanceBench, TAT-QA, Finance Alpaca, FiQA Personal Finance, Stock News Sentiment, ConvFinQA, FinQA, HC3 Finance |

| Vernetzungen | Kommentare, Forenbeiträge, Richtlinienseiten | Huffpostsports, Huffpostscience, Doordash, Health4CA |

| langer Kontext | Lange Aktenordner mit Regierungsberichten, wissenschaftlichen Abhandlungen, Dialogen usw. | NarrativeQA, Nadel, Hauptschlüssel, QMSum, SummScreenFD, WikimQA |

| Dialoge | Tagungsband, Dialog | Dialogsumme, QA Conv, HQA |

Eine Liste aller Bewertungsdatensätze finden Sie in der Dieses Arbeitsblatt Ansicht in.

Modellierung. Wir bewerteten die reise-3 im Gesang antworten Reise-3-Leichtsowie eine Reihe von alternativen Modellen, darunter: OpenAI v3 small (text-einbettung-3-klein) und groß (text-einbettung-3-groß), E5 Mistral (intfloat/e5-mistral-7b-instruct), BGE M3 (BAAI/bge-m3Cohere English v3.einbetten-englisch-v3.0) und reise-groß-2-anweisung. Für domänenspezifische und mehrsprachige Datensätze haben wir auch Folgendes bewertet reise-gesetz-2, undreise-finanzen-2, undreise-mehrsprachig-2Mehrsprachig E5.infloat/multilingual-e5-large) und Cohere mehrsprachig v3 (einbetten-mehrsprachig-v3.0).

Norm. Für die Abfrage werden die 10 besten Dokumente auf der Grundlage der Cosinus-Ähnlichkeit ermittelt und berichtetNormalisierter diskontierter kumulierter Gewinn(NDCG@10), die ein Standardindikator für die Qualität des Abrufs und eine Variante des Recalls ist.

am Ende

Domänenübergreifende Suche. Wie bereits erwähnt und in der ersten Radarkarte in diesem Dokument dargestellt, ist diereise-3 durchschnittlich 7.55% besser ab als OpenAI v3 large über mehrere Domänen hinweg, wie aus dem folgenden Balkendiagramm hervorgeht.reise-3 Die Leistung ist nur geringfügig niedriger als die des bereichsspezifischen Modells von Voyage.

mehrsprachige Suche. Wie in der nachstehenden Radarkarte dargestellt.reise-3 Die Qualität der mehrsprachigen Suche ist nur geringfügig schlechter als die der reise-mehrsprachig-2aber mit geringerer Latenz und der Hälfte der Kosten.Reise-3-Leicht Übertrifft alle Nicht-Voyage-Modelle um 4,55%, 3,13% und 3,89% gegenüber OpenAI v3 large, Cohere multilingual v3 bzw. Multilingual E5.

Alle Bewertungsergebnisse sind abrufbar unter Dieses Arbeitsblatt Ansicht in.

Testen Sie die Voyage 3-Serie!

Versuchen Sie es jetzt reise-3 im Gesang antworten Reise-3-Leicht! Die ersten 200M Token sind kostenlos. Gehen Sie zu unserem (Computer-)Datei Erfahren Sie mehr. Wenn Sie an der Feinabstimmung der Einbettung interessiert sind, würden wir uns freuen, von Ihnen zu hören - bitte kontaktieren Sie uns unter contact@voyageai.com Kontaktieren Sie uns. Folgen Sie uns auf X (Twitter) im Gesang antworten LinkedInund treten Sie unserem Diskord für weitere Aktualisierungen.

- Die durchschnittliche NDCG@10 für Cohere English v3 auf den LAW- und LONG-CONTEXT-Datensätzen beträgt 33,32% bzw. 42,48%. In der Radargramm-Visualisierung haben wir diese Werte auf 45% gerundet.

- E5 Mistral und BGE M3 sind Open-Source-Modelle. Wir verwenden $0,10 als Kosten für E5 Mistral, was dem Industriestandard für 7B parametrische Modelle entspricht, und $0,016 für BGE M3, was auf den Kosten von Fireworks.ai für 350M parametrische Modelle basiert. Preise Geschätzt.