Open WebUI: Lokal gehostete AI-Chat-WebUI

Allgemeine Einführung

Open WebUI (früher bekannt als Ollama WebUI) ist eine freundliche, interaktive AI-Benutzeroberfläche, die für LLMs (Large Language Models) entwickelt wurde. Es ist skalierbar, funktionsreich und läuft komplett offline. Zu den herausragenden Merkmalen von Open WebUI gehören ein gesprächiges Oberflächendesign, hohe Reaktionsfähigkeit, einfache Einrichtung mit Docker oder Kubernetes, Codehervorhebung, Markdown- und LaTeX-Unterstützung, lokale und entfernte RAG-Integration, Sprach-/Videoanruf-Funktionalität, Bilderzeugungsintegration und vieles mehr! Funktionen und vieles mehr.

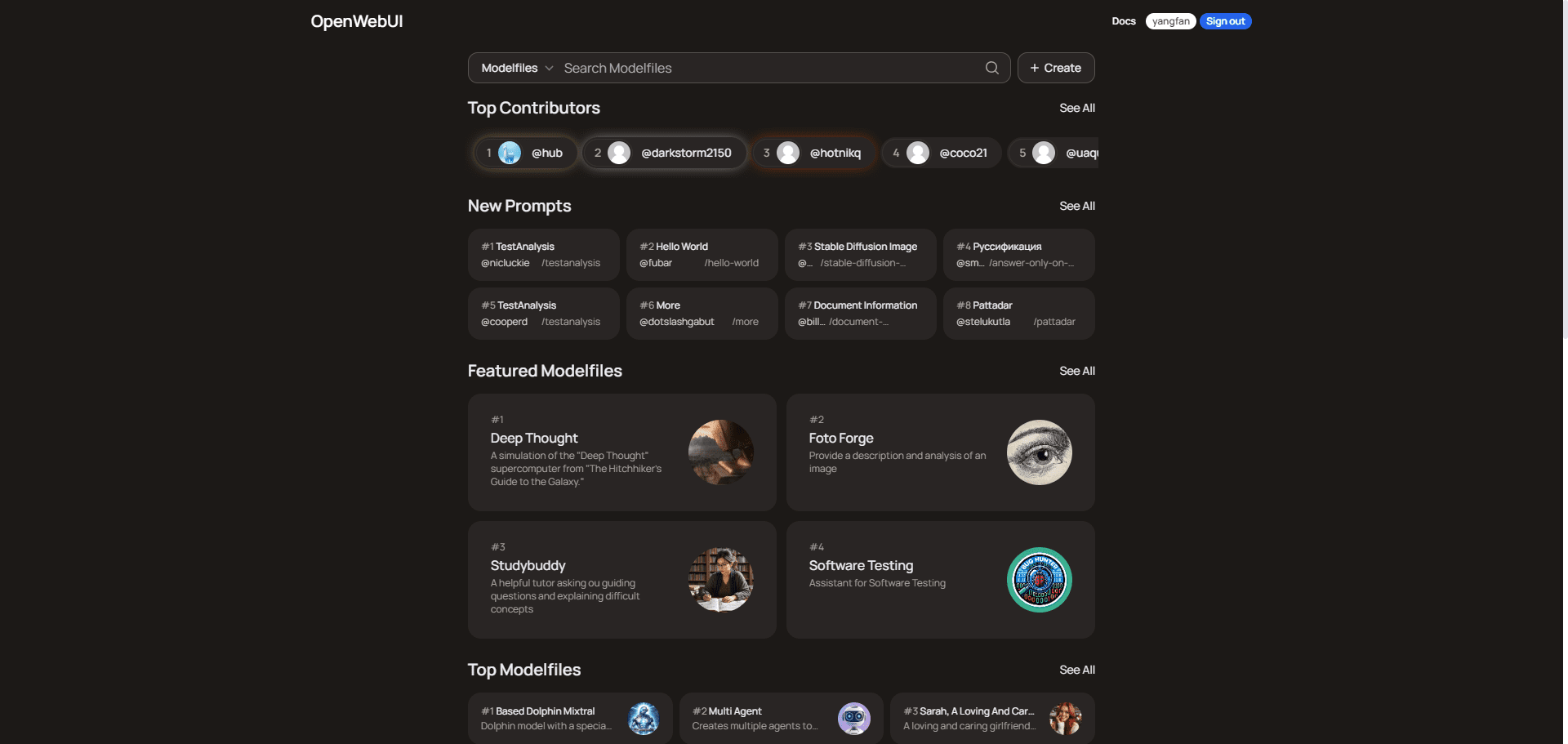

Über OpenWebUI:

OpenWebUI ist eine Benutzer-Community-Plattform, die Mehrzweck-Modelldateien für die Bereiche Programmierung, Schreiben, Produktivität, Bildung, Wirtschaft und Datenanalyse bereitstellt. Die Nutzer können diese Modelldateien erkunden und herunterladen, um die Effizienz ihrer Aufgaben und Projekte zu verbessern. Die Plattform hat mehr als 15.000 Nutzer und basiert auf der Bewertung von Beiträgen und gemeinsamen intelligenten Chatprotokollen für Kommunikation und Lernen.

Informationen zur kostenlosen Bereitstellung in der Cloud finden Sie unter Einsatz eines personalisierten Satzes von Miniatur-Chat-Tools auf unauffälligen Computern Es folgt eine Beschreibung von Koyebs Einsatz von Open WebUI.

Funktionsliste

- Nahtlose InstallationEinfache Installation über Docker oder Kubernetes, mit Unterstützung für Ollama und CUDA-getaggte Images.

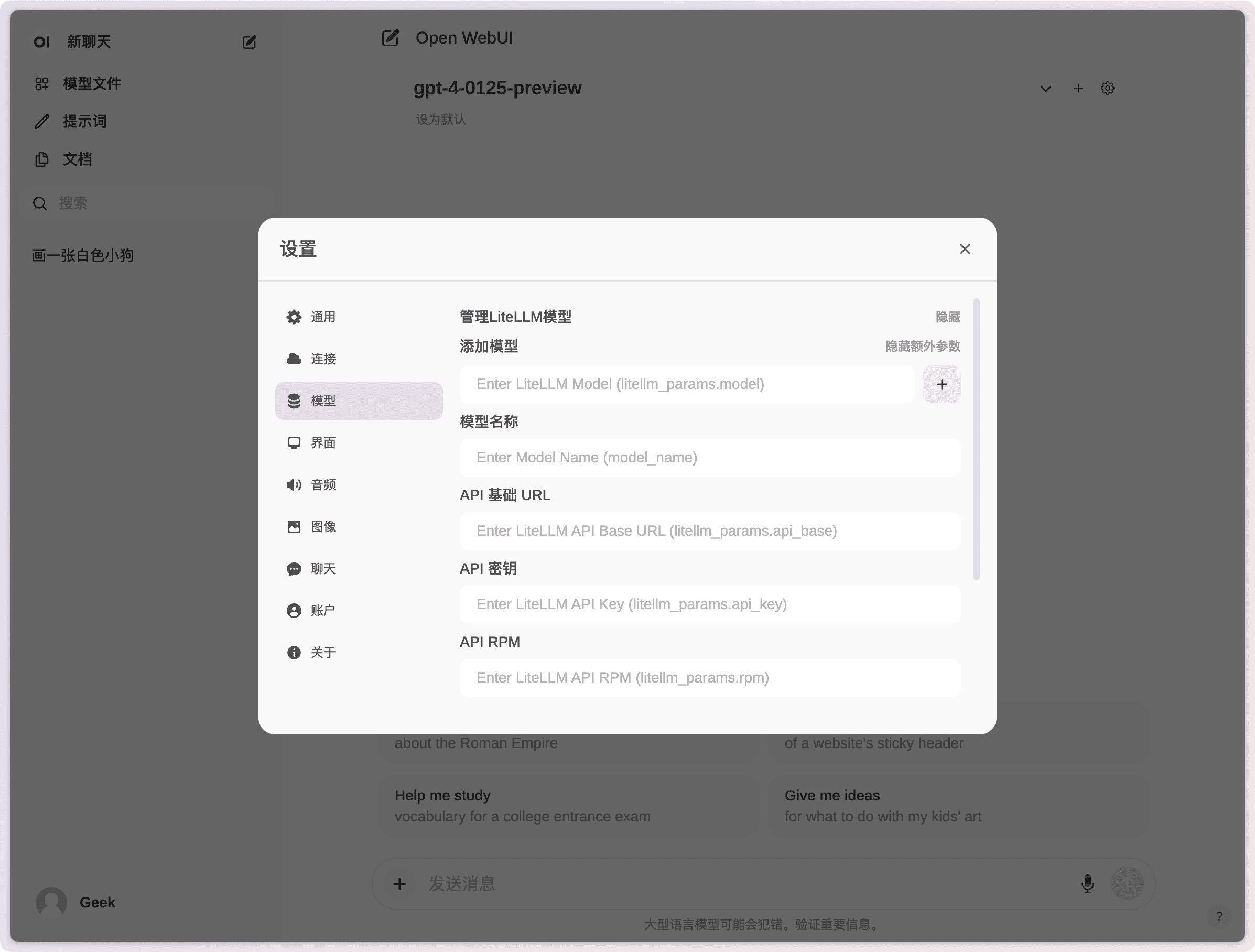

- API-EinbindungEinfache Integration mit OpenAI-kompatiblen APIs und Unterstützung für mehrere Dialogmodelle.

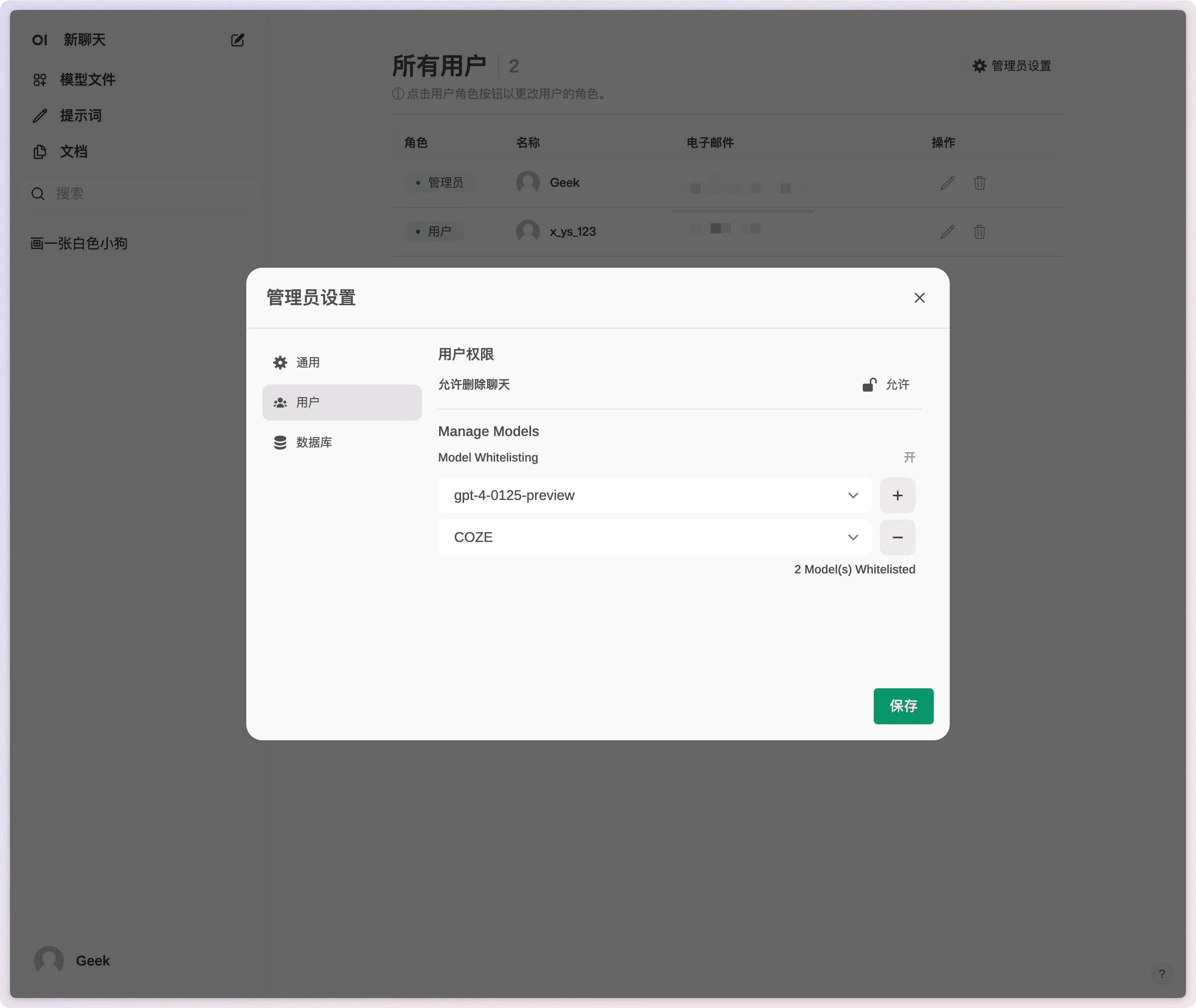

- Fein abgestufte Berechtigungen und BenutzergruppenAdministratoren können detaillierte Benutzerrollen und Berechtigungen erstellen, um eine sichere Benutzerumgebung zu gewährleisten.

- reaktionsfähiges DesignGenießen Sie ein nahtloses Erlebnis auf Desktop-PCs, Laptops und mobilen Geräten.

- Progressive Webanwendungen (PWA)Bieten Sie auf mobilen Geräten eine native, appähnliche Erfahrung mit Unterstützung für den Offline-Zugriff.

- Unterstützung von Markdown und LaTeXBereitstellung umfassender Markdown- und LaTeX-Funktionen zur Verbesserung der interaktiven Erfahrung.

- Sprach-/VideoanrufeIntegration der Freisprechfunktion für Sprach- und Videoanrufe für eine dynamischere Chatumgebung.

- ModellbauerEinfaches Erstellen von Ollama-Modellen und Hinzufügen von benutzerdefinierten Rollen/Agenten über die Web-UI.

- Lokale RAG-IntegrationUnterstützung für Retrieval Augmented Generation (RAG), um die Interaktion mit Dokumenten nahtlos in das Chat-Erlebnis zu integrieren.

- Integration der BilderzeugungUnterstützt AUTOMATIC1111 API, ComfyUI und OpenAIs DALL-E, um das Chat-Erlebnis zu verbessern.

- Multimodell-DialogInteragiert mit mehreren Modellen gleichzeitig und nutzt deren einzigartige Stärken, um die bestmögliche Antwort zu geben.

- Rollenbasierte Zugriffskontrolle (RBAC)Gewährleistung eines sicheren Zugangs, bei dem nur autorisiertes Personal Zugang zu Ollama und zur Modellerstellung bzw. zum Hochziehen von Modellen hat.

- Unterstützung mehrerer SprachenInternationalisierung: Es wird eine Unterstützung für die Internationalisierung angeboten, damit die Benutzer ihre bevorzugte Sprache wählen können.

- Plug-in-UnterstützungNahtlose Integration von benutzerdefinierter Logik und Python-Bibliotheken über das Pipelines-Plugin-Framework.

Hilfe verwenden

Einbauverfahren

Installieren mit Docker

- Spiegel abziehen: Führen Sie den folgenden Befehl in einem Terminal aus, um das neueste Open WebUI Docker-Image aus der GitHub-Container-Registry zu ziehen:

docker pull ghcr.io/open-webui/open-webui:main - Laufende Container: Führen Sie den Container mit den Standardeinstellungen aus, um eine dauerhafte Datenspeicherung zu gewährleisten:

docker run -d -p 3000:8080 -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main- Volumen-MappingPersistente Datenspeicherung, um Datenverluste beim Neustart des Containers zu vermeiden.

- Port-MappingWebUI auf Port 3000 auf dem lokalen Rechner freigeben.

Installation mit Python

- Installation von Open WebUIStellen Sie sicher, dass Sie Python 3.11 verwenden, um Kompatibilitätsprobleme zu vermeiden. Führen Sie den folgenden Befehl im Terminal aus:

pip install open-webui - Ausführen von Open WebUINachdem die Installation abgeschlossen ist, führen Sie den folgenden Befehl aus, um Open WebUI zu starten:

open-webui serveDadurch wird der Open WebUI-Server gestartet, den Sie unter http://localhost:8080访问 finden.

Funktion Betriebsanleitung

Sprach-/Videoanrufe

- einen Anruf einleitenKlicken Sie im Chat-Bildschirm auf die Schaltfläche Sprach- oder Videoanruf, um einen Kontakt auszuwählen und den Anruf zu starten.

- AnrufsteuerungWährend eines Anrufs können Sie mit den Steuertasten auf der Oberfläche stummschalten und auflegen.

Bilderzeugung

- Bildgenerator-Werkzeug auswählenWählen Sie AUTOMATIC1111 API, ComfyUI oder OpenAI's DALL-E im Chat-Bildschirm.

- Beschreibung der Eingabe: Geben Sie die Bildbeschreibung in das Eingabefeld ein und klicken Sie auf die Schaltfläche Generieren.

- Ergebnisse anzeigenDas erzeugte Bild wird in der Chat-Oberfläche angezeigt und kann vom Benutzer gespeichert oder freigegeben werden.

Lokale RAG-Integration

- Dokumente laden#: Verwenden Sie den #-Befehl im Chat-Interface, um Dokumente zu laden oder Dateien zur Dokumentenbibliothek hinzuzufügen.

- abrufen.Geben Sie eine Anfrage in den Chat ein und das System wird automatisch die relevanten Informationen aus den geladenen Dokumenten abrufen und eine Antwort generieren.

allgemeine Probleme

- KonnektivitätsproblemWenn Sie Verbindungsprobleme haben, stellen Sie sicher, dass der Docker-Container Zugriff auf den Ollama-Server hat. Verwenden Sie den folgenden Befehl, um das Problem zu lösen:

docker run -d --network=host -v open-webui:/app/backend/data -e OLLAMA_BASE_URL=http://127.0.0.1:11434 --name open-webui --restart always ghcr.io/open-webui/open-webui:main - Aktualisieren der Docker-InstallationWatchtower: Verwenden Sie Watchtower, um Ihre lokale Docker-Installation auf die neueste Version zu aktualisieren:

docker run --rm --volume /var/run/docker.sock:/var/run/docker.sock containrrr/watchtower --run-once open-webui

Bereitstellung von Open WebUI mit einem Klick bei Cuddleface

https://codeberg.org/fossandroid/Open-WebUI.git

https://linux.do/t/topic/274417

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...