Ollama Customized Model Lagerorte

Die von Ollama abgerufenen Modelle werden standardmäßig auf Laufwerk C gespeichert. Wenn Sie mehr als ein Modell abrufen müssen, wird das Laufwerk C voll sein, was sich auf den Speicherplatz von Laufwerk C auswirkt.

Daher wird in diesem Abschnitt beschrieben, wie Sie die Ollama Wo das Modell gespeichert ist.

Windows (Computer)

Wenn beim Herunterladen von Ollama keine weiteren Maßnahmen ergriffen werden, wird das Modell standardmäßig in das Verzeichnis

C:\Users\<用户名>\.ollama\modelsWenn wir es nicht auf dem Laufwerk C ablegen wollen, erstellen wir an dieser Stelle den Ordner, in den das benutzerdefinierte Modell heruntergeladen werden soll, und kopieren den Pfad, z. B.

D:\Ollama\ModelsHinweis: Die Pfade sollten im Voraus erstellt werden und keine chinesischen Zeichen oder Leerzeichen enthalten.

Für verschiedene Situationen können die folgenden Strategien angewandt werden 👀

Bevor Sie Ollama zum ersten Mal installieren, müssen Sie den Download-Pfad für das Modell manuell festlegen.

II. die Variablen der Systemumgebung ändern (empfohlen)

III. die Migration der bestehenden Musterdokumente

I. Legen Sie den Pfad zum Herunterladen des Modells manuell fest, wenn Sie Ollama zum ersten Mal installieren.

Benutzerdefinierter Installationspfad (bei Erstinstallation)

.\OllamaSetup.exe /DIR="D:\Ollama\Models"

Streik (auf der Tastatur) InstallDanach können Sie sehen, dass die Software im benutzerdefinierten Pfadordner installiert ist und das Modell standardmäßig in den benutzerdefinierten Ordner heruntergeladen wird.

II. die Variablen der Systemumgebung ändern (empfohlen)

Szenario: Es wird empfohlen, den Speicherort des Modells direkt nach Abschluss der Installation von Ollama zu ändern, oder Sie möchten, dass das neu heruntergeladene Modell direkt am neuen Ort gespeichert wird.

- Setzen von Umgebungsvariablen

Win + S→ Geben Sie "Umgebungsvariablen" ein → Wählen Sie "Systemumgebungsvariablen bearbeiten" → Klicken Sie auf die Schaltfläche "Umgebungsvariablen".- Systemvariable → neu gebaut → Eingabe:

- Variablenname ::

OLLAMA_MODELS - variabler Wert Benutzerdefinierte Pfade (z.B.

D:\Ollama\Models)

- wieder öffnen Ollama in Kraft treten

- Starten Sie den Ollama-Dienst neu (Rechtsklick auf das Symbol in der Taskleiste → Ollama).

Quit Ollama(und dann neu starten)

III. die Migration der bestehenden Musterdokumente

Heruntergeladene Modelle müssen an einen neuen Ort verschoben werden

- Beendigung Ollama Kurs

Suche nach der Prozess-IDtasklist | findstr ollamaBeendigung von Prozessen

taskkill /F /IM ollama.exe

- Migrationsmodell-Dateien

- Oberbefehlshaber (Militär)

C:\Users\<用户名>\.ollama\modelsOrdner an einen neuen Ort (z. B.D:\Ollama\Models) und Speicherplatz freizugeben - ❗ Daten sichern Backup vor der Migration empfohlen

C:\Users\<用户名>\.ollamaAkte (Papier)

- Erstellen von Umgebungsvariablen

- Einstellung nach Methode 2

OLLAMA_MODELSZeigt auf einen neuen Pfad (z. B.D:\Ollama\Models)

- Einstellung nach Methode 2

- wieder öffnen Ollama in Kraft treten

Überprüfen Sie die Liste der Modelle. Wenn sie Modelle anzeigt, die heruntergeladen wurden, war die Modellmigration erfolgreich 🎉.ollama list

Linux

Auf Linux-Systemen werden die von Ollama abgerufenen Modelle standardmäßig im Ordner .ollama/models im Home-Verzeichnis des Benutzers gespeichert, in der Regel unter ~/.ollama/models. Wenn Sie die Modelle an einem anderen Ort speichern möchten, können Sie dies auf verschiedene Weise tun.

I. Manuelles Festlegen des Modell-Download-Pfads

Szenario: bei der Erstinstallation

Auf Linux-Systemen wird Ollama normalerweise über einen Paketmanager oder ein Skript installiert. Wenn Sie den Speicherpfad des Modells während der Installation angeben müssen, können Sie dies durch Setzen einer Umgebungsvariablen tun.

- Umgebungsvariablen setzen: Bevor Sie Ollama installieren, setzen Sie die

OLLAMA_MODELSUmgebungsvariable, die den Speicherpfad für das Modell angibt. Öffnen Sie ein Terminal und geben Sie den folgenden Befehl ein:

export OLLAMA_MODELS=/path/to/your/custom/models

Oberbefehlshaber (Militär) /path/to/your/custom/models Ersetzen Sie den Pfad durch den von Ihnen gewünschten, z. B. /home/username/Ollama/Models.

- Installation von Ollama: Folgen Sie dem normalen Verfahren zur Installation von Ollama. Sobald die Installation abgeschlossen ist, wird das Modell automatisch in den angegebenen benutzerdefinierten Pfad heruntergeladen.

II. die Variablen der Systemumgebung ändern (empfohlen)

Szenario: Nach der Installation von Ollama möchten Sie den Speicherort des Modells direkt ändern, oder Sie möchten das neu heruntergeladene Modell an einem neuen Ort speichern.

- Umgebungsvariablen einstellen Bearbeiten

~/.bashrcvielleicht~/.zshrcDatei (je nach verwendeter Shell), fügen Sie Folgendes hinzu:

export OLLAMA_MODELS=/path/to/your/custom/models

Ersetzen Sie /path/to/your/custom/models durch den gewünschten Pfad, z.B. /home/username/Ollama/Models.

- Speichern Sie die Datei und laden Sie die Konfiguration erneut:

source ~/.bashrc

vielleicht

source ~/.zshrc

- Neustart des Ollama-Dienstes

Wenn Ollama bereits gestartet ist, kann der Dienst mit dem folgenden Befehl neu gestartet werden:

ollama quit

ollama start

III. die Migration der bestehenden Musterdokumente

Szenario: Heruntergeladene Modelle müssen an einen neuen Ort verschoben werden.

- Ollama schließen

- Dateien für die Migrationsmodellierung: zu erstellen

~/.ollama/modelsOrdner an einen neuen Ort (z. B./home/username/Ollama/Models) und Speicherplatz freizugeben:

mv ~/.ollama/models /path/to/your/custom/models

Oberbefehlshaber (Militär) /path/to/your/custom/models Ersetzen Sie ihn durch Ihren Zielpfad.

❗ Datensicherung: Es wird empfohlen, den Ordner ~/.ollama vor der Migration zu sichern.

- Umgebungsvariablen setzen: Methode 2 befolgen

OLLAMA_MODELSNeue Wege aufzeigen. - Neustart des Ollama-Dienstes: Starten Sie Ollama und überprüfen Sie die Modellliste, um zu bestätigen, dass die Modellmigration erfolgreich war:

ollama start

ollama list

Mit der oben beschriebenen Methode können Sie den Speicherort der Ollama-Modelle auf Linux-Systemen flexibel anpassen, um zu vermeiden, dass zu viel des standardmäßigen Speicherplatzes beansprucht wird.

MacOS

Der Standard-Download-Speicherort für Ollama auf Mac-Systemen ist

~/.ollama/models/blobs(wie unten gezeigt). Wie bei Windows und Linux werden auch Mac-Systeme durch die Einstellung derOLLAMA_MODELSum den Pfad zum Herunterladen des Modells zu steuern, können wir den Download-Pfad auf zwei Arten festlegen.

I. Vorübergehende Änderung des Download-Pfads

ausnutzen launchctl setenv aufstellen OLLAMA_MODELS Die Wirkung dieses Befehls ist vorübergehend, d. h. sie geht verloren, wenn der Computer neu gestartet oder das Konto abgemeldet wird.

launchctl setenv OLLAMA_MODELS "/Users/lta/Desktop/models"

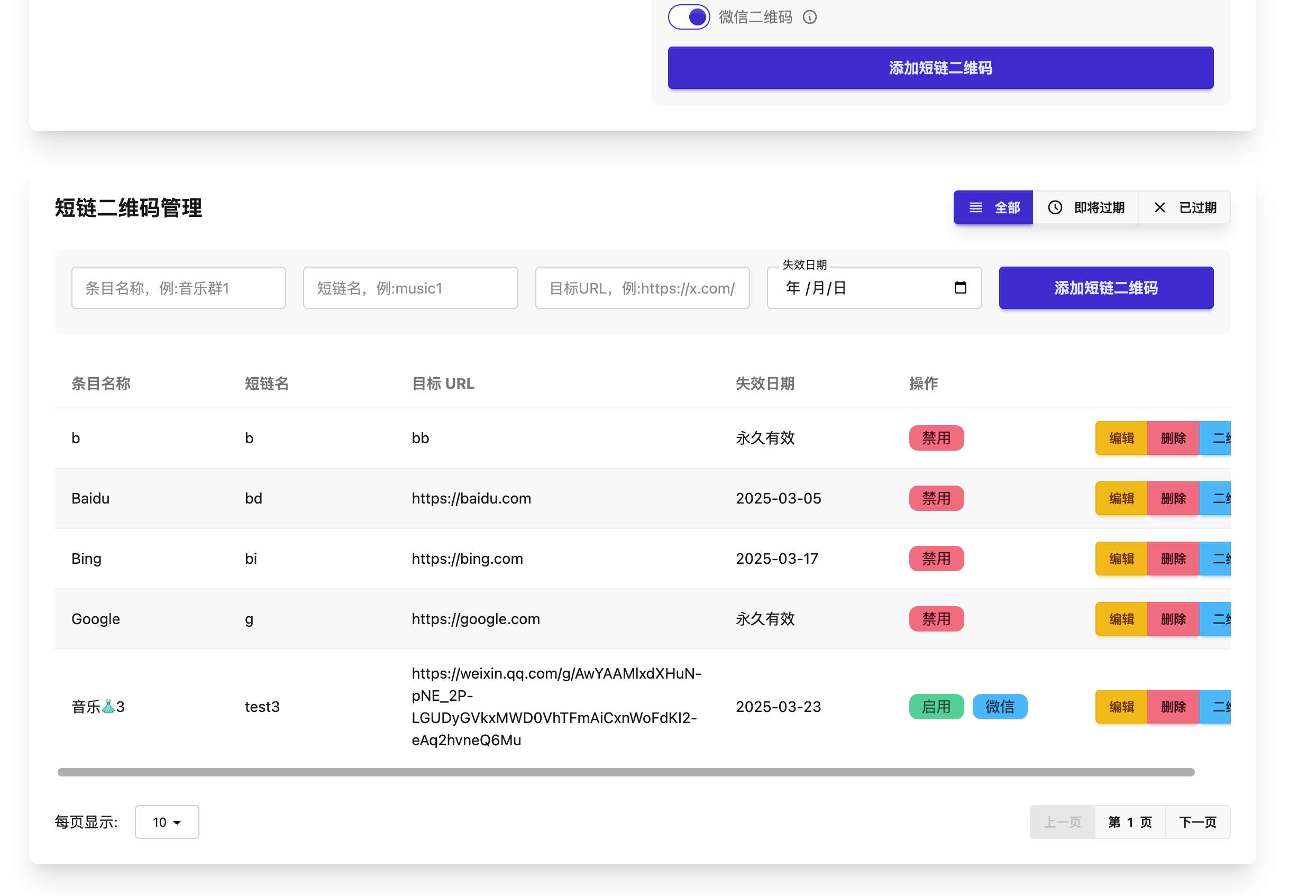

Nachdem Sie die Umgebungsvariable gesetzt haben, können Sie die Umgebungsvariable mit dem Befehllaunchctl getenv OLLAMA_MODELSZeigt die aktuellen Umgebungsvariablen an.

Ändern von Umgebungsvariablen

Test nach Änderung der Umgebungsvariablen

Wenn Sie eine zuvor gesetzte Variable rückgängig machen wollen, können Sie dies mit dem Befehl launchctl unsetenv OLLAMA_MODELS Befehl zum Zurücksetzen.

II. den Download-Pfad dauerhaft ändern

- passieren (eine Rechnung oder Inspektion etc.)

nano ~/.zshrcBefehl Bearbeiten~/.zshrcPapiere - Zur Datei hinzufügen

export OLLAMA_MODELS="/Users/lta/Desktop/models". - Nach dem Speichern und Beenden des Editors führen Sie

source ~/.zshrcdamit es funktioniert.

Denken Sie daran, Ollama nach der Änderung des Pfades neu zu starten.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...