Tutorial zur Installation und Verwendung von Ollama

Es gab schon viele frühere Ausgaben über Ollama Die Informationen in den Anleitungen zur Installation und zum Einsatz von Ollama sind ziemlich verstreut, daher haben wir dieses Mal eine vollständige Anleitung in einem Schritt zusammengestellt, wie man Ollama auf einem lokalen Computer verwendet. Dieses Tutorial ist für Anfänger gedacht, um die Fallstricke bei der Verwendung von Ollama zu vermeiden. Für diejenigen, die dazu in der Lage sind, empfehlen wir, die offizielle Ollama-Dokumentation zu lesen. Ich werde dann eine Schritt-für-Schritt-Anleitung zur Installation und Verwendung von Ollama geben.

Warum Ollama für die lokale Installation von Großmodellen wählen?

Viele Neulinge verstehen nicht, so wie ich, dass es andere, leistungsfähigere Werkzeuge für die Online-Bereitstellung großer Modelle gibt, wie zum Beispiel:Bestandsaufnahme von LLM-Frameworks ähnlich wie Ollama: mehrere Optionen für lokal eingesetzte große Modelle Warum empfehlen Sie die Installation von Ollama am Ende?

In erster Linie ist es natürlich einfach, es auf Personalcomputern zu installieren, aber einer der wichtigsten Punkte ist, dass die Leistung des Modells für den Standalone-Einsatz besser auf die Parameter abgestimmt ist und die Installation nicht fehleranfällig ist. Zum Beispiel, die gleiche Konfiguration Computer-Installation QwQ-32B Verwenden Sie Ollama für eine möglichst reibungslose Nutzung, wechseln Sie zu "stärker". lama.cpp Es kann sein, dass es stecken bleibt und sogar die Ausgabe nicht korrekt ist. Es gibt viele Gründe dafür und ich kann sie nicht klar erklären, also werde ich es nicht tun. Sie sollten nur wissen, dass Ollama llama.cpp am Ende enthält und aufgrund einer besseren Optimierung stabiler läuft als llama.cpp.

Welche Arten von großen Modelldateien kann Ollama verarbeiten?

Ollama unterstützt Modelldateien in den folgenden zwei Formaten mit unterschiedlichen Inferenzmaschinen:

- GGUF-Format: durch

llama.cppBegründungen. - Format der Sicherheitssensoren: durch

vllmBegründungen.

Das bedeutet:

- Wenn ein Modell im GGUF-Format verwendet wird, ruft Ollama die

llama.cppEffiziente CPU/GPU-Inferenz durchführen. - Wenn ein Modell im Safetensors-Format verwendet wird, benutzt Ollama die

vllmZusätzlich zu den GPUs werden die GPUs häufig für Hochleistungsinferenzen eingesetzt.

Natürlich müssen Sie sich nicht darum kümmern, Sie müssen nur wissen, dass die meisten Dateien, die Sie installieren, im GGUF-Format vorliegen. Warum betonen Sie GGUF?

GGUF-Unterstützung Quantitativ (z. B. Q4, Q6_K)Die Fähigkeit zurBehält eine gute Inferenzleistung bei sehr geringem Grafik- und Speicherbedarf beiWährend Safetensensoren normalerweise vollständige FP16/FP32-Modelle sind, sind sie viel größer und benötigen mehr Ressourcen. Sie können hier mehr erfahren:Was ist Modellquantisierung: Erklärung der Datentypen FP32, FP16, INT8, INT4.

Ollama Mindestanforderungen an die Konfiguration

Betriebssystem: Linux: Ubuntu 18.04 oder höher, macOS: macOS 11 Big Sur oder höher

RAM: 8 GB für die 3B-Modelle, 16 GB für die 7B-Modelle, 32 GB für die 13B-Modelle

Speicherplatz: 12 GB für die Installation von Ollama und des Basismodells, zusätzlicher Speicherplatz für die Modelldaten, je nach verwendetem Modell. Es wird empfohlen, 6 GB Speicherplatz auf dem Laufwerk C zu reservieren.

CPU: Es wird empfohlen, jede moderne CPU mit mindestens 4 Kernen zu verwenden, und für den Betrieb des 13B-Modells wird eine CPU mit mindestens 8 Kernen empfohlen.

GPU (optional): Sie brauchen keinen Grafikprozessor, um Ollama auszuführen, aber er kann die Leistung verbessern, insbesondere bei der Ausführung größerer Modelle. Wenn Sie einen Grafikprozessor haben, können Sie damit das Training von benutzerdefinierten Modellen beschleunigen.

Ollama installieren

Weiter zu: https://ollama.com/download

Wählen Sie einfach nach der Computerumgebung, die Installation ist sehr einfach, das einzige, was hier zu beachten ist, dass die Netzwerkumgebung kann dazu führen, dass die Installation nicht richtig.

macOS-Installation: https://ollama.com/download/Ollama-darwin.zip

Windows-Installation: https://ollama.com/download/OllamaSetup.exe

Linux-Installation:curl -fsSL https://ollama.com/install.sh | sh

Docker-Image: (bitte informieren Sie sich selbst auf der offiziellen Website)

CPU oder Nvidia GPU:docker pull ollama/ollama

AMD-GPUs:docker pull ollama/ollama:rocm

Nach Abschluss der Installation sehen Sie das Ollama-Symbol in der unteren rechten Ecke Ihres Desktops. Wenn das Symbol eine grüne Warnung enthält, bedeutet dies, dass Sie ein Upgrade durchführen müssen.

Ollama-Einrichtung

Ollama ist sehr einfach zu installieren, aber die meisten Einstellungen müssen die "Umgebungsvariablen", die sehr unfreundlich zu Neulingen ist zu ändern, liste ich alle Variablen für diejenigen, die zu verweisen müssen (nicht brauchen, um zu erinnern):

| Parameter | Beschriftung und Konfiguration |

|---|---|

| OLLAMA_MODELLE | Gibt das Verzeichnis an, in dem die Modelldateien gespeichert sind; das Standardverzeichnis istAktuelles Benutzerverzeichnisübernehmen (Büro) C:\Users%username%.ollama\modelsWindows-System Es wird nicht empfohlen, sie auf dem Laufwerk C abzulegen.Sie kann auf anderen Discs platziert werden (z. B. E:\ollama\models) |

| OLLAMA_HOST | ist die Netzwerkadresse, auf die der ollama-Dienst hört, und der Standardwert ist127.0.0.1 Wenn Sie anderen Computern den Zugriff auf Ollama erlauben wollen (z.B. anderen Computern in einem LAN), muss derEmpfohlene Einstellungenin Ordnung sein 0.0.0.0 |

| OLLAMA_PORT | Gibt den Standardport an, auf dem der ollama-Dienst lauscht, der standardmäßig auf11434 Wenn es einen Portkonflikt gibt, können Sie die Einstellungen auf andere Ports ändern (z. B.8080usw.) |

| OLLAMA_ORIGINEN | Gibt die Quelle der Anfrage des HTTP-Clients an, wobei eine durch Komma getrennte Liste von Halbspalten verwendet wird. Wenn die lokale Verwendung nicht eingeschränkt ist, kann es auf ein Sternchen gesetzt werden * |

| OLLAMA_KEEP_ALIVE | Gibt die Überlebensdauer des großen Modells an, nachdem es in den Speicher geladen wurde; der Standardwert ist5mDas sind 5 Minuten. (z. B. eine einfache Zahl 300 bedeutet 300 Sekunden, 0 bedeutet, dass das Modell deinstalliert wird, sobald die Antwort auf die Anfrage verarbeitet wurde, und jede negative Zahl bedeutet, dass es überlebt hat) Es wird empfohlen, die Einstellung 24h Das Modell bleibt 24 Stunden lang im Speicher, was die Zugriffsgeschwindigkeit erhöht. |

| OLLAMA_NUM_PARALLEL | Gibt die Anzahl der gleichzeitig verarbeiteten Anfragen an, Standardwert ist1 (d.h. einzelne gleichzeitige serielle Verarbeitung von Anfragen) Empfehlungen werden an den tatsächlichen Bedarf angepasst |

| OLLAMA_MAX_QUEUE | Gibt die Länge der Anfragewarteschlange an; der Standardwert ist512 Es wird empfohlen, die Länge der Warteschlange an den tatsächlichen Bedarf anzupassen; Anfragen, die diese Länge überschreiten, werden verworfen. |

| OLLAMA_DEBUG | bezeichnet die Ausgabe des Debug-Protokolls, das in der Phase der Anwendungsentwicklung auf die folgenden Werte eingestellt werden kann1 (d.h. Ausgabe detaillierter Protokollinformationen für die Fehlersuche) |

| OLLAMA_MAX_LOADED_MODELS | Gibt die maximale Anzahl von Modellen an, die gleichzeitig in den Speicher geladen werden, Standardwert ist1 (d.h. es kann nur 1 Modell im Speicher sein) |

1. das Download-Verzeichnis für große Modelldateien ändern

Auf Windows-Systemen werden die von Ollama heruntergeladenen Modelldateien standardmäßig in einem bestimmten Verzeichnis unter dem Ordner des Benutzers gespeichert. Der Standardpfad lautet in der RegelC:\Users\<用户名>\.ollama\models. Hier.<用户名>bezieht sich auf den aktuellen Windows-System-Anmeldebenutzernamen.

Wenn zum Beispiel der Login-Benutzername des Systemsyangfankann der Standardspeicherpfad der Modelldatei wie folgt lautenC:\Users\yangfan\.ollama\models\manifests\registry.ollama.ai. In diesem Verzeichnis finden die Nutzer alle über Ollama heruntergeladenen Modelldateien.

Hinweis: Neuere Systeminstallationspfade sind im Allgemeinen:C:\Users\<用户名>\AppData\Local\Programs\Ollama

Große Modell-Downloads können leicht mehrere Gigabyte groß sein. Wenn der Speicherplatz auf Ihrem Laufwerk C klein ist, müssen Sie als erstes das Download-Verzeichnis für große Modelldateien ändern.

1. den Einstiegspunkt für Umgebungsvariablen finden

Der einfachste Weg: Win+R, um das Ausführungsfenster zu öffnen, geben Sie ein sysdm.cplWenn Sie diese Option verwenden möchten, öffnen Sie die Systemeigenschaften, wählen Sie die Registerkarte Erweitert und klicken Sie auf Umgebungsvariablen.

Andere Methoden:

1) Start->Einstellungen->About->Erweiterte Systemeinstellungen->Systemeigenschaften->Umgebungsvariablen.

2) Dieser Computer -> Rechtsklick -> Eigenschaften -> Erweiterte Systemeinstellungen -> Umgebungsvariablen.

3) Start->Systemsteuerung->System und Sicherheit->System->Erweiterte Systemeinstellungen->Systemeigenschaften->Umgebungsvariablen.

4. das Suchfeld unten auf dem Desktop->Eingabe->Umgebungsvariablen

Nach der Eingabe sehen Sie den folgenden Bildschirm:

2. die Umgebungsvariablen ändern

Suchen Sie unter Systemvariablen die Variable OLLAMA_MODELS und klicken Sie auf Neu, wenn sie dort nicht zu finden ist.

Wenn OLLAMA_MODELS bereits existiert, markieren Sie es und doppelklicken Sie mit der linken Maustaste, oder markieren Sie es und klicken Sie auf "Bearbeiten".

Der Wert der Variablen wird in das neue Verzeichnis geändert, hier habe ich es von Laufwerk C auf Laufwerk E geändert, das mehr Speicherplatz bietet.

Nach dem Speichern empfiehlt es sich, den Computer neu zu starten und ihn erneut zu verwenden, um ein sichereres Ergebnis zu erzielen.

2. die Standard-Zugangsadresse und den Standard-Port ändern

Geben Sie im Browser die URL http://127.0.0.1:11434/ ein. Sie werden die folgende Meldung sehen, die anzeigt, dass das Programm läuft, es gibt hier einige Sicherheitsrisiken, die noch in den Umgebungsvariablen geändert werden müssen.

1.ändern Sie OLLAMA_HOST

Wenn nicht, fügen Sie eine neue hinzu, wenn es 0.0.0.0 ist, um den Zugang zum Extranet zu ermöglichen, ändern Sie es in 127.0.0.1

2.ändern Sie OLLAMA_PORT

Wenn Sie ihn nicht haben, fügen Sie ihn hinzu, und ändern Sie 11434 in einen beliebigen Port, z. B.:11331(Der Bereich für die Änderung des Anschlusses reicht von 1 bis 65535.) Wenn Sie die Zahl ab 1000 ändern, können Sie einen Anschlusskonflikt vermeiden. Beachten Sie die Verwendung des englischen ":".

Vergessen Sie nicht, Ihren Computer neu zu starten, um die empfohlenen Informationen über die Sicherheit von Ollama zu lesen:DeepSeek setzt Ollama in Brand, ist Ihr lokaler Einsatz sicher? Hüten Sie sich vor "gestohlener" Arithmetik!

Einbau von Großmodellen

Weiter zur URL: https://ollama.com/search

Modell auswählen, Modellgröße auswählen, Kopierbefehl

Zugang zu Befehlszeilentools

Fügen Sie den Befehl ein, um es automatisch zu installieren

Es wird hier heruntergeladen, wenn es also langsam ist, sollten Sie zu einer glücklicheren Internetumgebung wechseln!

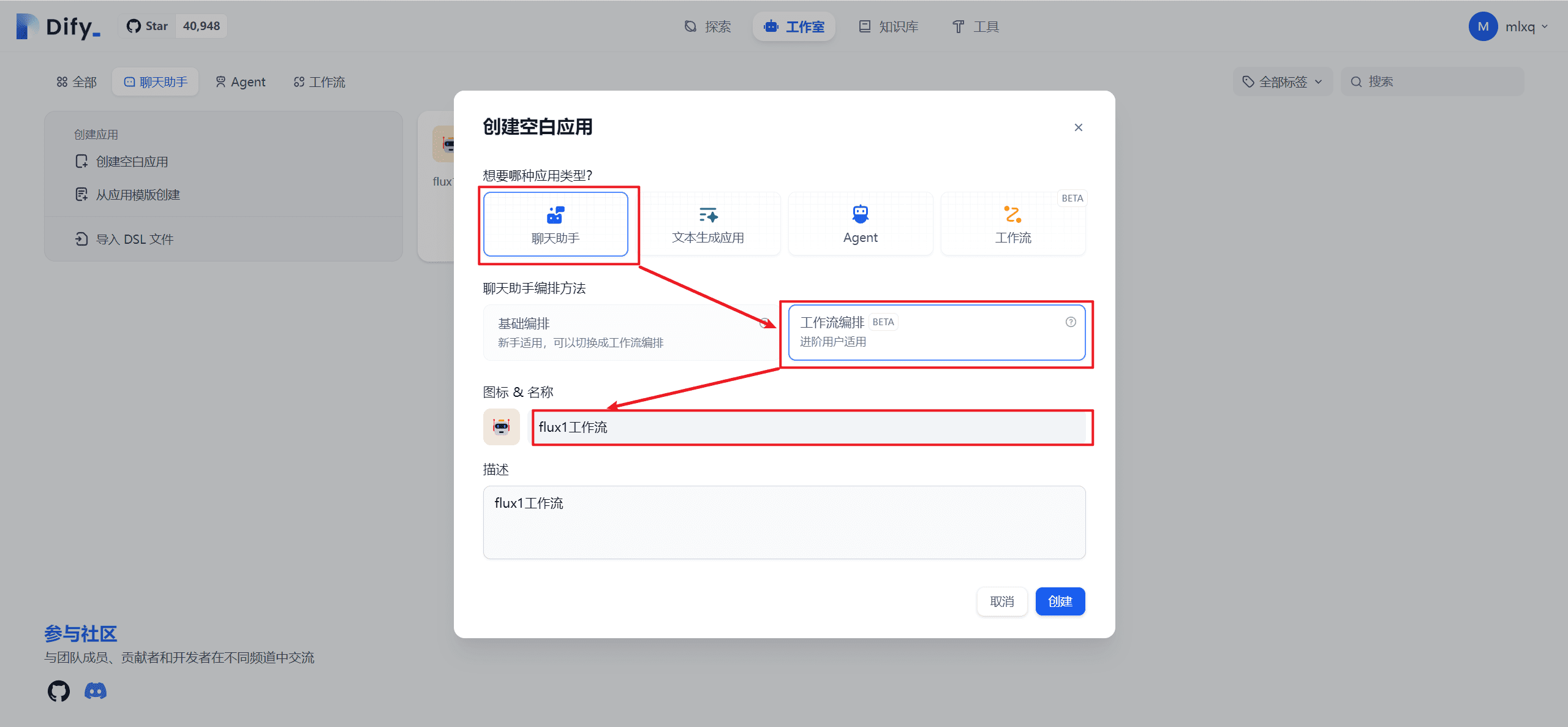

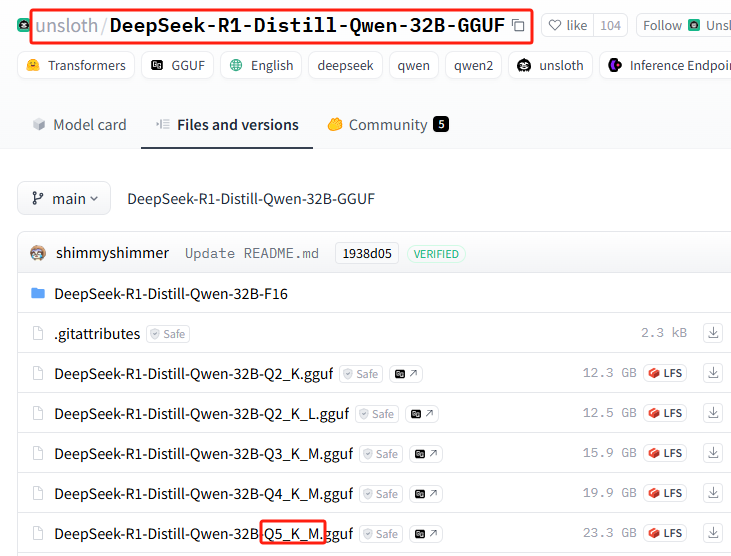

Wenn Sie große Modelle herunterladen möchten, die Ollama nicht anbietet, können Sie das natürlich tun, die meisten davon sind GGUF-Dateien auf huggingface, und ich habe eine spezielle quantisierte Version der DeepSeek-R1 32B wird als Beispiel für eine Installationsdemonstration verwendet.

1. die Installation des quantitativen Versionierungsmodells von Huggingface im Basisbefehlsformat

Merken Sie sich das folgende Format für den Installationsbefehl

ollama run hf.co/{username}:{reponame}

2. die Auswahl der quantitativen Version

Liste aller quantitativen Versionen: https://huggingface.co/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF/tree/main

Diese Installation verwendet: Q5_K_M

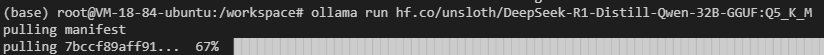

3. der Befehl "Spleiß-Installation

{Benutzername}=unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF

{reponame}=Q5_K_M

Spleißen Sie sie zusammen, um den vollständigen Installationsbefehl zu erhalten:ollama run hf.co/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF:Q5_K_M

4. die Installation in Ollama durchführen

Führen Sie den Installationsbefehl aus

Es kann zu Netzwerkfehlern kommen (viel Glück dabei), wiederholen Sie den Installationsbefehl noch ein paar Mal...

Funktioniert immer noch nicht? Versuchen Sie den folgenden Befehl.hf.co/Der Abschnitt erhält folgenden Wortlauthttps://hf-mirror.com/(Wechsel zur inländischen Mirror-Adresse), sieht das endgültige Patchwork des vollständigen Installationsbefehls wie folgt aus:

ollama run https://hf-mirror.com/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF:Q5_K_M

Eine vollständige Anleitung für diesen Abschnitt ist verfügbar:Privater Einsatz ohne lokale GPUs DeepSeek-R1 32B

Ollama Grundlegende Befehle

| Befehl | Beschreibungen |

|---|---|

ollama serve | Ollama starten |

ollama create | Erstellen von Modellen aus Modelldateien |

ollama show | Anzeige von Modellinformationen |

ollama run | Betriebsmodell |

ollama stop | Anhalten eines laufenden Modells |

ollama pull | Abrufen von Modellen aus der Registry |

ollama push | Modelle in die Registry verschieben |

ollama list | Alle Modelle auflisten |

ollama ps | Liste laufender Modelle |

ollama cp | Replikationsmodelle |

ollama rm | Modell löschen |

ollama help | Anzeige von Hilfeinformationen zu einem beliebigen Befehl |

| symbolisieren | Beschreibungen |

|---|---|

-h, --help | Hilfeinformationen für Ollama anzeigen |

-v, --version | Anzeige von Versionsinformationen |

Wenn Sie Befehle auf mehreren Zeilen eingeben, können Sie die """ Führen Sie einen Zeilenvorschub durch.

ausnutzen """ Zeilenvorschub am Ende.

Um den Ollama-Modellinferenzdienst zu beenden, können Sie die /bye.

Verwendung von Ollama in einem nativen KI-Dialogwerkzeug

Die meisten der gängigen nativen KI-Dialogwerkzeuge sind bereits standardmäßig an Ollama angepasst und erfordern keine weiteren Einstellungen. Zum Beispiel Seite Assist OpenwebUI.

Bei einigen lokalen KI-Dialog-Tools müssen Sie jedoch die API-Adresse selbst eingeben.http://127.0.0.1:11434/(beachten Sie, ob der Anschluss geändert wurde)

Einige webbasierte AI-Dialog-Tools unterstützen die Konfiguration, zum Beispiel NächsterChat :

Wenn Sie möchten, dass Ollama auf Ihrem lokalen Computer läuft und vollständig für die externe Nutzung zugänglich ist, müssen Sie cpolar oder ngrok selbst erlernen, was den Rahmen des Anfängerprogramms sprengen würde.

Der Artikel scheint sehr lang zu sein, in der Tat, innerhalb der 4 sehr einfachen Wissen Punkte, lernen die künftige Nutzung von Ollama im Grunde ungehindert, lassen Sie uns noch einmal überprüfen:

1. die Einstellung von Umgebungsvariablen

2. zwei Möglichkeiten zur Installation eines großen Modells

3. erinnern Sie sich an die grundlegenden Befehle zum Ausführen und Löschen von Modellen

4. die Verwendung in verschiedenen Mandanten

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...