Ollama Local Deployment Model Access Dify

Dify Unterstützung Zugang Ollama Einsatz umfangreicher Sprachmodell-Inferenz und Einbettungsfunktionen.

Schneller Zugang

- Ollama herunterladen

Interviews Ollama Installation und KonfigurationWeitere Informationen finden Sie im Ollama Local Deployment Tutorial. - Ollama laufen lassen und mit Llama chatten

ollama run llama3.1Nach erfolgreichem Start startet ollama einen API-Dienst auf dem lokalen Port 11434, der über die

http://localhost:11434Zugang.

Weitere Modelle sind unter https://ollama.ai/library erhältlich. - Zugang zu Ollama in Dify

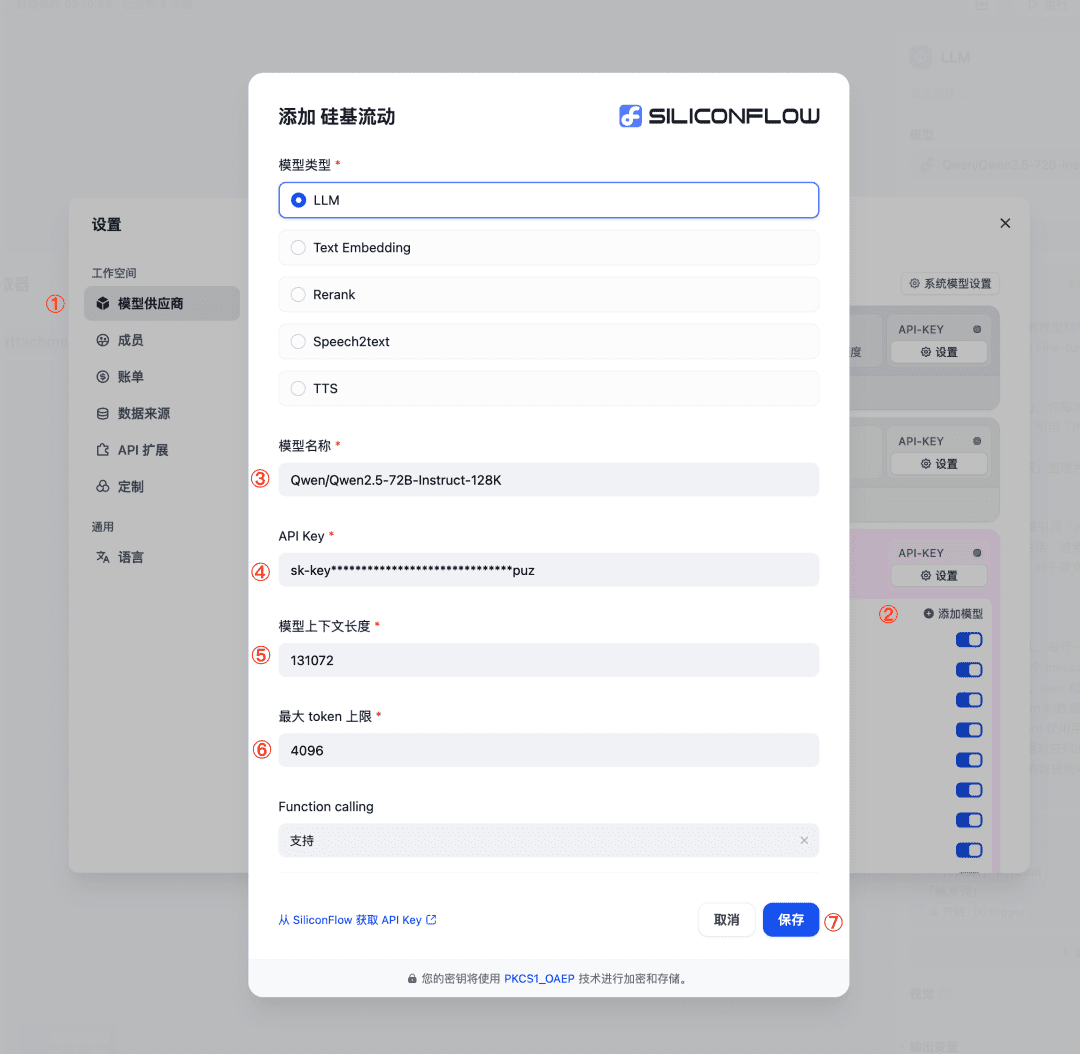

existieren设置 > 模型供应商 > OllamaFüllen Sie die Lücken aus:

- Modellname:

llama3.1 - Basis-URL:

http://<your-ollama-endpoint-domain>:11434

Die Adresse des Ollama-Dienstes, auf den zugegriffen werden kann, wird hier benötigt.

Wenn Dify als Docker eingesetzt wird, empfiehlt es sich, z.B. die LAN-IP-Adresse einzutragen:http://192.168.1.100:11434oder z. B. die IP-Adresse des Docker-Hosts:http://172.17.0.1:11434.Hinweis: Der Befehl LAN-IP-Adresse suchen:

- Unter Linux/macOS verwenden Sie den Befehl

ip addr showvielleichtifconfig. - Unter Windows verwenden Sie die

ipconfigBefehl, um ähnliche Adressen zu finden. - Normalerweise wird diese Adresse unter der Schnittstelle eth0 oder wlan0 angezeigt, je nachdem, ob Sie ein kabelgebundenes oder drahtloses Netzwerk verwenden.

Wenn Sie für lokalen Quellcode eingesetzt werden, füllen Sie das Feld

http://localhost:11434. - Unter Linux/macOS verwenden Sie den Befehl

- Modell Typ:

对话 - Modell Kontextlänge:

4096

Die maximale Kontextlänge des Modells, falls nicht klar, können Sie den Standardwert 4096 eingeben. - größte Token Kappe:

4096

Die maximale Anzahl von Token, die vom Modell als Inhalt zurückgegeben werden, die mit der Länge des Modellkontexts übereinstimmen kann, wenn das Modell nichts anderes angibt. - Ob Vision unterstützt wird oder nicht:

是

Wenn das Modell das Verstehen von Bildern unterstützt (multimodal), kreuzen Sie dieses Feld an, z. B.llava.

Klicken Sie auf "Speichern", um zu überprüfen, ob das Modell korrekt ist und in Ihrer Anwendung verwendet werden kann.

Der Zugriff auf das Einbettungsmodell erfolgt auf ähnliche Weise wie beim LLM, indem der Modelltyp auf Texteinbettung geändert wird. - Modellname:

- Verwendung des Ollama-Modells

Gehen Sie auf die Seite App Prompt Orchestration für die App, die Sie konfigurieren möchten, und wählen Sie den Ollama-Anbieter unter der Optionllama3.1Modell, konfigurieren Sie die Modellparameter und verwenden Sie es.

FAQ

⚠️ Wenn Sie Docker zur Bereitstellung von Dify und Ollama verwenden, kann der folgende Fehler auftreten.

httpconnectionpool(host=127.0.0.1, port=11434): max retries exceeded with url:/cpi/chat (Caused by NewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>: fail to establish a new connection:[Errno 111] Connection refused'))

httpconnectionpool(host=localhost, port=11434): max retries exceeded with url:/cpi/chat (Caused by NewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>: fail to establish a new connection:[Errno 111] Connection refused'))

Dieser Fehler tritt auf, weil der Docker-Container nicht auf den Ollama-Dienst zugreifen kann. Der localhost bezieht sich normalerweise auf den Container selbst, nicht auf den Host oder andere Container. Um dieses Problem zu beheben, müssen Sie den Ollama-Dienst für das Netzwerk freigeben.

Einstellen von Umgebungsvariablen auf einem Mac

für den Fall, dass Ollama handeln als macOS Anwendung läuft, sollte der folgende Befehl verwendet werden, um die Umgebungsvariablen zu setzenlaunchctl ::

- Durch den Aufruf der

launchctl setenvSetzen von Umgebungsvariablen:launchctl setenv OLLAMA_HOST "0.0.0.0" - Starten Sie die Ollama-Anwendung neu.

- Wenn die oben genannten Schritte nicht funktionieren, können Sie die folgende Methode anwenden:

Das Problem ist, dass Sie sich innerhalb von Docker mit demhost.docker.internalum auf den Docker-Host zuzugreifen, setzen Sie also dielocalhostErsetzen durchhost.docker.internalDer Dienst ist nun einsatzbereit:http://host.docker.internal:11434

Setzen von Umgebungsvariablen unter Linux

Wenn Ollama als systemd-Dienst ausgeführt wird, sollten Sie die systemctl Setzen von Umgebungsvariablen:

- Durch den Aufruf der

systemctl edit ollama.serviceBearbeiten Sie den systemd-Dienst. Dadurch wird ein Editor geöffnet. - Für jede Umgebungsvariable wird die

[Service]Fügen Sie eine Zeile unter dem AbschnittEnvironment::[Service] Environment="OLLAMA_HOST=0.0.0.0" - Speichern und beenden.

- schwere Ladung (auf einem Lastwagen)

systemdund Ollama neu starten:systemctl daemon-reload systemctl restart ollama

Setzen von Umgebungsvariablen unter Windows

Unter Windows erbt Ollama Ihre Benutzer- und Systemumgebungsvariablen.

- Klicken Sie zunächst auf Ollama in der Taskleiste, um das Programm zu beenden.

- Systemumgebungsvariablen über die Systemsteuerung bearbeiten

- Bearbeiten oder erstellen Sie neue Variablen für Ihr Benutzerkonto, z. B.

OLLAMA_HOSTundOLLAMA_MODELSusw. - Klicken Sie auf OK/Apply, um die Anwendung zu speichern.

- In einem neuen Terminalfenster ausführen

ollama

Wie stelle ich Ollama in meinem Netzwerk zur Verfügung?

Ollama bindet sich standardmäßig an Port 11434 auf 127.0.0.1. über die OLLAMA_HOST Umgebungsvariablen ändern die Bindungsadresse.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...