Der neueste KI-Chatbot von Nvidia arbeitet unabhängig auf Ihrem PC und ist völlig kostenlos.

Nvidias GPUs der GeForce RTX 40-Serie.

Wenn Sie einen Grafikprozessor der GeForce RTX 30-Serie oder neuer besitzen, ermöglicht die Demo-App mit dem Namen "Chat with RTX" personalisierte Inhaltsdienste, die keine Internetverbindung erfordern.

Nvidia hat Chat with RTX auf den Markt gebracht, einen KI-Chatbot, der auf jedem PC läuft, der mit einer Grafikkarte der RTX 30- oder 40-Serie mit mindestens 8 GB VRAM ausgestattet ist.

Auch das Auffinden und Zusammenfassen von lokalen Dokumenten oder YouTube-Videos wird unterstützt.

Empfohlene Lektüre:[World's Best AI Chatbots: ChatGPT and Other Alternatives]

Angetrieben von Nvidias TensorRT-LLM-Software, generiert die App nicht nur Inhalte, sondern lernt auch aus dem vom Benutzer bereitgestellten Material, mit Unterstützung für Dateitypen wie .txt, .pdf, .doc/.docx, .xml und der Möglichkeit, auf die URL eines YouTube-Videos zu verlinken.

Nach der Auswahl der Inhalte, mit denen der Roboter trainiert werden soll, können die Nutzer ihm individuelle Fragen zu diesen Inhalten stellen. So könnte der Roboter zum Beispiel Schritt-für-Schritt-Anweisungen aus einem YouTube-Anleitungsvideo skizzieren oder dem Nutzer sagen, welche Batterie auf seiner Einkaufsliste steht.

Die Bots werden auf der Grundlage der bevorzugten Inhalte des Nutzers trainiert, wodurch das gesamte Erlebnis persönlicher und individueller wird. Und die lokalisierte Verarbeitung der Daten gewährleistet den Schutz der Nutzerinformationen. Der Chat mit RTX" garantiert die Sicherheit der Nutzerdaten, da er nicht auf Cloud-Dienste angewiesen ist und auch in einer netzlosen Umgebung schnell reagieren kann.

Siehe auch: [ChatGPT vs Copilot: Welcher KI-Chatbot ist besser für Sie?]

Um diesen Chatbot auszuführen, benötigen Sie einen Nvidia-Grafikprozessor der Serie GeForce RTX 30 oder besser mit mindestens 8 GB Videospeicher." Chat mit RTX erfordert außerdem das Betriebssystem Windows 10 oder 11 und die neuesten Nvidia-GPU-Treiber.

Nvidia hat gezeigt, dass seine TensorRT-LLM-Software Retrieval Augmented Generation (RAG) und RTX-Beschleunigung kombiniert, um "Chatten mit RTX" zu ermöglichen, ohne sich auf das Netzwerk zu verlassen, indem lokale Dateien als Wissensbasis verwendet und mit Funktionen wie Mistral und Open Source Large Language Models (LLMs) wie Llama 2, um präzise Antworten zu geben.

Chat mit RTX Review

Nvidia enthüllte heute seine [Chat mit RTXEine frühe Version von ] - eine Demo-App, mit der Sie Ihren eigenen KI-Chatbot auf Ihrem PC betreiben können. Egal, ob es sich um ein YouTube-Video oder ein persönliches Dokument handelt, es kann verwendet werden, um Zusammenfassungen zu erstellen oder relevante Antworten auf der Grundlage persönlicher Daten zu erhalten. Der gesamte Prozess findet vollständig auf Ihrem lokalen Computer statt, und alles, was Sie brauchen, ist eine Grafikkarte der RTX 30- oder 40-Serie mit mindestens 8 GB VRAM.

Ich habe den Chat mit RTX in den letzten Tagen kurz ausprobiert, und obwohl die Anwendung noch rudimentär ist, kann ich schon jetzt erkennen, dass sie sich zu einem wertvollen Werkzeug für die Datenrecherche entwickeln könnte, sowohl für Journalisten als auch für alle Benutzer, die zahlreiche Dokumente analysieren müssen.

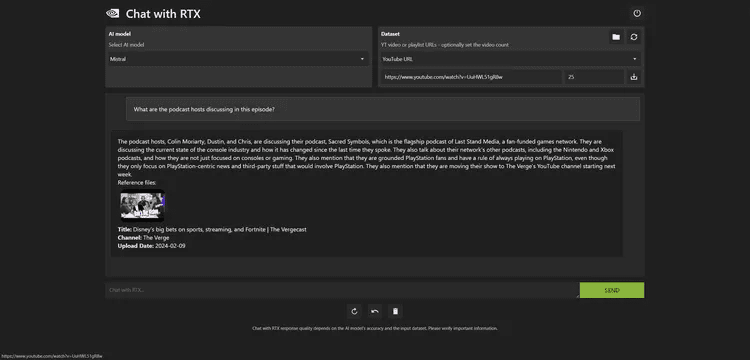

Chat mit RTX unterstützt die Verarbeitung von YouTube-Videos. Man gibt einfach die URL des Videos ein und kann nach bestimmten Untertiteln suchen oder das gesamte Video zusammenfassen. Dies ist für mich besonders nützlich bei der Suche nach Video-Podcasts, vor allem bei der Suche nach bestimmten Inhalten aus der letzten Woche mit Gerüchten über Microsofts neue Xbox-Strategieänderung.

Allerdings ist es nicht perfekt, wenn es um die Suche nach YouTube-Videos geht. Wenn man versucht, nach Untertiteln für ein YouTube-Video von _Verge_ zu suchen, lädt Chat mit RTX stattdessen Untertitel für ein ganz anderes Video herunter, was offenbar ein Fehler in früheren Versionen ist.

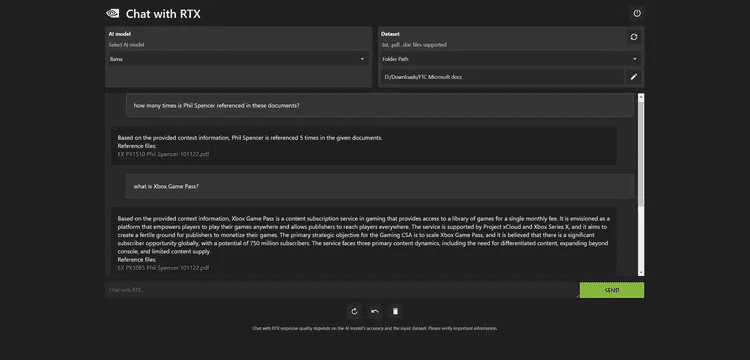

Abbildung 1: Chat mit RTX zeichnet sich durch die Suche in lokalen Dokumenten aus.

Wenn es richtig funktioniert, konnte ich innerhalb von Sekunden relevante Inhalte im Video finden. Ich habe Chat mit RTX auch verwendet, um den Dokumentensatz für den Fall _FTC vs. Microsoft_ zu analysieren. Als ich letztes Jahr über diesen Fall berichtete, musste ich eine große Anzahl von Dokumenten schnell durchsehen.

Die Dokumentation ist eine große Herausforderung, aber der Chat mit RTX ermöglicht es mir, Abfragen fast sofort zu erledigen.

So war der Chatbot beispielsweise in der Lage, die Xbox Game Pass-Strategie von Microsoft anhand von internen Dokumenten, die im Rahmen des Prozesses veröffentlicht wurden, genau zusammenzufassen:

Den Hintergrundinformationen zufolge handelt es sich bei Xbox Game Pass um einen Abonnementdienst für Spieleinhalte, der gegen eine einmalige monatliche Gebühr Zugang zu einer Bibliothek von Spielen bietet. Es soll eine Plattform sein, die es den Spielern ermöglicht, ihre Spiele überall zu spielen, und den Verlegern, Spieler weltweit zu erreichen. Der Dienst wird von Project xCloud und Xbox Series X unterstützt und soll den Verlagen ein günstiges Umfeld für die Realisierung ihrer Spiele bieten. Das strategische Hauptziel der Gaming CSA ist es, den Xbox Game Pass mit einem globalen Markt von bis zu 750 Millionen potenziellen Abonnenten auszubauen. Der Dienst steht vor drei großen inhaltlichen Herausforderungen: die Nachfrage nach differenzierten Inhalten, die Ausweitung auf andere Plattformen als Konsolen und die begrenzte Verfügbarkeit von Inhalten.

Ich fand das Tool auch hilfreich beim schnellen Scannen von PDF-Dokumenten und Überprüfen von Daten. Während Microsofts eigenes Copilot-System PDF-Dateien innerhalb von Word nicht sehr gut handhabt, konnte Nvidias Chat mit RTX alle wichtigen Informationen problemlos extrahieren und war so reaktionsschnell, dass es fast keine wahrnehmbare Latenz gab, was eine ganz andere Erfahrung ist als bei der Verwendung der Cloud-basierten ChatGPT- oder Copilot-Chatbots.

Das Hauptproblem von Chat with RTX ist, dass es sich wirklich wie eine anfängliche Entwicklerdemo anfühlt. In Wirklichkeit installiert Chat with RTX einen Webserver und eine Python-Instanz auf Ihrem PC, verarbeitet die eingehenden Daten durch ein Mistral- oder Llama-2-Modell und nutzt dann Nvidias Tensor-Kern, um den Abfrageprozess durch RTX-GPUs zu beschleunigen.

Abbildung 2: Die Genauigkeit von Chats mit RTX ist manchmal verzerrt.

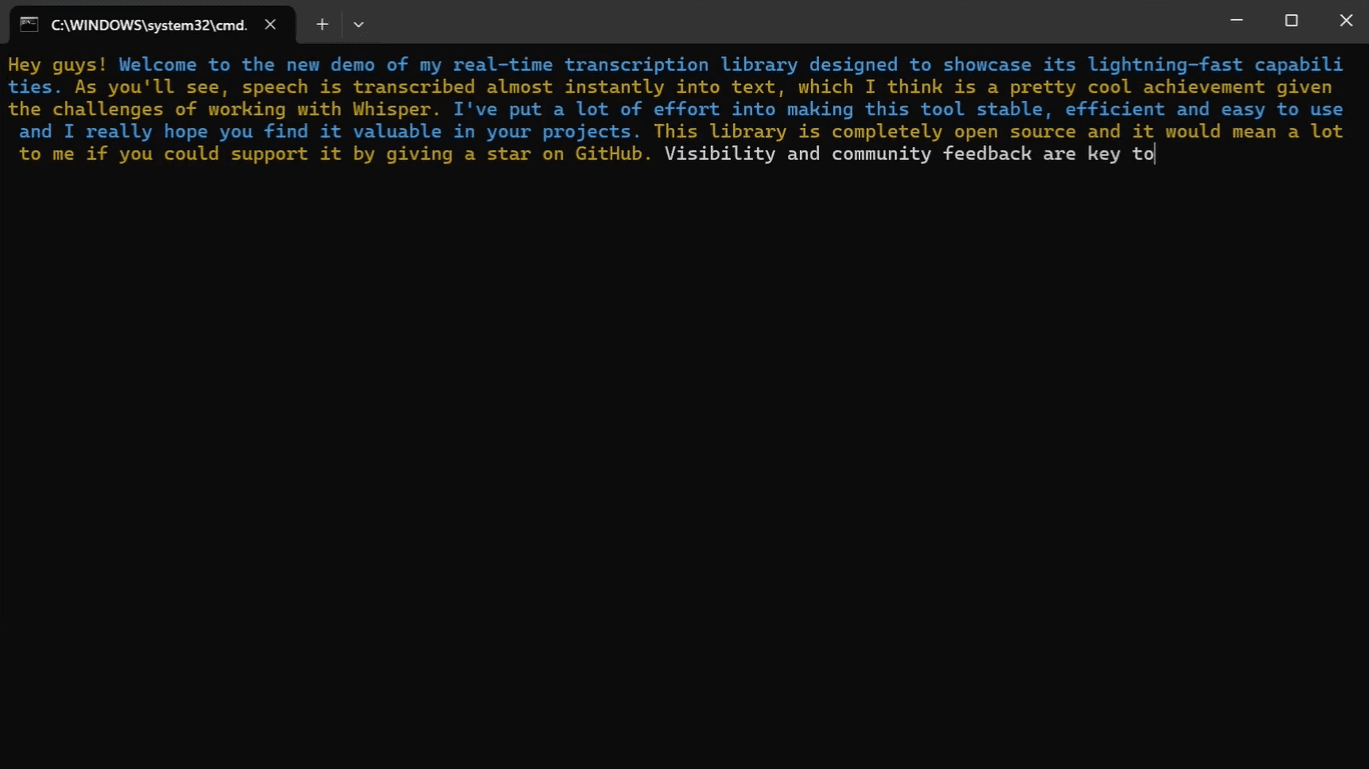

Auf meinem PC mit einem Intel Core i9-14900K-Prozessor und RTX 4090-GPU dauerte die Installation von Chat mit RTX etwa 30 Minuten. Die Anwendung ist fast 40 GB groß, wobei die Python-Instanz etwa 3 GB RAM von insgesamt 64 GB RAM auf meinem System beansprucht. Sobald sie läuft, können Sie über einen Browser auf Chat mit RTX zugreifen, wobei im Hintergrund der Prozess und alle Fehlercodes über eine Eingabeaufforderung angezeigt werden.

Nvidia hat sie nicht als vollwertige Anwendung veröffentlicht, die alle RTX-Nutzer sofort herunterladen und installieren sollten. Es gibt einige bekannte Probleme und Einschränkungen mit der App, einschließlich der Tatsache, dass die Quellenangabe nicht immer korrekt ist. Ich habe anfangs versucht, sie dazu zu bringen, 25.000 Dokumente zu indizieren, aber das führte dazu, dass die App abstürzte und die Einstellungen gelöscht werden mussten, um neu zu starten.

Außerdem merkt sich der Chat mit RTX nicht den vorherigen Kontext, so dass nachfolgende Ausgaben nicht auf dem Kontext der vorherigen Ausgabe basieren können. Außerdem werden JSON-Dateien im Indexordner erstellt. Ich empfehle daher nicht, diese Funktion generell im Ordner "Dokumente" unter Windows zu verwenden.

Nichtsdestotrotz bin ich nach wie vor sehr an technischen Demos wie dieser interessiert, und Nvidia hat in diesem Bereich wirklich Potenzial gezeigt. Das verheißt Gutes für die Zukunft von KI-Chatbots, die lokal auf dem PC laufen, insbesondere für diejenigen, die keine Dienste wie Copilot Pro oder ChatGPT Plus abonnieren wollen, um persönliche Dateien zu analysieren.

Chat mit RTX Download

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Verwandte Beiträge

Keine Kommentare...