MuseV+Muse Talk: Komplettes digitales menschliches Videogenerierungs-Framework | Portrait zu Video | Pose zu Video | Lippensynchronisation

Allgemeine Einführung

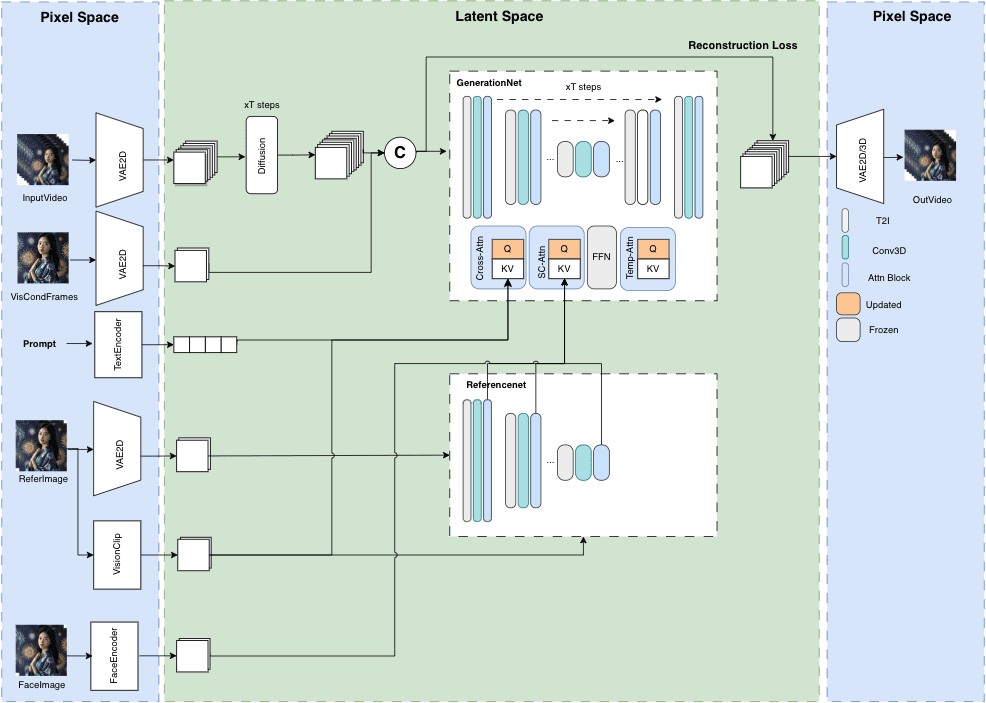

MuseV ist ein öffentliches Projekt auf GitHub, das auf die Erzeugung von Avatar-Videos von unbegrenzter Länge und hoher Wiedergabetreue abzielt. Es basiert auf der Diffusionstechnologie und bietet verschiedene Funktionen wie Image2Video, Text2Image2Video, Video2Video und mehr. Details der Modellstruktur, Anwendungsfälle, Schnellstartanleitung, Inferenzskripte und Danksagungen werden bereitgestellt.

MuseV ist ein Rahmenwerk zur Erzeugung virtueller menschlicher Videos, das auf einem Diffusionsmodell mit den folgenden Merkmalen basiert:

Es unterstützt die Erzeugung unendlicher Längen mit Hilfe eines neuartigen visuellen bedingten parallelen Entrauschungsschemas ohne das Problem der Fehlerakkumulation, insbesondere für Szenen mit festen Kamerapositionen.

Es wird ein vortrainiertes Modell für die Erzeugung von Avatar-Videos bereitgestellt, das anhand eines Datensatzes von Charakteren trainiert wurde.

Unterstützt Bild-zu-Video-, Text-zu-Bild-zu-Video- und Video-zu-Video-Generierung.

Kompatibel mit dem Stable Diffusion-Ökosystem zur Grafikerstellung, einschließlich base_model, lora, controlnet und anderen.

Unterstützung für mehrere Referenzbildtechnologien, einschließlich IPAdapter, ReferenceOnly, ReferenceNet, IPAdapterFaceID.

Wir werden den Schulungscode später ebenfalls einführen.

Funktionsliste

Unbegrenzt lange Videos erzeugen

Naturgetreue virtuelle menschliche Bilder

Vielseitige Unterstützung: Image2Video, Text2Image2Video, Video2Video

Klare Modellstruktur und Anwendungsfälle

Schnellstart und Reasoning Scripts

Hilfe verwenden

Besuchen Sie die GitHub-Repositories für Updates und herunterladbare Ressourcen

Folgen Sie der Schnellstartanleitung für die Ersteinrichtung des Projekts

Generierung von Videoinhalten mit Hilfe der mitgelieferten Argumentationsskripte

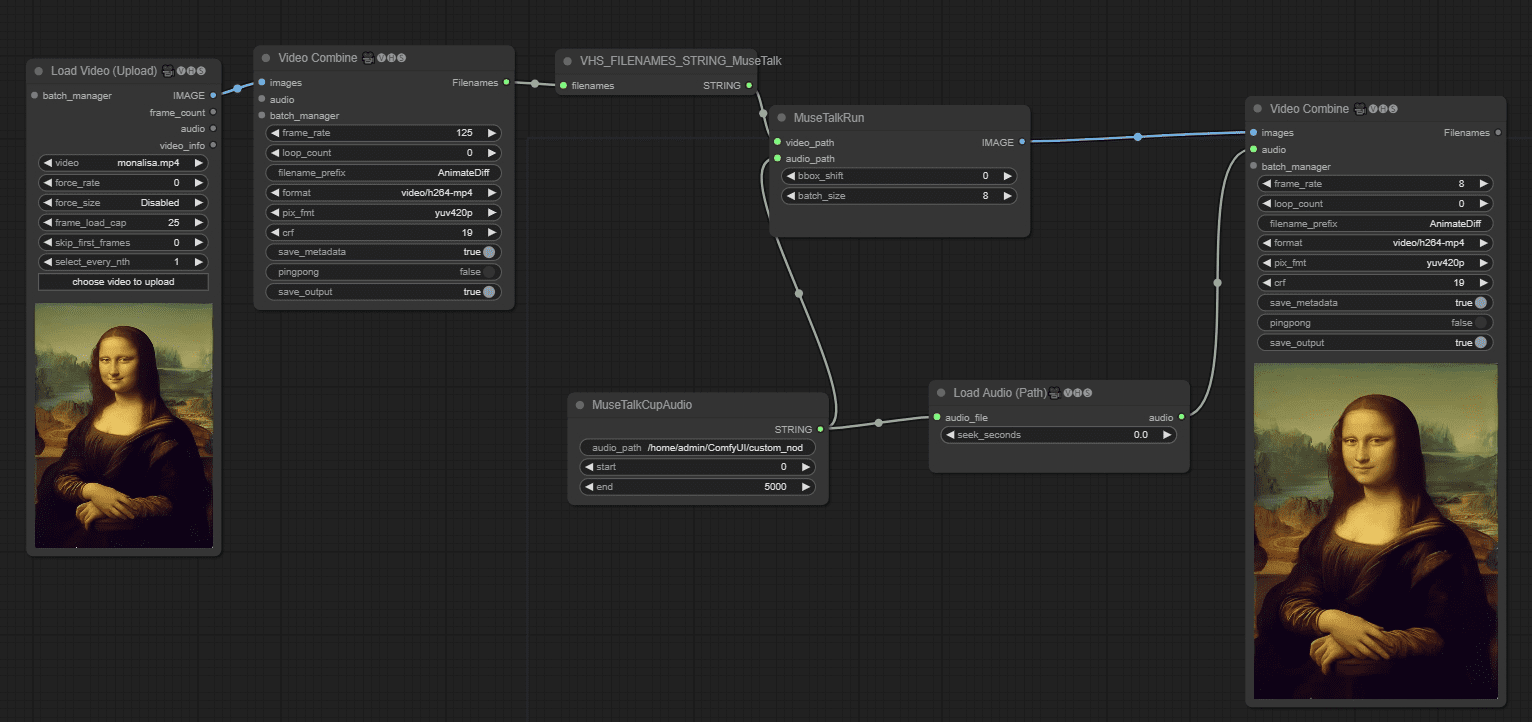

Methode der kombinierten Nutzung:

Methode 1: Live-Videoaufnahme + Muse Talk

Methode 2: Bild + MuseV + Muse Talk

ein fertiges Produkt

Aus einem Standbild Video-Loop, machen die Anime-Charakter sprechen, die Zeichentrickfigur selbst Lippen fehlt, die es seltsam zu sprechen macht, das nächste Mal sollten Sie das Bild mit "Lippen", vorzugsweise "echte Menschen" ändern. 45 Sekunden des Videos in der offiziellen Warten Sie etwa 15 Minuten auf die Testumgebung.

Video in ComfyUI-Workflows zum Sprechen bringen

Wir starten MuseTalk MuseTalk ist ein hochwertiges Echtzeit-Mundsynchronisationsmodell (30fps+ auf NVIDIA Tesla V100). MuseTalk kann mit Eingabevideos, wie z. B. dem von MuseV generierten, als vollständige Avatarlösung verwendet werden.

MuseV Online-Erfahrung / Windows-Ein-Klick-Installationspaket

Das MuseV-Begleitmund-Synchronisationsmodell MuseTalk

Link: https://pan.quark.cn/s/ed896ceda5c8

Auszug Code: JygA

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...