Allgemeine Einführung

Model Context Provider CLI (mcp-cli) ist ein Befehlszeilenwerkzeug auf Protokollebene für die Interaktion mit Model Context Provider-Servern. Das Tool ermöglicht es Benutzern, Befehle zu senden, Daten abzufragen und mit einer Vielzahl von Ressourcen zu interagieren, die vom Server bereitgestellt werden. mcp-cli unterstützt mehrere Anbieter und Modelle, einschließlich OpenAI und Ollama, wobei die Standardmodelle gpt-4o-mini bzw. qwen2.5-coder sind. Das Tool erfordert Python 3.8 oder höher sowie die entsprechenden Abhängigkeiten. Sie können das Tool verwenden, indem Sie das GitHub-Repository klonen und die erforderlichen Abhängigkeiten installieren.

Funktionsliste

- Unterstützung für die Kommunikation auf Protokollebene mit Servern für die Bereitstellung von Modellkontexten

- Dynamische Tools und Ressourcen zum Erkunden

- Unterstützung für mehrere Anbieter und Modelle (OpenAI und Ollama)

- Bietet einen interaktiven Modus, in dem Benutzer dynamisch Befehle ausführen können

- Unterstützte Befehle sind: ping, list-tools, list-resources, list-prompts, chat, clear, help, quit/exit

- Folgende Befehlszeilenparameter werden unterstützt: --server, --config-file, --provider, --model

Hilfe verwenden

Ablauf der Installation

- Klon-Lagerhaus:

git clone https://github.com/chrishayuk/mcp-cli

cd mcp-cli

- UV installieren:

pip installieren uv

- Synchronisierung der Abhängigkeiten:

uv . --Neuinstallation

Verwendung

- Starten Sie den Client und interagieren Sie mit dem SQLite-Server:

uv run main.py --server sqlite

- Führen Sie den Client mit dem Standard-OpenAI-Anbieter und -Modell aus:

uv run main.py --server sqlite

- Mit spezifischen Konfigurationen und Ollama Der Provider betreibt den Client:

uv run main.py --server sqlite --provider ollama --model llama3.2

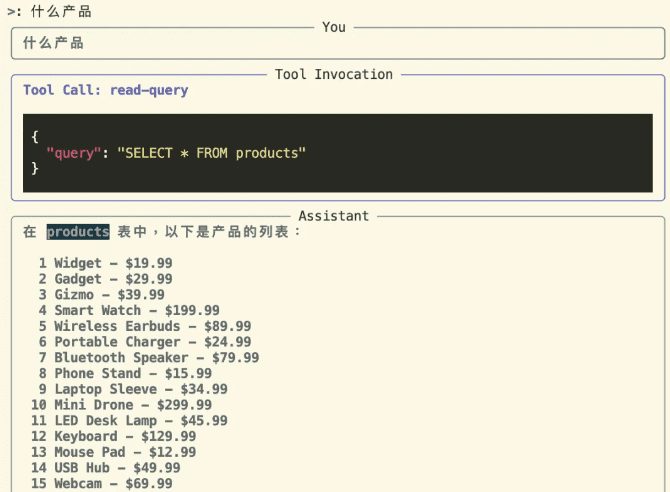

interaktiver Modus

Wechseln Sie in den interaktiven Modus und interagieren Sie mit dem Server:

uv run main.py --server sqlite

Im interaktiven Modus können Sie das Tool verwenden und mit dem Server interagieren. Der Anbieter und das Modell, die beim Start angegeben wurden, werden wie folgt angezeigt:

Eintritt in den Chat-Modus mit Anbieter 'ollama' und Modell 'ollama3.2'...

Unterstützte Befehle

ping (Computertechnik)Prüfen, ob der Server antwortetlist-tools: Verfügbare Tools anzeigenListe-RessourcenVerfügbare Ressourcen anzeigenlist-prompts: Verfügbare Tipps anzeigenChatInteraktiven Chat-Modus aufrufenklarLöschen des TerminalbildschirmsHilfeZeigt eine Liste der unterstützten Befehle an.kündigen/AusgangExit Client

Verwendung von OpenAI-Providern

Wenn Sie ein OpenAI-Modell verwenden möchten, sollten Sie die Option OPENAI_API_KEY Umgebungsvariable, die sich in der Datei .env Datei oder als Umgebungsvariable gesetzt.