Allgemeine Einführung

Go-with-the-Flow ist ein Open-Source-Projekt, das vom Forschungsteam der Netflix Eyeline Studios entwickelt wurde, um die Bewegungsmuster von Videodiffusionsmodellen durch Verzerrung des Rauschens zu steuern. Mit dem Projekt können Benutzer bestimmen, wie sich Kameras und Objekte in einer Szene bewegen, und sogar Bewegungsmuster von einem Video auf ein anderes übertragen.Go-with-the-Flow erreicht dies durch Feinabstimmung des zugrunde liegenden Modells, ohne die ursprüngliche Pipeline oder Architektur zu ändern. Der Code und die Modelle des Projekts sind Open Source und können von den Nutzern frei verwendet und verändert werden.

ComfyUI-Knoten: https://github.com/kijai/ComfyUI-VideoNoiseWarp

Funktionsliste

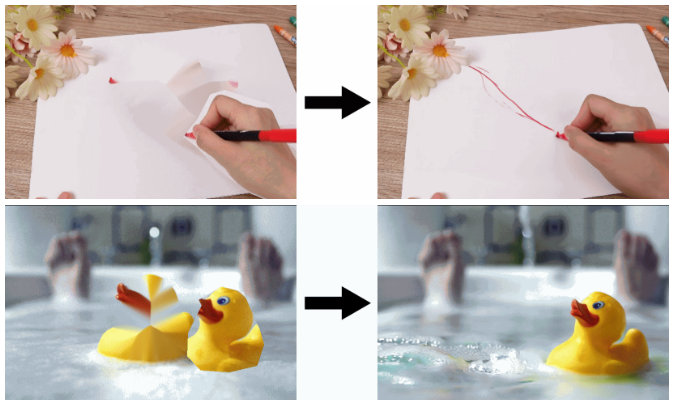

- Steuerung von Scher- und SchleppbewegungenBenutzer können Videos erstellen, indem sie verschiedene Teile eines Bildes ausschneiden und sie herumziehen.

- Verbreitung von VideosDie Umwandlung einer groben Animation in eine schöne Animation erfordert den Einsatz des Grafikprozessors.

- RauschverzerrungVerwenden Sie verzerrtes Rauschen anstelle von reinem Gaußschen Rauschen, um eine natürlichere Bewegung zu erzielen.

- Bewegungsmodus VerschiebungBewegungsmuster von einem Video auf ein anderes übertragen.

- Grafische Benutzeroberfläche (GUI)Bietet ein natives GUI für vom Benutzer erstellte Animationen.

- offene QuelleAlle Codes und Modelle sind quelloffen und können von den Benutzern frei zugänglich gemacht und verändert werden.

Hilfe verwenden

Ablauf der Installation

- Klon-Lagerhaus:

git clone https://github.com/VGenAI-Netflix-Eyeline-Research/Go-with-the-Flow.git

cd Mit-dem-Fluss-gehen

- Installieren Sie lokale Abhängigkeiten:

pip install -r anforderungen_lokal.txt

- Starten Sie die GUI:

python cut_and_drag_gui.py

Folgen Sie den Anweisungen in der grafischen Benutzeroberfläche, um den Vorgang abzuschließen. Die erzeugten MP4-Dateien müssen zur weiteren Verarbeitung auf einen Computer mit einem Grafikprozessor übertragen werden.

Verwendung Prozess

- Klonen Sie das Repository und installieren Sie die Abhängigkeiten auf einem Computer mit einem Grafikprozessor:

git clone https://github.com/VGenAI-Netflix-Eyeline-Research/Go-with-the-Flow.git

cd Go-with-the-Flow

pip install -r anforderungen.txt

- Verzerrungsrauschen:

python make_warped_noise.py --output_folder noise_warp_output_folder

- Running Reasoning:

python cut_and_drag_inference.py noise_warp_output_folder \

--prompt "Eine Ente plätschert" \\

--output_mp4_path "output.mp4" \\

--device "cuda" \

--num_inference_steps 5

Passen Sie Ordnerpfade, Stichwortwörter und andere Hyperparameter nach Bedarf an. Die Ausgabe wird gespeichert als Ausgabe.mp4.

Hauptfunktionen

- Steuerung von Scher- und SchleppbewegungenWählen Sie verschiedene Teile des Bildes in der GUI aus und ziehen Sie sie, um grobe Animationen zu erstellen.

- Verbreitung von VideosÜbertragen Sie grobe Animationsdateien auf einen Computer mit einem Grafikprozessor und führen Sie Inferenzskripte aus, um schöne Animationen zu erzeugen.

- Rauschverzerrung: Verwendung

make_warped_noise.pyDas Skript erzeugt Verzerrungsgeräusche für natürlichere Bewegungseffekte. - Bewegungsmodus VerschiebungAnwenden von Bewegungsmustern von einem Video auf ein anderes durch Anpassen von Hinweisen und Hyperparametern.

Detaillierte Vorgehensweise

- Ausschneiden und ZiehenLaden Sie ein Bild in die GUI und verwenden Sie die Maus, um verschiedene Teile des Bildes auszuwählen und zu ziehen, um grobe Animationen zu erstellen.

- Erzeugen von verzerrtem RauschenLäuft auf einem Computer mit einem Grafikprozessor

make_warped_noise.pySkript, das die Datei mit dem Verzerrungsrauschen erzeugt. - logische Schlussfolgerungen: Verwendung

cut_and_drag_inference.pySkripte, die grobe Animationen in schöne Animationen für die Ausgabe in MP4-Dateien umwandeln. - AnpassungsparameterCues, Hyperparameter und Dateipfade nach Bedarf anpassen, um beste Ergebnisse zu erzielen.

Mit den oben genannten Schritten können die Benutzer die Bewegungsmuster des Videos leicht erstellen und kontrollieren, um qualitativ hochwertige Videos und Animationen zu erstellen.