Mistral Small 3.1 vs. Gemma 3: Kann der 24-Milliarden-Parameter 27 Milliarden herausfordern?

Leichtgewichtige Großmodelle werden zum neuen Schlachtfeld der KI. Nach der Einführung von Google DeepMinds Gemma 3 Danach.Mistral AI Freigegeben im März 2024 Mistral Small 3.1Das Modell ist ein leistungsfähiges und leistungsfähiges Werkzeug für die Entwicklung eines neuen Modells für die Entwicklung eines neuen Modells. Mit seiner Effizienz, seinen multimodalen Fähigkeiten und seinem Open-Source-Charakter hat das 24-Milliarden-Parameter-Modell viel Aufmerksamkeit erregt und behauptet, in mehreren Benchmarks die Gemma 3 im Gesang antworten GPT-4o Mini.. Die Parameterskala ist ein Schlüsselmaß für die Leistung und Effizienz des Modells und steht in direktem Zusammenhang mit den Aussichten für seine Anwendung. In diesem Papier werden wir vergleichen Mistral Small 3.1 im Gesang antworten Gemma 3 und analysiert ihre Gemeinsamkeiten und Unterschiede unter verschiedenen Gesichtspunkten, darunter Leistung, Technologie, Anwendung und Ökologie.

I. Vergleich der Parametergrößen: 24 Mrd. $ vs. 27 Mrd. $, wer ist stärker?

Mistral Small 3.1 hat 24 Milliarden Parameter, während die Gemma 3 Es sind mehrere Versionen für 1 Milliarde, 4 Milliarden, 12 Milliarden und 27 Milliarden Parameter erhältlich, wobei die Version mit 27 Milliarden Parametern das Vorzeigemodell ist. Die Parametergröße bestimmt direkt die Kapazität und die Rechenanforderungen des Modells:

Mistral Klein 3.1 (24B)

- Kontextfenster: 128k Token

- Denkgeschwindigkeit: 150 Token/s

- Hardware-Anforderungen: einzeln

RTX 4090oder einen Mac mit 32 GB RAM. - Multimodale Unterstützung: Text + Bild

Gemma 3 (27B)

- Kontextfenster: 96k Token

- Denkgeschwindigkeit: ~120 Token/s (offiziell nicht spezifiziert, basierend auf Community-Tests)

- Hardware-Anforderungen: empfohlen: Dual

GPUoder High-End-Server (A100 40GB) - Multimodale Unterstützung: Text + einige visuelle Aufgaben

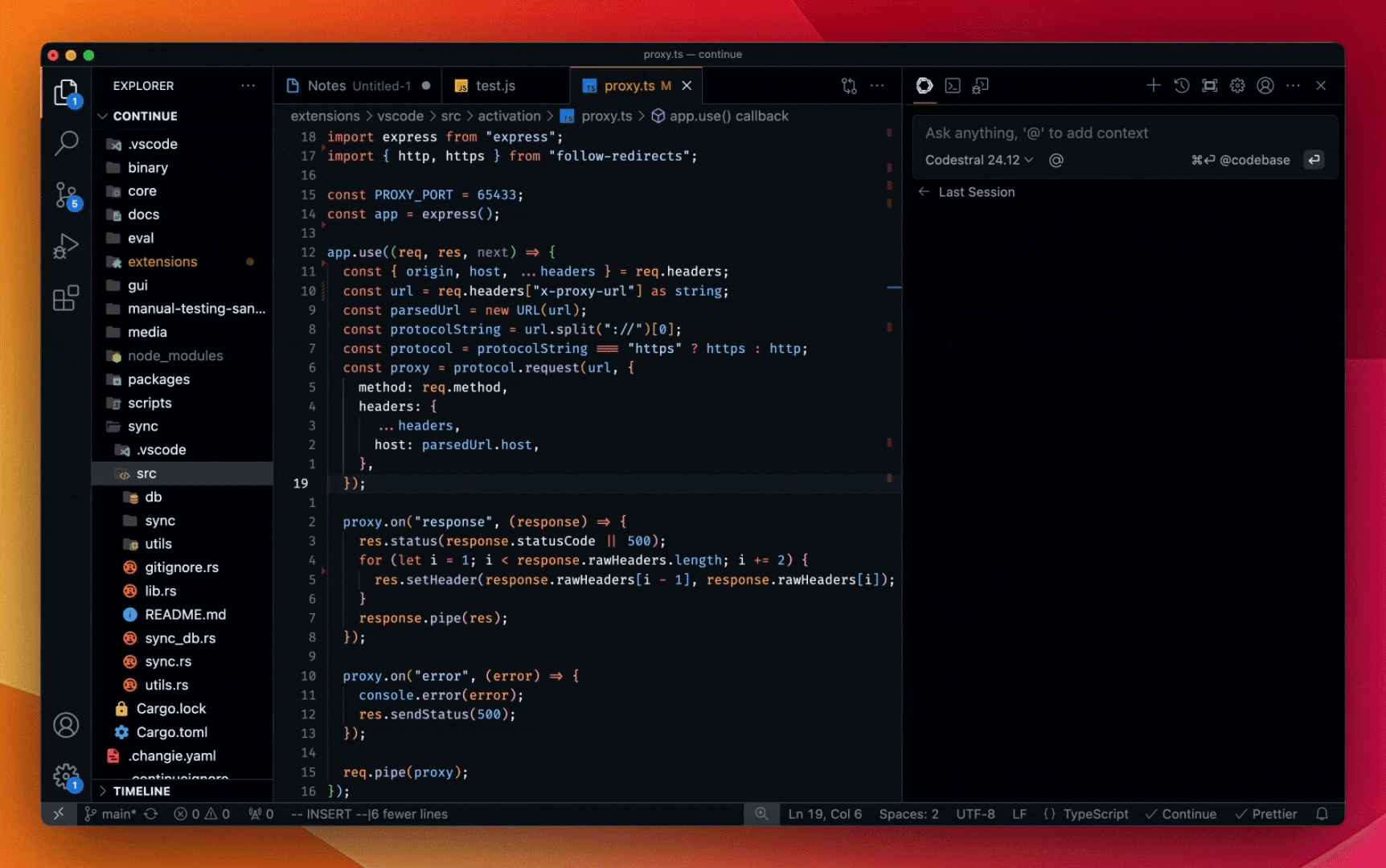

Die Zahl der Teilnehmer ist zwar um 3B geringer.Mistral Small 3.1 Es werden längere Kontextfenster und höhere Inferenzgeschwindigkeiten erreicht.Gemma 3 Obwohl die Anzahl der Parameter etwas besser ist, erfordert sie eine stärkere Hardwareunterstützung. In der nachstehenden Tabelle werden die Parameter und die Leistung der beiden Verfahren visuell verglichen:

| Modellierung | Parameterskala | Kontextfenster | Inferenzgeschwindigkeit | Hardware-Voraussetzung |

|---|---|---|---|---|

Mistral Small 3.1 | 24 Milliarden | 128k | 150 Token/s | RTX 4090/32GB RAM |

Gemma 3 | 27 Milliarden | 96k | ~120 Token/s | A100 40GB+ |

Es ist zu erkennen, dassMistral Small 3.1 Noch besser in Bezug auf die Parametereffizienz, mit weniger Parametern zu erreichen oder sogar zu übertreffen die Gemma 3 Die Leistung des

Zweitens, der Leistungsvergleich: Wer ist der König der Leichtgewichte?

Die Anzahl der Parameter ist nicht das einzige Kriterium, das bestimmt, ob ein Modell gut oder schlecht ist, die tatsächliche Leistung ist der Schlüssel. Nachstehend finden Sie einen Vergleich der beiden Modelle in einigen gängigen Benchmark-Tests:

- MMLU (Allgemeinwissen):

Mistral Small 3.1Ergebnis 81%.Gemma 3 27BCa. 79% - GPQA (Frage-Antwort-Fähigkeit):

Mistral 24BFührend, insbesondere in Szenarien mit niedriger Latenzzeit - MATH (Mathematisches Denken):

Gemma 3 27BGewinnt durch mehr Parameter zur Unterstützung komplexer Berechnungen - Multimodale Aufgaben (MM-MT-Bench):

Mistral 24BBessere Leistung und flüssigere Bild- und Textdarstellung

Die nachstehende Tabelle zeigt den Leistungsvergleich der beiden Modelle bei verschiedenen Testaufgaben (die Daten sind hypothetische Werte, die auf einer Trendspekulation beruhen):

| Testaufgaben | Mistral Klein 3.1 (24B) | Gemma 3 (27B) |

|---|---|---|

MMLU | 81% | 79% |

GPQA | 85% | 80% |

MATH | 70% | 78% |

MM-MT-Bench | 88% | 75% |

Aus den Testergebnissen geht hervor, dass dieMistral Small 3.1 Er ist für mehrere Aufgaben geeignet und ermöglicht ein ausgewogenes Multitasking. Während Gemma 3 In bestimmten Bereichen, wie z. B. dem mathematischen Denken, wird dann ein Vorteil durch mehr Parameter erzielt.

Drittens, die technischen Highlights: kleine Parameter, große Weisheit

Mistral Small 3.1 Die 24 Milliarden Parameter des Systems unterstützen multimodale Fähigkeiten (Text + Bild) und eine extrem lange Kontextverarbeitung dank des hybriden Aufmerksamkeitsmechanismus und der Optimierung der spärlichen Matrix. Im Gegensatz dazu ist dieGemma 3 Die 27-Milliarden-Parameter-Version stützt sich auf Googles Gemini Technologie-Stack mit mehr Stärken in der Mehrsprachigkeit (140+ Sprachen) und spezialisiertem Denken (z.B. Mathematik, Code), aber relativ schwachen multimodalen Fähigkeiten.

Ein weiterer bemerkenswerter Unterschied ist die Hardwarefreundlichkeit.Mistral Small 3.1 kann problemlos auf Geräten der Verbraucherklasse laufen, während die Gemma 3 Die 27-Milliarden-Parameter-Version von Gemma ist besser für den Einsatz auf Servern der Unternehmensklasse geeignet. Dieser Unterschied ist auf die unterschiedlichen Strategien der beiden Unternehmen bei der Zuweisung von Parametern zurückzuführen: Mistral neigt dazu, seine Modellstruktur zu straffen, während Gemma sich dafür entscheidet, mehr Parameter zu behalten, um seine Fähigkeit zur Bewältigung komplexer Aufgaben zu verbessern.

IV. Anwendungen und Ökologie: Wer hat mehr Bodenhaftung?

Mistral Small 3.1 angenommen Apache 2.0 Entwickler können das Modell lokal für Anwendungsszenarien wie Echtzeitgespräche und intelligenten Kundenservice anpassen. Während Gemma 3 Die 27-Milliarden-Parameter-Version unterliegt den Sicherheitsbedingungen von Google und eignet sich eher für den Einsatz in der Cloud für professionelle Anwendungen wie Bildung und Programmierung.

In Bezug auf die Anwendungen.Mistral Small 3.1 Bei Szenarien, die eine schnelle Reaktion und Personalisierung erfordern, wird mehr Wert auf Effizienz und Flexibilität gelegt. Während Gemma 3 Andererseits ist es stärker auf Tiefe und Spezialisierung ausgerichtet und eignet sich für die Bearbeitung komplexer beruflicher Aufgaben.

An der ökologischen Front.Mistral Durch seine Offenheit und Hardwarefreundlichkeit ist es einfacher, Indie-Entwickler und kleine Teams anzuziehen. Während Gemma Das starke Ökosystem von Google ermöglicht es dem Unternehmen, große Unternehmen und Forschungseinrichtungen besser zu bedienen.

V. Auswirkungen auf die Industrie und Ausblick

Mistral Small 3.1 erreicht oder übertrifft sogar die Leistung von Gemma 3 mit weniger Parametern und zeigt damit das ultimative Streben nach Parametereffizienz. Dies ist nicht nur ein Zeugnis für die Gemma 3 Die technischen Herausforderungen der KI sind auch ein Anstoß für ihre Universalisierung.

In Zukunft wird der Trend bei Leichtbaumodellen zu weniger Parametern und größerer Effizienz gehen; Mistral hat in diesem Bereich bereits die Führung übernommen, und Gemma 3 wird seine Strategie möglicherweise anpassen müssen, um dieser Herausforderung zu begegnen.

Leichtere, schnellere und stärkere KI-Modelle halten in immer schnellerem Tempo Einzug in unser Leben.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...