LiveTalking: quelloffenes, interaktives, digitales Echtzeit-Live-System, das einen synchronen Audio- und Videodialog ermöglicht

Allgemeine Einführung

LiveTalking ist ein quelloffenes, interaktives digitales Echtzeit-Menschensystem, das sich dem Aufbau einer hochwertigen digitalen menschlichen Live-Lösung widmet. Das Projekt verwendet das Apache 2.0 Open-Source-Protokoll und integriert eine Reihe von Spitzentechnologien, einschließlich ER-NeRF-Rendering, Echtzeit-Audio- und Video-Stream-Verarbeitung, Lippensynchronisation usw. Das System unterstützt die digitale Darstellung und Interaktion von Menschen in Echtzeit und kann für Live-Übertragungen, Online-Bildung, Kundendienst und viele andere Szenarien verwendet werden. Das Projekt hat mehr als 4300 Sterne und 600 Zweige auf GitHub, was einen starken Einfluss der Community zeigt.LiveTalking legt besonderen Wert auf Echtzeit-Performance und interaktive Erfahrung und bietet den Nutzern ein komplettes Framework für die Entwicklung digitaler Menschen durch die Integration von AIGC-Technologie. Das Projekt wird kontinuierlich aktualisiert und gewartet und wird durch eine umfassende Dokumentation unterstützt, was es zu einer idealen Wahl für die Erstellung von Anwendungen für digitale Menschen macht.

Funktionsliste

- Es werden mehrere digitale Menschmodelle unterstützt:ernerfundmusetalkundwav2lipundUltraleicht-digital-menschlich

- Gleichzeitiger Audio- und Videodialog

- Unterstützung für Sound Cloning

- Pro-Digital-Leute melden sich zu Wort und werden unterbrochen

- Unterstützt Ganzkörper-Videosplicing

- Unterstützt RTMP- und WebRTC-Push-Streams

- Unterstützung für die Videoplanung: Wiedergabe benutzerdefinierter Videos, wenn nicht gesprochen wird

- Unterstützt mehrfache Gleichzeitigkeit

Hilfe verwenden

1. das Installationsverfahren

- Anforderungen an die Umwelt Ubuntu 20.04, Python 3.10, Pytorch 1.12, CUDA 11.3

- Installation von Abhängigkeiten ::

conda create -n nerfstream python=3.10

conda activate nerfstream

conda install pytorch==1.12.1 torchvision==0.13.1 cudatoolkit=11.3 -c pytorch

pip install -r requirements.txt

Wenn Sie nicht trainieren. ernerf Modell müssen die folgenden Bibliotheken nicht installiert werden:

pip install "git+https://github.com/facebookresearch/pytorch3d.git"

pip install tensorflow-gpu==2.8.0

pip install --upgrade "protobuf<=3.20.1"

2. schneller Start

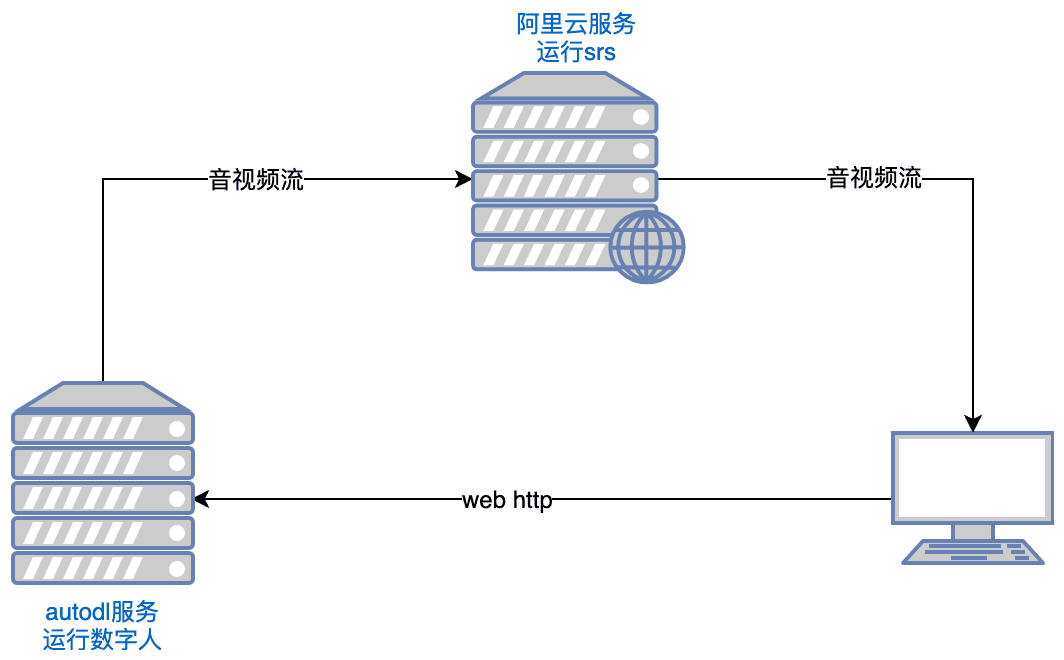

- Laufende SRS ::

export CANDIDATE='<服务器外网ip>'

docker run --rm --env CANDIDATE=$CANDIDATE -p 1935:1935 -p 8080:8080 -p 1985:1985 -p 8000:8000/udp registry.cn-hangzhou.aliyuncs.com/ossrs/srs:5 objs/srs -c conf/rtc.conf

Anmerkungen: Der Server muss die Ports tcp:8000,8010,1985; udp:8000 öffnen.

- Einführung von Digital People ::

python app.py

Wenn Sie keinen Zugriff auf Huggingface haben, führen Sie es vor der Ausführung aus:

export HF_ENDPOINT=https://hf-mirror.com

Mit Ihrem Browser öffnen http://serverip:8010/rtcpushapi.htmlWenn Sie einen Text in das Textfeld eingeben, senden Sie ihn ab, und die digitale Person wird den Text senden.

Weitere Gebrauchsanweisungen

- Docker läuft Die vorherige Installation ist nicht erforderlich, führen Sie es einfach aus:

docker run --gpus all -it --network=host --rm registry.cn-beijing.aliyuncs.com/codewithgpu2/lipku-metahuman-stream:vjo1Y6NJ3N

Der Code befindet sich in der /root/metahuman-streamvor git pull Ziehen Sie den neuesten Code und führen Sie den Befehl wie in Schritt 2 und 3 aus.

- Spiegelung ::

- autodl image:Autodl-Anleitung

- ucloud-Spiegel:ucloud-Anleitung

- allgemeine Probleme Sie können diesen Artikel für die Einrichtung der Linux CUDA Umgebung lesen:Referenzartikel

3. die Anweisungen zur Konfiguration

- System-Konfiguration

- Bearbeiten Sie die Datei config.yaml, um grundlegende Parameter festzulegen

- Konfigurieren von Kameras und Audiogeräten

- Einstellung der AI-Modellparameter und -pfade

- Konfigurieren Sie die Parameter für das Live-Push-Streaming

- Vorbereitung eines digitalen menschlichen Modells

- Unterstützung für den Import von benutzerdefinierten 3D-Modellen

- Vorgefertigte Beispielmodelle können verwendet werden

- Unterstützt MetaHuman-Modell-Import

Hauptfunktionen

- Audio- und videosynchroner Dialog in Echtzeit::

- Digitizer-Modell auswählen: Wählen Sie auf der Konfigurationsseite das entsprechende Digitizer-Modell (z.B. ernerf, musetalk, etc.).

- Auswahl der Audio-/Videoübertragungsmethode: Wählen Sie die geeignete Audio-/Videoübertragungsmethode (z.B. WebRTC, RTMP, etc.) entsprechend den Anforderungen.

- Dialog starten: Starten Sie die Audio-/Videoübertragung, um einen synchronen Audio-/Videodialog in Echtzeit zu erreichen.

- Digitales Modell des Menschen schalten::

- Aufrufen der Setup-Seite: Klicken Sie auf der Seite Projektlauf auf die Schaltfläche Setup, um die Setup-Seite aufzurufen.

- Neues Modell auswählen: Wählen Sie auf der Seite Einstellungen ein neues Digimon-Modell aus und speichern Sie die Einstellungen.

- Projekt neu starten: startet das Projekt neu, um die neue Modellkonfiguration anzuwenden.

- Einstellung der Audio- und Videoparameter::

- Aufrufen der Parametereinstellungsseite: Klicken Sie auf der Seite für die Projektausführung auf die Schaltfläche für die Parametereinstellung, um die Parametereinstellungsseite aufzurufen.

- Anpassungsparameter: Passen Sie die Audio- und Videoparameter (wie Auflösung, Bildrate usw.) nach Bedarf an.

- Speichern und anwenden: Speichert die Einstellungen und wendet die neue Parameterkonfiguration an.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...