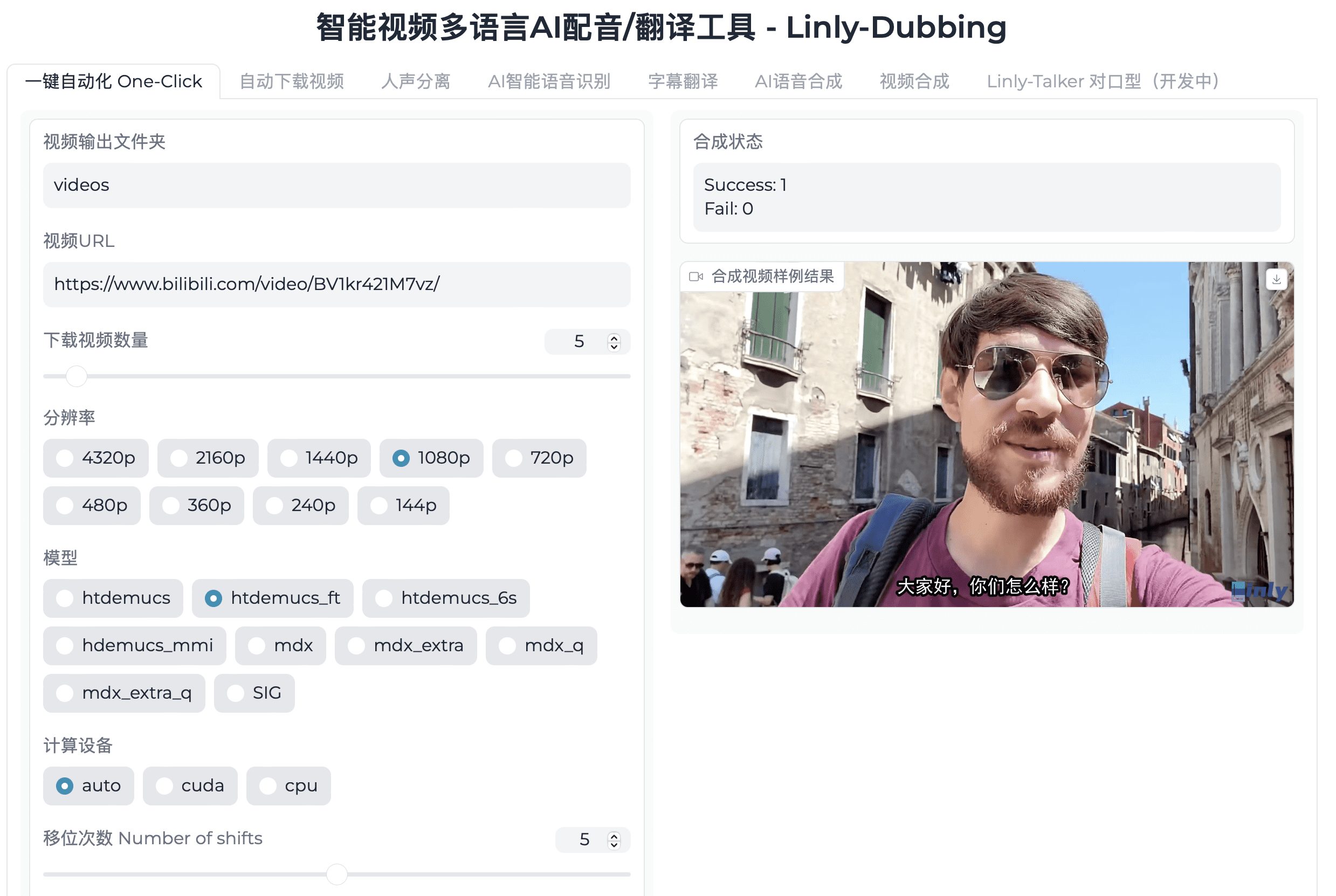

Allgemeine Einführung

Linly-Dubbing ist ein intelligentes, mehrsprachiges KI-Synchronisations- und Übersetzungstool, das Benutzern durch die Integration fortschrittlicher KI-Technologie hochwertige mehrsprachige Videosynchronisations- und Untertitelübersetzungsdienste bietet. Das Tool eignet sich besonders für Szenarien wie das internationale Bildungswesen und die Lokalisierung globaler Inhalte und hilft Teams bei der Verbreitung hochwertiger Inhalte in der ganzen Welt.

Funktionsliste

- Mehrsprachige UnterstützungSynchronisation und Untertitelung in Chinesisch und vielen anderen Sprachen, um den Anforderungen der Globalisierung gerecht zu werden.

- AI-SpracherkennungSprache-zu-Text-Umwandlung und Sprechererkennung mit fortschrittlicher KI-Technologie.

- Large Language Modelling ÜbersetzungKombiniert mit modernster Sprachmodellierung (z. B. GPT) werden die Übersetzungen schnell und präzise ausgeführt, wobei Professionalität und Natürlichkeit gewährleistet sind.

- KI Stimme klonenMit Hilfe modernster Technologie zum Klonen von Stimmen wird eine Stimme erzeugt, die der Original-Videosynchronisation sehr ähnlich ist, wobei die emotionale und intonatorische Kohärenz erhalten bleibt.

- Digitale Mensch-zu-Mensch-LippensynchronisationstechnikDurch die lippensynchrone Technologie ist die Stimme sehr gut mit dem Videobildschirm kompatibel, was den Eindruck von Realismus und Interaktivität verstärkt.

- Flexibles Hochladen und ÜbersetzenBenutzer können Videos hochladen und ihre eigene Übersetzungssprache und ihren eigenen Standard wählen, was Personalisierung und Flexibilität gewährleistet.

- regelmäßige Aktualisierung: Wir führen ständig die neuesten Modelle ein, um in Sachen Synchronisation und Übersetzung an der Spitze zu bleiben.

Hilfe verwenden

Ablauf der Installation

- Klon-Lager: Klonen Sie zunächst das Linly-Dubbing-Repository auf Ihren lokalen Rechner und initialisieren Sie die Submodule.

git clone https://github.com/Kedreamix/Linly-Dubbing.git --tiefe 1 cd Linly-Synchronisation git submodule update --init --rekursiv - Installation von Abhängigkeiten: Erstellen Sie eine neue Python-Umgebung und installieren Sie die erforderlichen Abhängigkeiten.

conda create -n linly_dubbing python=3.10 -y conda aktivieren linly_dubbing cd Linly-Dubbing/ conda install ffmpeg==7.0.2 -c conda-forge python -m pip install --upgrade pip pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple pip install torch==2.3.1 torchvision==0.18.1 torchaudio==2.3.1 --index-url https://download.pytorch.org/whl/cu118 pip install -r anforderungen.txt pip install -r anforderungen_module.txt - Umgebungsvariablen konfigurieren: Erstellen Sie die Datei .env im Hauptverzeichnis des Projekts und tragen Sie die erforderlichen Umgebungsvariablen ein.

OPENAI_API_KEY=sk-xxx MODEL_NAME=gpt-4 HF_TOKEN=Ihr_Umarmung_Gesicht_Token - Ausführen der AnwendungLaden Sie das gewünschte Modell herunter und starten Sie die WebUI-Oberfläche.

bash scripts/download_models.sh python webui.py

Verwendung Prozess

- Video hochladenBenutzer können über die WebUI-Schnittstelle Videodateien hochladen, die synchronisiert oder übersetzt werden sollen.

- Auswahl der Sprache und KriterienNach dem Hochladen des Videos kann der Benutzer die zu übersetzende Sprache und den Synchronisationsstandard auswählen.

- Synchronisation und Untertitelung erstellenDas System führt automatisch die Spracherkennung, Übersetzung und Synchronisation durch und synchronisiert die Erstellung von Untertiteldateien.

- Ergebnisse herunterladenBenutzer können die erzeugten synchronisierten Video- und Untertiteldateien zur weiteren Bearbeitung und Verwendung herunterladen.

Hauptfunktionen

- Automatisches Herunterladen von VideosMit dem yt-dlp-Tool können Sie Video- und Audiodateien in einer Vielzahl von Formaten und Auflösungen herunterladen.

- StimmbruchVocal und Backing Track Separation mit Demucs und UVR5 Technologie, um Backing Tracks und Vocal Extracts in hoher Qualität zu produzieren.

- AI-SpracherkennungPräzise Spracherkennung und Untertitelerstellung mit WhisperX und FunASR, mit Unterstützung für die Erkennung von mehreren Sprechern.

- Large Language Modelling ÜbersetzungHochwertige mehrsprachige Übersetzungen, die die OpenAI API und das Qwen-Modell kombinieren.

- AI-SprachsyntheseEdge TTS verwenden und CosyVoice Erzeugen Sie eine natürliche und flüssige Sprachausgabe mit Unterstützung für mehrere Sprachen und Sprachstile.

- VideoverarbeitungPersonalisieren Sie Ihre Videoinhalte durch Hinzufügen von Untertiteln, Einfügen von Hintergrundmusik, Anpassen der Lautstärke und Ändern der Abspielgeschwindigkeit.

- Digitale Mensch-zu-Mensch-LippensynchronisationstechnikDigitale Mensch-zu-Digital-Lippensynchronisation durch die Linly-Talker-Technologie zur Verbesserung der Professionalität des Videos und des Seherlebnisses.