Das Open-Source-Modell für traditionelles Chinesisch und das Sprachsynthesemodell für den taiwanesischen Akzent von MediaTek

MediaTek Research hat vor kurzem bekannt gegeben, dass es zwei multimodale Modelle, die für traditionelles Chinesisch optimiert sind, offiziell als Open Source zur Verfügung stellt: Llama-Breeze2-3B und Llama-Breeze2-8B, die für verschiedene Computerplattformen wie Mobiltelefone und PCs entwickelt wurden und über die Fähigkeit verfügen, Funktionen aufzurufen, was den flexiblen Einsatz externer Tools zur Erweiterung von Anwendungsszenarien ermöglicht. um Anwendungsszenarien zu erweitern. Darüber hinaus hat MediaTek eine Android-Anwendung auf der Basis von Llama-Breeze2-3B und BreezyVoice, einem Sprachsynthesemodell, das einen natürlichen taiwanesischen Akzent erzeugen kann, als Open Source zur Verfügung gestellt und damit seine umfassende Auslegung der Terminal-KI-Technologie demonstriert.

Die Llama-Breeze2-Serie von multimodalen Modellen für Mobiltelefone und PCs.

MediaTek Innovation Base diese offene Quelle Llama-Breeze2 Serie Traditionelles Chinesisch Multimodale BasismodelleDas Llama-Breeze2-3B ist eine leichtgewichtige Version des Llama-Breeze2, die auf mobilen Geräten laufen kann, und eine leichtgewichtige Version des Llama-Breeze2-8B, die auf PCs mehr Leistung bietet. Laut MediaTek beherrscht diese Modellreihe nicht nur traditionelles Chinesisch, sondern verfügt auch über fortschrittliche Funktionen wie Multimodalität und Funktionsaufrufe, die es ermöglichen, Bildinformationen zu verstehen und externe Tools aufzurufen, um komplexe Aufgaben zu erfüllen.

Um die Entwicklung mobiler KI-Anwendungen weiter voranzutreiben, hat MediaTek das Llama-Breeze2-3B-Modell als Kernstück gewählt.Entwicklung und Open Source einer Android-AnwendungKI-Assistent. Die App wurde entwickelt, um die Fähigkeiten des KI-Assistenten des Telefons zu verbessern, z. B. die Erkennung von Bildinhalten, Anrufe mit externen Tools und mehr. Inzwischen synchronisiert MediaTek auch die Rückzug BreezyVoice, ein Sprachsynthesemodell, das in der Lage ist, authentische taiwanesische Akzente zu synthetisieren. Der Open-Source-Inhalt der drei oben genannten Modelle und Anwendungen umfasst Modellgewichte und einen Teil des Ausführungscodes, den Entwickler studieren und anwenden können.

Technische Analyse des Modells Llama-Breeze2: Optimierung auf der Grundlage von Llama 3, Kombination von Komplexität, Vision und Werkzeugaufrufmöglichkeiten

Eine eingehende Analyse des Llama-Breeze2-Modells, dessen Kerntechnologie auf der Grundlage des Open-Source-Sprachmodells Llama 3 von Meta optimiert wurde. MediaTek nutzt den Korpus des traditionellen Chinesisch, um das Verständnis des Modells für das traditionelle Chinesisch zu verbessern, und integriert das visuelle Sprachmodell sowie Funktionsaufrufe (Funktion Aufrufen), wodurch die Modelle der Llama-Breeze2-Serie drei Hauptfunktionen erhalten: Optimierung des traditionellen Chinesisch, Bildverständnis und die Möglichkeit, externe Tools aufzurufen.

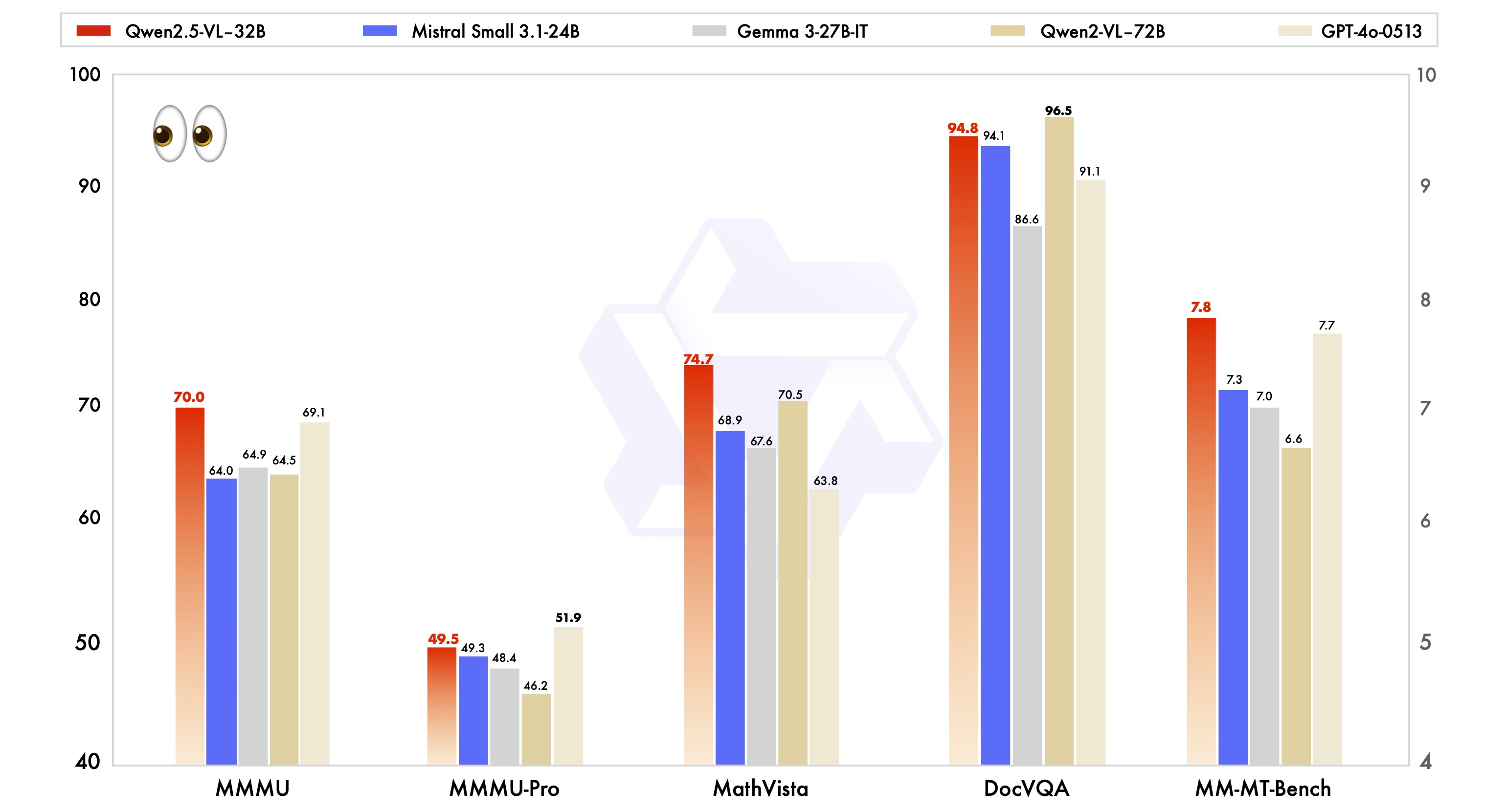

existierenTraditionelle chinesische FähigkeitWas die von MediaTek vorgelegten Vergleichsergebnisse betrifft, so war Llama-Breeze2-3B im Vergleich zum Llama 3 3B Instruct-Modell mit der gleichen Parameterskala in der Lage, bekannte Nachtmärkte wie den Shihlin-Nachtmarkt, den Raohe-Nachtmarkt und den Luodong-Nachtmarkt in dem generierten Kurztext der taiwanesischen Nachtmärkte korrekt aufzulisten, während das Llama 3 3B Instruct-Modell nur den Shihlin-Nachtmarkt korrekt erkannte. generiert aber zwei fiktive Nachtmärkte - Telecom Night Market und World Trade Night Market. Dieses Ergebnis unterstreicht den Vorteil der Llama-Breeze2-Modellfamilie beim Verständnis des traditionellen Chinesisch.

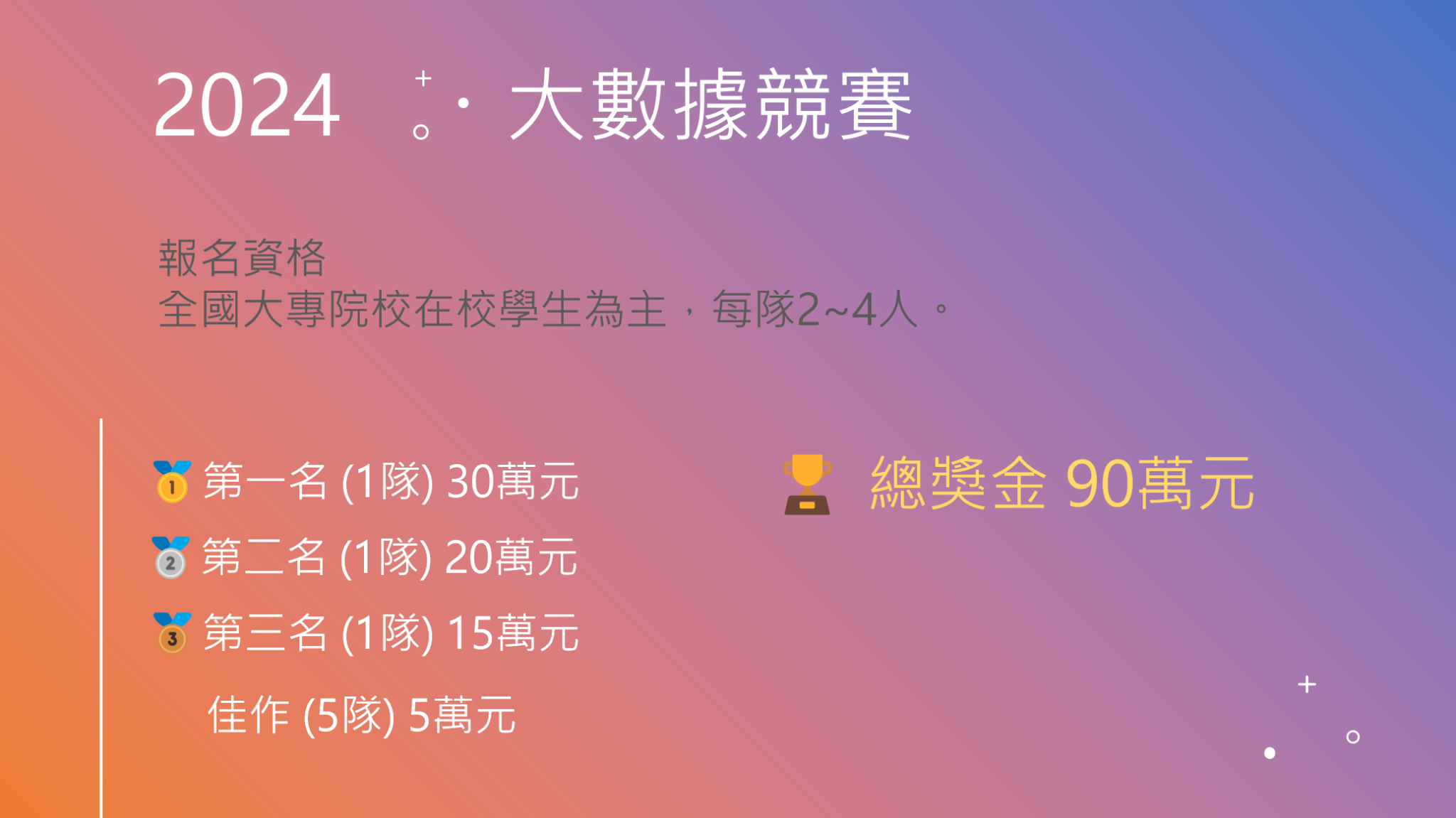

existierenmultimodale FähigkeitLlama-Breeze2-3B verarbeitet nicht nur Textinformationen, sondern analysiert auch effektiv den Inhalt von Bildern, wie z.B. Diagramme, OCR-Ergebnisse (Optical Character Recognition) oder Fotos von Sehenswürdigkeiten. Die Modelle sind in der Lage, die Bedeutung des Bildes zu verstehen und відповідь. Zum Beispiel im folgenden Szenario:

Benutzerfrage: Wie hoch ist die Gesamtsumme der Preisgelder für die drei Erstplatzierten?

Llama-Breeze2-8B antwortete: Nach den Angaben auf dem Bild beträgt der erste Platz 300.000 RMB, der zweite Platz 200.000 RMB und der dritte Platz 150.000 RMB. Wenn man diese Zahlen zusammenzählt, belaufen sich die drei Hauptpreise auf insgesamt 650.000 RMB.

Darüber hinaus sind die Modelle der Llama-Breeze2-Serie mit Funktionsaufrufen ausgestattet, die es ihnen ermöglichen, externe Tools zur Erfüllung komplexerer Aufgaben aufzurufen. Wenn sich ein Nutzer beispielsweise nach dem Wetter erkundigt, kann das Modell die API-Schnittstelle einer Wetteranwendung aufrufen, um sofort die neuesten Wetterinformationen zu erhalten und dem Nutzer die Ergebnisse mitzuteilen, was ein intelligenteres und interaktiveres Erlebnis bietet.

Android-App-Beispiel: Llama-Breeze2-3B Driving Mobile AI Apps

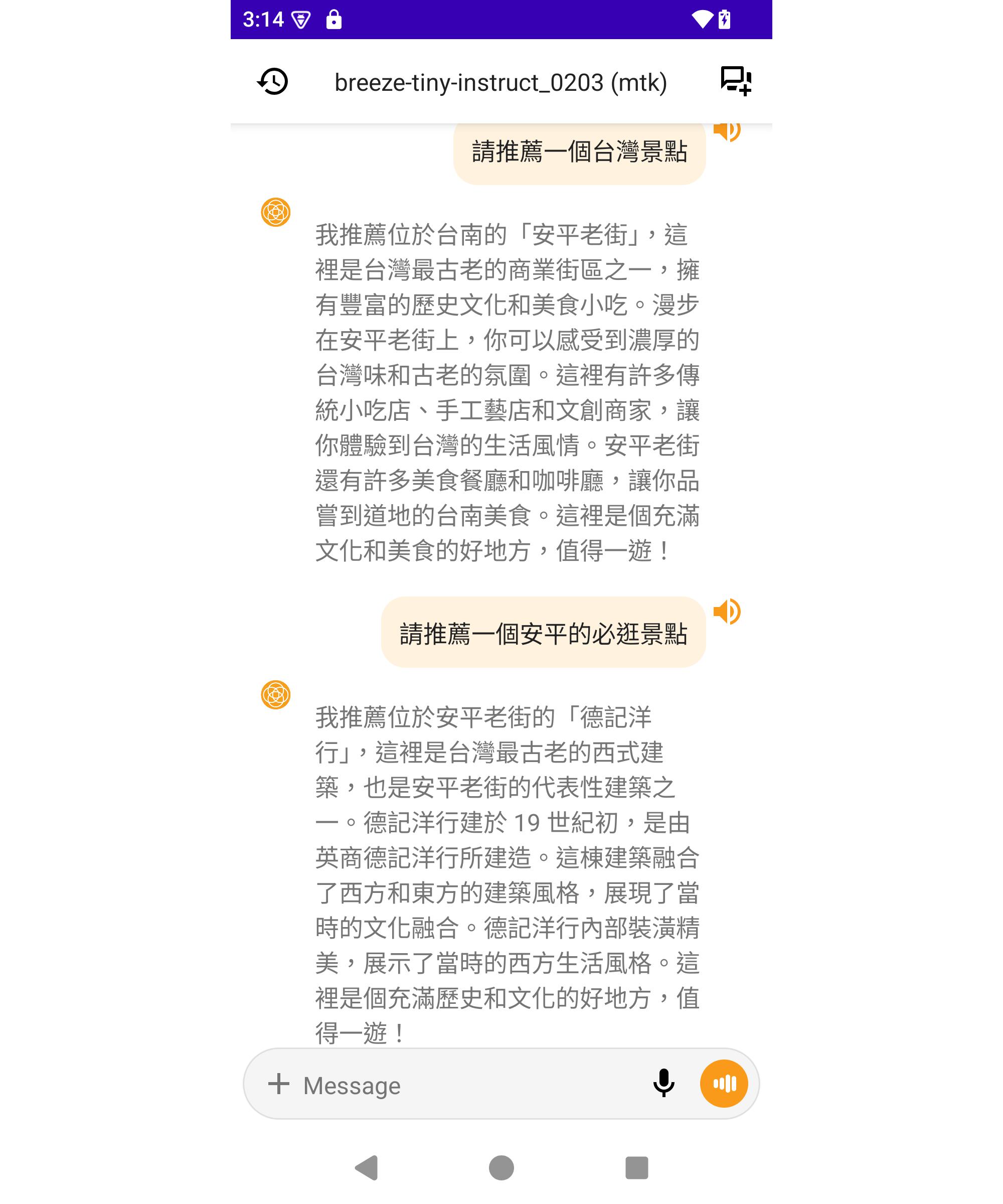

Neben der Freigabe von zwei multimodalen Sprachmodellen hat MediaTek Innovation Base auch eine Android-App freigegeben, die direkt auf Mobiltelefonen eingesetzt werden kann. Basierend auf dem Llama-Breeze2-3B-Modell kann diese App als persönlicher KI-Assistent verwendet werden, der den Nutzer mit Echtzeit-Übersetzungen, Empfehlungen zu Sehenswürdigkeiten und vielen anderen Aufgaben unterstützt - wie in der Abbildung unten dargestellt. Darüber hinaus ist die App mit einer Spracherzeugungsfunktion ausgestattet, die es den Nutzern ermöglicht, Text einzugeben, woraufhin das Modell eine natürliche und flüssige Sprachantwort generiert, die in verschiedenen Szenarien, wie z. B. der intelligenten Navigation, eingesetzt werden kann.

BreezyVoice Sprachsynthesemodell: Fünf Sekunden Audio-Samples, um authentische taiwanesische Akzente zu erzeugen

Im Rahmen des Open-Source-Programms hat die MediaTek Innovation Base auch BreezyVoice vorgestellt, ein Sprachsynthesemodell, das speziell für die traditionelle chinesische Sprache trainiert und mit einer leichtgewichtigen Architektur entwickelt wurde, um schnell hochrealistische Sprache mit nur 5 Sekunden Audioeingabe zu erzeugen. BreezyVoice kann als Sprachausgabelösung für KI-Assistenten verwendet werden, um ein natürlicheres und interaktiveres Erlebnis zu bieten. BreezyVoice kann als Sprachausgabelösung für KI-Assistenten verwendet werden, um ein natürlicheres und interaktiveres Erlebnis zu ermöglichen. Laut MediaTek läuft BreezyVoice jetzt reibungslos auf Laptops und kann mit jedem Large Language Modelling (LLM) oder Speech-to-Text-System kombiniert werden, um noch mehr Anwendungsmöglichkeiten zu schaffen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...