LHM: Generierung bewegungsfähiger 3D-Menschenmodelle aus einem einzigen Bild

Allgemeine Einführung

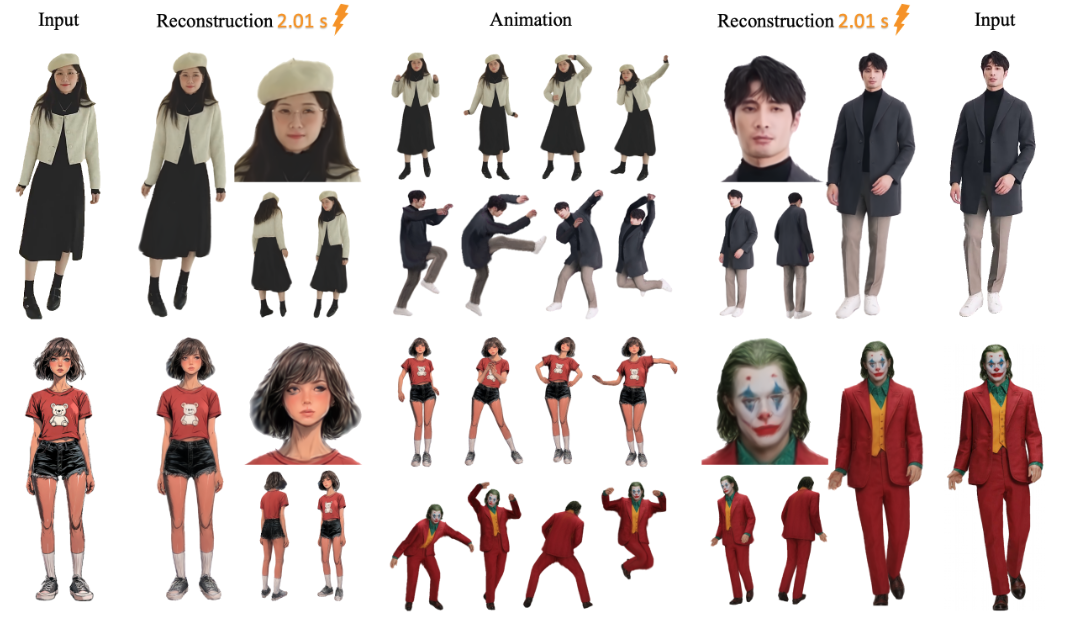

LHM (Large Animatable Human Reconstruction Model) ist ein Open-Source-Projekt, das vom aigc3d-Team entwickelt wird und schnell handlungsunterstützende 3D-Menschenmodelle aus einem einzigen Bild erzeugen kann. Das Hauptmerkmal ist die Verwendung von KI-Technologie, um ein 2D-Bild in Sekundenschnelle in ein 3D-Modell zu verwandeln, mit Unterstützung für Echtzeit-Vorschau und Posenanpassung. LHM verwendet 3D-Gaussian-Splatting-Technologie, um den menschlichen Körper darzustellen, kombiniert mit einer multimodalen Transformator-Architektur, die die Textur der Kleidung und geometrische Details bewahrt. Das Projekt, das erstmals am 13. März 2025 veröffentlicht wurde, bietet vortrainierte Modelle und Code, die sich für die Forschung oder die Entwicklung von digitalen 3D-Anwendungen für den Menschen eignen.

Funktionsliste

- Generieren Sie in Sekundenschnelle eine 3D-Schaufensterpuppe aus einem einzigen Bild.

- Das Rendering wird in Echtzeit unterstützt und das generierte Modell kann direkt betrachtet werden.

- Bietet eine Aktionsfunktion zur Anpassung der menschlichen Körperhaltung, um dynamische Videos zu erzeugen.

- Ausgabe von 3D-Netzdateien (z. B. im OBJ-Format) zur späteren Bearbeitung.

- Vorgefertigte Modelle (z.B. LHM-0.5B und LHM-1B) sind enthalten und müssen nicht selbst trainiert werden.

- Integrierte Gradio-Schnittstelle mit lokaler Visualisierungsunterstützung.

- Bietet eine Videoverarbeitungspipeline, die Aktionen aus Videos extrahieren und auf Modelle anwenden kann.

Hilfe verwenden

Die Nutzung des LHM gliedert sich in zwei Teile: Installation und Betrieb. Nachfolgend finden Sie detaillierte Schritte, die Ihnen helfen, schnell loszulegen.

Einbauverfahren

- Vorbereiten der Umgebung

Das System erfordert Python 3.10 und CUDA (Version 11.8 oder 12.1 unterstützt). Eine NVIDIA-Grafikkarte, z. B. eine A100 oder 4090, mit mindestens 16 GB Videospeicher wird empfohlen.- Überprüfen Sie die Python-Version:

python --version - Überprüfen Sie die CUDA Version:

nvcc --version

- Überprüfen Sie die Python-Version:

- Klon-Lager

Geben Sie den folgenden Befehl in das Terminal ein, um den LHM-Code herunterzuladen:git clone https://github.com/aigc3d/LHM.git cd LHM

- Installation von Abhängigkeiten

Führen Sie das entsprechende Skript entsprechend Ihrer CUDA Version aus:- CUDA 11.8:

sh ./install_cu118.sh - CUDA 12.1:

sh ./install_cu121.sh

Wenn das Skript fehlschlägt, installieren Sie die Abhängigkeiten manuell:

pip install -r requirements.txt - CUDA 11.8:

- Modelle herunterladen

Das Modell wird automatisch heruntergeladen. Wenn Sie es manuell herunterladen möchten, verwenden Sie den folgenden Befehl:- Modell LHM-0.5B:

wget https://virutalbuy-public.oss-cn-hangzhou.aliyuncs.com/share/aigc3d/data/for_lingteng/LHM/LHM-0.5B.tar tar -xvf LHM-0.5B.tar - Modell LHM-1B:

wget https://virutalbuy-public.oss-cn-hangzhou.aliyuncs.com/share/aigc3d/data/for_lingteng/LHM/LHM-1B.tar tar -xvf LHM-1B.tar

Laden Sie es herunter und entpacken Sie es in das Stammverzeichnis des Projekts.

- Modell LHM-0.5B:

- Überprüfen der Installation

Führen Sie die Testbefehle aus, um sicherzustellen, dass die Umgebung in Ordnung ist:python app.pyBei Erfolg wird die Gradio-Schnittstelle gestartet.

Arbeitsablauf

3D-Modelle generieren

- Bereiten Sie das Bild vor

Bereiten Sie ein klares Bild vor, das den gesamten menschlichen Körper enthält, und speichern Sie es lokal, z. B.<path_to_image>/person.jpg. - Ausführen von Inferenzskripten

Geben Sie ihn in das Terminal ein:bash ./inference.sh ./configs/inference/human-lrm-1B.yaml LHM-1B <path_to_image>/ ./output/<path_to_image>ist der Pfad zu Ihrem Bild../output/ist der Ausgabeordner, in dem die erzeugten Ergebnisse gespeichert werden.

- Ergebnisse anzeigen

Nach der Generierung der<output>Der Ordner enthält die 3D-Modelldatei und das gerenderte Video. Sie können die Mesh-Dateien mit 3D-Software (z. B. Blender) öffnen oder die Videos direkt abspielen.

Aktion hinzufügen

- Vorbereitende Bewegungssequenz

Das Projekt bietet Beispiel-Aktionsdateien, die sich im Verzeichnis<LHM根目录>/train_data/motion_video/mimo1/smplx_params. Sie können auch Ihre eigene SMPL-X-Parameterdatei verwenden. - Ausführen von Aktionsskripten

Geben Sie den folgenden Befehl ein:bash ./inference.sh ./configs/inference/human-lrm-1B.yaml LHM-1B <path_to_image>/ <path_to_motion>/smplx_params<path_to_motion>ist der Pfad der Aktionsdatei.

- Vorschau Action-Video

Der Ausgabeordner erzeugt ein Action-Video, das direkt abgespielt werden kann.

Verwendung der Gradio-Schnittstelle

- Schnittstelle starten

Läuft im Terminal:python app.pyDer Browser wird geöffnet

http://0.0.0.0:7860. - Ein Bild hochladen

Laden Sie ein Bild Ihres Körpers in die Schnittstelle hoch und klicken Sie auf "Senden". - Ergebnisse erzielen

Nach einigen Sekunden zeigt die Schnittstelle das gerenderte Bild und das Aktionsvideo an, das heruntergeladen und angesehen werden kann.

3D-Netze exportieren

- Exportieren Sie das Skript

Eingabe:bash ./inference_mesh.sh ./configs/inference/human-lrm-1B.yaml LHM-1B - Suchen Sie die Datei.

Der Ausgabeordner enthält Mesh-Dateien im OBJ-Format, die mit 3D-Software bearbeitet werden können.

caveat

- Die Bilder müssen klar sein, und einfache Hintergründe wirken besser.

- Die Wirkung der Aktion hängt von der Qualität der eingegebenen Aktion ab.

- Wenn Sie nicht über genügend Videospeicher verfügen, sollten Sie das Modell LHM-0.5B ausprobieren.

Anwendungsszenario

- Spieleentwicklung

Entwickler können mit LHM schnell 3D-Charaktermodelle aus Fotos generieren, die Posen anpassen und sie in die Spiel-Engine importieren, um Zeit bei der Modellierung zu sparen. - Film- und Fernsehproduktion

Film- und Fernsehteams können LHM nutzen, um digitale Stand-ins zu erstellen und Action-Videos für die Verwendung in Spezialeffektszenen zu generieren, wodurch die Kosten für die manuelle Modellierung reduziert werden. - virtueller Anker (TV)

Gastgeber können ihre eigenen Fotos hochladen, um ein 3D-Bild zu erzeugen, und dann Aktionen hinzufügen, um ein personalisiertes virtuelles Bild zu erstellen. - Bildungsforschung

Forscher konnten 3D-Rekonstruktionsalgorithmen mit LHM testen oder den Umwandlungsprozess von Bildern in Modelle im Klassenzimmer demonstrieren.

QA

- Welche Bildformate unterstützt die LHM?

Gängige Formate wie JPG und PNG werden unterstützt, JPG wird empfohlen, und die Dateigröße sollte 10 MB nicht überschreiten. - Wie lange dauert es, ein Modell zu erstellen?

Etwa 0,2 Sekunden auf A100-Karten, 1-2 Sekunden auf 4090-Karten, variiert leicht je nach Hardware. - Kann ich das Modell selbst trainieren?

Es ist möglich, aber es werden offiziell keine Trainingsskripte zur Verfügung gestellt. Erfordert die Vorbereitung des Datensatzes und die Abstimmung des Codes, geeignet für erfahrene Benutzer. - Kann das ausgegebene 3D-Modell bearbeitet werden?

Kann. Nach dem Exportieren der OBJ-Datei bearbeiten Sie die Geometrie und Texturen mit Blender oder Maya.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...