RAG (Retrieve Augmented Generation) ist eine Technik zur Optimierung der Ausgabe von Large Language Models (LLMs) auf der Grundlage von Informationen aus maßgeblichen Wissensdatenbanken. Diese Technik verbessert die Qualität der Ausgabe und gewährleistet ihre Relevanz, Genauigkeit und Nützlichkeit in einer Vielzahl von Kontexten, indem sie die Funktionalität von LLMs so erweitert, dass sie sich bei der Generierung von Antworten auf die interne Wissensbasis eines bestimmten Bereichs oder einer Organisation beziehen.

Optimierung großer Sprachmodelle (LLMs)

Große Sprachmodelle (Large Language Models, LLMs) werden in der Regel auf großen Datensätzen mit Milliarden von Parametern trainiert, um Rohdaten für Aufgaben wie die Beantwortung von Fragen, Sprachübersetzung und Satzvervollständigung zu erzeugen. Da die Trainingsdaten für LLMs jedoch statisch sind und einen Stichtag für die Wissensaktualisierung haben, ist es möglich, dass die Modelle falsche Informationen liefern, wenn Antworten fehlen, oder veraltete oder zweideutige Antworten ausgeben, wenn sie auf Anfragen antworten, die Zugang zu spezifischen aktuellen Informationen erfordern. Darüber hinaus ist es möglich, dass die Antworten der LLMs aus nicht-autoritären Quellen stammen oder aufgrund terminologischer Verwirrung falsche Antworten liefern, d.h. derselbe Begriff kann sich auf unterschiedliche Inhalte in verschiedenen Datenquellen beziehen.

Die Lösung der RAG

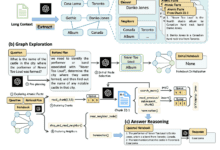

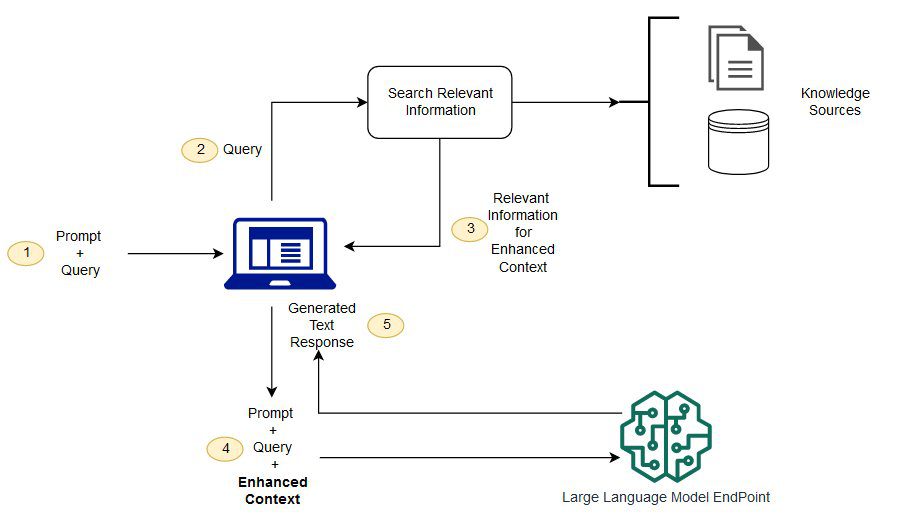

RAG löst das obige Problem, indem es LLMs anweist, relevante Informationen aus vordefinierten, maßgeblichen Wissensquellen abzurufen. Das Basismodell wird in der Regel offline trainiert und hat keinen Zugriff auf Daten, die nach dem Training generiert werden.LLMs werden in der Regel auf sehr allgemeinen Domänenkorpora trainiert und sind daher weniger effizient bei der Bearbeitung domänenspezifischer Aufgaben.Das RAG-Modell ist in der Lage, Informationen aus anderen Daten als denen des Basismodells abzurufen und die Hinweise zu erweitern, indem die relevanten abgerufenen Daten zum Kontext hinzugefügt werden.

Weitere Informationen über die Architektur des RAG-Modells finden Sie unterRetrieval-unterstützte Generierung von wissensintensiven NLP-Aufgaben..

Vorteile der Retrieval Augmented Generation (RAG)

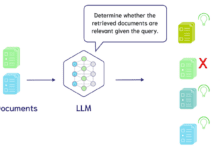

Durch die Verwendung von RAG können Daten aus einer Reihe von externen Datenquellen (z.B. Dokumentensammlungen, Datenbanken oder APIs) zur Ergänzung von Hinweisen herangezogen werden. Der Prozess beginnt mit der Umwandlung von Dokumenten und Benutzeranfragen in ein kompatibles Format für die Relevanzsuche. Formatkompatibilität bedeutet in diesem Zusammenhang, dass wir ein Einbettungs-Sprachmodell verwenden müssen, um die Dokumentensammlung (die als Wissensdatenbank betrachtet werden kann) und die vom Benutzer eingereichte Anfrage in eine numerische Darstellung für den Vergleich und die Suche umzuwandeln.Die Hauptaufgabe des RAG-Modells besteht darin, die Einbettung der Benutzeranfrage mit den Vektoren in der Wissensdatenbank zu vergleichen.

Die erweiterten Prompts werden dann an das Basismodell gesendet, wo die ursprünglichen Benutzer-Prompts mit relevantem Kontext aus ähnlichen Dokumenten in der Wissensdatenbank kombiniert werden. Sie können die Wissensbasis und die zugehörigen eingebetteten Darstellungen auch asynchron aktualisieren, um die Effizienz und Genauigkeit des RAG-Modells weiter zu verbessern.

Herausforderungen für die RAG

Obwohl RAG eine Möglichkeit bietet, große Sprachmodelle zu optimieren, um die Herausforderungen des Information Retrieval und der Beantwortung von Fragen in der Praxis zu bewältigen, gibt es immer noch eine Reihe von Problemen und Herausforderungen.

1. die Genauigkeit und Zuverlässigkeit der Datenquellen

Beim Modell zur Generierung von Retrieval-Erweiterungen ist die Genauigkeit und Aktualisierung der Datenquelle entscheidend. Wenn die Datenquelle falsche, veraltete oder nicht validierte Informationen enthält, kann dies zu falschen oder qualitativ schlechten Antworten führen, die von der RAG generiert werden. Daher ist die Sicherstellung der Qualität von Datenquellen eine Herausforderung, der man sich stellen und die man kontinuierlich lösen muss.

2. die Effizienz des Abrufs

Obwohl RAG bei großen Datenmengen effizient durchgeführt werden kann, kann es zu Effizienzproblemen kommen, wenn die Wissensbasis groß oder die Abfrage komplex wird. Da das Auffinden relevanter Informationen in einer großen Datenmenge eine zeit- und rechenintensive Aufgabe ist, stellt die Optimierung der Effizienz des Abrufalgorithmus auch für RAG eine Herausforderung dar.

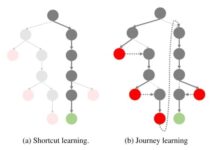

3. die Fähigkeit zur Verallgemeinerung

RAG-Modelle können besonders empfindlich auf bestimmte Daten und Abfragen reagieren, und bei einigen Problemen scheint es schwieriger zu sein, sinnvolle und wirksame Strategien anzuwenden, was oft Modelle mit guten Generalisierungsfähigkeiten erfordert. Die Probleme und Herausforderungen, die beim Training von Modellen für eine Vielzahl von Abfragen und Datenquellen angegangen werden müssen, sind recht komplex.

4) Heterogene Datenverarbeitung

In der Praxis liegen die Daten nicht immer in Form von Dokumenten vor, sondern können auch in anderen Formen wie Bildern, Audio und Video vorliegen. Es ist auch eine große Herausforderung, RAG mit diesen Formen von Daten für die Suche und den Querverweis zwischen einer breiteren Palette von Wissensquellen umgehen zu lassen.

Um die oben genannten Herausforderungen zu bewältigen, muss ein Gleichgewicht zwischen der Leistungsfähigkeit der RAG und ihren potenziellen Problemen gefunden werden, damit ihre Leistung in einer Vielzahl von realen Anwendungen gewährleistet werden kann.

Einzelheiten finden Sie in dem folgenden Beispiel-Notizbuch:

Wichtiger Hinweis: https://docs.aws.amazon.com/pdfs/sagemaker/latest/dg/sagemaker-dg.pdf#jumpstart-foundation-models-customize-rag

Retrieval-unterstützte Generierung: Fragen und Antworten auf der Grundlage individueller Datensätze

![Agenten-KI: Erkundung der Grenzwelt der multimodalen Interaktion [Fei-Fei Li - Classic Must Read] - Chief AI Sharing Circle](https://www.aisharenet.com/wp-content/uploads/2025/01/6dbf9ac2da09ee1-220x150.png)