Range Rover Starship: Bereitstellung einer integrierten Plattform für GPU-Arithmetik und KI-Training und Reasoning in der Cloud

Allgemeine Einführung

Lanrui Starship (Lanrui-ai) ist eine Plattform, die Cloud-basierte AIGC (Artificial Intelligence Generated Content) und KI-Training sowie Push-Integrationsberechnungen anbietet. Die Plattform wird unabhängig von Wingsquare entwickelt und zielt darauf ab, Nutzern kostengünstige KI-Rechenleistung zu bieten. Rangefinder Starship integriert eine Vielzahl von KI-Toolchains, unterstützt verteiltes Training auf mehreren Maschinen und mehreren Karten und bietet sofort einsatzbereite KI-Entwicklungsumgebungen und eine große Auswahl an GPU-Mietlösungen, um Unternehmen und Entwickler bei der schnellen Bereitstellung und Ausführung von KI-Anwendungen zu unterstützen.

Funktionsliste

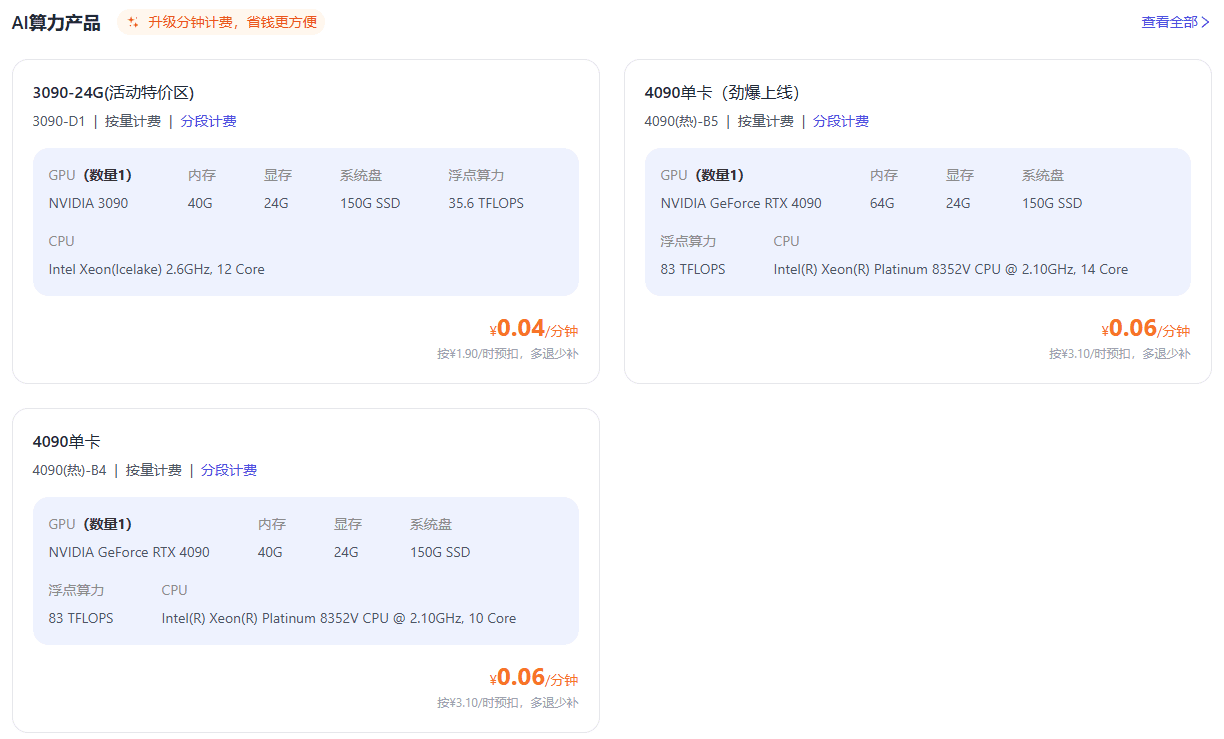

- Bietet eine breite Palette von GPU-Mietoptionen mit volumenbasierter Abrechnung

- Integriert mehrere AI-Toolchains zur Unterstützung von MLOps-Lösungen aus einer Hand

- Unterstützung von verteiltem Training an mehreren Maschinen und auf mehreren Karten

- Bietet hochverfügbare APIs und ein offenes Mirroring-Ökosystem

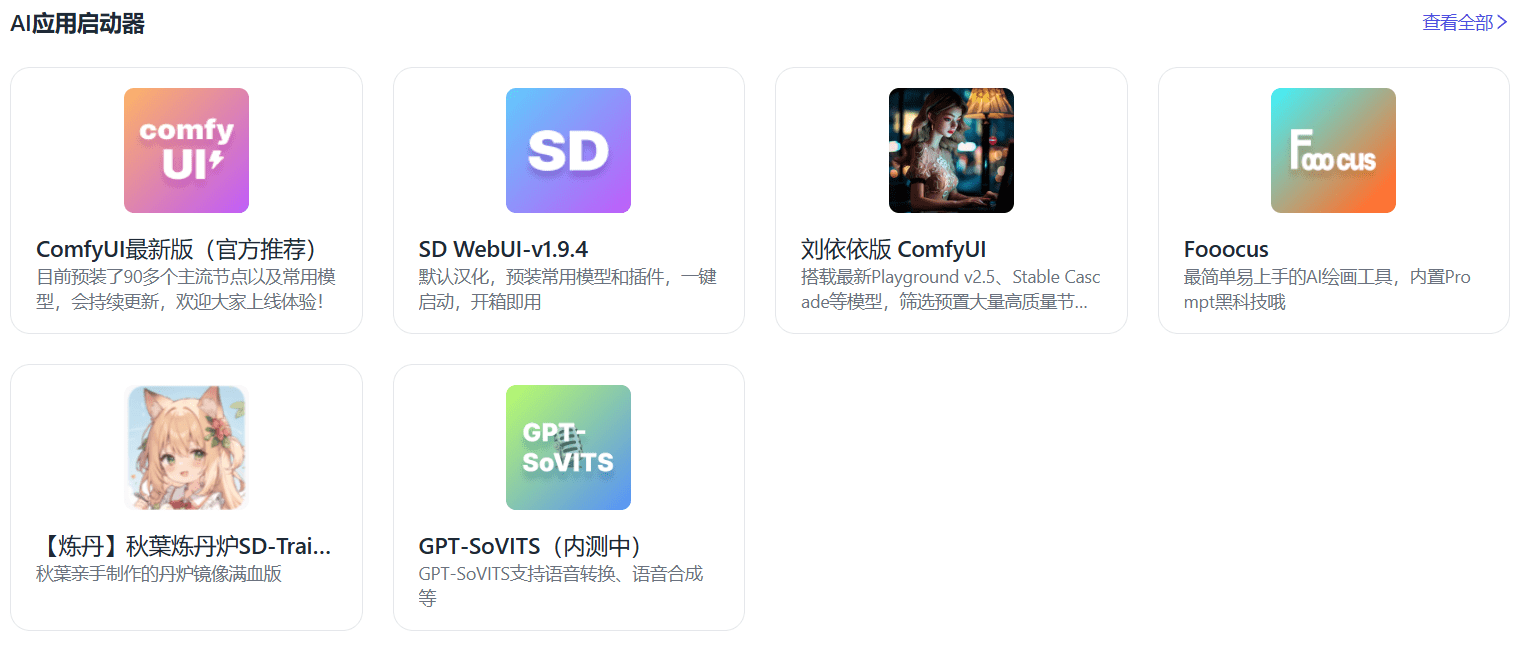

- Integrierte AI-Anwendungsstarter wie ComfyUI, SD WebUI, etc.

- Unterstützt Sprachumwandlung, Sprachsynthese und andere Funktionen

Hilfe verwenden

Installation und Registrierung

- URL öffnen: https://www.lanrui-ai.com/

- Klicken Sie auf die Schaltfläche "Registrieren" in der oberen rechten Ecke und geben Sie die erforderlichen Informationen ein, um die Registrierung abzuschließen.

- Sobald die Registrierung abgeschlossen ist, melden Sie sich bei Ihrem Konto an und gehen Sie zum Benutzer-Kontrollzentrum.

Funktion Betriebsanleitung

GPU-Verleih

- Wählen Sie in der Benutzerkonsole die Option "GPU-Verleih".

- Wählen Sie das richtige GPU-Modell und die richtige Konfiguration, z. B. NVIDIA 3090 oder 4090, je nach Ihren Anforderungen.

- Wählen Sie die Abrechnungsmethode (pro Volumen oder segmentierte Abrechnung), bestätigen Sie die Bestellung und bezahlen Sie.

- Nach Abschluss der Zahlung weist das System automatisch die GPU-Ressourcen zu, und die Nutzer können die gemieteten GPUs in der Systemsteuerung anzeigen und verwalten.

Nutzung der AI-Toolchain

- Wählen Sie in der Benutzerkonsole die Option AI Toolchain.

- Wählen Sie das richtige KI-Tool für Ihre Bedürfnisse, z. B. ComfyUI, SD WebUI, usw.

- Wenn Sie auf die Schaltfläche "Starten" klicken, wird das ausgewählte Tool automatisch konfiguriert und gestartet.

- Über das Bedienfeld können die Benutzer den Betriebsstatus des Tools einsehen und entsprechende Vorgänge durchführen.

verteilte Ausbildung

- Wählen Sie in der Benutzerkonsole die Option Verteiltes Training.

- Konfigurieren Sie die Parameter der Trainingsaufgabe, wie Datensatz, Modell, Trainingsknoten usw.

- Klicken Sie auf die Schaltfläche "Training starten". Das System weist automatisch Ressourcen zu und startet die Trainingsaufgabe.

- Die Benutzer können den Trainingsfortschritt und die Ergebnisse über das Bedienfeld einsehen.

allgemeine Probleme

Wie wählt man die richtige GPU aus?

Wählen Sie das richtige Grafikprozessormodell je nach den Rechenanforderungen der Aufgabe. Im Allgemeinen ist der NVIDIA 3090 für kleine bis mittlere Aufgaben und der NVIDIA 4090 für große Aufgaben geeignet.

Wie verwalte ich eine gemietete GPU?

Benutzer können gemietete GPUs in der Systemsteuerung anzeigen und verwalten, einschließlich Start-, Stopp- und Freigabevorgängen.

Wie erhalte ich technische Unterstützung?

Die Nutzer können über den Online-Kundendienst oder die von der Plattform bereitgestellte E-Mail für den technischen Support Hilfe erhalten.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...