Allgemeine Einführung

LlamaEdge ist ein Open-Source-Projekt, das den Prozess der Ausführung und Feinabstimmung von Large Language Models (LLMs) auf lokalen oder Edge-Geräten vereinfachen soll. Das Projekt unterstützt die Llama2-Modellfamilie und bietet OpenAI-kompatible API-Dienste, mit denen Benutzer LLM-Schlussfolgernde Anwendungen einfach erstellen und ausführen können.LlamaEdge nutzt die Rust- und Wasm-Technologie-Stacks, um leistungsstarke Alternativen für KI-Schlussfolgerungen zu bieten. Benutzer können Modelle mit einfachen Befehlszeilenoperationen schnell zum Laufen bringen und sie bei Bedarf feinabstimmen und erweitern.

Funktionsliste

- LLM lokal ausführenUnterstützung für den Betrieb von Modellen der Llama2-Serie auf lokalen oder Edge-Geräten.

- OpenAI-kompatible API-DiensteBietet OpenAI API-kompatible Service-Endpunkte, die Chat, Sprache-zu-Text, Text-zu-Sprache, Bilderzeugung und mehr unterstützen.

- Plattformübergreifende UnterstützungUnterstützt eine breite Palette von CPU- und GPU-Geräten und bietet plattformübergreifende Wasm-Anwendungen.

- SchnellstartModelle können schnell heruntergeladen und durch einfache Befehlszeilenoperationen ausgeführt werden.

- Feinabstimmung und ErweiterungBenutzer können den Quellcode nach Bedarf ändern und erweitern, um spezifische Anforderungen zu erfüllen.

- Dokumentation und TutorialsAusführliche offizielle Dokumentation und Tutorials helfen den Benutzern, schnell loszulegen.

Hilfe verwenden

Ablauf der Installation

- Einbau von WasmEdgeWasmEdge: Zunächst müssen Sie WasmEdge installieren, was Sie über die folgende Befehlszeile tun können:

curl -sSf https://raw.githubusercontent.com/WasmEdge/WasmEdge/master/utils/install_v2.sh | bash

- LLM-Modelldateien herunterladenNehmen Sie das Meta Llama 3.2 1B Modell als Beispiel und laden Sie es mit folgendem Befehl herunter:

curl -LO https://huggingface.co/second-state/Llama-3.2-1B-Instruct-GGUF/resolve/main/Llama-3.2-1B-Instruct-Q5_K_M.gguf

- LlamaEdge CLI Chat App herunterladenVerwenden Sie den folgenden Befehl, um die plattformübergreifende Wasm-Anwendung herunterzuladen:

curl -LO https://github.com/second-state/LlamaEdge/releases/latest/download/llama-chat.wasm

- Ausführen der Chat-Anwendung: Verwenden Sie den folgenden Befehl, um mit LLM zu chatten:

wasmedge --dir . :. --nn-preload default:GGML:AUTO:Llama-3.2-1B-Instruct-Q5_K_M.gguf llama-chat.wasm -p llama-3-chat

Funktion Betriebsablauf

- Starten des API-DienstesDer API-Dienst kann mit dem folgenden Befehl gestartet werden:

wasmedge --dir . :. --env API_KEY=Ihr_api_key llama-api-server.wasmedge ---model-name llama-3.2-1B --prompt-template llama-chat --reverse-prompt "[INST]" --ctx- Größe 32000

- Interaktion mit dem LLM über die WebschnittstelleNach dem Start des API-Dienstes können Sie über die Webschnittstelle mit dem lokalen LLM interagieren.

- Erstellen benutzerdefinierter API-DiensteBenutzerdefinierte API-Dienst-Endpunkte können je nach Bedarf erstellt werden, z. B. für Sprache-zu-Text, Text-zu-Sprache, Bilderzeugung und so weiter.

- Feinabstimmung und ErweiterungBenutzer können Konfigurationsdateien und Parameter im Quellcode ändern, um spezifische funktionale Anforderungen zu erfüllen.

LlamaEdge Schnell laufende Destillation auf einem Laptop DeepSeek-R1

DeepSeek-R1 ist ein leistungsstarkes und vielseitiges KI-Modell, das etablierte Anbieter wie OpenAI mit seinen fortschrittlichen Inferenzfunktionen, seiner Kosteneffizienz und seiner Open-Source-Verfügbarkeit herausfordert. Es hat zwar einige Einschränkungen, aber sein innovativer Ansatz und seine robuste Leistung machen es zu einem unschätzbaren Werkzeug für Entwickler, Forscher und Unternehmen. Wer seine Fähigkeiten erkunden möchte, kann das Modell und seine Lite-Version auf Plattformen wie Hugging Face und GitHub nutzen.

Es wurde von einem chinesischen Team mit GPU-Beschränkung trainiert und zeichnet sich durch Mathematik, Codierung und sogar einige recht komplexe Schlussfolgerungen aus. Interessant ist, dass es sich um ein "Lite"-Modell handelt, d. h. es ist kleiner und effizienter als das riesige Modell, auf dem es basiert. Das ist wichtig, denn dadurch wird es für die Menschen praktischer, es tatsächlich zu benutzen und zu bauen.

In diesem Artikel werden wir vorstellen

- Wie Sie Open Source auf Ihrem eigenen Gerät ausführen DeepSeek Modellierung

- Wie man einen OpenAI-kompatiblen API-Dienst mit dem neuesten DeepSeek-Modell erstellt

Wir werden LlamaEdge (Rust + Wasm technology stack) verwenden, um Anwendungen für dieses Modell zu entwickeln und einzusetzen. Sie müssen keine komplexen Python-Pakete oder C++-Toolchains installieren! Erfahren Sie, warum wir uns für diese Technologie entschieden haben.

Führen Sie das Modell DeepSeek-R1-Distill-Llama-8B auf Ihrem eigenen Gerät aus!

Schritt 1: Installieren Sie WasmEge über die folgende Befehlszeile.

curl -sSf https://raw.githubusercontent.com/WasmEdge/WasmEdge/master/utils/install_v2.sh | bash -s -- -v 0.14.1

Schritt 2: Laden Sie die quantisierte DeepSeek-R1-Distill-Llama-8B-GGUF-Modelldatei herunter.

Dies kann einige Zeit in Anspruch nehmen, da die Größe des Modells 5,73 GB beträgt.

curl -LO https://huggingface.co/second-state/DeepSeek-R1-Distill-Llama-8B-GGUF/resolve/main/DeepSeek-R1-Distill-Llama-8B-Q5_K_M.gguf `

Schritt 3: Laden Sie die LlamaEdge API Server-Anwendung herunter.

Es handelt sich außerdem um eine plattformübergreifende, portable Wasm-Anwendung, die auf vielen CPU- und GPU-Geräten läuft.

curl -LO https://github.com/LlamaEdge/LlamaEdge/releases/latest/download/llama-api-server.wasm

Schritt 4: Chatbot UI herunterladen

um mit dem DeepSeek-R1-Distill-Llama-8B-Modell in einem Browser zu interagieren.

curl -LO https://github.com/LlamaEdge/chatbot-ui/releases/latest/download/chatbot-ui.tar.gz tar xzf chatbot-ui.tar.gz rm chatbot-ui.tar.gz

Als nächstes starten Sie den LlamaEdge-API-Server mit dem folgenden Befehlsverhaltensmodell.

wasmedge --dir . :. --nn-preload default:GGML:AUTO:DeepSeek-R1-Distill-Llama-8B-Q5_K_M.gguf \ llama-api-server.wasm \ --prompt-template llama-3-chat \ --ctx-größe 8096

Dann öffnen Sie Ihren Browser und besuchen Sie http://localhost:8080, um den Chat zu starten! Oder Sie können eine API-Anfrage an das Modell senden.

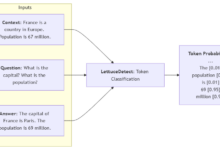

curl -X POST http://localhost:8080/v1/chat/completions \

-H 'accept:application/json' \

-H 'Content-Type: application/json' \\

-d '{"messages":[{"role": "system", "content": "Du bist ein hilfsbereiter Assistent."}, {"role": "user", "content": "Was ist die Hauptstadt von Frankreich?"}], " model": "DeepSeek-R1-Distill-Llama-8B"}'

{"id": "chatcmpl-68158f69-8577-4da2-a24b-ae8614f88fea", "object": "chat.completion", "created":1737533170, "model": "default", "choices". [{"index":0, "message":{"content": "Die Hauptstadt von Frankreich ist Paris.", "role":" assistant"}, "finish_reason": "stop", "logprobs":null}], "usage":{"prompt_tokens":34, "completion_tokens":18, "total_tokens":52}}

Erstellung OpenAI-kompatibler API-Dienste für DeepSeek-R1-Distill-Llama-8B

LlamaEdge ist leichtgewichtig und benötigt keinen Daemon oder sudo-Prozess zur Ausführung. Es kann leicht in Ihre eigenen Anwendungen eingebettet werden! Mit Unterstützung für Chat und Einbettung von Modellen kann LlamaEdge eine Alternative zur OpenAI API innerhalb von Anwendungen auf Ihrem lokalen Rechner sein!

Als nächstes zeigen wir, wie man eine neue Funktion zur DeepSeek-R1 Modell und das Einbettungsmodell, um den vollständigen API-Server zu starten. Der API-Server hat die Chat/Vervollständigungen im Gesang antworten Einbettungen Endpunkte. Zusätzlich zu den Schritten im vorigen Abschnitt müssen wir Folgendes tun:

Schritt 5: Laden Sie das Einbettungsmodell herunter.

curl -LO https://huggingface.co/second-state/Nomic-embed-text-v1.5-Embedding-GGUF/resolve/main/nomic-embed-text-v1.5.f16.gguf

Wir können dann den LlamaEdge-API-Server mit Chat und Einbettungsmodellen mit der folgenden Befehlszeile starten. Ausführlichere Anweisungen finden Sie in der Dokumentation - Starten des LlamaEdge-API-Dienstes.

wasmedge --dir . :. \ --nn-preload default:GGML:AUTO:DeepSeek-R1-Distill-Llama-8B-Q5_K_M.gguf \ --nn-preload einbettung:GGML:AUTO:nomic-embed-text-v1.5.f16.gguf \ llama-api-server.wasm -p llama-3-chat,embedding \ --model-name DeepSeek-R1-Distill-Llama-8B,nomic-embed-text-v1.5.f16 \ --ctx-size 8192,8192 \ ---batch-size 128,8192 \ --log-prompts --log-stat

Schließlich können Sie diesen Anleitungen folgen, um den LlamaEdge-API-Server in andere Agent-Frameworks als Ersatz für OpenAI zu integrieren. Ersetzen Sie insbesondere die OpenAI API durch die folgenden Werte in Ihrer Anwendung oder Agentenkonfiguration.

| Option "Konfigurieren | (wert sein) |

|---|---|

| Basis-API-URL | http://localhost:8080/v1 |

| Modellbezeichnung (großes Modell) | DeepSeek-R1-Distill-Llama-8B |

| Modellname (Texteinbettung) | nomic-embed |

Das war's! Besuchen Sie jetzt das LlamaEdge-Repository und bauen Sie Ihren ersten KI-Agenten! Wenn Sie es interessant finden, starten Sie bitte unser Repo hier. Wenn Sie Fragen zum Betrieb dieses Modells haben, gehen Sie bitte ebenfalls zum Repo, um Fragen zu stellen oder buchen Sie eine Demo bei uns, um Ihr eigenes LLM geräteübergreifend zu betreiben!