Zusammenfassungen.

In diesem Beitrag wird ein neuer Satz von Basismodellen mit dem Namen Llama 3 vorgestellt. Llama 3 ist eine Gemeinschaft von Sprachmodellen, die Mehrsprachigkeit, das Schreiben von Code, logisches Denken und die Verwendung von Werkzeugen unterstützt. Unser größtes Modell ist ein dichter Transformer mit 405 Milliarden Parametern und einem Kontextfenster von bis zu 128.000 Token.Dieses Papier führt eine umfangreiche Reihe von empirischen Bewertungen von Llama 3 durch. Die Ergebnisse zeigen, dass Llama 3 bei vielen Aufgaben eine Qualität erreicht, die mit führenden Sprachmodellen wie GPT-4 vergleichbar ist. Wir stellen Llama 3 öffentlich zur Verfügung, einschließlich vor- und nachtrainierter Sprachmodelle mit 405 Milliarden Parametern sowie des Llama Guard 3 Modells für Input-Output-Sicherheit. In diesem Papier werden auch experimentelle Ergebnisse zur Integration von Bild-, Video- und Sprachmerkmalen in Llama 3 durch einen kombinatorischen Ansatz vorgestellt. Wir stellen fest, dass dieser Ansatz mit den modernsten Ansätzen für Bild-, Video- und Spracherkennungsaufgaben konkurrieren kann. Da sich diese Modelle noch in der Entwicklungsphase befinden, sind sie noch nicht allgemein veröffentlicht worden.

Volltext herunterladen pdf:

1 Einleitung

Grundmodellsind allgemeine Modelle der Sprache, des Sehens, der Sprache und anderer Modalitäten, die zur Unterstützung einer breiten Palette von KI-Aufgaben entwickelt wurden. Sie bilden die Grundlage für viele moderne KI-Systeme.

Die Entwicklung eines modernen Basismodells gliedert sich in zwei Hauptphasen:

(1) Vorschulungsphase. Die Modelle werden anhand großer Datenmengen trainiert, wobei einfache Aufgaben wie die Vorhersage von Wörtern oder die Erstellung von Diagrammkommentaren verwendet werden;

(2) Nachbereitungsphase. Modelle werden fein abgestimmt, um Anweisungen zu befolgen, sich an menschlichen Vorlieben zu orientieren und bestimmte Fähigkeiten zu verbessern (z. B. Codierung und logisches Denken).

In diesem Beitrag wird eine neue Reihe von Sprachbasismodellen mit dem Namen Llama 3 vorgestellt. Die Llama 3 Herd-Familie von Modellen unterstützt von Haus aus Mehrsprachigkeit, Kodierung, Argumentation und Werkzeugnutzung. Unser größtes Modell ist ein dichter Transformer mit 405B Parametern, der Informationen in Kontextfenstern von bis zu 128K Token verarbeiten kann.

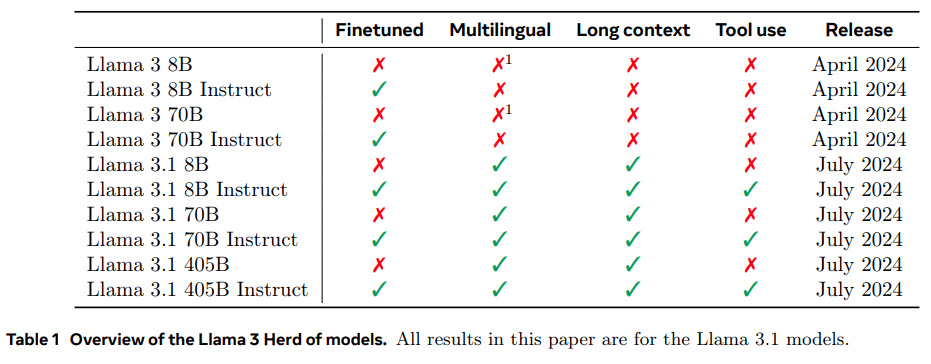

In Tabelle 1 sind die einzelnen Mitglieder der Herde aufgeführt. Alle in diesem Dokument vorgestellten Ergebnisse basieren auf dem Modell Llama 3.1 (kurz Llama 3).

Wir sind der Meinung, dass die drei wichtigsten Instrumente für die Entwicklung qualitativ hochwertiger Basismodelle Daten, Maßstab und Komplexitätsmanagement sind. Wir werden uns bemühen, diese drei Bereiche während unseres Entwicklungsprozesses zu optimieren:

- Daten. Sowohl die Quantität als auch die Qualität der Daten, die wir für das Pre- und Post-Training verwendet haben, wurden im Vergleich zu früheren Versionen von Llama verbessert (Touvron et al., 2023a, b). Zu diesen Verbesserungen gehören die Entwicklung sorgfältigerer Vorverarbeitungs- und Kuratierungspipelines für die Pre-Trainingsdaten sowie die Entwicklung einer strengeren Qualitätssicherung und Filterung. Entwicklung sorgfältigerer Vorverarbeitungs- und Kuratierungspipelines für Pre-Training-Daten und Entwicklung strengerer Qualitätssicherungs- und Filterverfahren Llama 3 wurde auf einem Korpus von etwa 15T mehrsprachigen Token vortrainiert, während Llama 2 auf 1,8T Token vortrainiert wurde.

- Umfang. Wir haben ein größeres Modell als das vorherige Llama-Modell trainiert: Unser Flaggschiff-Sprachmodell verwendet 3,8 × 1025 FLOPs für das Pre-Training, fast 50 Mal mehr als die größte Version von Llama 2. Konkret haben wir ein Vorzeigemodell mit 405B trainierbaren Parametern auf 15,6T Text-Token vortrainiert. Wie erwartet, ist die

- Komplexität bewältigen. Die von uns getroffenen Designentscheidungen zielten darauf ab, die Skalierbarkeit des Modellentwicklungsprozesses zu maximieren. So haben wir zum Beispiel einen dichten Standard Transformator Modellarchitektur (Vaswani et al., 2017) mit einigen geringfügigen Anpassungen, anstatt ein Experten-Mischmodell (Shazeer et al., 2017) zu verwenden, um die Trainingsstabilität zu maximieren. In ähnlicher Weise haben wir einen relativ einfachen Postprozessor verwendet, der auf überwachtem Fine-Tuning (SFT), Rejection Sampling (RS) und direkter Präferenzoptimierung (DPO; Rafailov et al. (2023)) basiert, anstatt komplexere Reinforcement-Learning-Algorithmen (Ouyang et al., 2022; Schulman et al., 2017) zu verwenden, die oft weniger stabil und schwierig zu skalieren sind.

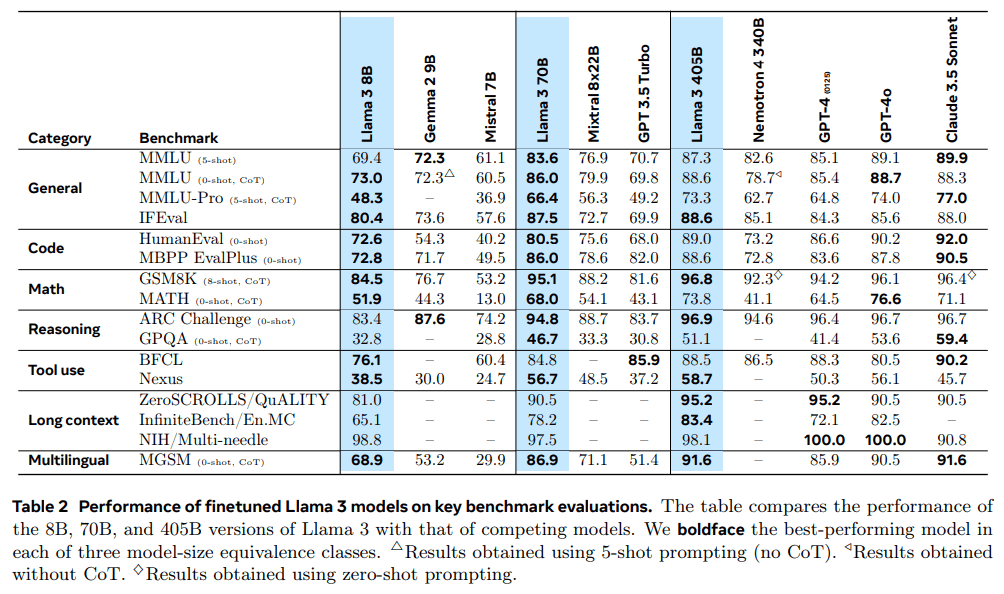

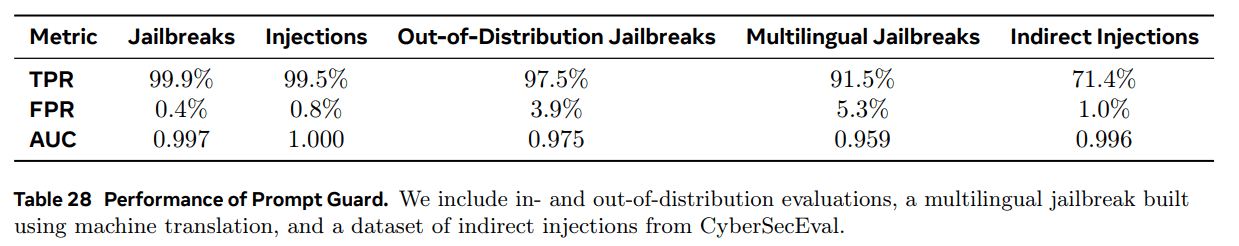

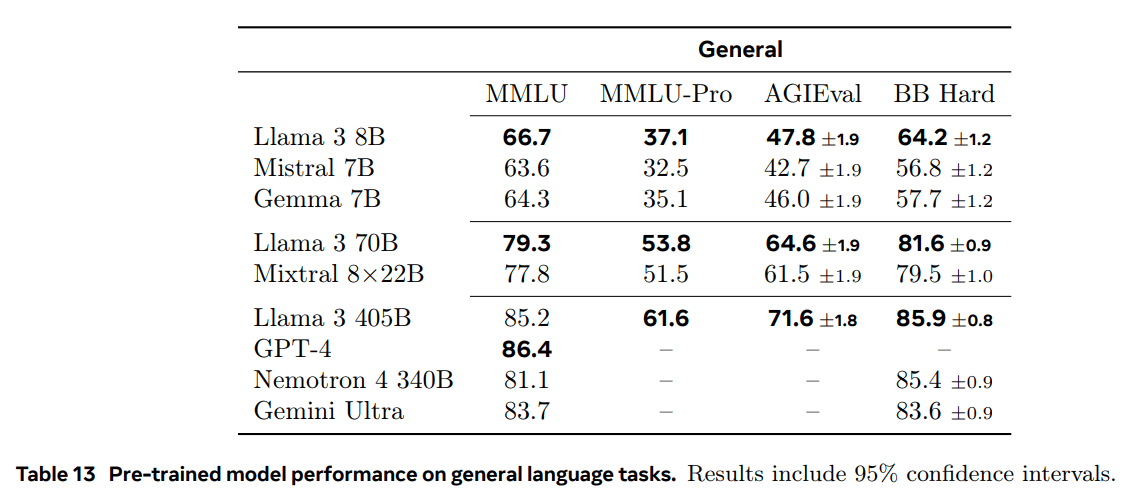

Das Ergebnis unserer Arbeit ist Llama 3: eine dreisprachige Mehrsprachigkeit mit 8B, 70B und 405B Parametern.1Population von Sprachmodellen. Wir haben die Leistung von Llama 3 anhand einer großen Anzahl von Benchmark-Datensätzen bewertet, die ein breites Spektrum von Sprachverstehensaufgaben abdecken. Darüber hinaus haben wir umfangreiche manuelle Evaluierungen durchgeführt, bei denen wir Llama 3 mit konkurrierenden Modellen verglichen haben. Tabelle 2 zeigt einen Überblick über die Leistung des Flaggschiffs Llama 3 in den wichtigsten Benchmark-Tests. Unsere experimentellen Auswertungen zeigen, dass unser Flaggschiffmodell mit führenden Sprachmodellen wie GPT-4 (OpenAI, 2023a) mithalten kann und bei einer Vielzahl von Aufgaben nahe am Stand der Technik ist. Unser kleineres Modell ist Klassenbester und übertrifft andere Modelle mit einer ähnlichen Anzahl von Parametern (Bai et al., 2023; Jiang et al., 2023).Llama 3 schafft auch ein besseres Gleichgewicht zwischen Hilfsbereitschaft und Unbedenklichkeit als sein Vorgänger (Touvron et al., 2023b). Wir analysieren die Sicherheit von Llama 3 im Detail in Abschnitt 5.4.

Wir veröffentlichen alle drei Llama-3-Modelle unter einer aktualisierten Version der Llama-3-Community-Lizenz; siehe https://llama.meta.com. Dazu gehören vortrainierte und nachbearbeitete Versionen unseres parametrischen Sprachmodells 405B sowie eine neue Version des Llama-Guard-Modells (Inan et al., 2023) zur Eingabe- und Ausgabesicherheit. und Ausgabesicherheit. Wir hoffen, dass die Veröffentlichung eines Vorzeigemodells eine Innovationswelle in der Forschungsgemeinschaft auslösen und den Fortschritt auf dem Weg zu einer verantwortungsvollen Entwicklung der künstlichen Intelligenz (AGI) beschleunigen wird.

Mehrsprachig: Dies bezieht sich auf die Fähigkeit des Modells, Text in mehreren Sprachen zu verstehen und zu erzeugen.

Während der Entwicklung von Llama 3 haben wir auch multimodale Erweiterungen des Modells entwickelt, um Bilderkennung, Videoerkennung und Sprachverständnis zu ermöglichen. Diese Modelle befinden sich noch in der aktiven Entwicklung und sind noch nicht zur Veröffentlichung bereit. Zusätzlich zu den Ergebnissen unserer Sprachmodellierung werden in diesem Papier die Ergebnisse unserer ersten Experimente mit diesen multimodalen Modellen vorgestellt.

Llama 3 8B und 70B wurden mit mehrsprachigen Daten trainiert, wurden aber zu diesem Zeitpunkt hauptsächlich für Englisch verwendet.

2 Allgemeines

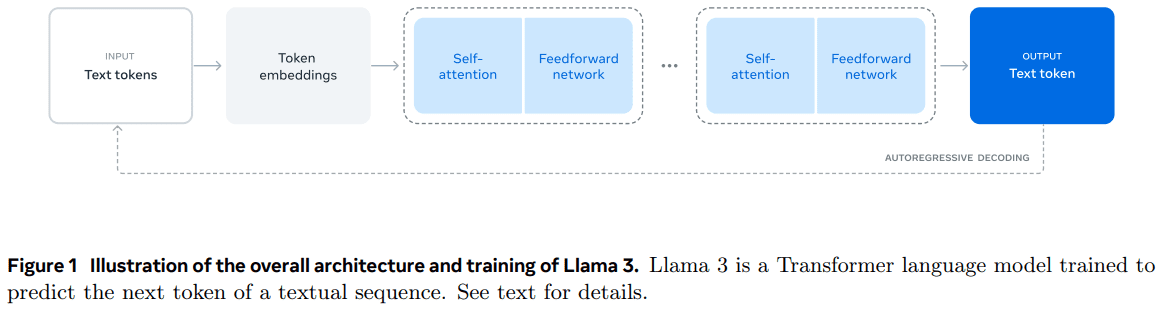

Die Architektur des Llama 3-Modells ist in Abbildung 1 dargestellt. Die Entwicklung unseres Llama 3-Sprachmodells ist in zwei Hauptphasen unterteilt:

- Vortraining des Sprachmodells.Wir konvertieren zunächst ein großes mehrsprachiges Textkorpus in diskrete Token und trainieren ein Large Language Model (LLM) auf den resultierenden Daten für die nächste Token-Vorhersage vor. In der LLM-Pre-Trainingsphase lernt das Modell die Struktur der Sprache und erwirbt eine große Menge an Wissen über die Welt aus dem Text, den es "liest". Um dies effizient zu tun, wird das Pre-Training in großem Maßstab durchgeführt: Wir haben ein Modell mit 405B Parametern auf einem Modell mit 15,6T Token vortrainiert, wobei ein Kontextfenster von 8K Token verwendet wurde. Auf diese Standard-Pre-Trainingsphase folgt eine weitere Pre-Trainingsphase, in der das unterstützte Kontextfenster auf 128K Token erhöht wird. Siehe Abschnitt 3 für weitere Informationen.

- Ausbildung nach der Modellierung.Das vortrainierte Sprachmodell verfügt über ein umfassendes Verständnis der Sprache, hat aber noch nicht die Anweisungen befolgt oder sich wie der Assistent verhalten, den wir von ihm erwarten. Wir haben das Modell durch menschliches Feedback in mehreren Runden kalibriert, wobei jede Runde eine überwachte Feinabstimmung (SFT) und eine direkte Präferenzoptimierung (DPO; Rafailov et al., 2024) auf anweisungsabgestimmten Daten beinhaltete. In dieser Nachtrainings-Phase haben wir auch neue Merkmale, wie die Verwendung von Werkzeugen, integriert und deutliche Verbesserungen in Bereichen wie Codierung und Inferenz beobachtet. Weitere Informationen finden Sie in Abschnitt 4. Schließlich wurden in der Nachtrainings-Phase auch Sicherheitsabschwächungen in das Modell integriert, deren Einzelheiten in Abschnitt 5.4 beschrieben werden. Die generierten Modelle sind sehr funktionsreich. Sie sind in der Lage, Fragen in mindestens acht Sprachen zu beantworten, qualitativ hochwertigen Code zu schreiben, komplexe Inferenzprobleme zu lösen und Tools out-of-the-box oder stichprobenfrei zu verwenden.

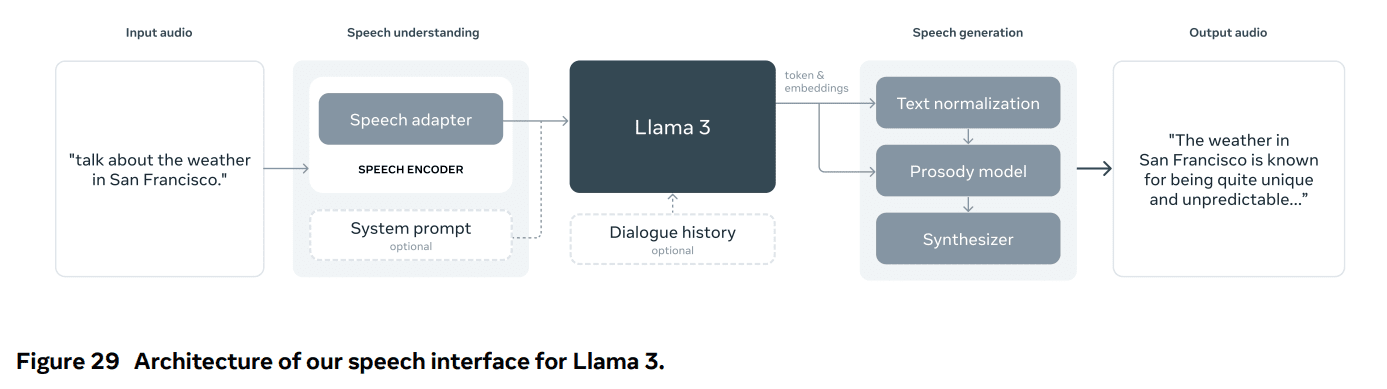

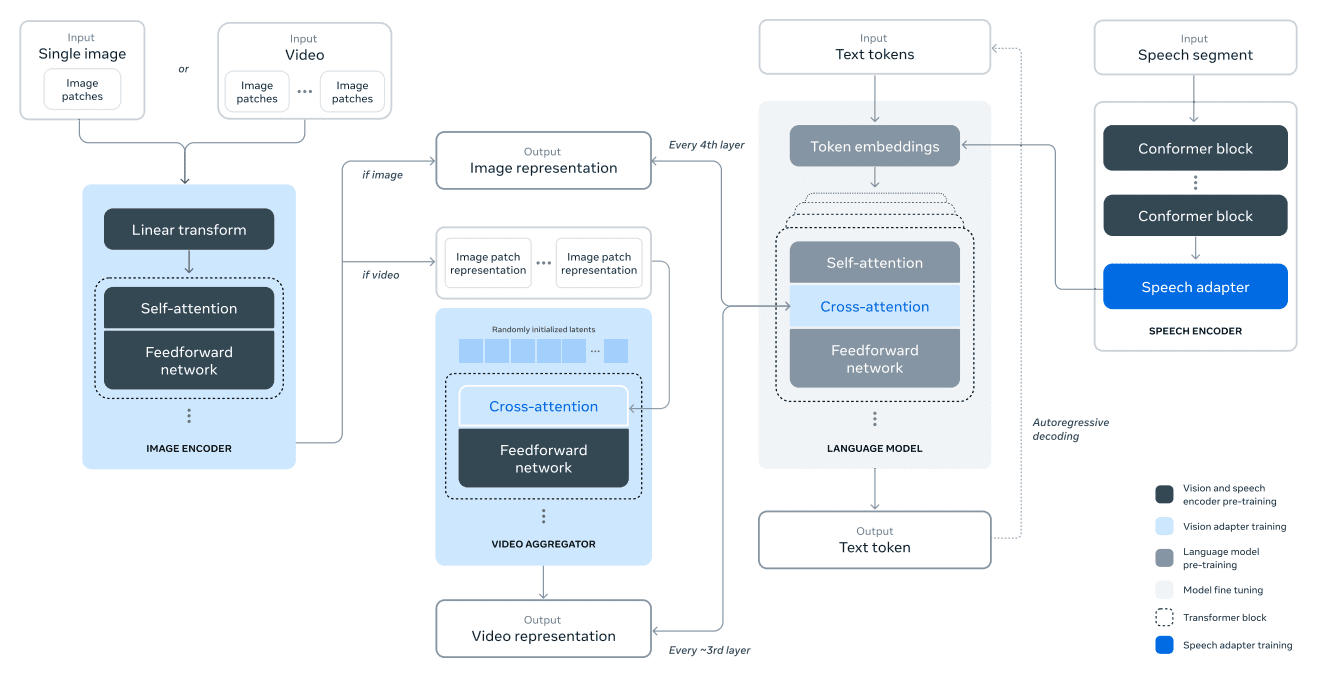

Wir führen auch Experimente durch, um Llama 3 durch einen kombinierten Ansatz um Bild-, Video- und Sprachfunktionen zu erweitern. Der von uns untersuchte Ansatz besteht aus drei zusätzlichen Phasen, die in Abbildung 28 dargestellt sind:

- Multimodales Encoder-Vortraining.Wir trainieren separate Kodierer für Bild und Sprache. Wir trainieren den Bildkodierer mit einer großen Anzahl von Bild-Text-Paaren. Dadurch lernt das Modell die Beziehung zwischen dem visuellen Inhalt und seiner natürlichsprachlichen Beschreibung. Unser Sprachcodierer verwendet eine selbstüberwachte Methode, die einen Teil der Spracheingabe maskiert und versucht, den maskierten Teil durch eine diskrete Markerrepräsentation zu rekonstruieren. Auf diese Weise erlernt das Modell die Struktur des Sprachsignals. Weitere Informationen zu Bildkodierern finden Sie in Abschnitt 7 und zu Sprachkodierern in Abschnitt 8.

- Ausbildung zum visuellen Adapter.Wir trainieren einen Adapter, der einen vortrainierten Bildkodierer mit einem vortrainierten Sprachmodell verbindet. Der Adapter besteht aus einer Reihe von Cross-Attention-Schichten, die die Darstellung des Bildkodierers in das Sprachmodell einspeisen. Der Adapter wird auf Text-Bild-Paare trainiert, wodurch die Bildrepräsentation mit der Sprachrepräsentation in Einklang gebracht wird. Während des Trainings des Adapters aktualisieren wir auch die Parameter des Bild-Encoders, nicht aber die Parameter des Sprachmodells. Wir trainieren auch einen Videoadapter zusätzlich zum Bildadapter, indem wir gepaarte Video-Text-Daten verwenden. Dadurch kann das Modell Informationen über mehrere Bilder hinweg zusammenfassen. Für weitere Informationen siehe Abschnitt 7.

- Schließlich integrieren wir den Sprachkodierer über einen Adapter in das Modell, der die Sprachkodierung in eine tokenisierte Repräsentation umwandelt, die direkt in das feinabgestimmte Sprachmodell eingespeist werden kann. Während der überwachten Feinabstimmungsphase werden die Parameter des Adapters und des Encoders gemeinsam aktualisiert, um ein hochwertiges Sprachverständnis zu erreichen. Das Sprachmodell wird während des Trainings des Sprachadapters nicht verändert. Wir integrieren auch ein Text-to-Speech-System. Siehe Abschnitt 8 für weitere Einzelheiten.

Unsere multimodalen Experimente haben zu Modellen geführt, die den Inhalt von Bildern und Videos erkennen und die Interaktion über eine Sprachschnittstelle unterstützen. Diese Modelle befinden sich noch in der Entwicklung und sind noch nicht zur Veröffentlichung bereit.

3 Vorschulung

Das Vortraining von Sprachmodellen umfasst die folgenden Aspekte:

(1) Sammeln und Filtern großer Trainingskorpora;

(2) Entwicklung von Modellarchitekturen und entsprechenden Skalierungsgesetzen zur Bestimmung der Modellgröße;

(3) Entwicklung von Techniken für effizientes Pre-Training in großem Maßstab;

(4) Entwicklung eines Vorschulungsprogramms. Jede dieser Komponenten wird im Folgenden beschrieben.

3.1 Daten vor dem Training

Wir haben aus verschiedenen Datenquellen Datensätze für das Vortraining von Sprachmodellen erstellt, die Wissen bis Ende 2023 enthalten. Für jede Datenquelle haben wir mehrere Deduplizierungsmethoden und Datenbereinigungsmechanismen angewandt, um eine hochwertige Kennzeichnung zu erhalten. Wir haben Domänen mit großen Mengen an personenbezogenen Daten sowie Domänen mit bekanntermaßen nicht jugendfreien Inhalten entfernt.

3.11 Bereinigung von Webdaten

Die meisten der von uns verwendeten Daten stammen aus dem Internet, und wir beschreiben im Folgenden unseren Bereinigungsprozess.

PII und Sicherheitsfilterung. Neben anderen Maßnahmen haben wir Filter implementiert, die Daten von Websites entfernen, die möglicherweise unsichere Inhalte oder große Mengen personenbezogener Daten enthalten, von Domains, die nach verschiedenen Meta-Sicherheitsstandards als schädlich eingestuft sind, und von Domains, die bekanntermaßen nicht jugendfreie Inhalte enthalten.

Extraktion und Bereinigung von Text. Wir verarbeiten rohe HTML-Inhalte, um hochwertigen, vielfältigen Text zu extrahieren, und verwenden zu diesem Zweck nicht abgeschnittene Webdokumente. Zu diesem Zweck haben wir einen benutzerdefinierten Parser entwickelt, der HTML-Inhalte extrahiert und die Genauigkeit der Vorlagenentfernung sowie die Wiedererkennung von Inhalten optimiert. Wir haben die Qualität des Parsers durch eine manuelle Bewertung beurteilt und ihn mit populären HTML-Parsern von Drittanbietern verglichen, die für den Inhalt ähnlicher Artikel optimiert sind, und festgestellt, dass er gut funktioniert. Bei HTML-Seiten, die Mathematik- und Codeinhalte enthalten, achten wir darauf, dass die Struktur dieser Inhalte erhalten bleibt. Wir behalten den Text des Alt-Attributs für Bilder bei, da mathematische Inhalte in der Regel als vorgerendertes Bild dargestellt werden, bei dem die Mathematik ebenfalls im Alt-Attribut enthalten ist.

Wir haben festgestellt, dass Markdown die Leistung des Modells, das hauptsächlich auf Webdaten trainiert wurde, im Vergleich zu reinem Text beeinträchtigt, daher haben wir alle Markdown-Tags entfernt.

Betonung abbauen. Wir führen mehrere Deduplizierungsrunden auf URL-, Dokument- und Zeilenebene durch:

- De-Duplizierung auf URL-Ebene. Wir führen eine Deduplizierung auf URL-Ebene für den gesamten Datensatz durch. Für jede Seite, die einer URL entspricht, behalten wir die letzte Version.

- De-Duplizierung auf Dokumentenebene. Wir führen eine globale MinHash-Deduplizierung (Broder, 1997) für den gesamten Datensatz durch, um nahezu doppelte Dokumente zu entfernen.

- De-Duplizierung auf Zeilenebene. Wir führen eine radikale Deduplizierung ähnlich wie bei ccNet (Wenzek et al., 2019) durch. Wir entfernen Zeilen, die mehr als 6 Mal in jeder Gruppe mit 30 Millionen Dokumenten vorkommen.

Obwohl unsere manuellen qualitativen Analysen darauf hindeuten, dass die De-Duplizierung auf Zeilenebene nicht nur den restlichen Standardinhalt einer Vielzahl von Websites (z. B. Navigationsmenüs, Cookie-Warnungen), sondern auch häufigen hochwertigen Text entfernt, zeigen unsere empirischen Auswertungen deutliche Verbesserungen.

Heuristische Filterung. Es wurden Heuristiken entwickelt, um zusätzliche minderwertige Dokumente, Ausreißer und Dokumente mit zu vielen Wiederholungen zu entfernen. Einige Beispiele für Heuristiken sind:

- Wir verwenden Duplicate n-tuple coverage (Rae et al., 2021), um Zeilen mit doppeltem Inhalt (z. B. Protokolle oder Fehlermeldungen) zu entfernen. Diese Zeilen können sehr lang und eindeutig sein und können daher nicht durch Zeilenduplizierung herausgefiltert werden.

- Wir verwenden eine Zählung von "schmutzigen Wörtern" (Raffel et al., 2020), um Seiten mit nicht jugendfreien Inhalten herauszufiltern, die nicht von der Domain-Blacklist erfasst sind.

- Wir verwenden die Kullback-Leibler-Streuung der Token-Verteilung, um Dokumente herauszufiltern, die im Vergleich zur Verteilung im Trainingskorpus zu viele anomale Token enthalten.

Modellgestützte Qualitätsfilterung.

Darüber hinaus haben wir versucht, verschiedene modellbasierte Qualitätsklassifikatoren für die Auswahl hochwertiger Etiketten zu verwenden. Zu diesen Methoden gehören:

- Verwendung schneller Klassifikatoren wie fasttext (Joulin et al., 2017), die darauf trainiert sind, zu erkennen, ob ein bestimmter Text in Wikipedia zitiert wird (Touvron et al., 2023a).

- Es wurde ein rechenintensiverer Klassifikator nach dem Roberta-Modell (Liu et al., 2019a) verwendet, der anhand der Vorhersagen von Llama 2 trainiert wurde.

Um den auf Llama 2 basierenden Qualitätsklassifikator zu trainieren, haben wir eine Reihe von bereinigten Webdokumenten erstellt, die die Qualitätsanforderungen beschreiben, und das Chat-Modell von Llama 2 angewiesen, zu bestimmen, ob die Dokumente diese Anforderungen erfüllen. Um die Effizienz zu steigern, verwenden wir DistilRoberta (Sanh et al., 2019), um Qualitätsbewertungen für jedes Dokument zu erstellen. Wir werden die Wirksamkeit verschiedener Qualitätsfilterkonfigurationen experimentell bewerten.

Code und Inferenzdaten.

Ähnlich wie DeepSeek-AI et al. (2024) haben wir domänenspezifische Pipelines entwickelt, um Webseiten zu extrahieren, die Code und Mathematik enthalten. Sowohl die Code- als auch die Inferenz-Klassifikatoren sind DistilledRoberta-Modelle, die mit Llama 2 annotierten Webdaten trainiert wurden. Im Gegensatz zu den oben erwähnten generischen Qualitätsklassifikatoren führen wir ein Cue-Tuning durch, um Webseiten mit mathematischen Schlussfolgerungen, Schlussfolgerungen in MINT-Bereichen und in natürliche Sprache eingebetteten Code zu finden. Da sich die Token-Verteilungen von Code und Mathematik stark von denen der natürlichen Sprache unterscheiden, implementieren diese Pipelines eine domänenspezifische HTML-Extraktion, benutzerdefinierte Textmerkmale und Heuristiken für die Filterung.

Mehrsprachige Daten.

Ähnlich wie die oben beschriebene englische Verarbeitungspipeline implementieren wir Filter, um Websitedaten zu entfernen, die möglicherweise personenbezogene Daten oder unsichere Inhalte enthalten. Unsere mehrsprachige Textverarbeitungspipeline weist die folgenden einzigartigen Merkmale auf:

- Wir verwenden ein schnelles textbasiertes Spracherkennungsmodell, um Dokumente in 176 Sprachen zu klassifizieren.

- Wir führen die Datendeduplizierung auf Dokumentenebene und auf Zeilenebene für jede Sprache durch.

- Wir wenden sprachspezifische Heuristiken und modellbasierte Filter an, um minderwertige Dokumente zu entfernen.

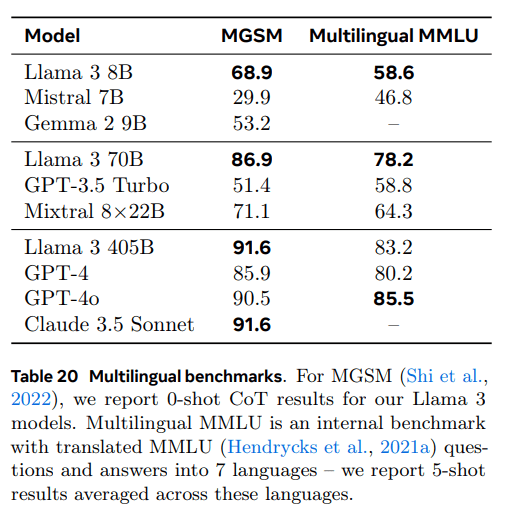

Darüber hinaus verwenden wir einen mehrsprachigen Klassifikator auf der Grundlage von Llama 2, um die Qualität mehrsprachiger Dokumente zu bewerten und sicherzustellen, dass hochwertige Inhalte bevorzugt behandelt werden. Die Anzahl der mehrsprachigen Token, die wir im Pre-Training verwenden, wird experimentell bestimmt, und die Modellleistung wird in englischen und mehrsprachigen Benchmark-Tests ausgeglichen.

3.12 Bestimmung des Datenmixes

为了获得高质量语言模型,必须谨慎确定预训练数据混合中不同数据源的比例。我们主要利用知识分类和尺度定律实验来确定这一数据混合。

知识分类。我们开发了一个分类器,用于对网页数据中包含的信息类型进行分类,以便更有效地确定数据组合。我们使用这个分类器对网页上过度代表的数据类别(例如艺术和娱乐)进行下采样。

为了确定最佳数据混合方案。我们进行规模定律实验,其中我们将多个小型模型训练于特定数据混合集上,并利用其预测大型模型在该混合集上的性能(参见第 3.2.1 节)。我们多次重复此过程,针对不同的数据混合集选择新的候选数据混合集。随后,我们在该候选数据混合集上训练一个更大的模型,并在多个关键基准测试上评估该模型的性能。

数据混合摘要。我们的最终数据混合包含大约 50% 的通用知识标记、25% 的数学和推理标记、17% 的代码标记以及 8% 的多语言标记。

3.13 Glühdaten

Empirische Ergebnisse zeigen, dass das Annealing auf einer kleinen Menge hochwertiger Code- und Mathematikdaten (siehe Abschnitt 3.4.3) die Leistung von vortrainierten Modellen in wichtigen Benchmark-Tests verbessern kann. Ähnlich wie in der Studie von Li et al. (2024b) führen wir das Annealing mit einem gemischten Datensatz durch, der hochwertige Daten aus ausgewählten Bereichen enthält. Unsere geglätteten Daten enthalten keine Trainingsdatensätze aus häufig verwendeten Vergleichstests. Dies ermöglicht es uns, die tatsächliche Lernfähigkeit von Llama 3 für wenige Stichproben und die Generalisierung außerhalb der Domäne zu bewerten.

In Anlehnung an OpenAI (2023a) haben wir die Auswirkung von Annealing auf die Trainingssätze GSM8k (Cobbe et al., 2021) und MATH (Hendrycks et al., 2021b) untersucht. Wir stellen fest, dass Annealing die Leistung des vortrainierten Llama 3 8B-Modells um 24,0% bzw. 6,4% auf den GSM8k- und MATH-Validierungssätzen verbessert, während die Verbesserung für das 405B-Modell vernachlässigbar ist, was darauf hindeutet, dass unser Vorzeigemodell über starke kontextuelle Lern- und Schlussfolgerungsfähigkeiten verfügt und dass es keine domänenspezifischen Trainingsmuster benötigt, um eine robuste Leistung zu erzielen.

Bewerten Sie die Datenqualität durch Glühen.Wie Blakeney et al. (2024) stellen wir fest, dass wir mit Hilfe von Annealing den Wert kleiner domänenspezifischer Datensätze beurteilen können. Wir messen den Wert dieser Datensätze, indem wir die Lernrate des Llama 3 8B-Modells, das mit 50% trainiert wurde, über 40 Milliarden Token linear auf 0 annealen. In diesen Experimenten weisen wir dem neuen Datensatz 30%-Gewichte zu und die restlichen 70%-Gewichte dem Standarddatenmix. Es ist effizienter, neue Datenquellen durch Annealing zu evaluieren, als Skalierungsexperimente mit jedem kleinen Datensatz durchzuführen.

3.2 Modellarchitektur

Llama 3 verwendet die standardmäßige dichte Transformer-Architektur (Vaswani et al., 2017). Die Modellarchitektur unterscheidet sich nicht wesentlich von Llama und Llama 2 (Touvron et al., 2023a, b); unsere Leistungssteigerungen sind in erster Linie auf Verbesserungen bei der Datenqualität und -vielfalt sowie auf die Vergrößerung der Trainingsgröße zurückzuführen.

Wir haben ein paar kleine Änderungen vorgenommen:

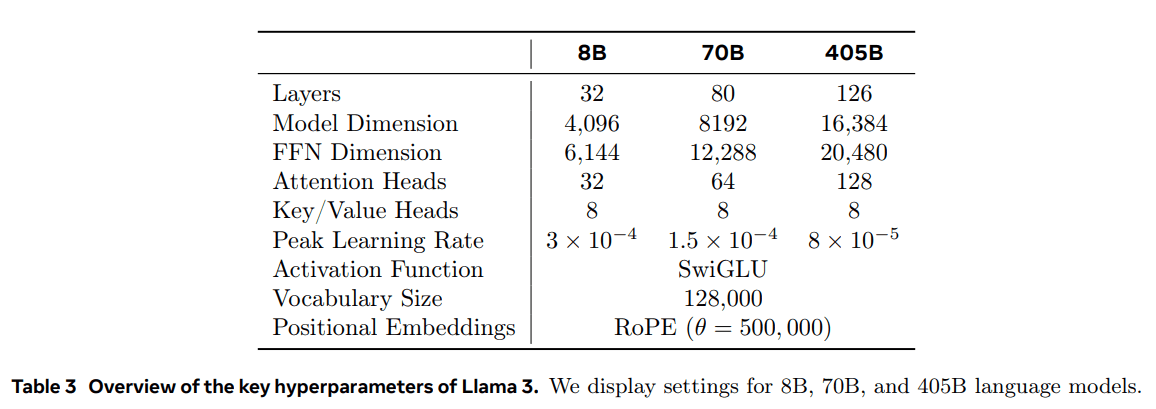

- Wir verwenden Grouped Query Attention (GQA; Ainslie et al. (2023)), bei der 8 Key-Value-Header verwendet werden, um die Inferenzgeschwindigkeit zu erhöhen und die Größe des Key-Value-Cache während der Dekodierung zu reduzieren.

- Wir verwenden eine Aufmerksamkeitsmaske, um Mechanismen der Selbstaufmerksamkeit zwischen verschiedenen Dokumenten in der Sequenz zu verhindern. Wir stellen fest, dass diese Änderung beim Standard-Pre-Training nur begrenzte Auswirkungen hat, beim kontinuierlichen Pre-Training von sehr langen Sequenzen jedoch wichtig ist.

- Wir verwenden ein Vokabular von 128K Token. Unser tokenisiertes Vokabular kombiniert die 100K Token des tiktoken3-Vokabulars mit 28K zusätzlichen Token, um nicht-englische Sprachen besser zu unterstützen. Im Vergleich zum Vokabular von Llama 2 verbessert unser neues Vokabular die Komprimierung von englischen Datenproben von 3,17 auf 3,94 Zeichen/Token. Dadurch kann das Modell bei gleichem Trainingsaufwand mehr Text "lesen". Wir haben auch festgestellt, dass das Hinzufügen von 28K Token aus bestimmten nicht-englischen Sprachen die Kompression und die nachgelagerte Leistung verbessert, während es keine Auswirkungen auf die englische Tokenisierung hat.

- Wir erhöhen den RoPE-Basisfrequenz-Hyperparameter auf 500.000. Damit können wir längere Kontexte besser unterstützen; Xiong et al. (2023) zeigen, dass dieser Wert für Kontextlängen bis zu 32.768 gültig ist.

Das Llama 3 405B verwendet eine Architektur mit 126 Schichten, 16.384 Marker-Repräsentationsdimensionen und 128 Aufmerksamkeitsköpfen; weitere Informationen finden Sie in Tabelle 3. Dies führt zu einer Modellgröße, die auf der Grundlage unserer Daten und eines Trainingsbudgets von 3,8 × 10^25 FLOPs annähernd rechnerisch optimal ist.

3.2.1 Gesetz der Skala

Wir haben die Skalierungsgesetze (Hoffmann et al., 2022; Kaplan et al., 2020) verwendet, um die optimale Größe des Flaggschiffmodells unter Berücksichtigung unseres Rechenbudgets vor dem Training zu bestimmen. Neben der Bestimmung der optimalen Modellgröße stellt die Vorhersage der Leistung des Flaggschiffmodells bei nachgelagerten Benchmark-Aufgaben aus den folgenden Gründen eine große Herausforderung dar:

- Bestehende Skalierungsgesetze sagen in der Regel nur den Verlust der nächsten Markierungsvorhersage voraus, nicht aber eine bestimmte Benchmarking-Leistung.

- Skalierungsgesetze können verrauscht und unzuverlässig sein, da sie auf der Grundlage von Vortrainingsläufen mit einem geringen Rechenbudget entwickelt werden (Wei et al., 2022b).

Um diese Herausforderungen zu bewältigen, haben wir einen zweistufigen Ansatz zur Entwicklung von Skalierungsgesetzen entwickelt, die eine genaue Vorhersage der Downstream-Benchmarking-Leistung ermöglichen:

- Wir stellen zunächst die Korrelation zwischen den FLOPs vor dem Training und der Berechnung der negativen Log-Likelihood des besten Modells für die nachgelagerte Aufgabe fest.

- Als Nächstes korrelieren wir die negative Log-Wahrscheinlichkeit bei der nachgelagerten Aufgabe mit der Aufgabengenauigkeit unter Verwendung des Modells der Skalierungsgesetze und eines älteren Modells, das zuvor mit einer höheren Rechenleistung (FLOPs) trainiert wurde. In diesem Schritt verwenden wir ausschließlich die Llama-2-Modellfamilie.

Mit diesem Ansatz können wir die nachgelagerte Aufgabenleistung (für rechnerisch optimale Modelle) auf der Grundlage einer bestimmten Anzahl von vortrainierten FLOPs vorhersagen. Wir verwenden einen ähnlichen Ansatz, um unsere Kombination von Vortrainingsdaten auszuwählen (siehe Abschnitt 3.4).

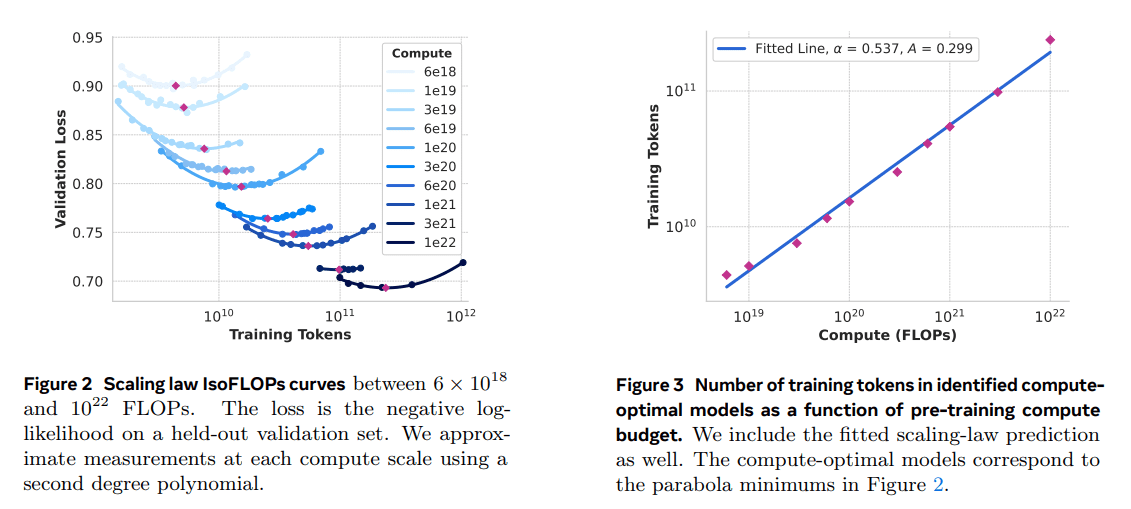

Skalierung Rechtsexperiment.Konkret haben wir Skalierungsgesetze konstruiert, indem wir Modelle mit Rechenbudgets zwischen 6 × 10^18 FLOPs und 10^22 FLOPs vortrainiert haben. Bei jedem Rechenbudget haben wir Modelle mit Größen zwischen 40M und 16B Parametern vortrainiert und einen Bruchteil der Modellgröße bei jedem Rechenbudget verwendet. Bei diesen Trainingsläufen verwenden wir eine kosinusförmige Lernratenplanung und ein lineares Warm-up innerhalb von 2.000 Trainingsschritten. Die Spitzenlernrate wurde je nach Modellgröße zwischen 2 × 10^-4 und 4 × 10^-4 festgelegt. Der Cosinus-Abfall wurde auf das 0,1-fache des Spitzenwertes festgelegt. Der Gewichtsabfall für jeden Schritt wurde auf das 0,1-fache der Lernrate für diesen Schritt festgelegt. Für jede Berechnungsgröße wurde eine feste Stapelgröße verwendet, die von 250K bis 4M reichte.

Diese Experimente ergaben die IsoFLOPs-Kurven in Abbildung 2. Die Verluste in diesen Kurven wurden an separaten Validierungssätzen gemessen. Wir passen die gemessenen Verlustwerte mit einem Polynom zweiter Ordnung an und bestimmen den Minimalwert jeder Parabel. Wir bezeichnen das Minimum der Parabel als das rechnerisch optimale Modell unter dem entsprechenden vortrainierten Berechnungsbudget.

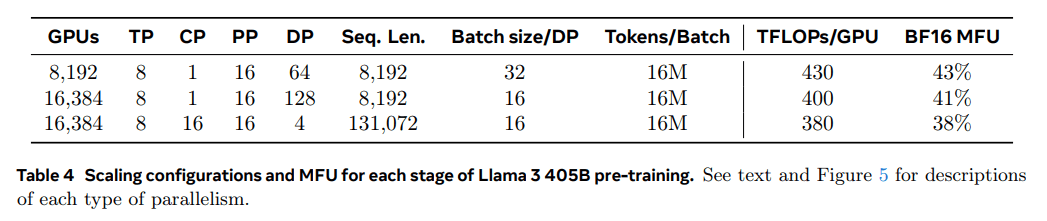

Wir verwenden die auf diese Weise ermittelten rechnerisch optimalen Modelle, um die optimale Anzahl von Trainings-Token für ein gegebenes Rechenbudget vorherzusagen. Zu diesem Zweck nehmen wir eine Potenzgesetz-Beziehung zwischen dem Berechnungsbudget C und der optimalen Anzahl von Trainingstoken N (C) an:

N (C) = AC α .

Wir passen A und α anhand der Daten in Abb. 2 an. Wir finden (α, A) = (0,53, 0,29); die entsprechende Anpassung ist in Abb. 3 dargestellt. Die Extrapolation des resultierenden Skalierungsgesetzes auf 3,8 × 10 25 FLOPs legt nahe, ein Modell mit 402B Parametern zu trainieren und 16,55T Token zu verwenden.

Eine wichtige Beobachtung ist, dass die IsoFLOPs-Kurve um das Minimum herum flacher wird, wenn das Berechnungsbudget steigt. Dies bedeutet, dass die Leistung des Flaggschiffmodells relativ stabil ist, wenn der Kompromiss zwischen Modellgröße und Trainingsmarkern geringfügig variiert. Auf der Grundlage dieser Beobachtung haben wir schließlich beschlossen, ein Flaggschiffmodell zu trainieren, das den Parameter 405B enthält.

Vorhersage der Leistung bei nachgelagerten Aufgaben.Wir verwenden das generierte rechnerisch optimale Modell, um die Leistung des Vorzeigemodells Llama 3 auf dem Benchmark-Datensatz vorherzusagen. Zunächst setzen wir die (normierte) negative logarithmische Wahrscheinlichkeit der richtigen Antwort im Benchmark in linearen Zusammenhang mit den Trainings-FLOPs. Für diese Analyse haben wir nur das Skalierungsgesetz-Modell verwendet, das auf 10^22 FLOPs auf der oben genannten Datenmischung trainiert wurde. Als Nächstes haben wir eine S-förmige Beziehung zwischen der Log-Likelihood und der Genauigkeit unter Verwendung des Scaling-Law-Modells und des Llama-2-Modells ermittelt, das mit dem Llama-2-Datenmix und dem Tagger trainiert wurde. (Die Ergebnisse dieses Experiments mit dem ARC-Challenge-Benchmark sind in Abbildung 4 dargestellt). Wir stellen fest, dass diese zweistufige Vorhersage nach dem Skalierungsgesetz (extrapoliert über vier Größenordnungen) recht genau ist: Sie unterschätzt die endgültige Leistung des Vorzeigemodells Llama 3 nur leicht.

3.3 Infrastruktur, Ausbau und Effizienz

Wir beschreiben die Hardware und die Infrastruktur, die das Llama 3 405B Pre-Training unterstützen und diskutieren verschiedene Optimierungen, die die Trainingseffizienz verbessern.

3.3.1 Ausbildungsinfrastruktur

Die Modelle Llama 1 und Llama 2 wurden auf dem KI-Forschungs-Supercluster von Meta trainiert (Lee und Sengupta, 2022). Im Zuge der weiteren Skalierung wurde das Training von Llama 3 auf den Produktionscluster von Meta verlagert (Lee et al., 2024). Dieses Setup optimiert die Zuverlässigkeit auf Produktionsebene, was bei der Ausweitung des Trainings entscheidend ist.

EDV-Ressourcen: Der Llama 3 405B trainiert bis zu 16.000 H100-GPUs, die jeweils mit 700 W TDP und 80 GB HBM3 laufen, unter Verwendung der Grand Teton AI-Serverplattform von Meta (Matt Bowman, 2022). Jeder Server ist mit acht GPUs und zwei CPUs ausgestattet; innerhalb des Servers sind die acht GPUs über NVLink verbunden. Die Trainingsaufträge werden mit MAST (Choudhury et al., 2024), dem globalen Trainingsplaner von Meta, geplant.

Lagerung: Tectonic (Pan et al., 2021), das verteilte Allzweck-Dateisystem von Meta, wurde zum Aufbau der Speicherarchitektur für das Vortraining von Llama 3 (Battey und Gupta, 2024) verwendet. Es bietet 240 Petabyte Speicherplatz und besteht aus 7.500 mit SSDs ausgestatteten Servern, die einen nachhaltigen Durchsatz von 2 TB/s und einen Spitzendurchsatz von 7 TB/s unterstützen. Eine große Herausforderung ist die Unterstützung von Checkpoint-Schreibvorgängen, die die Speicherstruktur in kurzer Zeit sättigen. Checkpoints speichern den Modellstatus pro GPU, der von 1 MB bis 4 GB pro GPU reicht, zur Wiederherstellung und Fehlersuche. Unser Ziel ist es, die GPU-Pausenzeit während des Checkpointing zu minimieren und die Häufigkeit des Checkpointing zu erhöhen, um die Menge der nach der Wiederherstellung verlorenen Arbeit zu reduzieren.

Vernetzung: Der Llama 3 405B verwendet eine RDMA over Converged Ethernet (RoCE)-Architektur, die auf den Rack-Switches Arista 7800 und Minipack2 des Open Compute Project (OCP) basiert. Kleinere Modelle der Llama 3-Serie wurden mit dem Nvidia Quantum2 Infiniband-Netzwerk trainiert. Sowohl die RoCE- als auch die Infiniband-Cluster nutzen eine 400-Gbit/s-Verbindung zwischen den GPUs. Trotz der Unterschiede in der zugrundeliegenden Netzwerktechnologie dieser Cluster haben wir beide so abgestimmt, dass sie eine gleichwertige Leistung bieten, um diese großen Trainingslasten zu bewältigen. Wir werden unser RoCE-Netzwerk weiter ausbauen, sobald wir die volle Verantwortung für sein Design übernommen haben.

- Netzwerktopologie: Unser RoCE-basierter KI-Cluster umfasst 24.000 Grafikprozessoren (Fußnote 5), die über ein dreistufiges Clos-Netzwerk verbunden sind (Lee et al., 2024). Auf der untersten Ebene beherbergt jedes Rack 16 GPUs, die zwei Servern zugeordnet und über einen einzigen Minipack2-Top-of-Rack-Switch (ToR) verbunden sind. Auf der mittleren Ebene sind 192 dieser Racks über Cluster-Switches verbunden, um einen Pod mit 3 072 GPUs mit voller bidirektionaler Bandbreite zu bilden, so dass eine Überzeichnung ausgeschlossen ist. Auf der obersten Ebene werden acht solcher Pods innerhalb desselben Rechenzentrumsgebäudes über Aggregations-Switches zu einem Cluster mit 24.000 GPUs verbunden. Anstatt jedoch die volle bidirektionale Bandbreite aufrechtzuerhalten, haben die Netzwerkverbindungen auf der Aggregationsschicht eine Überbelegungsrate von 1:7. Sowohl unser modellparalleler Ansatz (siehe Abschnitt 3.3.2) als auch der Scheduler für die Trainingsaufgaben (Choudhury et al., 2024) sind so optimiert, dass sie die Netzwerktopologie berücksichtigen, um die Netzwerkkommunikation zwischen den Pods zu minimieren.

- Lastausgleich: Das Training großer Sprachmodelle erzeugt einen hohen Netzwerkverkehr, der mit herkömmlichen Methoden wie dem Equal Cost Multipath (ECMP) Routing nur schwer auf alle verfügbaren Netzwerkpfade verteilt werden kann. Um diese Herausforderung zu bewältigen, setzen wir zwei Techniken ein. Erstens erzeugt unsere Aggregatbibliothek 16 Netzwerkflüsse zwischen zwei GPUs anstelle von einem, wodurch der Datenverkehr pro Fluss reduziert wird und mehr Flüsse für den Lastausgleich zur Verfügung stehen. Zweitens gleicht unser Enhanced ECMP (E-ECMP)-Protokoll diese 16 Ströme effektiv über verschiedene Netzwerkpfade aus, indem es andere Felder im RoCE-Header-Paket hasht.

- Staukontrolle: Wir verwenden Deep-Buffer-Switches (Gangidi et al., 2024) im Backbone-Netz, um vorübergehende Überlastungen und Pufferungen, die durch aggregierte Kommunikationsmuster verursacht werden, auszugleichen. Dies trägt dazu bei, die Auswirkungen anhaltender Überlastungen und des durch langsame Server verursachten Netzrückstaus zu begrenzen, was bei Schulungen häufig der Fall ist. Schließlich verringert eine bessere Lastverteilung durch E-ECMP die Wahrscheinlichkeit von Überlastungen erheblich. Mit diesen Optimierungen konnten wir einen Cluster mit 24.000 GPUs erfolgreich betreiben, ohne dass herkömmliche Staukontrollmethoden wie die Data Center Quantified Congestion Notification (DCQCN) erforderlich waren.

3.3.2 Parallelität bei der Modellskalierung

Um das Training unseres größten Modells zu skalieren, haben wir das Modell mit 4D-Parallelität gesplittet - ein Schema, das vier verschiedene parallele Ansätze kombiniert. Dieser Ansatz verteilt die Berechnungen effektiv auf viele GPUs und stellt sicher, dass die Modellparameter, Optimierungszustände, Gradienten und Aktivierungswerte jeder GPU in ihren HBM passen. Unsere parallele 4D-Implementierung (wie in et al. (2020); Ren et al. (2021); Zhao et al. (2023b) gezeigt) unterteilt das Modell, den Optimierer und den Gradienten und implementiert gleichzeitig Datenparallelität, die die Daten parallel auf mehreren GPUs verarbeitet und sie nach jedem Trainingsschritt synchronisiert. Wir verwenden FSDP, um den Zustand des Optimierers und den Gradienten für Llama 3 zu slicen, aber für das Modell-Slicing schneiden wir nach der Vorwärtsberechnung nicht erneut, um zusätzliche Full-Collection-Kommunikation während des Reverse-Passes zu vermeiden.

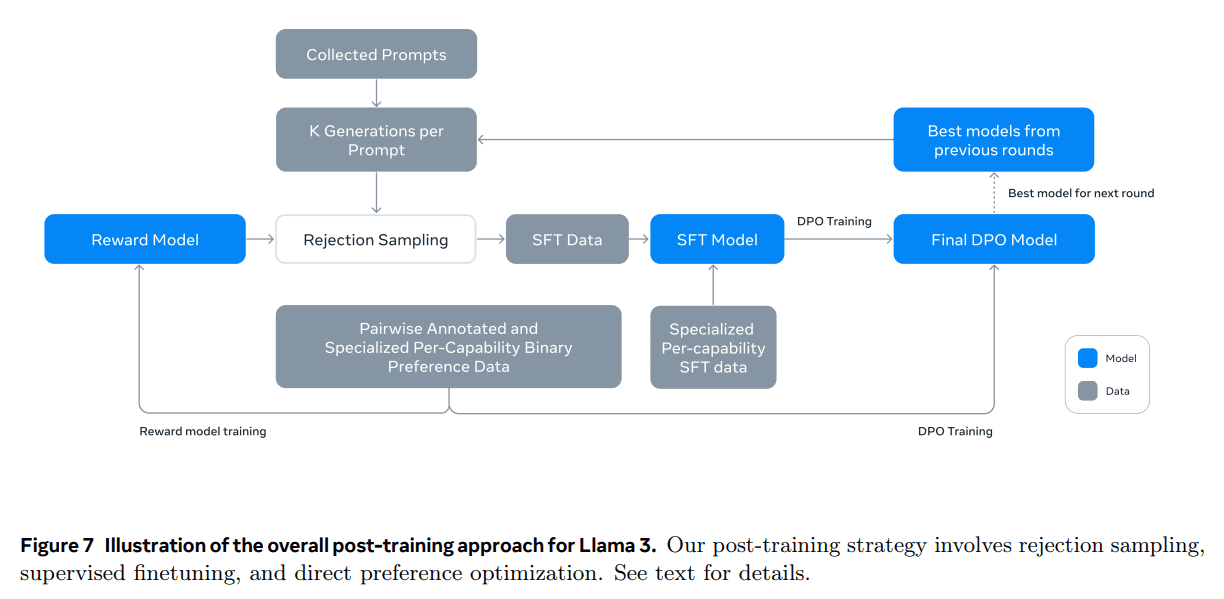

GPU-Nutzung.Durch sorgfältige Abstimmung der parallelen Konfiguration, der Hardware und der Software erreichen wir eine BF16-Modell-FLOPs-Auslastung (MFU; Chowdhery et al. (2023)) von 38-43%. Die in Tabelle 4 dargestellten Konfigurationen zeigen, dass im Vergleich zu 43% auf 8K-GPUs und DP=64 der Rückgang der MFU auf 41% auf 16K-GPUs und DP=128 auf die Notwendigkeit zurückzuführen ist, die Stapelgröße jeder DP-Gruppe zu reduzieren, um die Anzahl der globalen Marker während des Trainings konstant zu halten. 41% ist auf die Notwendigkeit zurückzuführen, die Stapelgröße jeder DP-Gruppe zu reduzieren, um die Anzahl der globalen Token während des Trainings konstant zu halten.

Rationalisierung paralleler Verbesserungen.Bei unserer bisherigen Umsetzung sind wir auf mehrere Herausforderungen gestoßen:

- Beschränkungen der Chargengröße.Aktuelle Implementierungen begrenzen die pro GPU unterstützte Stapelgröße, die durch die Anzahl der Pipelinestufen teilbar sein muss. Für das Beispiel in Abb. 6 erfordert die Pipeline-Parallelität für das Depth-First-Scheduling (DFS) (Narayanan et al. (2021)) N = PP = 4, während das Breadth-First-Scheduling (BFS; Lamy-Poirier (2023)) N = M erfordert, wobei M die Gesamtzahl der Mikrobatches und N die Anzahl der aufeinanderfolgenden Mikrobatches in derselben Stufe in Vorwärts- oder Rückwärtsrichtung ist. Die Vorschulung erfordert jedoch in der Regel Flexibilität bei der Chargengrößenbestimmung.

- Ungleichgewicht im Gedächtnis.Bestehende parallele Implementierungen mit Pipelines führen zu einem unausgewogenen Ressourcenverbrauch. Die erste Stufe verbraucht aufgrund der Einbettung und Erwärmung von Mikrobatches mehr Speicher.

- Die Berechnungen sind nicht ausgeglichen. Nach der letzten Schicht des Modells müssen wir die Ausgänge und Verluste berechnen, was diese Phase zu einem Engpass in Bezug auf die Ausführungslatenz macht. wobei Di der Index der i-ten parallelen Dimension ist. In diesem Beispiel sind GPU0[TP0, CP0, PP0, DP0] und GPU1[TP1, CP0, PP0, DP0] in derselben TP-Gruppe, GPU0 und GPU2 in derselben CP-Gruppe, GPU0 und GPU4 in derselben PP-Gruppe und GPU0 und GPU8 in derselben DP-Gruppe.

Um diese Probleme zu lösen, haben wir den in Abbildung 6 dargestellten Ansatz der Pipeline-Planung geändert, der eine flexible Einstellung von N - in diesem Fall N = 5 - ermöglicht, so dass in jeder Charge eine beliebige Anzahl von Mikrochargen ausgeführt werden kann. Dies ermöglicht es uns:

(1) Wenn es eine Chargengrößenbegrenzung gibt, werden weniger Mikrochargen als die Anzahl der Stufen ausgeführt; oder

(2) Führen Sie mehr Mikrostapel aus, um die Peer-to-Peer-Kommunikation zu verbergen und die beste Kommunikations- und Speichereffizienz zwischen Depth-First Scheduling (DFS) und Breadth-First Scheduling (BFS) zu finden. Um die Pipeline auszubalancieren, reduzieren wir jeweils eine Transformer-Schicht in der ersten und letzten Stufe. Das bedeutet, dass der erste Modellblock auf der ersten Stufe nur die Einbettungsschicht enthält, während der letzte Modellblock auf der letzten Stufe nur die Ausgangsprojektion und die Verlustberechnung enthält.

Um Pipeline-Blasen zu reduzieren, verwenden wir einen Ansatz zur verschachtelten Planung (Narayanan et al., 2021) in einer Pipeline-Hierarchie mit V Pipeline-Stufen. Das gesamte Pipeline-Blasenverhältnis ist PP-1 V * M . Darüber hinaus verwenden wir asynchrone Peer-to-Peer-Kommunikation, die das Training erheblich beschleunigt, insbesondere in Fällen, in denen Dokumentenmasken zusätzliche rechnerische Ungleichgewichte verursachen. Wir aktivieren TORCH_NCCL_AVOID_RECORD_STREAMS, um die Speichernutzung durch asynchrone Peer-to-Peer-Kommunikation zu reduzieren. Um schließlich die Speicherkosten zu senken, geben wir auf der Grundlage einer detaillierten Analyse der Speicherzuweisung proaktiv Tensoren frei, die nicht für zukünftige Berechnungen verwendet werden, einschließlich Eingabe- und Ausgabetensoren für jede Pipelinestufe. ** Mit diesen Optimierungen sind wir in der Lage, die 8K-Tensoren ohne Aktivierungsprüfpunkte auszuführen, ohne Aktivierungsprüfpunkte. Token Sequenzen für die Llama 3-Vorschulung.

Die Kontextparallelisierung wird für lange Sequenzen verwendet. Wir nutzen die Kontextparallelisierung (CP), um die Speichereffizienz bei der Skalierung der Llama-3-Kontextlängen zu verbessern und das Training auf sehr langen Sequenzen mit bis zu 128K Länge zu ermöglichen. Bei CP partitionieren wir über die Sequenzdimensionen hinweg, d. h. wir teilen die Eingabesequenz in 2 × CP-Blöcke auf, so dass jede CP-Ebene zwei Blöcke erhält, um eine bessere Lastverteilung zu erreichen. Die i-te CP-Ebene erhält den i-ten und (2 × CP -1 -i) Blöcke.

Im Gegensatz zu bestehenden CP-Implementierungen, bei denen sich Kommunikation und Berechnung in einer Ringstruktur überschneiden (Liu et al., 2023a), verwendet unsere CP-Implementierung einen All-Gather-basierten Ansatz, bei dem zunächst Schlüssel-Wert-Tensoren (K, V) global aggregiert werden und dann die Aufmerksamkeitsausgaben eines Blocks lokaler Abfragetensoren (Q) berechnet werden. Obwohl die All-Gather-Kommunikationslatenz auf dem kritischen Pfad liegt, wählen wir diesen Ansatz aus zwei Hauptgründen:

(1) Es ist einfacher und flexibler, verschiedene Arten von Aufmerksamkeitsmasken, wie z. B. Dokumentenmasken, in der allumfassenden CP-Aufmerksamkeit zu unterstützen;

(2) Die exponierte All-Gather-Latenzzeit ist klein, weil der K- und V-Tensor der Kommunikation aufgrund der Verwendung von GQA viel kleiner ist als der Q-Tensor (Ainslie et al., 2023). Infolgedessen ist die Zeitkomplexität der Aufmerksamkeitsberechnung um eine Größenordnung größer als die von All-Gather (O(S²) gegenüber O(S), wobei S die Länge der Sequenz in der vollständigen Kausalmaske bezeichnet), wodurch der All-Gather-Overhead vernachlässigbar ist.

Netzwerkfähige, parallelisierte Konfiguration.Die Reihenfolge der Parallelisierungsdimensionen [TP, CP, PP, DP] ist für die Netzkommunikation optimiert. Die innerste Schicht der Parallelisierung erfordert die höchste Netzbandbreite und die geringste Latenz und ist daher in der Regel auf denselben Server beschränkt. Die äußerste Parallelisierungsschicht kann sich über Multi-Hop-Netze erstrecken und sollte eine höhere Netzlatenz tolerieren können. Daher ordnen wir die Parallelisierungsdimensionen auf der Grundlage der Anforderungen an die Netzwerkbandbreite und -latenz in der Reihenfolge [TP, CP, PP, DP] ein. DP (d. h. FSDP) ist die äußerste Parallelisierungsschicht, da sie eine längere Netzwerklatenz tolerieren kann, indem sie die Gewichte des Slicing-Modells asynchron vorab abruft und den Gradienten reduziert. Die Bestimmung der optimalen Parallelisierungskonfiguration mit minimalem Kommunikations-Overhead bei gleichzeitiger Vermeidung eines GPU-Speicherüberlaufs ist eine Herausforderung. Wir haben einen Schätzer für den Speicherverbrauch und ein Tool zur Leistungsprojektion entwickelt, mit dem wir verschiedene Parallelisierungskonfigurationen untersuchen, die Gesamttrainingsleistung vorhersagen und Speicherlücken effizient identifizieren konnten.

Numerische Stabilität.Durch den Vergleich der Trainingsverluste zwischen verschiedenen parallelen Einstellungen beheben wir einige numerische Probleme, die die Trainingsstabilität beeinträchtigen. Um die Trainingskonvergenz zu gewährleisten, verwenden wir FP32-Gradientenakkumulation während der Rückwärtsberechnung mehrerer Mikrostapel und reduzieren die Streuung der Gradienten mit FP32 zwischen datenparallelen Arbeitern in FSDP. Für Zwischentensoren, die mehrfach in Vorwärtsberechnungen verwendet werden, wie z. B. visuelle Codierausgaben, wird der Rückwärtsgradient ebenfalls in FP32 akkumuliert.

3.3.3 Kollektive Kommunikation

Die kollektive Kommunikationsbibliothek von Llama 3 basiert auf einem Zweig von Nvidias NCCL-Bibliothek namens NCCLX. NCCLX verbessert die Leistung von NCCL erheblich, insbesondere für Netzwerke mit hoher Latenz. Die Reihenfolge der parallelen Dimensionen ist [TP, CP, PP, DP], wobei DP dem FSDP entspricht, und die äußersten parallelen Dimensionen, PP und DP, können über ein Multi-Hop-Netzwerk mit Latenzen im Bereich von zehn Mikrosekunden kommunizieren. Die kollektiven Kommunikationsoperationen "all-gather" und "reduce-scatter" der ursprünglichen NCCL werden in FSDP verwendet, während für PP eine Punkt-zu-Punkt-Kommunikation verwendet wird, die Daten-Chunking und stufenweise Datenreplikation erfordert. Dieser Ansatz führt zu einigen der folgenden Ineffizienzen:

- Zur Erleichterung der Datenübertragung muss eine große Anzahl kleiner Kontrollmeldungen über das Netz ausgetauscht werden;

- Zusätzliche Speicherkopiervorgänge;

- Verwenden Sie zusätzliche GPU-Zyklen für die Kommunikation.

Für das Llama 3-Training beheben wir einige dieser Ineffizienzen, indem wir das Chunking und die Datenübertragungen an unsere Netzwerklatenz anpassen, die in großen Clustern bis zu zehn Mikrosekunden betragen kann. Außerdem lassen wir zu, dass kleine Kontrollnachrichten unser Netzwerk mit höherer Priorität durchlaufen, um insbesondere Head-of-Queue-Blockierungen in tief gepufferten Core-Switches zu vermeiden.

Unsere laufenden Arbeiten für zukünftige Versionen von Llama beinhalten tiefgreifende Änderungen an NCCLX, um alle oben genannten Probleme vollständig zu lösen.

3.3.4 Zuverlässigkeit und betriebliche Herausforderungen

Die Komplexität und die möglichen Fehlerszenarien des 16K-GPU-Trainings übersteigen die der größeren CPU-Cluster, mit denen wir gearbeitet haben. Außerdem ist das Training aufgrund seiner synchronen Natur weniger fehlertolerant - ein einziger GPU-Ausfall kann einen Neustart des gesamten Auftrags erfordern. Trotz dieser Herausforderungen erreichten wir für Llama 3 effektive Trainingszeiten von mehr als 90% und unterstützten gleichzeitig die automatische Clusterwartung (z. B. Firmware- und Linux-Kernel-Upgrades (Vigraham und Leonhardi, 2024)), was zu mindestens einem Trainingsausfall pro Tag führte.

Die effektive Schulungszeit ist die Zeit, die während der verstrichenen Zeit für die effektive Schulung aufgewendet wurde. Während der 54-tägigen Momentaufnahme vor dem Training gab es insgesamt 466 Betriebsausfälle. Davon waren 47 geplante Unterbrechungen aufgrund automatischer Wartungsarbeiten (z. B. Firmware-Upgrades oder vom Bediener initiierte Arbeiten wie Konfigurations- oder Datensatzaktualisierungen). Die restlichen 419 waren unvorhergesehene Ausfälle, die in Tabelle 5 kategorisiert sind. Etwa 78% der unvorhergesehenen Ausfälle waren auf festgestellte Hardwareprobleme zurückzuführen, wie z. B. Ausfälle von GPU- oder Host-Komponenten, oder auf vermutete hardwarebezogene Probleme, wie z. B. stille Datenverfälschungen und ungeplante individuelle Host-Wartungsereignisse.GPU-Probleme stellten mit 58,7% aller unvorhergesehenen Probleme die größte Kategorie dar.Trotz der großen Anzahl von Ausfällen waren in diesem Zeitraum nur drei größere manuelle Trotz der großen Anzahl von Ausfällen waren in diesem Zeitraum nur drei größere manuelle Eingriffe erforderlich, und die übrigen Probleme wurden durch Automatisierung gelöst.

Um die effektive Trainingszeit zu verbessern, haben wir die Zeit für das Starten von Jobs und das Checkpointing reduziert und Werkzeuge für eine schnelle Diagnose und Problemlösung entwickelt. Wir nutzten ausgiebig den in PyTorch eingebauten NCCL Flight Recorder (Ansel et al., 2024) - eine Funktion, die kollektive Metadaten und Stack Traces in einem Ringpuffer aufzeichnet, was uns eine schnelle Diagnose von Hängern und Leistungsproblemen im großen Maßstab ermöglicht, insbesondere im Fall von NCCLX-Aspekten. Mit dieser Funktion können wir Kommunikationsereignisse und -dauer für jede kollektive Operation effizient protokollieren und im Falle eines NCCLX-Watchdog- oder Heartbeat-Timeouts automatisch Tracedaten ausgeben. Mit Online-Konfigurationsänderungen (Tang et al., 2015) können wir selektiv rechenintensivere Trace-Operationen und die Sammlung von Metadaten aktivieren, ohne dass der Code freigegeben oder der Job neu gestartet werden muss. Das Debuggen von Problemen in großen Trainings wird durch die Mischung aus NVLink und RoCE in unserem Netzwerk erschwert. Datenübertragungen werden typischerweise über NVLink mittels Load/Store-Operationen durchgeführt, die vom CUDA-Kernel ausgegeben werden, und der Ausfall einer entfernten GPU oder NVLink-Verbindung manifestiert sich oft als blockierte Load/Store-Operation im CUDA-Kernel, ohne dass ein expliziter Fehlercode zurückgegeben wird.NCCLX verbessert die Geschwindigkeit und Genauigkeit der Fehlererkennung und -lokalisierung, indem es eng mit PyTorch zusammenarbeitet, so dass PyTorch kann auf den internen Zustand von NCCLX zugreifen und relevante Informationen verfolgen. Es ist zwar nicht möglich, einen Stillstand aufgrund von NVLink-Fehlern vollständig zu verhindern, aber unser System überwacht den Zustand der Kommunikationsbibliotheken und schaltet automatisch ab, wenn ein solcher Stillstand erkannt wird. Darüber hinaus verfolgt NCCLX die Kernel- und Netzwerkaktivitäten jeder NCCLX-Kommunikation und liefert eine Momentaufnahme des internen Zustands des fehlerhaften NCCLX-Kollektivs, einschließlich abgeschlossener und nicht abgeschlossener Datenübertragungen zwischen allen Ranks. Wir analysieren diese Daten, um Probleme mit der NCCLX-Erweiterung zu beheben.

Manchmal können Hardwareprobleme zu noch laufenden, aber langsamen Nachzüglern führen, die schwer zu erkennen sind. Selbst wenn es nur einen Nachzügler gibt, kann er Tausende anderer GPUs verlangsamen, oft in Form von normalem Betrieb, aber langsamer Kommunikation. Wir haben Tools entwickelt, mit denen sich potenziell problematische Kommunikationen von ausgewählten Prozessgruppen priorisieren lassen. Indem wir nur einige wenige Hauptverdächtige untersuchen, können wir Nachzügler oft effektiv identifizieren.

Eine interessante Beobachtung ist der Einfluss von Umgebungsfaktoren auf die Trainingsleistung in großem Maßstab. Beim Llama 3 405B haben wir Durchsatzschwankungen von 1-2% in Abhängigkeit von der Zeit festgestellt. Diese Fluktuation wird durch höhere Mittagstemperaturen verursacht, die die dynamische Spannungs- und Frequenzskalierung der GPU beeinflussen. Während des Trainings können Zehntausende von GPUs gleichzeitig den Stromverbrauch erhöhen oder senken, z. B. weil alle GPUs darauf warten, dass ein Checkpoint oder eine kollektive Kommunikation beendet wird oder dass ein ganzer Trainingsjob beginnt oder beendet wird. Wenn dies geschieht, kann es zu vorübergehenden Schwankungen des Stromverbrauchs im Rechenzentrum in der Größenordnung von einigen zehn Megawatt kommen, was die Grenzen des Stromnetzes ausreizt. Dies ist eine ständige Herausforderung, da wir das Training für zukünftige und noch größere Llama-Modelle skalieren.

3.4 Ausbildungsprogramme

Das Vorschulungsrezept für Llama 3 405B enthält drei Hauptstufen:

(1) anfängliches Pre-Training, (2) Pre-Training mit langem Kontext und (3) Annealing. Jeder dieser drei Schritte wird im Folgenden beschrieben. Für das Pre-Training der 8B- und 70B-Modelle verwenden wir ähnliche Rezepte.

3.4.1 Erste Vorschulung

Wir haben das Modell Llama 3 405B mit einem Kosinus-Lernratenschema mit einer maximalen Lernrate von 8 × 10-⁵ vortrainiert, linear auf 8.000 Schritte aufgewärmt und nach 1.200.000 Trainingsschritten auf 8 × 10-⁷ abklingen lassen. Um die Stabilität des Trainings zu verbessern, verwenden wir zu Beginn des Trainings eine kleinere Losgröße und erhöhen anschließend die Losgröße, um die Effizienz zu verbessern. Konkret haben wir anfangs eine Stapelgröße von 4M Token und eine Sequenzlänge von 4.096. Nach dem Vortraining von 252M Token verdoppeln wir die Stapelgröße und die Sequenzlänge auf 8M Sequenzen bzw. 8.192 Token. Nach dem Vortraining von 2,87T Token verdoppeln wir erneut die Stapelgröße auf 16M. Wir haben festgestellt, dass Diese Trainingsmethode ist sehr stabil: Es treten nur sehr wenige Verlustspitzen auf, und es ist kein Eingreifen erforderlich, um Abweichungen beim Modelltraining zu korrigieren.

Anpassung der Datenkombinationen. Während des Trainings haben wir mehrere Anpassungen an der Datenkombination vor dem Training vorgenommen, um die Leistung des Modells bei bestimmten nachgelagerten Aufgaben zu verbessern. Insbesondere haben wir den Anteil der nicht-englischen Daten während des Vortrainings erhöht, um die mehrsprachige Leistung von Llama 3 zu verbessern. Außerdem haben wir den Anteil der mathematischen Daten erhöht, um das mathematische Denken des Modells zu verbessern, in den späteren Phasen des Vortrainings neuere Netzwerkdaten hinzugefügt, um die Wissensabgrenzungen des Modells zu aktualisieren, und den Anteil einer Teilmenge der Daten, die später als von geringerer Qualität identifiziert wurde, verringert.

3.4.2 Vorschulung im langen Kontext

In der letzten Phase des Vortrainings trainieren wir lange Sequenzen, um Kontextfenster von bis zu 128.000 Token zu unterstützen. Wir trainieren lange Sequenzen nicht früher, da die Berechnungen in der Selbstbeobachtungsschicht quadratisch mit der Sequenzlänge wachsen. Wir erhöhen schrittweise die unterstützte Kontextlänge und führen ein Pre-Training durch, nachdem sich das Modell erfolgreich an die erhöhte Kontextlänge angepasst hat. Wir bewerten die erfolgreiche Anpassung, indem wir beides messen:

(1) Ob die Leistung des Modells bei Kurzkontextbewertungen vollständig wiederhergestellt wurde;

(2) Ob das Modell die Aufgabe "Nadel im Heuhaufen" bis zu dieser Länge perfekt lösen kann. Beim Vortraining von Llama 3 405B haben wir die Länge des Kontextes in sechs Stufen schrittweise erhöht, beginnend mit einem anfänglichen Kontextfenster von 8.000 Token und schließlich bis zu einem Kontextfenster von 128.000 Token. In dieser langen Kontext-Vorübungsphase wurden ca. 800 Milliarden Trainings-Token verwendet.

3.4.3 Glühen

Während des Vortrainings der letzten 40 Mio. Token haben wir die Lernrate linear auf 0 geglättet und dabei eine Kontextlänge von 128K Token beibehalten. Während dieser Annealing-Phase passen wir auch den Datenmix an, um die Stichprobengröße der sehr hochwertigen Datenquellen zu erhöhen; siehe Abschnitt 3.1.3. Schließlich berechneten wir den Durchschnitt der Modellprüfpunkte (Polyak (1991) Durchschnitt) während des Annealings, um das endgültige vortrainierte Modell zu erstellen.

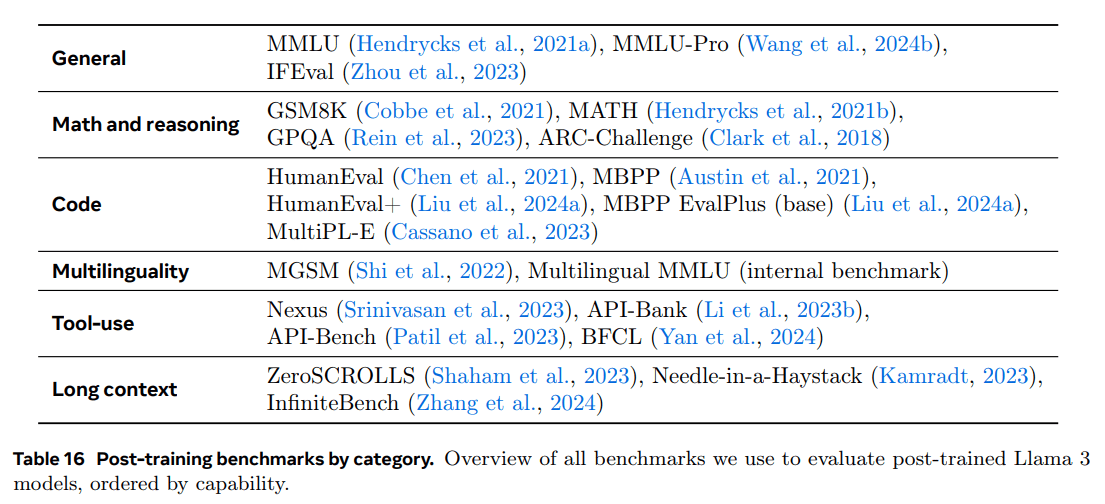

4 Nachschulung

Wir generieren und alignieren Llama-3-Modelle, indem wir mehrere Runden von Follow-up-Training durchführen. Diese Folgetrainings basieren auf vortrainierten Kontrollpunkten und beziehen menschliches Feedback für die Modellanpassung mit ein (Ouyang et al., 2022; Rafailov et al., 2024). Jede Runde des Folgetrainings bestand aus einer überwachten Feinabstimmung (SFT), gefolgt von einer direkten Präferenzoptimierung (DPO; Rafailov et al., 2024) unter Verwendung von Beispielen, die durch manuelle Annotation oder Synthese generiert wurden. In den Abschnitten 4.1 und 4.2 beschreiben wir unsere anschließende Trainingsmodellierung und unsere Datenmethoden. Darüber hinaus geben wir in Abschnitt 4.3 weitere Einzelheiten zu den Strategien für die kundenspezifische Datensammlung an, um das Modell in Bezug auf Inferenz, Programmierfähigkeiten, Faktorisierung, mehrsprachige Unterstützung, Werkzeugnutzung, lange Kontexte und genaue Einhaltung von Anweisungen zu verbessern.

4.1 Modellierung

Die Grundlage unserer Post-Training-Strategie bilden ein Belohnungsmodell und ein Sprachmodell. Zunächst trainieren wir ein Belohnungsmodell auf den Pre-Training-Kontrollpunkten mit von Menschen gelabelten Präferenzdaten (siehe Abschnitt 4.1.2). Anschließend erfolgt eine Feinabstimmung der Pre-Training-Checkpoints mit Supervised Fine-Tuning (SFT; siehe Abschnitt 4.1.3) und ein weiterer Abgleich mit den Checkpoints mit Hilfe von Direct Preference Optimization (DPO; siehe Abschnitt 4.1.4). Dieser Prozess ist in Abbildung 7 dargestellt. Sofern nicht anders angegeben, gilt unser Modellierungsprozess für Llama 3 405B, das wir der Einfachheit halber als Llama 3 405B bezeichnen.

4.1.1 Format des Chat-Dialogs

Um ein Large Language Model (LLM) für die Mensch-Computer-Interaktion anzupassen, müssen wir ein Chat-Dialogprotokoll definieren, das es dem Modell ermöglicht, menschliche Befehle zu verstehen und Dialogaufgaben auszuführen. Im Vergleich zu seinem Vorgänger hat Llama 3 neue Funktionen, wie z.B. die Verwendung von Werkzeugen (Abschnitt 4.3.5), die es erforderlich machen können, mehrere Nachrichten in einer einzigen Dialogrunde zu erzeugen und sie an verschiedene Stellen zu senden (z.B. Benutzer, ipython). Um dies zu unterstützen, haben wir ein neues Chat-Protokoll für mehrere Nachrichten entwickelt, das eine Reihe von speziellen Header- und Terminierungs-Tokens verwendet. Header-Token werden verwendet, um die Quelle und das Ziel jeder Nachricht in einem Dialog anzugeben. Ebenso zeigen Beendigungsmarkierungen an, wann der Mensch und die KI an der Reihe sind, abwechselnd zu sprechen.

4.1.2 Belohnungsmodellierung

Wir haben ein Belohnungsmodell (RM) trainiert, das verschiedene Fähigkeiten abdeckt, und es auf vortrainierten Kontrollpunkten aufgebaut. Das Trainingsziel ist das gleiche wie in Llama 2, aber wir entfernen den marginalen Term in der Verlustfunktion, da wir eine geringere Verbesserung mit zunehmender Datenmenge beobachten. Wie in Llama 2 verwenden wir alle Präferenzdaten für die Belohnungsmodellierung, nachdem wir Proben mit ähnlichen Antworten herausgefiltert haben.

Zusätzlich zu den Standard-Präferenzpaaren (ausgewählt, abgelehnt) wird bei einigen Stichwörtern eine dritte "bearbeitete Antwort" erstellt, bei der die aus dem Paar ausgewählte Antwort zur Verbesserung weiter bearbeitet wird (siehe Abschnitt 4.2.1). Somit gibt es in jeder Stichprobe für die Präferenzsortierung zwei oder drei Antworten, die eine klare Rangfolge aufweisen (bearbeitet > ausgewählt > abgelehnt). Während des Trainings haben wir die Stichwörter und Mehrfachantworten in einer Zeile zusammengefasst und die Antworten randomisiert. Dies ist eine Annäherung an das Standardszenario, bei dem die Antworten in separaten Zeilen angeordnet werden, aber in unseren Ablationsexperimenten verbessert dieser Ansatz die Trainingseffizienz ohne Präzisionsverlust.

4.1.3 Feinabstimmung der Überwachung

Menschlich markierte Hinweise werden zunächst mit Hilfe des Belohnungsmodells, dessen detaillierte Methodik in Abschnitt 4.2 beschrieben wird, für die Stichprobe zurückgewiesen. Wir kombinieren diese zurückgewiesenen Daten mit anderen Datenquellen (einschließlich synthetischer Daten), um das vortrainierte Sprachmodell mit Hilfe von Standard-Cross-Entropie-Verlusten zu verfeinern, mit dem Ziel, die Zielmarkierung vorherzusagen (und dabei die Verluste aus der markierten Markierung zu maskieren). Siehe Abschnitt 4.2 für weitere Details zum Data Blending. Obwohl viele der Trainingsziele durch das Modell generiert werden, bezeichnen wir diese Phase als überwachte Feinabstimmung (SFT; Wei et al. 2022a; Sanh et al. 2022; Wang et al. 2022b).

Unser maximales Modell wird mit einer Lernrate von 1e-5 innerhalb von 8,5K bis 9K Schritten feinabgestimmt. Wir haben festgestellt, dass diese Hyperparametereinstellungen für verschiedene Runden und Datenmischungen geeignet sind.

4.1.4 Direkte Präferenzoptimierung

Wir haben unsere SFT-Modelle für den Abgleich menschlicher Präferenzen mithilfe der direkten Präferenzoptimierung (DPO; Rafailov et al., 2024) weiter trainiert. Für das Training verwenden wir hauptsächlich die neuesten Präferenzdaten, die von den leistungsstärksten Modellen der vorherigen Abgleichsrunde gesammelt wurden. Dadurch stimmen unsere Trainingsdaten besser mit der Verteilung der optimierten Strategiemodelle in jeder Runde überein. Wir haben auch Strategiealgorithmen wie PPO (Schulman et al., 2017) untersucht, aber festgestellt, dass DPO weniger Berechnungen erfordert und bei großen Modellen besser abschneidet, insbesondere bei Benchmarks zur Befolgung von Anweisungen wie IFEval (Zhou et al., 2023).

Für Llama 3 verwendeten wir eine Lernrate von 1e-5 und setzten den Hyperparameter β auf 0,1. Zusätzlich haben wir die folgenden algorithmischen Änderungen an DPO vorgenommen:

- Maskierung von Formatierungsmarkierungen in DPO-Verlusten. Wir maskieren spezielle Formatmarker (einschließlich der in Abschnitt 4.1.1 beschriebenen Header- und Terminationsmarker) aus den ausgewählten und abgelehnten Antworten, um das DPO-Training zu stabilisieren. Wir stellen fest, dass die Einbeziehung dieser Marker in den Verlust zu unerwünschtem Modellverhalten führen kann, wie z. B. Schwanzverdopplung oder plötzliche Erzeugung von Terminationsmarkern. Wir stellen die Hypothese auf, dass dies auf die gegensätzliche Natur des DPO-Verlustes zurückzuführen ist - das Vorhandensein gemeinsamer Marker sowohl in ausgewählten als auch in abgelehnten Antworten kann zu widersprüchlichen Lernzielen führen, da das Modell die Wahrscheinlichkeit dieser Marker gleichzeitig erhöhen und verringern muss.

- Regularisierung mit NLL-Verlusten: die Ähnlich wie Pang et al. (2024) fügten wir den ausgewählten Sequenzen einen zusätzlichen Verlustterm der negativen Log-Likelihood (NLL) mit einem Skalierungsfaktor von 0,2 hinzu. Dies trägt zur weiteren Stabilisierung des DPO-Trainings bei, indem das für die Generierung erforderliche Format beibehalten wird und verhindert wird, dass die Log-Wahrscheinlichkeit der ausgewählten Antworten abnimmt (Pang et al., 2024; Pal et al., 2024).

4.1.5 Modell-Mittelwertbildung

Schließlich haben wir die Modelle aus Experimenten mit verschiedenen Datenversionen oder Hyperparametern in jeder RM-, SFT- oder DPO-Stufe gemittelt (Izmailov et al. 2019; Wortsman et al. 2022; Li et al. 2022). Wir präsentieren statistische Informationen zu den intern erhobenen menschlichen Präferenzdaten, die für die Konditionierung von Llama 3 verwendet wurden. Wir baten die Bewerter, sich in mehreren Dialogrunden mit dem Modell zu unterhalten, und verglichen die Antworten aus jeder Runde. Bei der Nachbearbeitung teilten wir jeden Dialog in mehrere Beispiele auf, die jeweils eine Aufforderung (einschließlich des vorherigen Dialogs, falls verfügbar) und eine Antwort (z. B. eine Antwort, die ausgewählt oder abgelehnt wurde) enthielten.

4.1.6 Iterationsrunden

In Anlehnung an Llama 2 haben wir die oben beschriebene Methodik in sechs Iterationsrunden angewandt. In jeder Runde haben wir neue Daten zur Präferenzkennzeichnung und Feinabstimmung (SFT) gesammelt und synthetische Daten aus dem letzten Modell entnommen.

4.2 Daten nach der Ausbildung

Die Zusammensetzung der Post-Training-Daten spielt eine entscheidende Rolle für den Nutzen und das Verhalten des Sprachmodells. In diesem Abschnitt werden unser Annotationsverfahren und die Erhebung von Präferenzdaten (Abschnitt 4.2.1), die Zusammensetzung der SFT-Daten (Abschnitt 4.2.2) und Methoden zur Datenqualitätskontrolle und -bereinigung (Abschnitt 4.2.3) erläutert.

4.2.1 Vorlieben

Unser Verfahren zur Kennzeichnung von Präferenzdaten ist ähnlich wie bei Llama 2. Nach jeder Runde setzen wir mehrere Modelle für die Annotation ein und nehmen zwei Antworten von verschiedenen Modellen für jeden Benutzerhinweis. Diese Modelle können mit verschiedenen Datenmischungs- und Ausrichtungsschemata trainiert werden, was zu unterschiedlichen Stärken (z. B. Code-Expertise) und einer größeren Datenvielfalt führt. Wir haben die Kommentatoren gebeten, ihre Präferenzbewertungen in eine von vier Stufen einzuordnen: deutlich besser, besser, etwas besser oder etwas besser.

Wir haben auch einen Bearbeitungsschritt nach der Präferenzordnung vorgesehen, um den Kommentator zu ermutigen, die bevorzugte Antwort weiter zu verfeinern. Der Kommentator kann entweder die ausgewählte Antwort direkt bearbeiten oder das Feedback-Cue-Modell verwenden, um seine eigene Antwort zu verfeinern. Infolgedessen haben einige Präferenzdaten drei sortierte Antworten (Bearbeiten > Auswählen > Ablehnen).

Die Präferenzstatistiken, die wir für das Training mit Llama 3 verwendet haben, sind in Tabelle 6 aufgeführt. Allgemeines Englisch umfasst mehrere Unterkategorien, wie z. B. wissensbasierte Fragen und Antworten oder präzises Befolgen von Anweisungen, die über den Rahmen der spezifischen Fähigkeiten hinausgehen. Im Vergleich zu Llama 2 beobachteten wir eine Zunahme der durchschnittlichen Länge von Prompts und Antworten, was darauf hindeutet, dass wir Llama 3 für komplexere Aufgaben trainieren. Darüber hinaus haben wir einen Qualitätsanalyse- und manuellen Evaluierungsprozess implementiert, um die gesammelten Daten kritisch zu bewerten, so dass wir die Prompts verfeinern und den Annotatoren systematisches, umsetzbares Feedback geben können. Wenn sich Llama 3 beispielsweise nach jeder Runde verbessert, werden wir die Komplexität der Hinweise entsprechend erhöhen, um Bereiche anzugehen, in denen das Modell hinterherhinkt.

In jeder späten Trainingsrunde verwenden wir für die Belohnungsmodellierung alle zu diesem Zeitpunkt verfügbaren Präferenzdaten und für das DPO-Training nur die jüngsten Chargen aus jeder Fähigkeit. Sowohl für die Belohnungsmodellierung als auch für den DPO trainieren wir mit Stichproben, die als "Auswahlreaktion deutlich besser oder besser" gekennzeichnet sind, und verwerfen Stichproben mit ähnlichen Antworten.

4.2.2 SFT-Daten

Unsere Daten für die Feinabstimmung stammen hauptsächlich aus den folgenden Quellen:

- Hinweise aus unserer manuell annotierten Sammlung und ihre Ablehnung von Stichprobenantworten

- Synthetische Daten für bestimmte Fähigkeiten (siehe Abschnitt 4.3 für Details)

- Geringe Menge an manuell beschrifteten Daten (siehe Abschnitt 4.3 für Details)

Im weiteren Verlauf unseres Post-Trainingszyklus entwickelten wir leistungsfähigere Varianten von Llama 3 und nutzten diese, um größere Datensätze zu sammeln, die ein breites Spektrum komplexer Fähigkeiten abdecken. In diesem Abschnitt werden die Details des Rejection Sampling-Prozesses und die Gesamtzusammensetzung der endgültigen SFT-Datenmischung erläutert.

Verweigerung der Probenahme.Beim Rejection Sampling (RS) werden für jeden Hinweis, den wir während der manuellen Annotation (Abschnitt 4.2.1) sammeln, K Ausgaben der letzten Chat-Modellierungsstrategie (typischerweise die besten Ausführungskontrollpunkte aus der letzten Post-Trainingsiteration oder die besten Ausführungskontrollpunkte für eine bestimmte Kompetenz) ausgewählt und unser Belohnungsmodell verwendet, um den besten Kandidaten auszuwählen, in Übereinstimmung mit Bai et al. (2022). In späteren Phasen des Nachtrainings führen wir Systemhinweise ein, um die Antworten der RS so zu lenken, dass sie einem gewünschten Ton, Stil oder Format entsprechen, das für verschiedene Fähigkeiten unterschiedlich sein kann.

Um die Effizienz des Rejection Sampling zu verbessern, setzen wir PagedAttention (Kwon et al., 2023) ein, das die Speichereffizienz durch dynamische Zuweisung von Schlüsselwerten im Cache verbessert. Es unterstützt beliebige Ausgabelängen durch dynamische Planung von Anforderungen auf der Grundlage der aktuellen Cache-Kapazität. Leider birgt dies das Risiko des Swapping, wenn der Speicher knapp wird. Um diesen Swapping-Overhead zu eliminieren, definieren wir eine maximale Ausgabelänge und führen Anfragen nur dann aus, wenn genügend Speicher für Ausgaben dieser Länge vorhanden ist. pagedAttention ermöglicht es uns auch, die angedeutete Schlüsselwert-Cache-Seite auf alle entsprechenden Ausgaben aufzuteilen. Insgesamt führte dies zu einer mehr als zweifachen Steigerung des Durchsatzes während der Ablehnungsproben.

Aggregierte Datenzusammensetzung.Tabelle 7 zeigt die Statistiken für jede der großen Datenkategorien in unserem "Nützlichkeits"-Mix. Obwohl die SFT- und Präferenzdaten sich überschneidende Bereiche enthalten, sind sie unterschiedlich kuratiert, was zu unterschiedlichen Zählstatistiken führt. In Abschnitt 4.2.3 werden die Techniken beschrieben, die zur Kategorisierung des Themas, der Komplexität und der Qualität unserer Datenproben verwendet werden. In jeder Runde des Post-Trainings stimmen wir unseren gesamten Datenmix sorgfältig ab, um die Leistung auf mehreren Achsen für eine breite Palette von Benchmarks anzupassen. Unsere endgültige Datenmischung wird für bestimmte hochwertige Quellen mehrfach wiederholt und für andere heruntergestuft.

4.2.3 Datenverarbeitung und Qualitätskontrolle

Da es sich bei den meisten unserer Trainingsdaten um modellgenerierte Daten handelt, ist eine sorgfältige Bereinigung und Qualitätskontrolle erforderlich.

Datenbereinigung: In der Anfangsphase stellten wir viele unerwünschte Muster in den Daten fest, wie etwa die übermäßige Verwendung von Emoticons oder Ausrufezeichen. Wir haben daher eine Reihe von regelbasierten Strategien zur Datenlöschung und -modifikation eingeführt, um problematische Daten zu filtern oder zu entfernen. Um z. B. das Problem der übermäßig entschuldigenden Intonation zu entschärfen, identifizierten wir übermäßig verwendete Phrasen (z. B. "Es tut mir leid" oder "Ich entschuldige mich") und glichen den Anteil solcher Muster im Datensatz sorgfältig aus.

Datenbeschneidung: Außerdem wenden wir eine Reihe von modellbasierten Techniken an, um minderwertige Trainingsmuster zu entfernen und die Gesamtleistung des Modells zu verbessern:

- Klassifizierung der Themen: Zunächst haben wir Llama 3 8B in einen Themenklassifikator umgewandelt und alle Daten in grobkörnige Kategorien ("Mathematisches Denken") und feinkörnige Kategorien ("Geometrie und Trigonometrie") eingeteilt.

- Bewertung der Qualität: Wir verwendeten das Reward-Modell und Llama-basierte Signale, um Qualitätsbewertungen für jede Probe zu erhalten. Für die RM-basierten Werte betrachteten wir Daten mit Werten im höchsten Quartil als hochqualitativ. Für die Llama-basierten Bewertungen haben wir die Llama-3-Kontrollpunkte dazu veranlasst, die allgemeinen englischen Daten auf drei Ebenen (Genauigkeit, Einhaltung der Anweisungen und Tonalität/Darstellung) und die Codedaten auf zwei Ebenen (Fehlererkennung und Benutzerabsicht) zu bewerten, und betrachteten die Proben, die die höchsten Punktzahlen erhielten, als hochwertige Daten. RM- und Llama-basierte Bewertungen haben hohe Konfliktraten, und wir fanden heraus, dass die Kombination dieser Signale die beste Wiedererkennung für die interne Testmenge ergab. Letztendlich wählen wir diejenigen Beispiele aus, die entweder von den RM- oder den Llama-basierten Filtern als hochwertig eingestuft werden.

- Schwierigkeitsgrad: Da wir auch daran interessiert waren, komplexere Modellbeispiele zu priorisieren, bewerteten wir die Daten anhand von zwei Schwierigkeitsmetriken: dem Instag (Lu et al., 2023) und dem Llama-basierten Scoring. Für Instag forderten wir Llama 3 70B auf, eine Absichtsmarkierung für SFT-Hinweise vorzunehmen, wobei mehr Absicht eine höhere Komplexität bedeutet. Außerdem forderten wir Llama 3 auf, den Schwierigkeitsgrad des Dialogs auf drei Ebenen zu messen (Liu et al., 2024c).

- Semantische Deemphasis: Schließlich führen wir eine semantische De-Duplizierung durch (Abbas et al., 2023; Liu et al., 2024c). Zunächst clustern wir vollständige Dialoge mithilfe von RoBERTa (Liu et al., 2019b) und sortieren sie in jedem Cluster nach Qualitäts- und Schwierigkeitsscore. Dann führen wir eine gierige Auswahl durch, indem wir über alle sortierten Beispiele iterieren und nur diejenigen behalten, deren maximale Cosinus-Ähnlichkeit zu den Beispielen in den bisherigen Clustern kleiner als ein Schwellenwert ist.

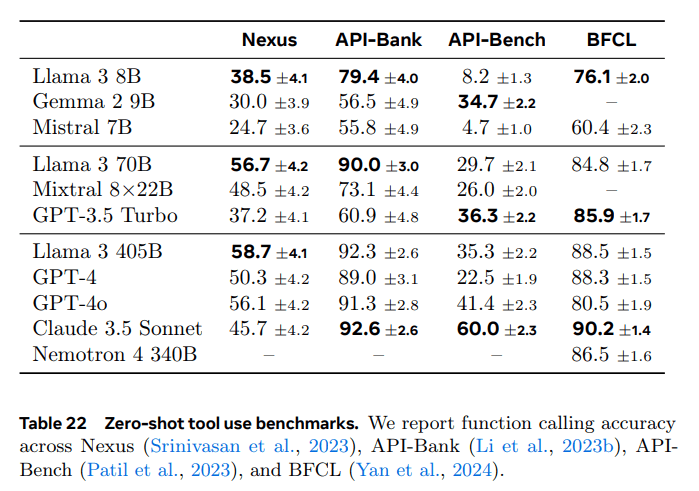

4.3 Kapazität

Insbesondere heben wir einige der Anstrengungen hervor, die unternommen wurden, um spezifische Kompetenzen zu fördern, wie die Handhabung von Codes (Abschnitt 4.3.1), Mehrsprachigkeit (Abschnitt 4.3.2), mathematische und logische Fähigkeiten (Abschnitt 4.3.3), lange Kontextualisierung (Abschnitt 4.3.4), Werkzeugnutzung (Abschnitt 4.3.5), Sachlichkeit (Abschnitt 4.3.6) und Kontrollierbarkeit (Abschnitt 4.3.7).

4.3.1 Code

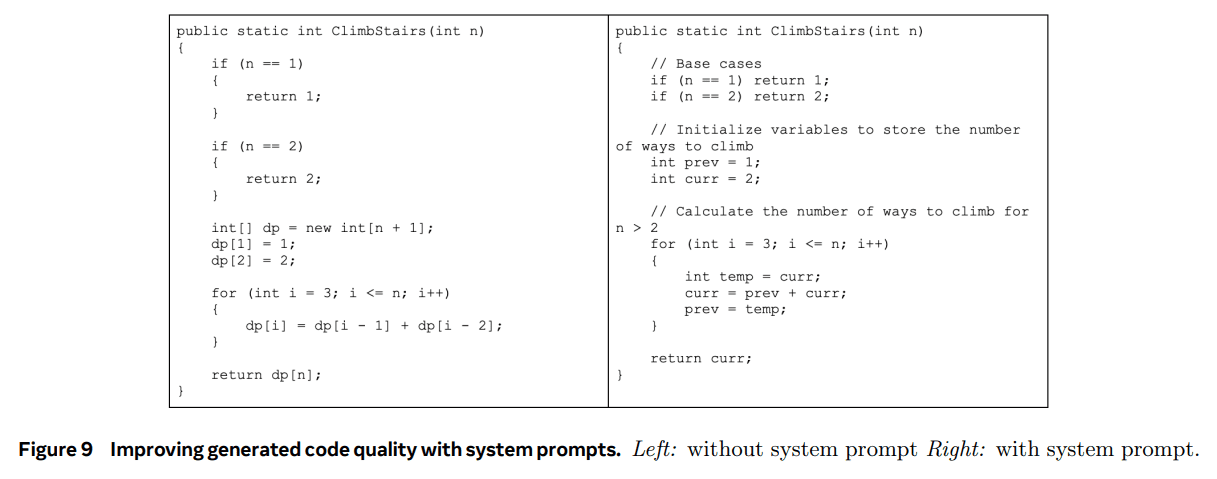

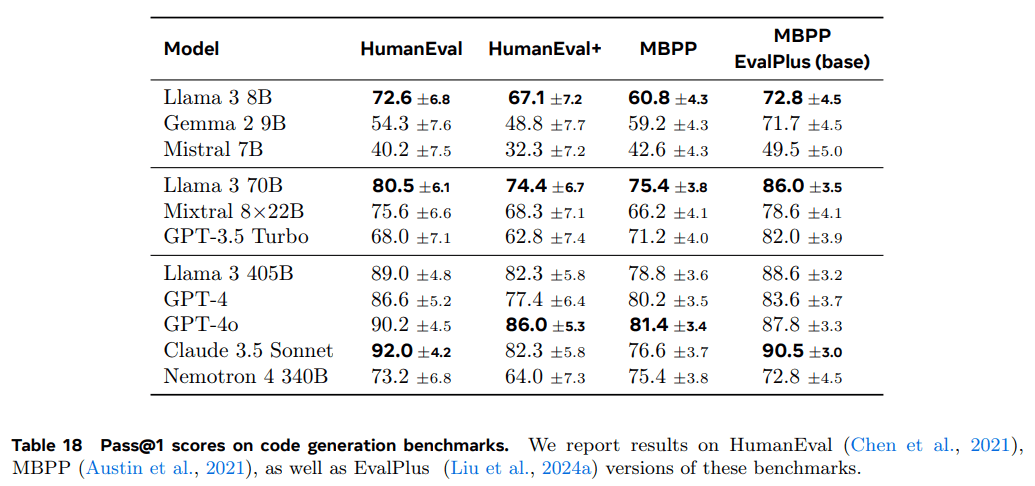

seit (einer Zeit) Kopilot und Codex (Chen et al., 2021) veröffentlicht wurden, haben LLMs für Code viel Aufmerksamkeit erhalten. Entwickler nutzen diese Modelle nun ausgiebig, um Codeschnipsel zu generieren, zu debuggen, Aufgaben zu automatisieren und die Codequalität zu verbessern. Für Llama 3 ist es unser Ziel, die Fähigkeiten zur Codegenerierung, Dokumentation, Fehlersuche und Überprüfung für die folgenden vorrangigen Programmiersprachen zu verbessern und zu bewerten: Python, Java, JavaScript, C/C++, TypeScript, Rust, PHP, HTML/CSS, SQL und Bash/Shell. Hier stellen wir die Ergebnisse vor, die durch die Schulung von Code-Experten, die Erzeugung synthetischer Daten für SFT, die Umstellung auf verbesserte Formate über Systemaufforderungen und die Erstellung von Qualitätsfiltern zur Entfernung schlechter Beispiele aus den Trainingsdaten zur Verbesserung dieser Codierungsfunktionen erzielt wurden.

Spezialisierte Ausbildung.Wir haben einen Code-Experten trainiert und ihn in mehreren Runden des Post-Trainings eingesetzt, um qualitativ hochwertige menschliche Code-Annotationen zu sammeln. Dies wurde erreicht, indem wir den Haupt-Pre-Trainingslauf abzweigten und das Pre-Training mit einer Mischung aus 1T-Token fortsetzten, die hauptsächlich (>85%) Code-Daten waren. Es hat sich gezeigt, dass fortgesetztes Vortraining mit domänenspezifischen Daten die Leistung in bestimmten Domänen verbessert (Gururangan et al., 2020). Wir folgen einem ähnlichen Rezept wie CodeLlama (Rozière et al., 2023). In den letzten paar Tausend Trainingsschritten führen wir ein Long Context Fine-Tuning (LCFT) auf einer hochwertigen Mischung von Code-Daten auf Repository-Ebene durch und erweitern die Kontextlänge des Experten auf 16K Token. Schließlich folgen wir einem ähnlichen Rezept zur Modellierung nach dem Training, wie in Abschnitt 4.1 beschrieben, um das Modell abzugleichen, aber unter Verwendung einer Mischung aus SFT- und DPO-Daten, die in erster Linie codespezifisch sind. Das Modell wird auch für das Rejection Sampling von Coding Cues verwendet (Abschnitt 4.2.2).

Erzeugung synthetischer Daten.Während der Entwicklung haben wir wichtige Probleme bei der Codegenerierung festgestellt, darunter Schwierigkeiten beim Befolgen von Anweisungen, Syntaxfehler, falsche Codegenerierung und Schwierigkeiten bei der Fehlerbehebung. Während dichte menschliche Annotationen diese Probleme theoretisch lösen könnten, bietet die synthetische Datengenerierung einen ergänzenden Ansatz, der billiger ist, besser skaliert und nicht durch das Fachwissen der Annotatoren eingeschränkt ist.

Wir haben daher Llama 3 und Code Expert verwendet, um eine große Anzahl synthetischer SFT-Dialoge zu erzeugen. Wir beschreiben drei High-Level-Methoden zur Erzeugung synthetischer Codedaten. Insgesamt haben wir bei SFT über 2,7 Millionen synthetische Beispiele verwendet.

1. Synthetische Datengenerierung: Implementierung von Feedback.Die Modelle 8B und 70B zeigen deutliche Leistungsverbesserungen bei Trainingsdaten, die von größeren, kompetenteren Modellen erzeugt wurden. Unsere vorläufigen Experimente deuten jedoch darauf hin, dass das Training von Llama 3 405B nur auf den von ihm selbst generierten Daten nicht hilfreich ist (oder die Leistung sogar verschlechtert). Um diese Einschränkung zu beheben, führen wir das Ausführungsfeedback als eine Quelle der Wahrheit ein, die es dem Modell ermöglicht, aus seinen Fehlern zu lernen und auf Kurs zu bleiben. Insbesondere generieren wir einen Datensatz von etwa einer Million synthetischer Code-Dialoge mit dem folgenden Verfahren:

- Erstellung von Problembeschreibungen:Zunächst generierten wir eine große Menge an Beschreibungen von Programmierproblemen, die eine Vielzahl von Themen abdecken (einschließlich Long-Tail-Verteilungen). Um diese Vielfalt zu erreichen, haben wir nach dem Zufallsprinzip Codeschnipsel aus einer Vielzahl von Quellen ausgewählt und das Modell aufgefordert, auf der Grundlage dieser Beispiele Programmierprobleme zu generieren. Auf diese Weise konnten wir eine breite Palette von Themen nutzen und einen umfassenden Satz von Problembeschreibungen erstellen (Wei et al., 2024).

- Generierung von Lösungen:Anschließend forderten wir Llama 3 auf, jedes Problem in der vorgegebenen Programmiersprache zu lösen. Wir stellten fest, dass das Hinzufügen guter Programmierregeln zu den Aufforderungen die Qualität der generierten Lösungen verbesserte. Außerdem fanden wir es hilfreich, das Modell aufzufordern, seinen Denkprozess mit Kommentaren zu erklären.

- Analyse der Korrektheit: Nach der Generierung von Lösungen ist es wichtig zu erkennen, dass ihre Korrektheit nicht garantiert ist und dass die Aufnahme falscher Lösungen in den fein abgestimmten Datensatz die Qualität des Modells beeinträchtigen kann. Wir können zwar keine vollständige Korrektheit garantieren, aber wir haben Methoden entwickelt, um die Korrektheit zu approximieren. Zu diesem Zweck nehmen wir den extrahierten Quellcode der generierten Lösungen und wenden eine Kombination aus statischen und dynamischen Analysetechniken an, um ihre Korrektheit zu prüfen:

- Statische Analyse: Wir lassen den gesamten generierten Code durch einen Parser und Code-Prüfwerkzeuge laufen, um die syntaktische Korrektheit zu gewährleisten und Syntaxfehler, die Verwendung nicht initialisierter Variablen oder nicht importierter Funktionen, Code-Stilprobleme, Typfehler usw. zu erkennen.

- Erstellung und Ausführung von Einheitstests: Für jedes Problem und jede Lösung veranlassen wir das Modell, Unit-Tests zu generieren und sie mit der Lösung in einer containerisierten Umgebung auszuführen, wobei Laufzeitfehler und einige semantische Fehler abgefangen werden.

- Fehlerrückmeldung und iterative Selbstkorrektur: Wenn die Lösung in irgendeinem Schritt fehlschlägt, fordern wir das Modell auf, sie zu ändern. Die Aufforderung enthält die ursprüngliche Problembeschreibung, die falsche Lösung und das Feedback des Parsers/Code-Inspektionswerkzeugs/Testprogramms (Standardausgabe, Standardfehler und Rückgabewert). Nach einer fehlgeschlagenen Ausführung eines Unit-Tests kann das Modell entweder den Code so korrigieren, dass er die bestehenden Tests besteht, oder seine Unit-Tests an den generierten Code anpassen. Nur Dialoge, die alle Tests bestehen, werden in den endgültigen Datensatz für die überwachte Feinabstimmung (SFT) aufgenommen. Wir haben festgestellt, dass etwa 20% der Lösungen anfänglich falsch waren, sich aber selbst korrigiert haben, was darauf hindeutet, dass das Modell aus dem Feedback der Ausführung gelernt und seine Leistung verbessert hat.

- Feinabstimmung und iterative Verbesserung: Der Feinabstimmungsprozess erfolgt über mehrere Runden, wobei jede Runde auf der vorherigen Runde aufbaut. Nach jeder Feinabstimmungsrunde wird das Modell verbessert, um qualitativ hochwertigere synthetische Daten für die nächste Runde zu erzeugen. Dieser iterative Prozess ermöglicht eine schrittweise Verfeinerung und Verbesserung der Modellleistung.

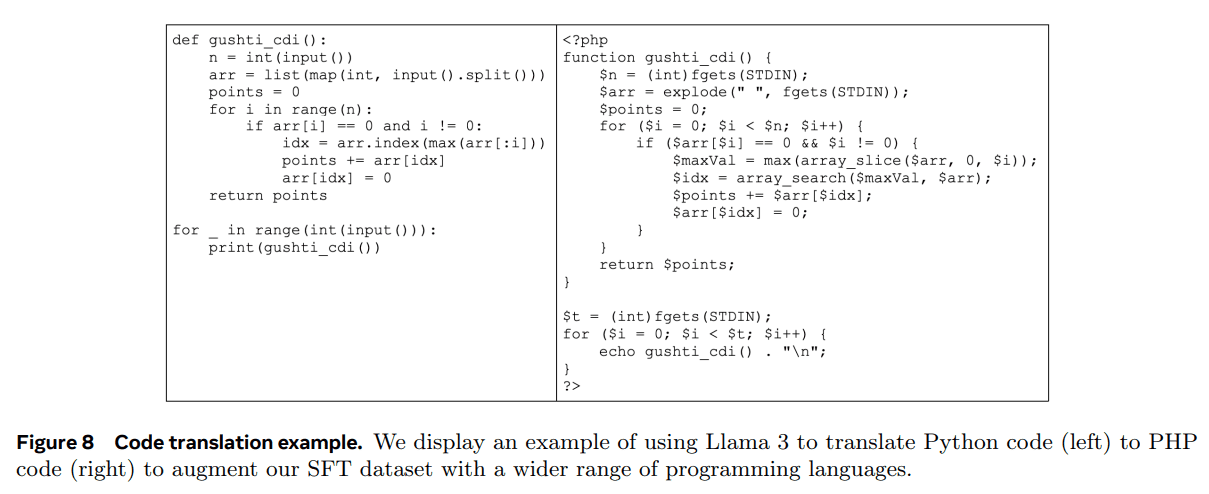

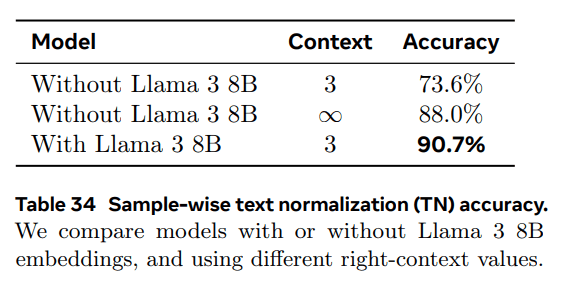

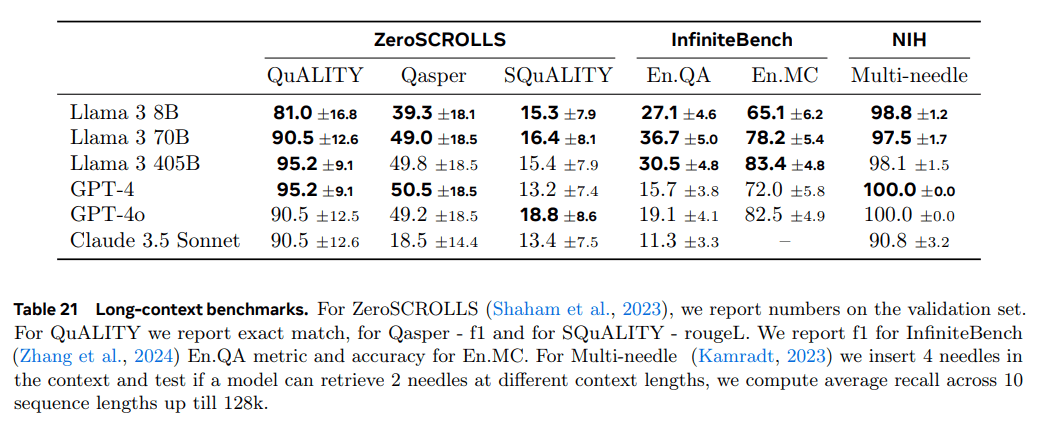

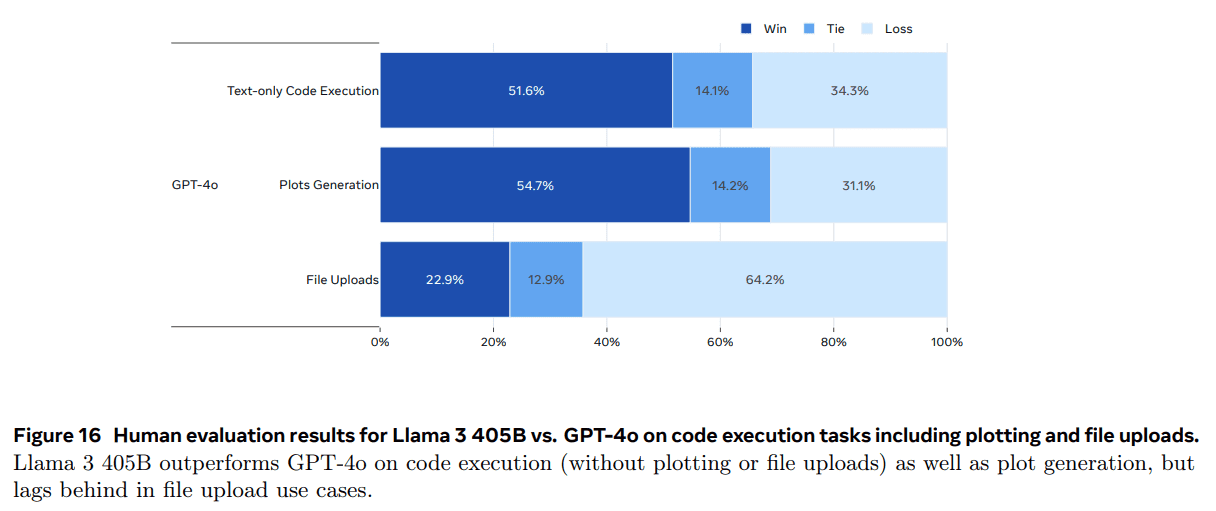

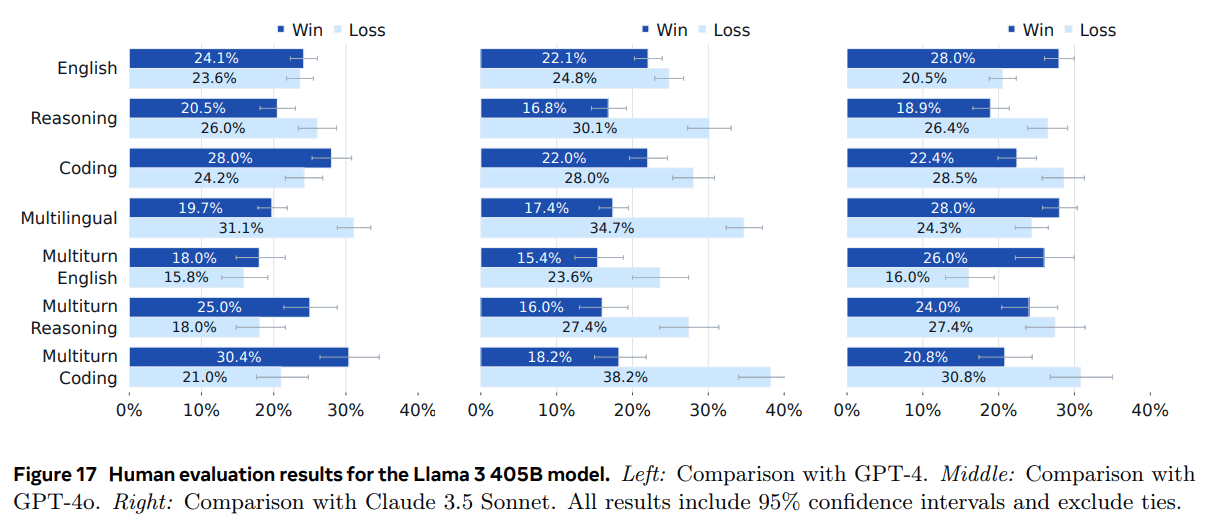

2) Synthetische Datenerzeugung: Übersetzung der Programmiersprache. Wir beobachten einen Leistungsunterschied zwischen den großen Programmiersprachen (z. B. Python/C++) und weniger verbreiteten Programmiersprachen (z. B. Typescript/PHP). Dies ist nicht überraschend, da wir weniger Trainingsdaten für weniger verbreitete Programmiersprachen haben. Um dies abzumildern, werden wir die verfügbaren Daten durch die Übersetzung von Daten aus gängigen Programmiersprachen in weniger gängige Sprachen ergänzen (ähnlich wie Chen et al. (2023) im Bereich der Inferenz). Dies wird durch die Eingabeaufforderung von Llama 3 und die Gewährleistung der Qualität durch syntaktisches Parsing, Kompilierung und Ausführung erreicht. Abbildung 8 zeigt ein Beispiel für synthetischen PHP-Code, der aus Python übersetzt wurde. Dadurch wird die mit dem MultiPL-E (Cassano et al., 2023) Benchmark gemessene Leistung von weniger verbreiteten Sprachen erheblich verbessert.