Hybrid-T1 neu aufgelegt: Mamba-fähig, neue Definition der Inferenzgeschwindigkeit

In letzter Zeit hat der Bereich der groß angelegten Sprachmodellierung von der Industrie zunehmend Aufmerksamkeit für neue Paradigmen des Verstärkungslernens in den späten Phasen des Trainings erhalten. Nach der Einführung von Modellen der O-Reihe wie GPT-4o von OpenAI und dem DeepSeek-R1 der Veröffentlichung zeigt die hervorragende Leistung des Modells die Schlüsselrolle des Verstärkungslernens im Optimierungsprozess.

Auch das Tencent Mixed Meta Model Team hat in letzter Zeit bedeutende Fortschritte gemacht. Mitte Februar dieses Jahres hat das Team das Mixed Yuan T1-Preview Inferenzmodell auf der Basis eines mittelgroßen Mixed Yuan in der Tencent Yuanbao APP eingeführt. Nun wurde das Deep Thinking-Modell der Mixed Meta Model-Serie zur offiziellen Version Mixed Meta-T1 aufgewertet.

Erfahrung Adresse:

https://llm.hunyuan.tencent.com/#/chat/hy-t1

https://huggingface.co/spaces/tencent/Hunyuan-T1

Der Hybrid-T1 basiert auf der Anfang März erschienenen Version des TurboS Rapid Thinking Base.TurboS ist das weltweit erste hyperskalige Mixed Model of Expertise (MoE), das die Transformator und Mamba-Architekturen. Mit umfangreichem Post-Training werden die Inferenzfähigkeiten von Mamba-T1 erheblich erweitert und besser an die menschlichen Präferenzen angepasst.

Hybrid-T1 hat einzigartige Vorteile beim Deep Reasoning. Erstens trägt die Fähigkeit von TurboS, lange Texte zu erfassen, dazu bei, die üblichen Probleme des Kontextverlusts und der Abhängigkeit von entfernten Informationen bei der Inferenz langer Texte wirksam zu lösen. Zweitens ist die Mamba-Architektur speziell für lange Sequenzen optimiert und reduziert den Verbrauch von Rechenressourcen durch effiziente Berechnungsmethoden erheblich, während gleichzeitig die Fähigkeit zur Erfassung langer Textinformationen gewährleistet wird. Unter den gleichen Einsatzbedingungen wird die Dekodiergeschwindigkeit um den Faktor 2 erhöht.

In der späteren Trainingsphase des Modells werden 96,7% der Rechenressourcen in das Reinforcement-Learning-Training investiert, wobei der Schwerpunkt auf der Verbesserung der reinen Inferenz und der Optimierung der Übereinstimmung mit den menschlichen Präferenzen liegt.

Um dieses Ziel zu erreichen, sammelte das Forschungsteam wissenschaftliche und logische Probleme von Weltrang aus den Bereichen Mathematik, logisches Denken, Wissenschaft und Code. Diese Datensätze decken ein breites Spektrum an Aufgaben ab, von grundlegenden mathematischen Schlussfolgerungen bis hin zu komplexen wissenschaftlichen Problemlösungen. In Verbindung mit echtem Feedback (ground-truth) wird so sichergestellt, dass das Modell bei einer Vielzahl von Denkaufgaben gut abschneidet.

Das Training wurde mit Hilfe eines Curriculum-Learning-Ansatzes (CLE) durchgeführt, bei dem der Schwierigkeitsgrad der Daten schrittweise erhöht und die Länge des Modellkontextes schrittweise erweitert wird, so dass das Modell lernt, die Argumentationsfähigkeit effektiv zu nutzen und gleichzeitig die Token Begründungen.

Was die Trainingsstrategien betrifft, so werden klassische Strategien des Verstärkungslernens wie die Wiederholung von Daten und das periodische Zurücksetzen von Richtlinien verwendet, um die langfristige Stabilität des Modelltrainings um mehr als 50% zu verbessern. In der Phase der Anpassung an menschliche Präferenzen wird ein einheitliches Belohnungssystem verwendet, das die Selbstbelohnung (umfassende Auswertung und Bewertung der Modellausgabe auf der Grundlage einer früheren Version von T1-Preview) und Belohnungsmodi umfasst, um das Modell zur Selbstverbesserung zu führen. Die Modelle zeigen in ihren Antworten detailliertere Inhalte und effizientere Informationen.

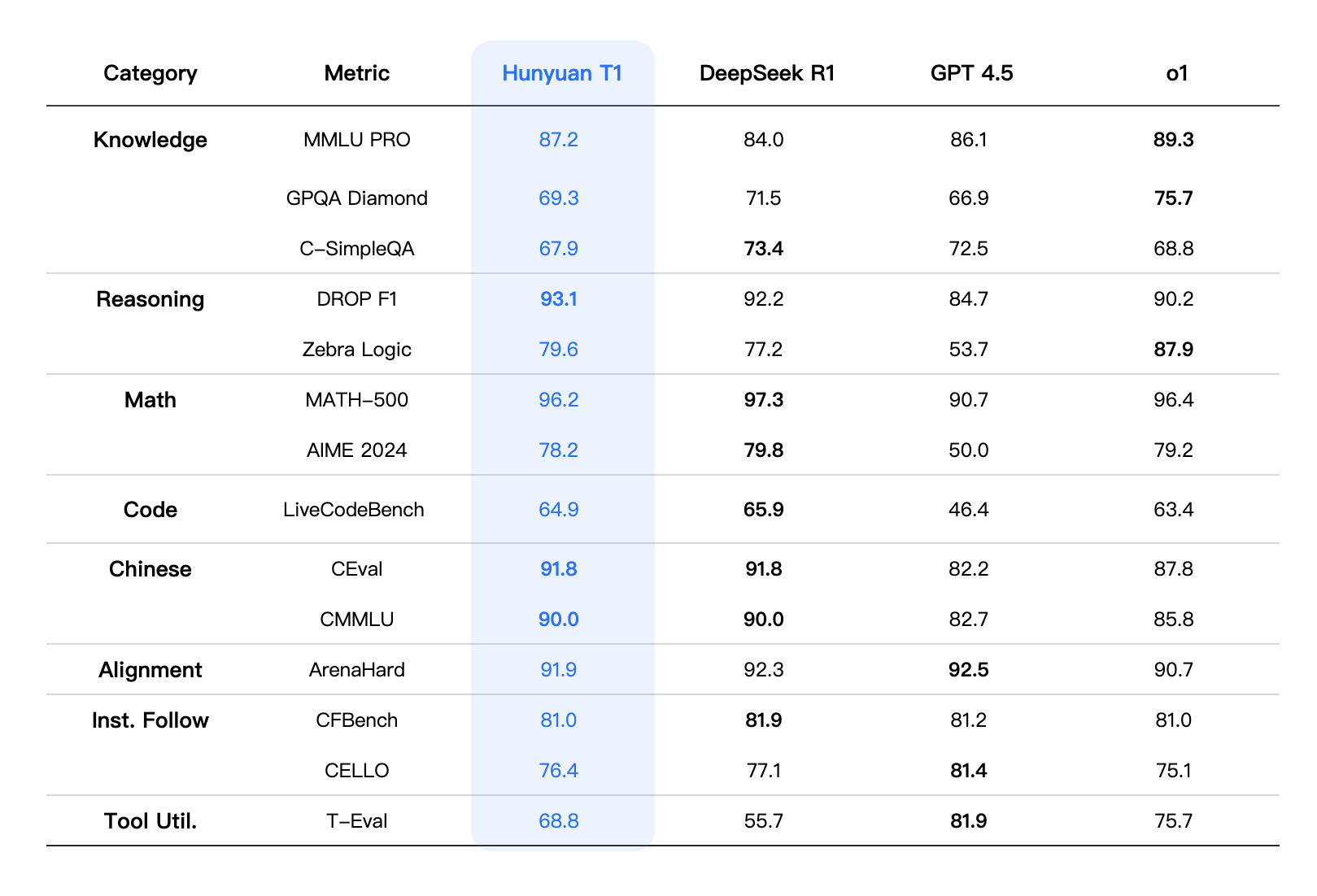

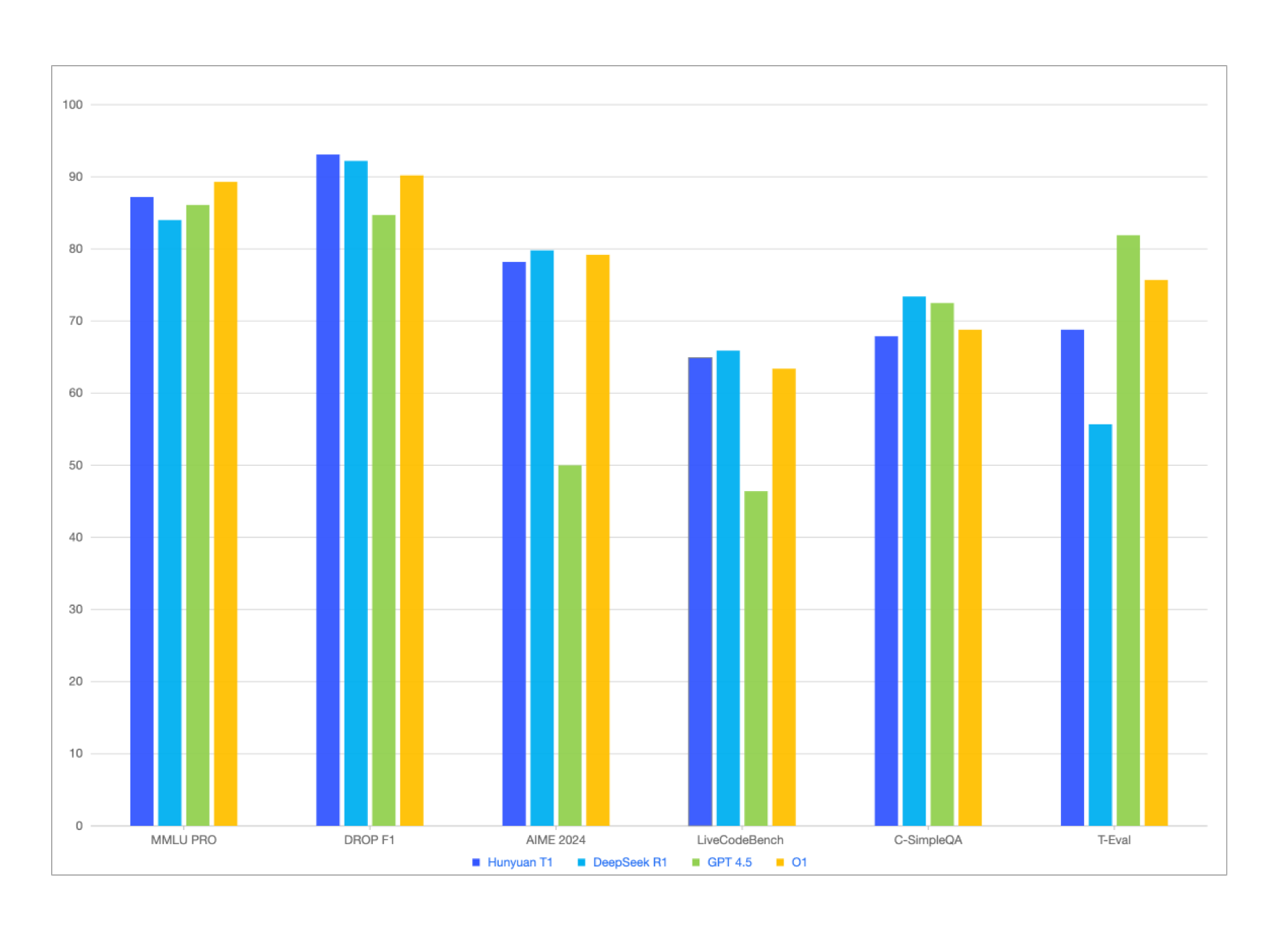

Mixed Elements-T1 erzielt nicht nur vergleichbare oder leicht bessere Ergebnisse als DeepSeek-R1 in öffentlichen Benchmark-Tests zu Chinesisch- und Englischkenntnissen, Mathematik und logischem Denken auf Wettbewerbsebene wie MMLU-pro, CEval, AIME, Zebra Logic und anderen, sondern schneidet auch in internen Bewertungsdatensätzen gut ab, mit leichten Vorteilen bei der Befolgung kultureller und kreativer Anweisungen, der Textzusammenfassung und der Smart-Body-Kompetenz. .

In Bezug auf die umfassenden Bewertungsmetriken ist die Gesamtleistung von Hybrid-T1 mit der eines erstklassigen Frontier-Inferenzmodells vergleichbar. Bei der umfassenden Bewertung der Fähigkeiten liegt T1 bei MMLU-PRO An zweiter Stelle nach O1 auf der Liste, mit einem Zuwachs von 87.2 der hohen Punktzahlen. Der Test umfasst Fragen aus 14 Bereichen der Geistes- und Sozialwissenschaften sowie der Natur- und Ingenieurwissenschaften und prüft vor allem das Gedächtnis und das Verständnis eines breiten Spektrums an Wissen. Durch die Konzentration auf spezielles Fachwissen und komplexes wissenschaftliches Denken GPQA-Diamant(T1 hat die folgenden Ergebnisse erzielt (hauptsächlich Probleme auf PhD-Niveau in Physik, Chemie und Biologie) 69.3 Das Ergebnis.

In den Natur- und Ingenieurwissenschaften wurden Szenarien getestet, die ein ausgeprägtes logisches Denkvermögen erfordern, z. B. Codierung, Mathematik und logisches Denken. In der LiveCodeBench Bei der Codebewertung erreichte T1 64.9 Punkte. In der Zwischenzeit glänzte T1 in Mathe. Besonders in MATH-500 Darüber hinaus machte es 96.2 Die ausgezeichneten Ergebnisse nach DeepSeek-R1 zeigten die umfassenden Fähigkeiten von T1 beim Lösen mathematischer Probleme. Darüber hinaus zeigte T1 eine starke Anpassungsfähigkeit bei mehreren Ausrichtungsaufgaben, Aufgaben zur Befolgung von Befehlen und Aufgaben zur Nutzung von Werkzeugen. Zum Beispiel, T1's Leistung bei der ArenaHard Die Mission wurde mit dem 91.9 Das Ergebnis.

Modellierungseffekt

Hinweis: Die Bewertungsindikatoren für die anderen Modelle in der Tabelle stammen aus den offiziellen Bewertungsergebnissen. Für die Teile, die nicht in den offiziellen Bewertungsergebnissen enthalten sind, stammen die Daten von der internen Bewertungsplattform von Hybrid.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...