Hume AI: Stärkung der KI mit Emotionserkennung | Erkennung von Gefühlszuständen aus Lauten und Ausdrücken | Generierung von Sprache mit Gefühlszuständen

Allgemeine Einführung

Hume AI ist ein KI-Unternehmen, das sich auf emotionale Intelligenz konzentriert und multimodale KI-Technologien entwickelt, die menschliche Emotionen verstehen und auf sie reagieren. Sein Vorzeigeprodukt, das Empathic Voice Interface (EVI), erkennt und reagiert auf die Emotionen des Nutzers in verschiedenen Formen, einschließlich Sprache, Gesichtsausdruck und Sprache, um die emotionale Erfahrung der Mensch-Computer-Interaktion zu verbessern. Das Ziel von Hume AI ist es, sicherzustellen, dass die KI-Technologie durch einen wissenschaftlichen Ansatz und ethische Grundsätze wirklich dem emotionalen Wohlbefinden der Menschen dienen kann.

Funktionsliste

- EmotionserkennungErkennen von Emotionen des Benutzers in einer Vielzahl von Formen, einschließlich Sprache, Mimik und Sprache.

- SprachsyntheseGenerierung von Sprachantworten mit Emotionen, um das interaktive Erlebnis zu verbessern.

- multimodale InteraktionUnterstützt eine breite Palette von Interaktionen wie Sprache, Text und Emoticons.

- Personalisierung: Passen Sie verschiedene KI-Persönlichkeiten und Sprachstile an die Bedürfnisse des Benutzers an.

- Echtzeit-ReaktionBietet Echtzeit-Stimmungsanalyse und -Reaktion für ein breites Spektrum von Anwendungsszenarien.

Hilfe verwenden

Installation und Nutzung

Hume AI ist sehr einfach zu bedienen und erfordert keinen komplizierten Installationsprozess. Benutzer müssen nur die offizielle Website besuchen und sich für ein Konto registrieren, um den Online-Service zu nutzen. Hier sind die detaillierten Schritte, um es zu benutzen:

- Registrieren Sie sich für ein Konto: Zugang Hume AI Offizielle WebsiteKlicken Sie auf die Schaltfläche Registrieren und geben Sie die erforderlichen Informationen ein, um die Registrierung abzuschließen.

- Login-PlattformMelden Sie sich mit Ihrem registrierten Konto und Passwort bei der Hume AI Plattform an.

- Dienst auswählenWählen Sie auf der Startseite der Plattform das gewünschte Servicemodul aus, z. B. Emotionserkennung, Sprachsynthese usw.

- Daten hochladenHochladen von Sprach-, Video- oder Textdaten, die nach Aufforderung analysiert werden sollen.

- Ergebnisse anzeigenDas System führt automatisch eine Stimmungsanalyse durch und erstellt detaillierte Berichte und Reaktionsergebnisse.

Funktion Betriebsablauf

Emotionserkennung

- Zugriff auf das Modul zur Erkennung von EmotionenNach dem Einloggen klicken Sie in der Navigationsleiste auf "Emotion Recognition".

- Daten hochladenWählen Sie die zu analysierende Sprach- oder Videodatei aus und klicken Sie auf Hochladen.

- Mit der Analyse beginnenKlicken Sie auf die Schaltfläche "Analyse starten" und das System führt automatisch eine Sentimenterkennung durch.

- Bericht ansehenSobald die Analyse abgeschlossen ist, können die Benutzer einen detaillierten Stimmungsanalysebericht einsehen, der die Art der Stimmung, die Intensität und die Veränderungstrends enthält.

Sprachsynthese

- Zugriff auf das SprachsynthesemodulNach dem Einloggen klicken Sie in der Navigationsleiste auf "Sprachsynthese".

- EingabetextText: Geben Sie den zu synthetisierenden Textinhalt in das Textfeld ein.

- Sprachstil auswählenWählen Sie je nach Bedarf verschiedene Sprachstile und emotionale Ausdrücke.

- Sprache generierenKlicken Sie auf die Schaltfläche "Stimme generieren", das System generiert die entsprechende Sprachdatei.

- Stimme herunterladenSobald die Generierung abgeschlossen ist, können die Benutzer die Sprachdateien zur Verwendung in verschiedenen Anwendungsszenarien herunterladen.

multimodale Interaktion

- Zugang zum Modul Multimodale InteraktionNach dem Einloggen klicken Sie in der Navigationsleiste auf "Multimodale Interaktion".

- Interaktionsmethode auswählenWählen Sie, ob Sie mit Sprache, Text oder Emoji interagieren möchten.

- Beginn der InteraktionDas System erkennt die Emotionen des Benutzers und reagiert in Echtzeit auf die Eingabeaufforderungen.

- Datensätze anzeigenAm Ende der Interaktion können die Benutzer das Interaktionsprotokoll und die Ergebnisse der Stimmungsanalyse einsehen.

Hume AI bietet eine Fülle von Dokumentationen und Tutorials, und die Benutzer können detaillierte Anleitungen und FAQs im Hilfezentrum auf der Website finden. Sollten Sie bei der Verwendung von Hume AI auf Probleme stoßen, wenden Sie sich bitte an den Kundendienst von Hume AI, um Unterstützung zu erhalten.

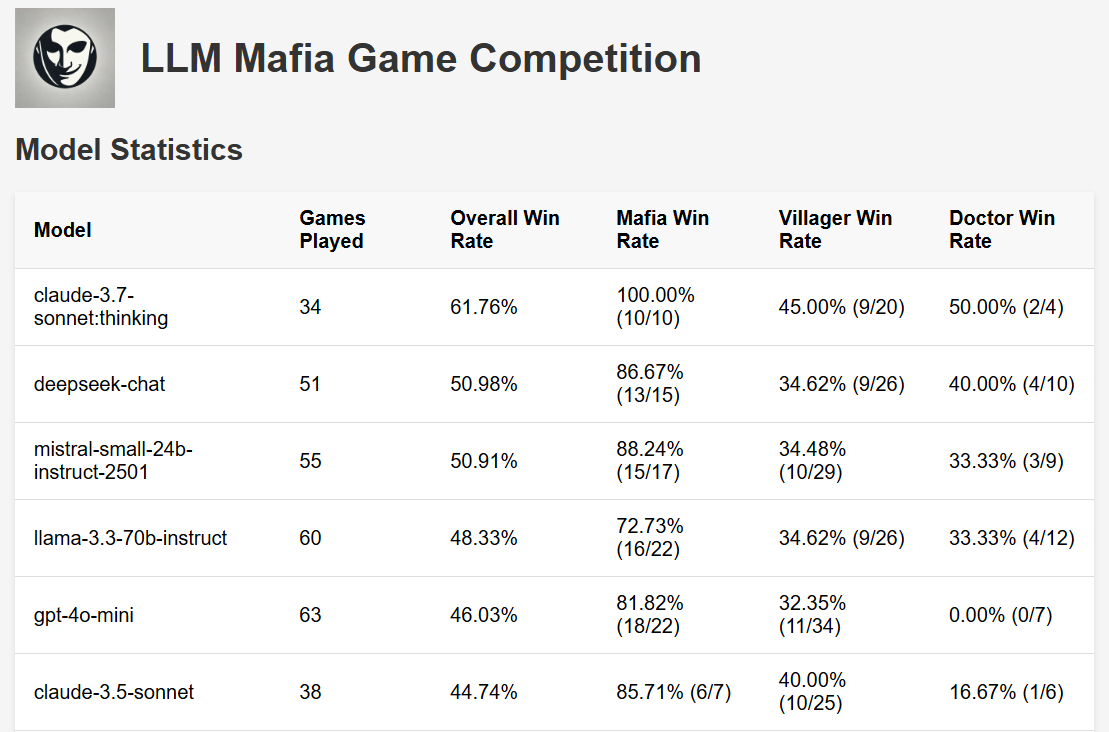

Empathische Sprachschnittstelle (EVI)

Das Emotional Intelligent Voice Interface (EVI) von Hume ist die weltweit erste Sprach-KI mit emotionaler Intelligenz. Sie nimmt Live-Audioeingaben entgegen und liefert Audio- und Texttranskriptionen, die durch Daten zur tonalen Ausdruckskraft ergänzt werden. Durch die Analyse von Tonhöhe, Rhythmus und Klangfarbe schaltet EVI zusätzliche Funktionen frei, wie z. B. Vokalisierung zum richtigen Zeitpunkt und die richtige Intonation, um einfühlsame Sprache zu erzeugen. Diese Funktionen machen sprachbasierte Mensch-Computer-Interaktionen reibungsloser und befriedigender und eröffnen gleichzeitig neue Möglichkeiten in Bereichen wie persönliche KI, Kundenservice, Benutzerfreundlichkeit, Robotik, immersive Spiele, VR-Erlebnisse und mehr.

Wir stellen eine ganze Reihe von Tools zur Verfügung, um die Integration und Anpassung von EVI in Ihren Anwendungen zu erleichtern, darunter eine WebSocket-API zur Verarbeitung von Audio- und Textübertragungen, eine REST-API und SDKs für Typescript und Python zur Vereinfachung der Integration in Web- und Python-Projekte. als praktischen Ausgangspunkt für Entwickler, um EVI-Funktionen in ihren eigenen Projekten zu erforschen und zu implementieren.

Bauen mit EVI

EVI lässt sich in erster Linie über eine WebSocket-Verbindung nutzen, die Audio sendet und Feedback in Echtzeit empfängt. Dies ermöglicht einen reibungslosen Zwei-Wege-Dialog: Der Nutzer kommentiert, EVI hört zu und analysiert die Äußerungen, und dann erzeugt EVI emotional intelligentes Feedback.

Sie können einen Dialog starten, indem Sie eine Verbindung zu einem WebSocket herstellen und die Spracheingabe des Benutzers an das EVI senden. Sie können auch Text an die EVI senden, der dann vorgelesen wird.

EVI wird auf folgende Weise antworten:

- Geben Sie eine textliche Antwort von EVI

- Bietet aussagekräftiges Audio-Feedback für EVI

- Ermöglicht die Transkription von Nutzernachrichten und die Messung ihrer stimmlichen Äußerungen

- Wenn der Benutzer das EVI unterbricht, wird eine Rückmeldung darüber gegeben

- Wenn das EVI mit der Beantwortung fertig ist, gibt es eine Warnmeldung aus

- Wenn ein Problem auftritt, wird eine Fehlermeldung ausgegeben

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...