Harbor: ein containerisiertes Toolset zur Bereitstellung lokaler LLM-Entwicklungsumgebungen mit einem Klick und zur einfachen Verwaltung und Ausführung von KI-Diensten

Allgemeine Einführung

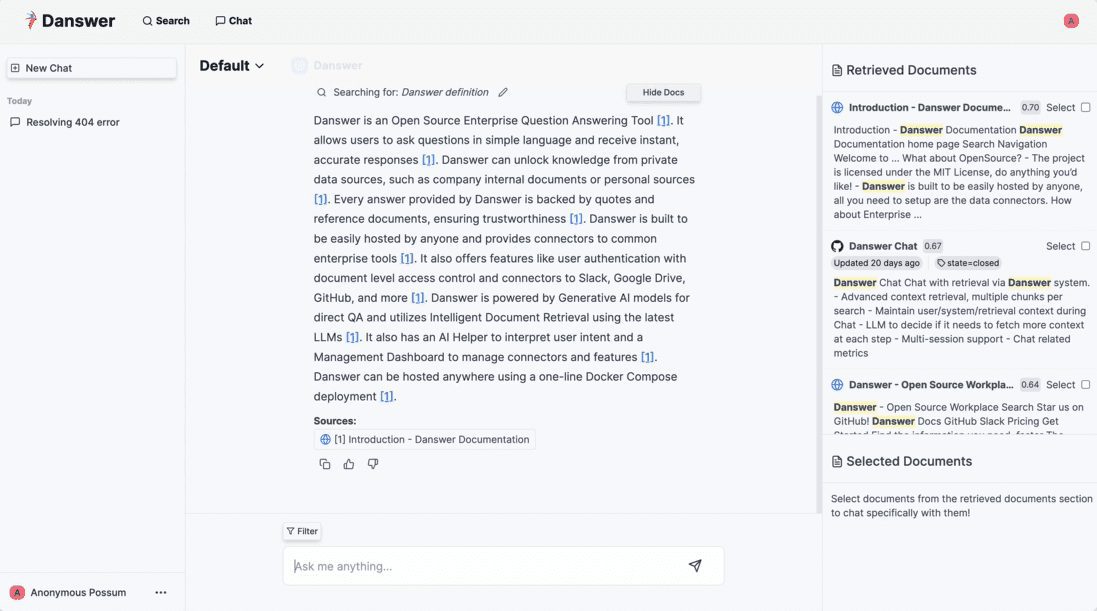

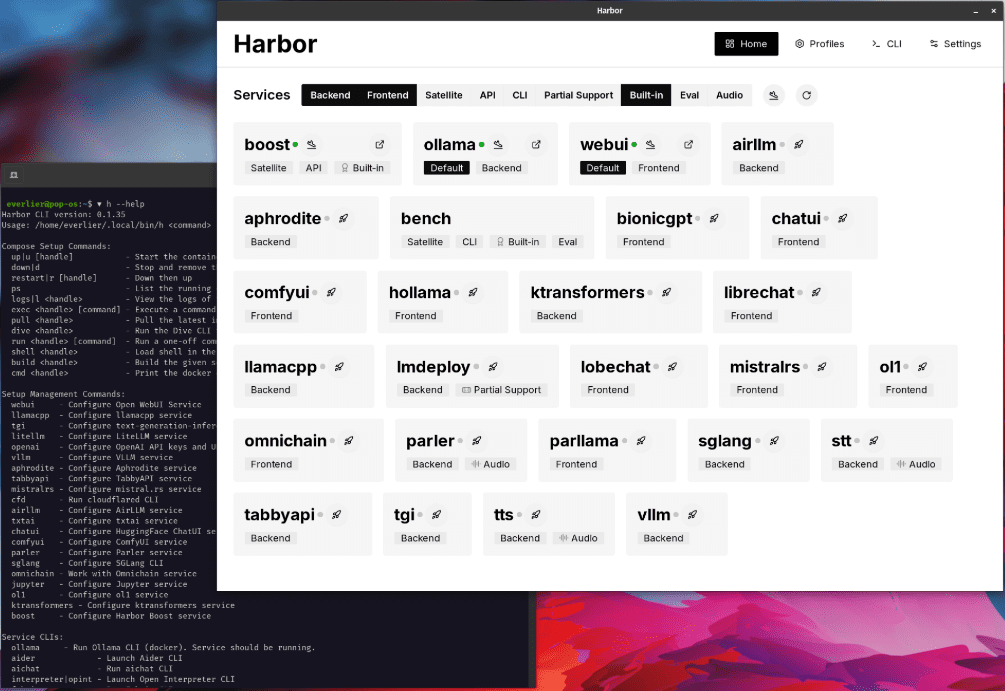

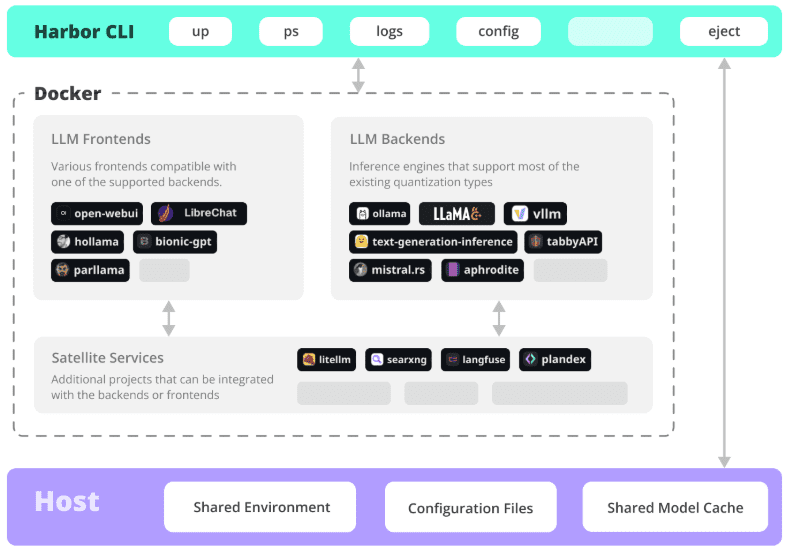

Harbor ist ein revolutionäres containerisiertes LLM-Toolset, das sich auf die Vereinfachung der Bereitstellung und Verwaltung von lokalen KI-Entwicklungsumgebungen konzentriert. Es ermöglicht Entwicklern den Start und die Verwaltung aller KI-Dienstkomponenten, einschließlich LLM-Backend, API-Schnittstelle, Front-End-Schnittstelle usw., mit einem einzigen Klick über eine übersichtliche Befehlszeilenschnittstelle (CLI) und unterstützende Anwendungen. Als Open-Source-Projekt eignet sich Harbor besonders für Entwickler, die schnell LLM-Anwendungen erstellen und mit ihnen experimentieren möchten. Es unterstützt nicht nur die gängigen KI-Modelle und -Dienste, sondern bietet auch flexible Konfigurationsoptionen und eine vollständige Toolchain, so dass sich die Entwickler auf die Anwendungsentwicklung und nicht auf die Umgebungskonfiguration konzentrieren können.Harbor verwendet das Apache 2.0 Open-Source-Protokoll, wird von der Community aktiv unterstützt, hat auf GitHub mehr als 770 Sternchen erhalten und wurde von vielen Entwicklern anerkannt und verwendet.

Funktionsliste

- Ein-Klick-Bereitstellung: Starten Sie eine komplette LLM-Dienstumgebung mit einem einzigen Befehl

- Container-Verwaltung: Integration von Docker und Docker Compose für die Orchestrierung von Diensten

- Multi-Backend-Unterstützung: Kompatibel mit einer Vielzahl von LLM-Engines und Modellformaten (GGUF, SafeTensors, etc.).

- Dienstintegration: Vorkonfigurierte API-Dienste und Front-End-Schnittstellen arbeiten zusammen

- Entwicklungstools: Bietet eine vollständige lokale Entwicklungs-Toolkette

- Konfigurationsflexibilität: Unterstützung für benutzerdefinierte Dienstkomponenten und Konfigurationsoptionen

- SSL-Zertifikate: Integrierte Certbot-Unterstützung für die einfache Konfiguration des HTTPS-Zugangs

- Umgebungsmigration: Unterstützung des Konfigurationsexports, einfache Migration in die Produktionsumgebung

- Überwachungsmanagement: Bietet eine Funktion zur Überwachung des Dienststatus und zur Anzeige von Protokollen.

- Versionskontrolle: Unterstützung der Verwaltung verschiedener Versionen von KI-Dienstkomponenten

Hilfe verwenden

1. die Vorbereitung der Umwelt

1.1 Systemanforderungen

- Betriebssystem: Unterstützt Linux, MacOS oder Windows WSL2

- Docker-Engine 20.10+

- Docker Compose 1.18.0+

- Node.js 16+ (optional, für npm-Installationsmethode)

1.2 Installation von Harbor

# 方式1:使用npm安装

npm install -g @avlab/harbor

# 方式2:使用curl安装

curl -sfL https://get.harbor.ai | sh

2. grundlegende Verwendung

2.1 Dienste starten

# 初始化Harbor环境

harbor init

# 启动所有服务

harbor up

# 查看服务状态

harbor ps

2.2 Konfiguration des Dienstes

# 配置模型路径

harbor config set models.path /path/to/models

# 启用特定服务

harbor enable chatui

harbor enable api

# 禁用服务

harbor disable service-name

3. erweiterte Funktionen

3.1 Konfiguration des SSL-Zertifikats

# 设置环境变量

export NGINX_SSL_CERT_FILENAME=fullchain.pem

export NGINX_SSL_CERT_KEY_FILENAME=privkey.pem

export CERTBOT_DOMAIN=your_domain.com

export CERTBOT_EMAIL=your@email.com

# 获取证书

harbor ssl setup

3.2 Benutzerdefinierte Konfiguration

# 导出配置

harbor eject

# 修改配置文件

vim harbor.yaml

# 使用自定义配置启动

harbor up -c custom-config.yaml

4. gemeinsame Betriebsverfahren

4.1 Einführung neuer Dienste

- Prüfen Sie die Liste der Dienstleistungen:

harbor list - Aktivieren Sie die gewünschten Dienste:

harbor enable <service-name> - Konfigurieren Sie die Dienstparameter:

harbor config set <param> <value> - Starten Sie den Dienst:

harbor up - Überprüfen Sie den Dienststatus:

harbor ps

4.2 Problemerkennung

# 查看服务日志

harbor logs <service-name>

# 检查服务状态

harbor status

# 重启服务

harbor restart <service-name>

5. bewährte Praktiken

- Regelmäßige Sicherung der Konfigurationsdateien

- Verwaltung benutzerdefinierter Konfigurationen mit Versionskontrolle

- Überwachung der Nutzung von Dienstressourcen

- Harbor und die zugehörigen Komponenten auf dem neuesten Stand halten

- Beschleunigen Sie den Bereitstellungsprozess mit Projektvoreinstellungen

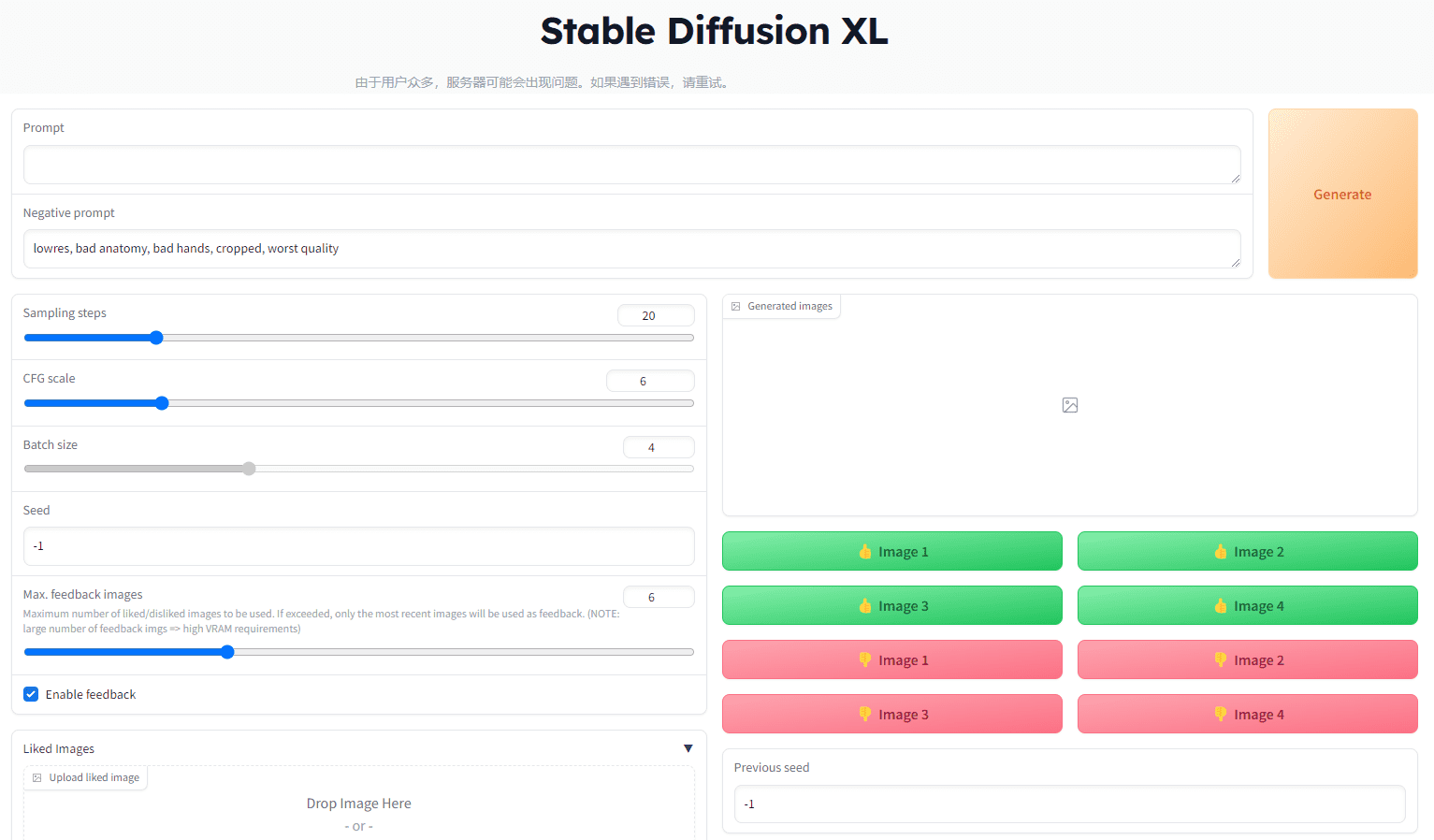

Installierbare AI-Dienste

Benutzer

WebUI öffnen ⦁︎ ComfyUI ⦁︎ LibreChat ⦁︎ HuggingFace ChatUI ⦁︎ Keulenschwätzer ⦁︎ Hollama ⦁︎ parllama ⦁︎ BionicGPT ⦁︎ AnythingLLM ⦁︎ Chat Nio

Backend-Dienst

Ollama ⦁︎ lama.cpp ⦁︎ vLLM ⦁︎ TabbyAPI ⦁︎ Aphrodite-Motor ⦁︎ mistral.rs ⦁︎ openai-sprache ⦁︎ faster-whisper-server ⦁︎ Parler ⦁︎ text-generierungs-inferenz ⦁︎ LMDeploy ⦁︎ AirLLM ⦁︎ SGLang ⦁︎ KTransformatoren ⦁︎ Nexa SDK

Erweiterungstools

Harbor Bank ⦁︎ Hafen Boost ⦁︎ SearXNG ⦁︎ Perplexica ⦁︎ Dify ⦁︎ Plandex ⦁︎ LiteLLM ⦁︎ LangFuse ⦁︎ Offener Dolmetscher ⦁ ︎cloudflared ⦁︎ cmdh ⦁︎ Stoff ⦁︎ txtai RAG ⦁︎ TextGrad ⦁︎ Aider ⦁︎ aichat ⦁︎ omnichain ⦁︎ lm-auswertung-geschirr ⦁︎ JupyterLab ⦁︎ ol1 ⦁︎ OpenHands ⦁︎ LitLytics ⦁︎ Repopack ⦁︎ n8n ⦁︎ Bolzen.neu ⦁︎ WebUI-Pipelines öffnen ⦁︎ Qdrant ⦁︎ K6 ⦁︎ Promptfoo ⦁︎ Webtop ⦁︎ OmniParser ⦁︎ Flowise ⦁︎ Langflow ⦁︎ OptiLLM

Siehe auch Dokumentation der Dienstleistung Verschaffen Sie sich einen kurzen Überblick über jeden Dienst.

Detaillierte Schritte zur Installation von Open WebUI mit Harbor

1. vorbereitende Maßnahmen

- Sicherstellen, dass Docker und Docker Compose installiert sind

- Stellen Sie sicher, dass die Harbor CLI ordnungsgemäß installiert ist

- Stellen Sie sicher, dass Ihr System die grundlegenden Anforderungen erfüllt (8 GB oder mehr RAM empfohlen)

2. die Initialisierung der Harbor-Umgebung

# 初始化Harbor环境

harbor init

# 验证Harbor环境

harbor doctor

3. die Installation und Konfiguration von Open WebUI

3.1 Aktivieren der WebUI-Dienste

# 启用Open WebUI服务

harbor enable webui

3.2 Konfiguration der Basisparameter (optional)

# 配置WebUI版本(如果需要指定特定版本)

harbor webui version <version>

# 配置WebUI端口(默认为8080)

harbor config set webui.port <port_number>

4. die Aktivierung der Dienste

# 启动所有已启用的服务,包括WebUI

harbor up

# 或者仅启动WebUI服务

harbor up webui

5. die Überprüfung der Installation

- Rufen Sie http://localhost:8080 (oder einen anderen von Ihnen eingerichteten Anschluss) auf.

- Prüfen Sie den Status des Dienstes:

harbor ps

6. gemeinsame Verwaltungsbefehle

Dienststatus prüfen

# 查看所有运行中的服务

harbor ps

# 查看WebUI日志

harbor logs webui

Servicemanagement

# 停止WebUI服务

harbor stop webui

# 重启WebUI服务

harbor restart webui

# 更新WebUI版本

harbor webui version latest

harbor restart webui

7. die Integration von Ollama (fakultativ)

Wenn Sie eine Verbindung zu Ollama über WebUI herstellen möchten:

# 启用Ollama服务

harbor enable ollama

# 重启服务

harbor restart

8. die Fehlersuche bei allgemeinen Problemen

Überprüfung des Gesundheitszustands des Dienstes

harbor doctor

Spezifische Fehlermeldungen anzeigen

harbor logs webui

Lösung von Hafenkonflikten

Wenn Port 8080 belegt ist:

# 修改WebUI端口

harbor config set webui.port 8081

harbor restart webui

9 Speicherort der Konfigurationsdatei

- Hauptkonfigurationsdatei:

~/.harbor/.env - WebUI-Konfiguration:

~/.harbor/open-webui/

10. die Empfehlungen zur Datensicherung

# 导出当前配置

harbor eject > harbor-backup.yaml

Vorbehalte:

- Sicherstellen, dass das System über ausreichende Ressourcen verfügt, um den Dienst auszuführen

- Beim ersten Start kann es einige Zeit dauern, bis das Image heruntergeladen ist.

- Wenn Sie Probleme mit den Berechtigungen haben, überprüfen Sie die Docker-Berechtigungseinstellungen

- Eine regelmäßige Sicherung der Konfigurationsdateien wird empfohlen

- Halten Sie Harbor und die zugehörigen Dienste auf dem neuesten Stand der Technik

开始使用:

1. 完成安装后,打开浏览器访问 http://localhost:8080

2. 首次访问时会要求进行基本设置

3. 可以开始使用Open WebUI进行AI对话了

需要帮助时可以使用:

```bash

harbor help webui© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...