Allgemeine Einführung

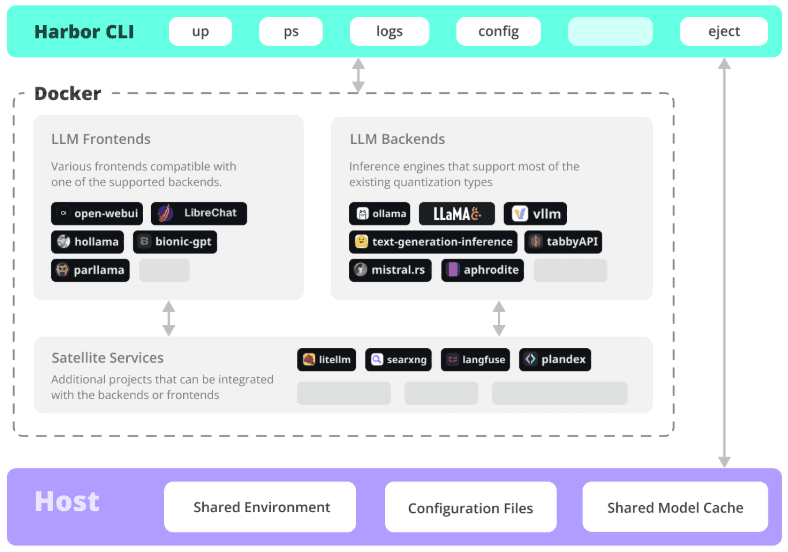

Harbor ist ein revolutionäres containerisiertes LLM-Toolset, das sich auf die Vereinfachung der Bereitstellung und Verwaltung von lokalen KI-Entwicklungsumgebungen konzentriert. Es ermöglicht Entwicklern den Start und die Verwaltung aller KI-Dienstkomponenten, einschließlich LLM-Backend, API-Schnittstelle, Front-End-Schnittstelle usw., mit einem einzigen Klick über eine übersichtliche Befehlszeilenschnittstelle (CLI) und unterstützende Anwendungen. Als Open-Source-Projekt eignet sich Harbor besonders für Entwickler, die schnell LLM-Anwendungen erstellen und mit ihnen experimentieren möchten. Es unterstützt nicht nur die gängigen KI-Modelle und -Dienste, sondern bietet auch flexible Konfigurationsoptionen und eine vollständige Toolchain, so dass sich die Entwickler auf die Anwendungsentwicklung und nicht auf die Umgebungskonfiguration konzentrieren können.Harbor verwendet das Apache 2.0 Open-Source-Protokoll, wird von der Community aktiv unterstützt, hat auf GitHub mehr als 770 Sternchen erhalten und wurde von vielen Entwicklern anerkannt und verwendet.

Funktionsliste

- Ein-Klick-Bereitstellung: Starten Sie eine komplette LLM-Dienstumgebung mit einem einzigen Befehl

- Container-Verwaltung: Integration von Docker und Docker Compose für die Orchestrierung von Diensten

- Multi-Backend-Unterstützung: Kompatibel mit einer Vielzahl von LLM-Engines und Modellformaten (GGUF, SafeTensors, etc.).

- Dienstintegration: Vorkonfigurierte API-Dienste und Front-End-Schnittstellen arbeiten zusammen

- Entwicklungstools: Bietet eine vollständige lokale Entwicklungs-Toolkette

- Konfigurationsflexibilität: Unterstützung für benutzerdefinierte Dienstkomponenten und Konfigurationsoptionen

- SSL-Zertifikate: Integrierte Certbot-Unterstützung für die einfache Konfiguration des HTTPS-Zugangs

- Umgebungsmigration: Unterstützung des Konfigurationsexports, einfache Migration in die Produktionsumgebung

- Überwachungsmanagement: Bietet eine Funktion zur Überwachung des Dienststatus und zur Protokollanzeige.

- Versionskontrolle: Unterstützung der Verwaltung verschiedener Versionen von KI-Dienstkomponenten

Hilfe verwenden

1. die Vorbereitung der Umwelt

1.1 Systemanforderungen

- Betriebssystem: Unterstützt Linux, MacOS oder Windows WSL2

- Docker-Engine 20.10+

- Docker Compose 1.18.0+

- Node.js 16+ (optional, für npm-Installationsmethode)

1.2 Installation von Harbor

# Weg 1: Installation mit npm

npm install -g @avlab/harbor

# Weg 2: Installieren mit curl

curl -sfL https://get.harbor.ai | sh

2. grundlegende Verwendung

2.1 Dienste starten

# Initialisierung der Harbor-Umgebung

harbor init

# Start aller Dienste

harbor up

# Prüfen des Dienststatus

harbor ps

2.2 Konfiguration des Dienstes

# Konfigurieren Sie den Modellpfad

harbor config set models.path /path/to/models

# Aktivieren Sie bestimmte Dienste

harbor enable chatui

harbor api freigeben

# Dienst deaktivieren

harbor dienst-name deaktivieren

3. erweiterte Funktionen

3.1 Konfiguration des SSL-Zertifikats

# Setzen von Umgebungsvariablen

export NGINX_SSL_CERT_FILENAME=fullchain.pem

export NGINX_SSL_CERT_KEY_FILENAME=privkey.pem

export CERTBOT_DOMAIN=Ihre_Domäne.com

exportieren CERTBOT_EMAIL=your@email.com

# Abrufen eines Zertifikats

hafen ssl-einrichtung

3.2 Benutzerdefinierte Konfiguration

# Export Konfiguration

Hafen auswerfen

# Konfigurationsdatei ändern

vim harbor.yaml

# Starten mit benutzerdefinierter Konfiguration

harbor up -c benutzerdefinierte-konfig.yaml

4. gemeinsame Betriebsverfahren

4.1 Einführung neuer Dienste

- Prüfen Sie die Liste der Dienste:

Hafenliste - Aktivieren Sie die gewünschten Dienste:

harbor enable <Dienstname - Konfigurieren Sie die Dienstparameter:

Hafenkonfiguration setzen - Starten Sie den Dienst:

Hafen aufwärts - Überprüfen Sie den Dienststatus:

hafen ps

4.2 Problemerkennung

# Anzeigen von Dienstprotokollen

harbor logs <Dienst-Name

# Dienststatus prüfen

harbor status

# Neustart des Dienstes

harbor Neustart

5. bewährte Praktiken

- Regelmäßige Sicherung der Konfigurationsdateien

- Verwaltung benutzerdefinierter Konfigurationen mit Versionskontrolle

- Überwachung der Nutzung von Dienstressourcen

- Harbor und die zugehörigen Komponenten auf dem neuesten Stand halten

- Beschleunigen Sie den Bereitstellungsprozess mit Projektvoreinstellungen

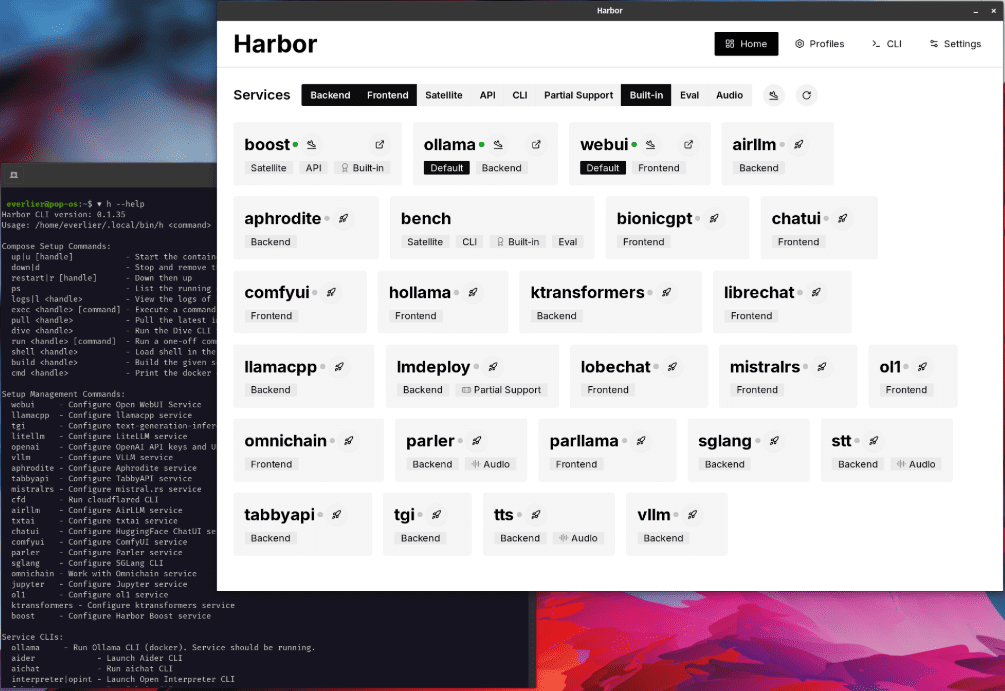

Installierbare AI-Dienste

Benutzer

WebUI öffnen ⦁︎ ComfyUI ⦁︎ LibreChat ⦁︎ HuggingFace ChatUI ⦁︎ Keulenschwätzer ⦁︎ Hollama ⦁︎ parllama ⦁︎ BionicGPT ⦁︎ AnythingLLM ⦁︎ Chat Nio

Backend-Dienst

Ollama ⦁︎ lama.cpp ⦁︎ vLLM ⦁︎ TabbyAPI ⦁︎ Aphrodite-Motor ⦁︎ mistral.rs ⦁︎ openai-sprache ⦁︎ faster-whisper-server ⦁︎ Parler ⦁︎ text-generierungs-inferenz ⦁︎ LMDeploy ⦁︎ AirLLM ⦁︎ SGLang ⦁︎ KTransformatoren ⦁︎ Nexa SDK

Erweiterungstools

Harbor Bank ⦁︎ Hafen Boost ⦁︎ SearXNG ⦁︎ Perplexica ⦁︎ Dify ⦁︎ Plandex ⦁︎ LiteLLM ⦁︎ LangFuse ⦁︎ Offener Dolmetscher ⦁ ︎cloudflared ⦁︎ cmdh ⦁︎ Stoff ⦁︎ txtai RAG ⦁︎ TextGrad ⦁︎ Aider ⦁︎ aichat ⦁︎ omnichain ⦁︎ lm-auswertung-geschirr ⦁︎ JupyterLab ⦁︎ ol1 ⦁︎ OpenHands ⦁︎ LitLytics ⦁︎ Repopack ⦁︎ n8n ⦁︎ Bolzen.neu ⦁︎ WebUI-Pipelines öffnen ⦁︎ Qdrant ⦁︎ K6 ⦁︎ Promptfoo ⦁︎ Webtop ⦁︎ OmniParser ⦁︎ Flowise ⦁︎ Langflow ⦁︎ OptiLLM

Siehe auch Dokumentation der Dienstleistung Verschaffen Sie sich einen kurzen Überblick über jeden Dienst.

Detaillierte Schritte zur Installation von Open WebUI mit Harbor

1. vorbereitende Maßnahmen

- Sicherstellen, dass Docker und Docker Compose installiert sind

- Stellen Sie sicher, dass die Harbor CLI ordnungsgemäß installiert ist

- Stellen Sie sicher, dass Ihr System die grundlegenden Anforderungen erfüllt (8 GB oder mehr RAM empfohlen)

2. die Initialisierung der Harbor-Umgebung

# Initialisierung der Harbor-Umgebung

Harbor-Init

# Überprüfen der Harbor-Umgebung

Hafendoktor

3. die Installation und Konfiguration von Open WebUI

3.1 Aktivieren der WebUI-Dienste

# Offenen WebUI-Dienst aktivieren

Hafen enable webui

3.2 Konfiguration der Basisparameter (optional)

# Konfigurieren Sie die WebUI-Version (wenn Sie eine bestimmte Version angeben müssen)

harbor webui version

# Konfigurieren Sie den WebUI-Port (Standard ist 8080)

harbor config set webui.port

4. die Aktivierung der Dienste

# Start aller aktivierten Dienste, einschließlich WebUI

Hafen auf

# oder nur WebUI-Dienste starten

WebUI einbinden

5. die Überprüfung der Installation

- Rufen Sie http://localhost:8080 (oder einen anderen von Ihnen eingerichteten Anschluss) auf.

- Prüfen Sie den Status des Dienstes:

hafen ps

6. gemeinsame Verwaltungsbefehle

Dienststatus prüfen

# Anzeigen aller laufenden Dienste

Hafen ps

# Anzeigen von WebUI-Protokollen

harbor logs webui

Servicemanagement

# WebUI-Dienst anhalten

Hafen stop webui

# Neustart des WebUI-Dienstes

hafen neu starten webui

# Aktualisieren der WebUI-Version

harbor webui neueste Version

Hafen Neustart Webui

7. die Integration von Ollama (fakultativ)

Wenn Sie eine Verbindung zu Ollama über WebUI herstellen möchten:

# Aktivieren Sie den Ollama-Dienst

Hafen freigeben ollama

# Dienst neu starten

Hafen-Neustart

8. die Fehlersuche bei allgemeinen Problemen

Überprüfung des Gesundheitszustands des Dienstes

Hafenarzt

Spezifische Fehlermeldungen anzeigen

hafen logs webui

Lösung von Hafenkonflikten

Wenn Port 8080 belegt ist:

# Ändern des WebUI-Ports

harbor config set webui.port 8081

Hafen Neustart WebUI

9 Speicherort der Konfigurationsdatei

- Hauptkonfigurationsdatei:

~/.harbour/.env - WebUI-Konfiguration:

~/.harbour/open-webui/

10. die Empfehlungen zur Datensicherung

# Exportieren Sie die aktuelle Konfiguration

harbor eject > harbor-backup.yaml

Vorbehalte:

- Sicherstellen, dass das System über ausreichende Ressourcen verfügt, um den Dienst auszuführen

- Beim ersten Start kann es einige Zeit dauern, bis das Image heruntergeladen ist.

- Wenn Sie Probleme mit den Berechtigungen haben, überprüfen Sie die Docker-Berechtigungseinstellungen

- Eine regelmäßige Sicherung der Konfigurationsdateien wird empfohlen

- Halten Sie Harbor und die zugehörigen Dienste auf dem neuesten Stand der Technik

Erste Schritte:

1. öffnen Sie nach Abschluss der Installation Ihren Browser und besuchen Sie http://localhost:8080.

2 Bei Ihrem ersten Besuch werden Sie aufgefordert, grundlegende Einstellungen vorzunehmen.

(3) Sie können mit Open WebUI für den AI-Dialog beginnen.

Wenn Sie Hilfe benötigen, können Sie folgendes benutzen:

```bash

Hafen Hilfe WebUI