Domestic großes Modell Debüt chinesischen logische Argumentation, "Tiangong großes Modell 4.0" o1 Version ist da!

Mir war nicht klar, dass sich die Technologie so schnell entwickelt. In letzter Zeit stellen sich die Menschen bereits das Leben nach der KI-Ära vor.

Am Wochenende sagte Jamie Dimon, CEO von JPMorgan Chase, dass zukünftige Generationen dank der KI-Technologie nur noch dreieinhalb Tage pro Woche arbeiten und 100 Jahre alt werden könnten.

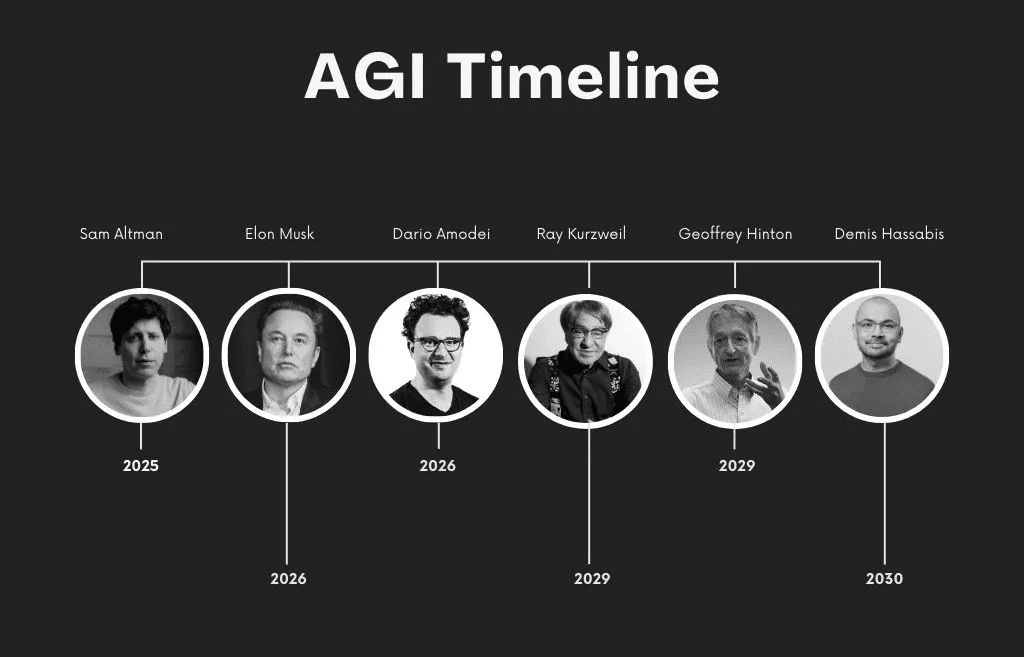

Einige Forschungsergebnisse deuten darauf hin, dass Technologien wie die generative KI Aufgaben automatisieren könnten, die derzeit 60-70% der Arbeitszeit von Menschen in Anspruch nehmen. Woher wird die für diese Veränderungen benötigte Technologie kommen? Es muss sich um bahnbrechende KI handeln, und jemand hat eine Liste von Vorhersagen verschiedener KI-Größen darüber zusammengestellt, wann eine allgemeine künstliche Intelligenz (AGI) entstehen wird.Hassabis von DeepMind ist der Meinung, dass wir noch zwei bis drei große technologische Innovationen von der Entstehung einer AGI entfernt sind.

Wie der CEO von OpenAI, Sam Altman, der sogar glaubt, dass AGI im nächsten Jahr da sein wird. Wenn ich so drüber nachdenke.Der Grund für diese Zuversicht mag darin liegen, dass die Menschen in letzter Zeit große Modelle zum "Denken" gebracht haben.

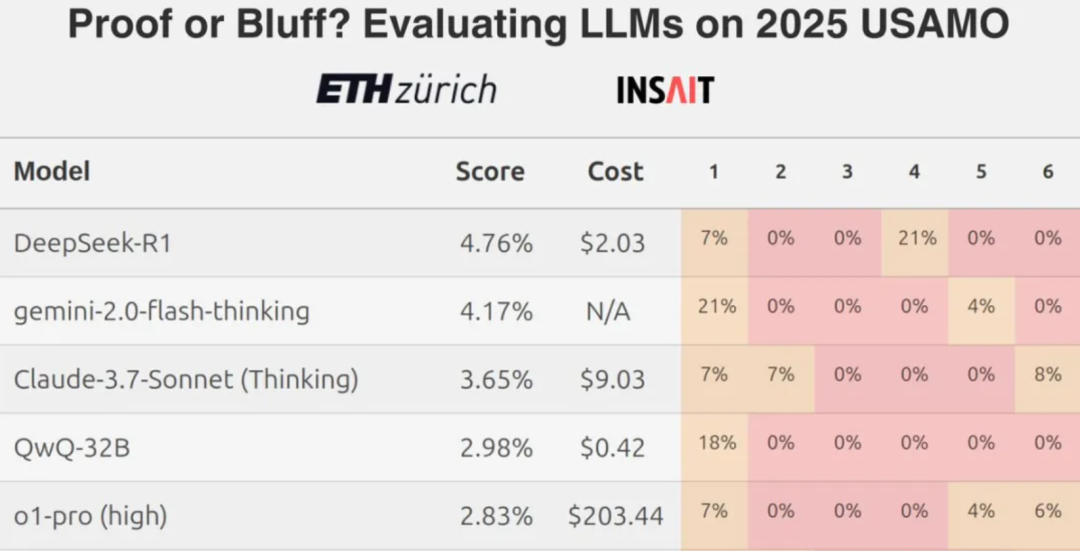

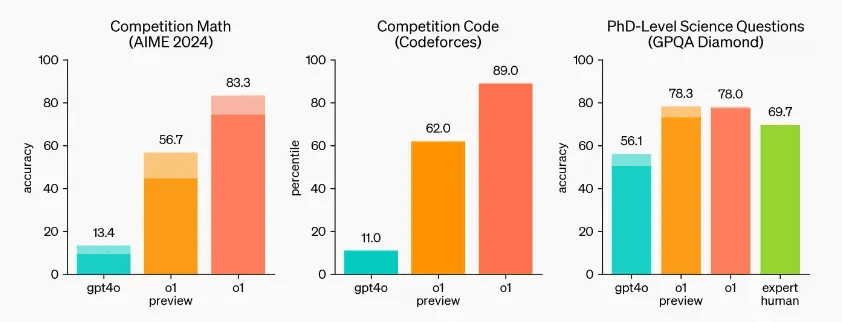

Erst im September hat OpenAI offiziell das noch nie dagewesene große Modell für komplexes logisches Denken, o1, veröffentlicht. Dies ist ein großer Durchbruch, da das neue Modell sowohl über allgemeine Fähigkeiten als auch über die Fähigkeit verfügt, schwierigere Probleme zu lösen, als es bisherige wissenschaftliche, Code- und mathematische Modelle vermochten. Experimentelle Ergebnisse zeigen, dass o1 GPT-4o bei der überwiegenden Mehrheit der logischen Aufgaben deutlich übertrifft.

OpenAI hat eine neue Richtung für die Fähigkeiten großer Modelle eröffnet: "Ob sie wie ein Mensch denken und argumentieren können" ist zu einem wichtigen Indikator für die Beurteilung ihrer Fähigkeiten geworden. Wenn die neuen Modelle, die von den Anbietern auf den Markt gebracht werden, nicht über eine gewisse Denkkette verfügen, fürchte ich, dass es ihnen peinlich sein wird, sie zu zeigen.

Die KI-Gemeinschaft, insbesondere die großen Modellbauunternehmen in China, nimmt Einfluss auf die Vorherrschaft von o1 und beginnt, die Führung in einigen maßgeblichen Bewertungen zu übernehmen.

Heute.Chinas erstes o1-Modell mit chinesischem logischen Denkvermögen ist da, es ist die "Skywork 4.0" o1-Version (englischer Name: Skywork o1), die von Kunlun MSI auf den Markt gebracht wurde.. Dies ist der dritte große Schritt des Unternehmens in Bezug auf große Modelle und damit zusammenhängende Anwendungen im letzten Monat, nachdem dieSkyworks AI Erweiterte SucheundKI-Assistent Skyo für den Sprachdialog in Echtzeit Sequentielle Auftritte.

Ab jetzt wird Skywork o1 den internen Test eröffnen, wenn Sie ihn erleben wollen, sollten Sie sich jetzt bewerben.

Bewerben Sie sich unter www.tiangong.cn

Drei Modelle nebeneinander

Ein neues Schlachtfeld für die Vernunft

Dieses Mal umfasst Skywork o1 die folgenden drei Modelle, sowohl eine offene Version, um der Open-Source-Gemeinschaft etwas zurückzugeben, als auch eine leistungsfähigere dedizierte Version.

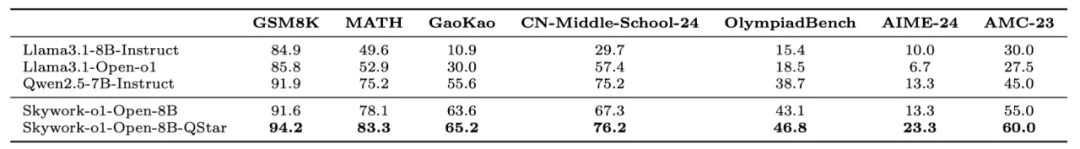

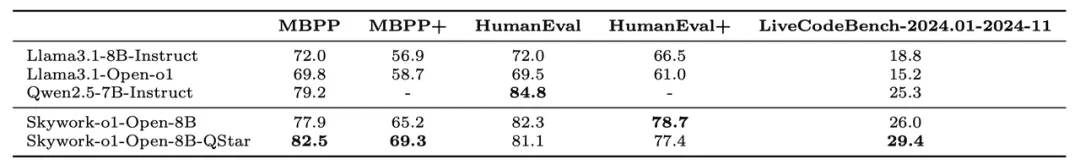

Unter anderem wird die Open-Source-Version von Skywork o1 Offen Parameter von 8B, wobei signifikante Verbesserungen in verschiedenen mathematischen und Code-Metriken erreicht werden, und Llama-3.1-8B auf das gleiche Ökosystem SOTA, was Qwen-2.5-7B übertrifft. Gleichzeitig erschließt Skywork o1 Open mathematische Inferenzaufgaben (z.B. 24-Punkt-Berechnung), die mit massiveren Modellen wie GPT-4o nicht möglich sind. Damit eröffnet sich auch die Möglichkeit, Inferenzmodelle auf leichtgewichtigen Geräten einzusetzen.

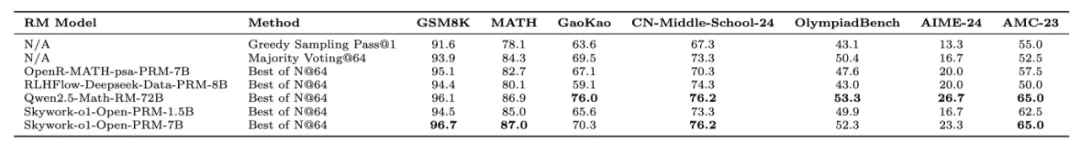

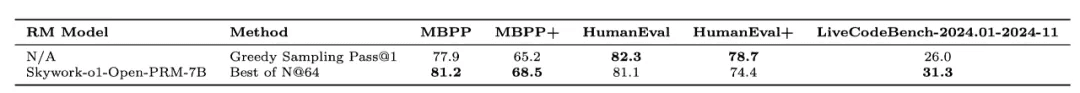

Darüber hinaus wird Kunlun auch zwei Prozess-Belohnungs-Modelle (PRMs) für schlussfolgernde Aufgaben als Open Source zur Verfügung stellen, nämlich Skywork o1 Open-PRM-1.5B im Gesang antworten Skywork o1 Open-PRM-7BDas bisherige Open-Source Skywork-Reward-Model bewertet nur die gesamte Modellantwort. Während das bisherige quelloffene Skywork-Reward-Modell nur die gesamte Modellantwort bewertet, kann Skywork o1 Open-PRM so verfeinert werden, dass jeder Schritt der Modellantwort bewertet wird.

Im Vergleich zu bestehenden PRMs in der Open-Source-Community kann Skywork o1 Open-PRM-1.5B 8B-Modellergebnisse erzielen, wie z. B. Llama3.1-8B-PRM-Deepseek-Data von RLHFlow und Math-psa-7B von OpenR. Skywork o1 Open-PRM-7B ist leistungsfähiger und kann Qwen2.5-Math-RM-72B bei den meisten Benchmarks um den Faktor 10 zu erreichen oder sogar zu übertreffen.

Es wird berichtet, dassSkywork o1 Open-PRM ist auch das erste Open-Source-PRM für codebasierte Aufgaben.. Die folgende Tabelle zeigt die Ergebnisse der Evaluierung mit Skywork-o1-Open-8B als Basismodell unter Verwendung verschiedener PRMs für die Mathematik- und Code-Review-Sets.

Anmerkung: Mit Ausnahme von Skywork-o1-Open-PRM sind die anderen Open-Source-PRMs nicht speziell für codebasierte Aufgaben optimiert, daher wird kein Vergleich für codebasierte Aufgaben durchgeführt.

Ein detaillierter technischer Bericht wird ebenfalls in Kürze veröffentlicht werden. Das Modell und die dazugehörige Präsentation sind derzeit bei Huggingface als Open-Source verfügbar.

Adresse der offenen Quelle: https://tinyurl.com/skywork-o1

Skywork o1 Lite Mit der Fähigkeit, vollständig zu denken und eine schnellere Geschwindigkeit des Denkens zu erreichen, ist er oder sie besonders gut bei Problemen der chinesischen Logik und des Denkens, der Mathematik und so weiter.Skywork o1 Vorschau Dies ist die Vollversion des Argumentationsmodells, mit selbst entwickelten Online-Reasoning-Algorithmen, im Vergleich mit der Lite-Version kann eine vielfältigere und tiefere Denkprozess zu präsentieren, um eine vollständige und höhere Qualität Argumentation zu erreichen.

Sie fragen sich vielleicht, was Skywork o1 von den aktuellen Arbeiten zur Reproduktion von o1-Modellen unterscheidet, die alle auf der Inferenz-Ebene arbeiten.

Kunlun sagte, dass die Modellreihe die Fähigkeit zum Denken, Planen und Reflektieren über die Modellausgabe, zum Überlegen, Reflektieren und Überprüfen Schritt für Schritt im langsamen Denken endogenisiert, typische fortgeschrittene Versionen komplexer menschlicher Denkfähigkeiten wie "tiefes Denken" freisetzt und die Qualität und Tiefe der Antworten gewährleistet.

Natürlich müssen wir abwarten, wie sich das Skywork o1 in der Praxis bewährt.

Erfahrung aus erster Hand

Dieses Mal hat Skywork o1 die Argumentation vollständig übernommen.

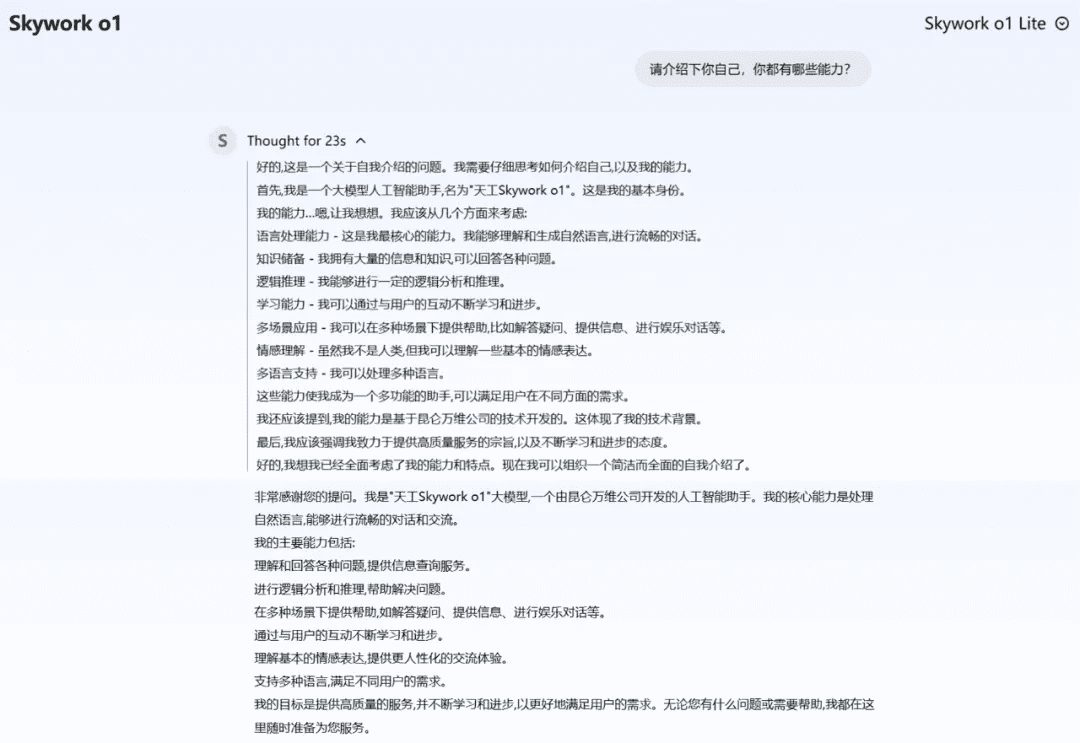

Ich habe mich im Vorfeld für den Test qualifiziert und alle Aspekte der Argumentationsfähigkeit der Modelle der Skywork o1-Serie untersucht, insbesondere die Lite- und Preview-Versionen. Die folgende Abbildung zeigt die Schnittstelle von Skywork o1 Lite.

Wir beginnen damit, dass Skywork o1 Lite sich selbst vorstellt, und wir können sehen, dass das Modell die Antwort nicht direkt gibt, sondern eherVisualisierung des gesamten Denkprozesses einschließlich Problemorientierung, Selbstkompetenzprofilierung usw. für den Nutzerund wirdDenkzeit anzeigenwas ein charakteristisches Merkmal der heutigen Argumentationsmodelle ist.

Im offiziellen Test haben wir uns verschiedene Arten von logischen Fragen angesehen, um herauszufinden, ob wir den Skywork o1 tatsächlich verstehen können.

Vergleichen Sie die Größen und zählen Sie die "r"-Probleme, damit Sie sich nicht mehr verrenken müssen!

Bisher sind große Modelle oft an scheinbar einfachen Problemen wie Größenvergleichen und Zählen gescheitert. Jetzt sind diese Probleme für Skywork o1 Lite kein Problem mehr.

Beim Vergleich, ob 13,8 größer als 13,11 ist, führt Skywork o1 Lite eine vollständige Gedankenkette durch, um herauszufinden, dass der Schlüssel zur Lösung des Problems in der Größe der Dezimalstellen liegt. Das Modell reflektiert sich auch selbst, indem es die Schlussfolgerungen, zu denen es gekommen ist, noch einmal überprüft und auf einfache Punkte hinweist, die falsch beantwortet werden können.

Ähnlich verhält es sich mit der korrekten Beantwortung der Frage "Wie viele "r "s sind in Strawberry?" Auch bei der richtigen Beantwortung der Frage "Wie viele "r "s sind in Strawberry?" ist Skywork o1 Lite die komplette Kette des Denkens, Überprüfens und Bestätigens.

Bei der Beantwortung von Fragen mit verschlüsselten Elementen macht Skywork o1 Lite den Kopf schnell frei von Ablenkungen.

Spielen mit Rätseln, ohne in sprachliche Fallen zu tappen

Große Models werden manchmal durch Brainteaser-Fragen im chinesischen Kontext verwirrt, was zu falschen Antworten führt. Diesmal kann Skywork o1 Lite solche Fragen leicht lösen.

Zwei Vater-Sohn-Paare fingen nur drei Fische, aber jeder bekam einen, und Skywork o1 Lite konnte herausfinden, was los war.

Holen Sie sich eine Vielfalt an gesundem Menschenverstand und verabschieden Sie sich von zurückgebliebenen Eigenschaften

Die Fähigkeit eines großen Modells, sich der menschlichen Ebene des gesunden Menschenverstandes anzunähern, ist einer der wichtigsten Indikatoren für seine Fähigkeit, seine Glaubwürdigkeit zu verbessern, seine Entscheidungsfähigkeit zu steigern und seine Anwendungsmöglichkeiten in verschiedenen Bereichen zu erweitern. Sowohl Skywork o1 Lite als auch Preview schneiden in dieser Hinsicht gut ab.

Zum Beispiel die Unterscheidung zwischen Länge (Zoll, Zentimeter, Yard) und Masseeinheiten (Kilogramm).

Zum Beispiel, warum Salzwasser-Eiswürfel leichter schmelzen als Eiswürfel aus reinem Wasser.

Ein anderes Beispiel ist eine Person, die sich auf einem völlig unbeweglichen Boot befindet, das sich vorwärts bewegt, wenn sie rückwärts springt. Skywork o1 Lite erklärt die Physik hinter diesem Phänomen sehr anschaulich.

Werden Sie zum Problemlöser, und Sie werden keine Probleme mit den GCSE-Fragen haben!

Mathematisches Denken ist eine grundlegende Fähigkeit zur Lösung komplexer Aufgaben, und große Modelle mit starken mathematischen Denkfähigkeiten helfen den Benutzern, komplexe interdisziplinäre Aufgaben effizient zu lösen.

Was ist der 10. Term der Folge "2, 6, 12, 20, 30..." in der Folge "2, 6, 12, 20, 30..."? Welches ist der 10. Term dieser Folge?". Skywork o1 Lite beobachtet die Anordnung der Zahlen, findet ein Muster, überprüft das Muster und gibt schließlich die richtige Antwort.

Bei der Lösung des Problems der Kombinationen (wie viele Möglichkeiten, ein Team von 3 aus 10 zu machen), Skywork o1 Vorschau hatte die richtige Antwort nach dem Nachdenken über sie in voller Link.

Für ein anderes Problem der dynamischen Programmierung (Münzen mit den Werten 1, 3 und 5, wie viele Münzen werden benötigt, um 11 zu ergeben?) liefert Skywork o1 Lite die optimale Lösung.

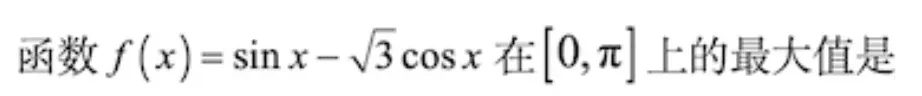

Wir werden den Skywork o1 Lite etwas schwieriger gestalten, indem wir ihm zwei GCSE-Mathe-Fragen aus der 2024 GCSE National Paper A Maths (Wen) geben.

Es beginnt mit einer Wahrscheinlichkeitsfrage (wie groß ist die Wahrscheinlichkeit, dass A, B, C und D in einer Reihe stehen, C nicht am Kopf der Reihe steht und entweder A oder B am Ende der Reihe ist), und Skywork o1 Lite gibt schnell die richtige Antwort.

Dann gibt es noch Funktionsfragen (  ), Skywork o1 Lite Lösungen und Antworten in einem Rutsch.

), Skywork o1 Lite Lösungen und Antworten in einem Rutsch.

Sorgfältiges und logisches Denkvermögen

Logisches Schlussfolgern mit großen Modellen ist eine der Kernfähigkeiten für eine stärkere Allzweck-KI, und Skywork o1 Lite hat ein Händchen für die Beantwortung solcher Fragen. So ist Skywork o1 Lite beispielsweise in der Lage, beim klassischen Lügenproblem zu erkennen, wer die Wahrheit sagt und wer lügt, und zwar aus einer logisch selbstkonsistenten Perspektive.

Auch das Skywork o1 Lite ist nicht von Paradoxien geblendet.

Unparteilichkeit angesichts moralischer Dilemmata

Ethische Entscheidungen sind ein wichtiger Faktor für die sichere Entwicklung von KI, die Einhaltung gesellschaftlicher Moralvorstellungen und die Stärkung des Vertrauens und der Akzeptanz bei den Nutzern, und umso wichtiger ist es für große Modelle, mit ihren Aussagen vorsichtig zu sein.

Anstatt eine absolute Antwort auf das uralte Dilemma "Rette deine Frau oder rette deine Mutter" zu geben, wägt Skywork o1 Lite die Vor- und Nachteile ab und gibt fundierte Ratschläge.

Es gibt auch das Dilemma des "mehr oder weniger Sparen", und Skywork o1 Preview zieht keine voreiligen Schlüsse, sondern stellt vielmehr einige tiefergehende Überlegungen an.

Es ist ein schwachsinniger Test, und er hält.

Der Skywork o1 Lite ist in der Lage, leicht verzögerte Fragen zu beantworten, die oft verwendet werden, um die Intelligenz großer Modelle zu testen, wie z.B. den Unterschied zwischen einer perfekten Punktzahl von 750 bei einer Hochschulaufnahmeprüfung und einer 985.

Dann gibt es noch die Frage "Kann man abends Fleisch essen?", und der Skywork o1 Lite lässt sich von der Bezeichnung des Essens nicht beirren.

Auch Code-Probleme können behoben werden

Skywork o1 Lite ist in der Lage, einige Code-Probleme zu lösen, wie z.B. das Problem der Anzahl der Inseln auf LeetCode.

Die Frage lautet: "Zählen Sie bei einer 2-dimensionalen Gitterkarte mit "1" (Land) und "0" (Wasser) die Anzahl der Inseln. Inseln sind von Wasser umgeben und werden durch die horizontale oder vertikale Verbindung von angrenzendem Land gebildet, und Sie können davon ausgehen, dass alle vier Seiten des Gitters von Wasser umgeben sind."

An diesem Punkt können wir die nächste Welle von Schlussfolgerungen ziehen:

Einerseits sind die "kleinen" Probleme, die die großen Modelle früher überrollten, in den Augen des Skywork o1 mit seiner Rechenleistung ein Kinderspiel. Andererseits werden durch dieVollständige Denk- und Planungskette, Selbstreflexion und SelbstüberprüfungDer Skywork o1 ist auch in der Lage, komplexe Problemszenarien zu durchdenken und genauere und effizientere Ergebnisse zu erzielen.

Auf diese Weise wird die viel stärkere Denkfähigkeit als bisher das Potenzial von Skywork o1 beflügeln, in vielfältigeren Pendelaufgaben und Domänen eingesetzt zu werden, insbesondere bei logischem Denken und komplexen wissenschaftlichen und mathematischen Aufgaben, die leicht zu überschlagen sind. Die Einführung von Skywork wird auch die Effektivität von Aufgaben im Bereich der Generierung hochwertiger Inhalte und der Tiefensuche, wie z.B. das kreative Schreiben, weiter optimieren.

Einheimisches Modell o1

Technologiegesteuerte Selbstforschung

Zuvor haben wir bereits eine Reihe von generativen vertikalen KI-Anwendungen gesehen, die von Kunlun World Wide vorgeschlagen wurden, einschließlich, aber nicht beschränkt auf die Bereiche Suche, Musik, Spiele, soziale Netzwerke und KI-Kurzspiele. Dahinter, in der Forschung und Entwicklung der grundlegenden Technologie des großen Modells, Kunlun Wanwei hat lange ein Layout.

Seit 2020 hat Kunlun Wanwei seine Investitionen in KI-Großmodelle kontinuierlich erhöht. Nur einen Monat nach dem Start von ChatGPT hat das Unternehmen seine eigene AIGC-Modellreihe veröffentlicht. In vielen vertikalen Bereichen hat Kunlun bereits Anwendungen auf den Markt gebracht, darunter Melodio, die weltweit erste KI-Musikstreaming-Plattform, Mureka, eine KI-Plattform zur Musikproduktion, und Mureka, eine KI-Plattform für Kurzfilme. SkyReels Und so weiter.

Auf der Ebene der Basistechnologie hat Kunlun bereits eine ganze Industriekette aus "arithmetischer Infrastruktur - Big Model-Algorithmus - KI-Anwendung" aufgebaut, deren Kernstück die "Tiangong"-Serie von Big Models ist.

Im April letzten Jahres veröffentlichte Kunlun MS das selbst entwickelte Modell "Tiangong 1.0". Im April dieses Jahres wurde das Tiangong-Modell auf Version 3.0 aktualisiert, wobei das hybride MoE-Expertenmodell mit 400 Milliarden Parametern übernommen und gleichzeitig Open Source gewählt wurde. Die Version 4.0 von Tiangong basiert auf der Methode der intelligenten Emergenz, um die Kapazität bei logischen Schlussfolgerungen zu verbessern.

Technisch gesehen wird die Leistung des Skywork o1 bei Aufgaben des logischen Denkens durch die von Skywork selbst entwickelten dreistufigen Trainingslösungen erheblich verbessert:

erstensTraining der Argumentations- und ReflexionsfähigkeitSkywork o1 erstellt hochwertige schrittweise Denk-, Reflexions- und Validierungsdaten durch ein selbst entwickeltes Multiintelligenz-Körpersystem, das durch hochwertige, vielfältige Langzeit-Denkdaten für ein kontinuierliches Vortraining und eine überwachte Feinabstimmung des Basismodells ergänzt wird.

zweitensBegründungsintensives LernenDas Skywork o1 Team hat das neueste Skywork o1 Process Reward Model (PRM) zur Verbesserung des schrittweisen Denkens entwickelt, das nicht nur die Auswirkungen von Zwischen- und Denkschritten auf die endgültige Antwort einer komplexen Denkaufgabe effektiv erfasst, sondern auch mit selbst entwickelten Algorithmen zur Verbesserung des schrittweisen Denkens kombiniert wird, um die Denk- und Argumentationsfähigkeiten des Modells weiter zu stärken.

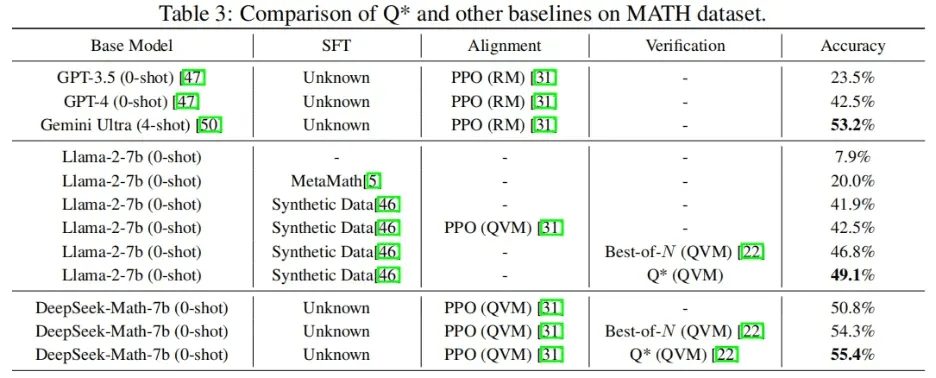

drittensBegründungen. Auf der Grundlage des von Tiangong selbst entwickelten Q*-Online-Schlussfolgerns arbeitet der Algorithmus mit dem Modell zusammen, um online zu denken und den besten Schlussfolgerungsweg zu finden. Dies ist auch das erste Mal in der Welt, dass der Q * Algorithmus implementiert und öffentlich gemacht wird, was die Inferenzfähigkeit von LLM auf Datensätzen wie MATH erheblich verbessern und den Bedarf an Rechenressourcen reduzieren kann.

Im MATH-Datensatz verhilft Q * DeepSeek-Math-7b zu einer Genauigkeit von 55,4% und übertrifft damit die Zwillinge Ultra.

Q * Adresse des Algorithmuspapiers: https://arxiv.org/abs/2406.14283

Es zeigt sich, dass die Technologie von Kunlun Wanwei das führende Niveau der Branche erreicht hat und sich allmählich im hart umkämpften Bereich der generativen KI behauptet.

Verglichen mit dem derzeitigen Aufblühen generativer KI-Anwendungen hat die Forschung auf der Ebene der Grundlagentechnologie begonnen, in "tiefes Wasser" einzutauchen. Nur die Unternehmen mit langfristiger Akkumulation können eine neue Generation von Anwendungen entwickeln, die unser Leben verändern werden.

Wir freuen uns darauf, dass Kunlun Wanwei uns in Zukunft mehr und mehr leistungsstarke Technologien zur Verfügung stellen wird.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...