Allgemeine Einführung

GPT Crawler ist ein Open-Source-Tool, das es Benutzern ermöglicht, Wissensdateien zu generieren, indem sie den Inhalt einer bestimmten Website crawlen, was wiederum maßgeschneiderte GPT-Modelle erzeugt. Das Projekt wird hauptsächlich zum Crawlen und Organisieren von Webinformationen verwendet, unterstützt die Ausführung über die API und den lokalen Einsatz. Die Nutzer können den Crawler flexibel konfigurieren, um ihn an unterschiedliche Website-Strukturen und -Anforderungen anzupassen und so für den eigenen Gebrauch geeignete Wissensdatenbanken zu erstellen.

Funktionsliste

- Crawling von Website-Inhalten zur Erstellung von Wissensdateien

- Unterstützt API und lokale Bereitstellungsläufe

- Flexible Konfiguration der Crawler-Parameter

- Erzeugen von kundenspezifischen GPT-Modellen

- Unterstützt den Ausschluss von mehreren Dateiformaten

Hilfe verwenden

Ablauf der Installation

- Klon-Lager: Stellen Sie zunächst sicher, dass Sie Node.js >= 16 installiert haben. Führen Sie dann den folgenden Befehl aus, um das Repository zu klonen:

git klonen. https://github.com/BuilderIO/gpt-crawler - Installation von Abhängigkeiten: Wechseln Sie in das Projektverzeichnis und installieren Sie die Abhängigkeiten:

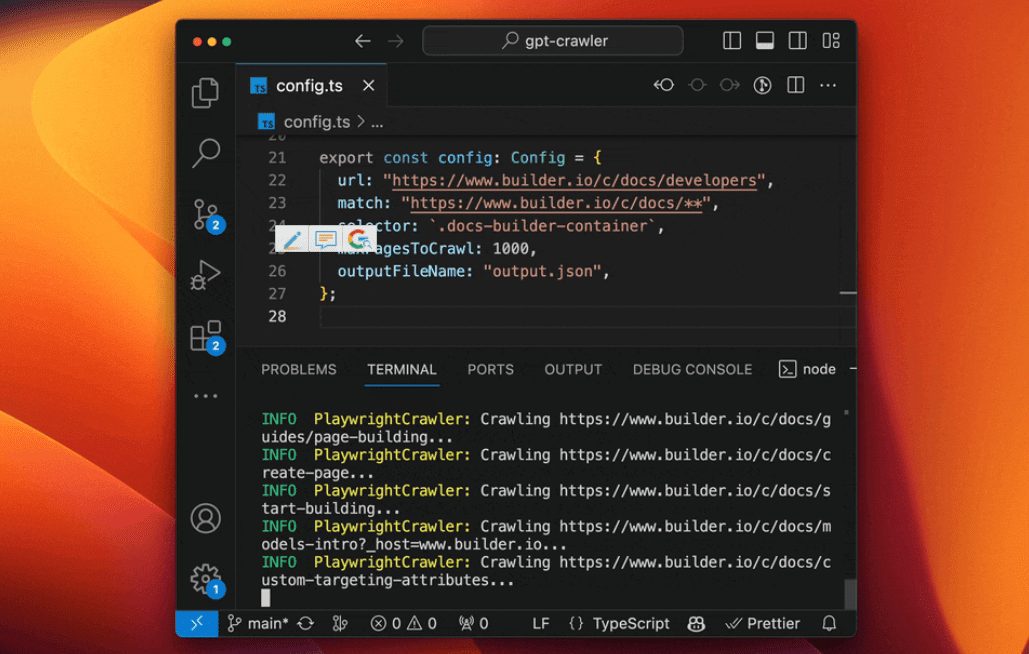

cd gpt-crawler npm-Installation - Den Crawler konfigurieren: Öffnen

config.tsDatei, bearbeiten Sie dieurlim Gesang antwortenSelektorEigenschaft an Ihre Bedürfnisse anpassen. Um zum Beispiel Builder.io-Dokumente zu crawlen, können Sie die folgende Konfiguration verwenden:exportieren const defaultConfig: Konfigurieren Sie = { url: "https://www.builder.io/c/docs/developers", Spiel: "https://www.builder.io/c/docs/**", Selektor: ".docs-builder-container", maxPagesToCrawl: 50, outputFileName: "output.json", }; - Ausführen des CrawlersSobald die Konfiguration abgeschlossen ist, führen Sie den folgenden Befehl aus, um den Crawler zu starten:

npm run start

Anweisungen für den Gebrauch

- Konfigurationsdatei: in

config.tsDatei können Sie Parameter wie die Start-URL des Crawlers, das Übereinstimmungsmuster, den Selektor, die maximale Anzahl der zu crawlenden Seiten usw. festlegen. Stellen Sie sicher, dass diese Parameter mit der Struktur der Zielsite übereinstimmen. - Ausführen des Crawlers: Verwendung

npm run startstartet den Crawler, der den Inhalt der Website durchsucht und auf der Grundlage der Parameter in der Konfigurationsdatei Wissensdateien erzeugt. - GPT-Modell generierenSobald der Crawler abgeschlossen ist, werden die erzeugten Wissensdateien im Projektverzeichnis gespeichert. Sie können diese Dateien in OpenAI oder andere GPT-Dienste hochladen, um eigene GPT-Modelle zu erstellen.

- API-VerwendungWenn Sie den Crawler über die API laufen lassen wollen, können Sie die API-Dokumentation im Projekt nutzen, um den API-Dienst zu konfigurieren und zu starten.

caveat

- Ressourcenausschluss: in

config.tsDatei, können Sie dieresourceExclusionsAttribut schließt unerwünschte Dateitypen wie Bilder, Videos usw. aus. - Begrenzung der DateigrößeSie können einstellen

maxFileSizeim Gesang antwortenmaxTokensAttribut, das die maximale Größe der erzeugten Datei und die maximale Token Menge.