Google veröffentlicht Gemini 2.5: Große Verbesserungen bei den "Denk"-Fähigkeiten

Google DeepMind veröffentlichte am 25. März 2025 (zuletzt aktualisiert am 26. März) die nach eigenen Angaben intelligenteste Familie von KI-Modellen - die Gemini 2.5. Das erste Debüt des Gemini 2.5 Pro Experimental Die Version schneidet in mehreren Benchmarks hervorragend ab und zeigt deutliche Verbesserungen insbesondere bei den Argumentations- und Codierungsfähigkeiten sowie bei LMArena Mit deutlichem Abstand an der Spitze der Charts.

"Denkmodelle": mehr als Vorhersage, mehr als Argumentation

Gemini 2.5 Die Serie wird von Google als "Denkmodelle" definiert. Im Mittelpunkt dieses Konzepts steht die Fähigkeit der Modelle, einen internen "Denk-" oder Argumentationsprozess zu durchlaufen, bevor sie eine Antwort generieren, mit dem Ziel, die Leistung und Genauigkeit bei der Bewältigung komplexer Probleme zu verbessern. In der KI geht die Fähigkeit zum "Denken" über einfache Klassifizierung und Vorhersage hinaus und umfasst die Fähigkeit, Informationen zu analysieren, logische Schlussfolgerungen zu ziehen, Kontext und Nuancen zu verstehen und dementsprechend fundierte Entscheidungen zu treffen.

Forscher erforschen seit langem Möglichkeiten zur Verbesserung des KI-Schlussfolgerns, wie z. B. das Verstärkungslernen und Hinweise auf die Gedankenkette. Auf der Grundlage dieser Forschungen hat Google bereits das erste "Denkmodell" vorgestellt. Gemini 2.0 Flash Thinking. Die Freigabe der Gemini 2.5 Google sagt, dass es diese "Denk"-Fähigkeit in Zukunft in alle seine Modelle einbauen wird, um komplexere Probleme anzugehen und leistungsfähigere, besser kontextbewusste Agenten zu unterstützen. Diese "Denk"-Fähigkeit wird in alle Modelle eingebaut, um komplexere Probleme anzugehen und leistungsfähigere und kontextbewusste Agenten zu unterstützen. Dieser Mechanismus des "Denkens" und anschließenden "Antwortens" soll dazu beitragen, das bei KI-Modellen häufig auftretende Phänomen der "Illusion" zu verringern und die Zuverlässigkeit der Antworten zu verbessern.

Gemini 2.5 Pro Experimental Leistung

Laut den von Google veröffentlichten InformationenGemini 2.5 Pro Experimental Bei der Bewältigung komplexer Aufgaben steht sie derzeit an der Spitze. Sie ist sehr gut bei der Messung menschlicher Präferenzen in LMArena Ein deutlicher Vorsprung in den Diagrammen bedeutet in der Regel, dass das Modell nicht nur leistungsfähig ist, sondern dass auch der Stil, die Kohärenz und die Nützlichkeit seiner Ergebnisse von den Benutzern bevorzugt werden.

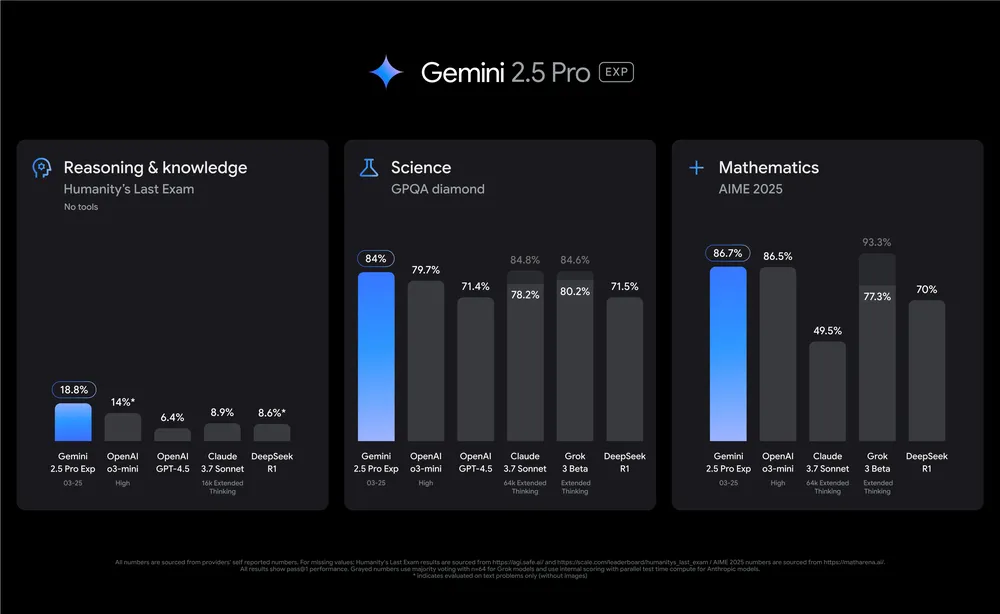

Was die spezifischen Benchmarks betrifft:

- logisches DenkvermögenDas Modell ist nützlich für mathematische und naturwissenschaftliche Vergleichstests, die fortgeschrittenes logisches Denken erfordern (z. B.

GPQAim Gesang antwortenAIME 2025) in führender Leistung und ohne den Einsatz von kostensteigernden Testzeittricks (z. B. Mehrheitsentscheidungen). In einem Test, mit dem die Grenzen des menschlichen Wissens und Denkens von Hunderten von Fachleuten bewertet werden sollen, ist dieHumanity’s Last Examauf den Datensatz.Gemini 2.5 ProEin Wert von 18,8% wurde ohne den Einsatz externer Hilfsmittel erreicht, was wiederum den Spitzenwert darstellt.

- Hinweis: Die obige Abbildung zeigt einen Vergleich der Modelle in Bezug auf logisches Denken, Naturwissenschaften und Mathematik unter Einbeziehung von OpenAI GPT-4.5 und Claude 3.7 Modellnamen und Daten wie z.B. Sonnet sind den von Google bereitgestellten Tabellen entnommen.

- Programmierkenntnisse::

Gemini 2.5In Bezug auf die Kodierung im Vergleich zuGemini 2.0hat einen riesigen Schritt nach vorn gemacht und sich auf die Erstellung von optisch ansprechenden Webanwendungen, Smart-Body-Code-Anwendungen sowie die Konvertierung und Bearbeitung von Code spezialisiert. Der Industriestandard für die Messung von Smart-Body-Code-FähigkeitenSWE-Bench VerifiedEin, unter Verwendung einer benutzerdefinierten Smart Body-Einstellung vonGemini 2.5 Proeine Punktzahl von 63,8% erreicht. google zeigte auch ein Beispiel für eineGemini 2.5 ProEs wurde ein einfaches Dinosaurier-Videospiel erstellt, bei dem die Fähigkeit des Systems genutzt wurde, auf der Grundlage einer einzigen Zeile von Eingabeaufforderungen ausführbaren Code zu erzeugen.

Vererbung und Entwicklung: Multimodalität und lange Kontexte

Gemini 2.5 vererbt Gemini Die wichtigsten Stärken der Serie: native multimodale Funktionen und lange Kontextfenster.Gemini 2.5 Pro Eine Million Unterstützer bei der Einführung Token Kontextfenster (und plant, es bald auf 2 Millionen Token zu erweitern) und übertrifft sein Vorgängermodell in diesem langen Fenster. Das bedeutet, dass es riesige Datensätze mit Text, Audio, Bildern, Video und sogar ganzen Codebasen verstehen und verarbeiten kann, um komplexe Probleme aus verschiedenen Informationsquellen zu bewältigen. Dies bietet ein erhebliches Anwendungspotenzial für Szenarien, die ein tiefes Verständnis langer Dokumente, die Analyse komplexer Code-Projekte oder die Verarbeitung langer Videoinhalte erfordern.

Die Tabelle wurde am 26. März aktualisiert, um die neue MRCR-Bewertung (Multi Round Coreference Resolution) aufzunehmen.

Verfügbarkeit und Zukunftsperspektiven

Derzeit.Gemini 2.5 Pro Experimental Die Version wurde veröffentlicht in Google AI Studio Den Entwicklern wurde ein Versuch imGemini Advanced Die Nutzer können das Modell auch über ein Dropdown-Menü auf Desktop- und Mobilgeräten verwenden. Das Modell wird voraussichtlich in den kommenden Wochen auf folgenden Websites erscheinen Vertex AI Google plant außerdem, in den kommenden Wochen Preisinformationen bekannt zu geben, die es den Nutzern ermöglichen, die Plattform in skalierten Produktionsumgebungen mit höheren Raten zu verwenden.

Die Kennzeichnung "Experimental" deutet darauf hin, dass die aktuelle Version noch schnell überarbeitet wird und dass die Nutzer bei der Verwendung möglicherweise auf eine gewisse Instabilität stoßen, während Google hofft, umfangreiches Feedback für eine kontinuierliche Verbesserung zu sammeln.Gemini 2.5 Die Veröffentlichung dieses neuen Sprachmodells, insbesondere seine Betonung des "Denkens" und seine starke Leistung bei Benchmarks, ist zweifellos ein weiterer Schritt nach vorn auf dem Gebiet der Sprachmodellierung in großem Maßstab, und seine weitere Entwicklung und praktische Anwendung verdienen große Aufmerksamkeit.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...