Allgemeine Einführung

GLM-Edge ist eine Reihe von großen Sprachmodellen und multimodalen Verständigungsmodellen, die von der Tsinghua-Universität für Endgeräte entwickelt wurden (Smart Spectrum Light Language). Zu diesen Modellen gehören GLM-Edge-1.5B-Chat, GLM-Edge-4B-Chat, GLM-Edge-V-2B und GLM-Edge-V-5B für Mobiltelefon-, Auto- bzw. PC-Plattformen. Die Modelle der GLM-Edge-Reihe konzentrieren sich auf die einfache praktische Anwendung und die Geschwindigkeit der Inferenz bei gleichzeitig hoher Leistung und zeichnen sich insbesondere durch die Qualcomm Snapdragon und Intel-Plattformen aus. Die Modelle der GLM-Edge-Serie konzentrieren sich auf die einfache Bereitstellung und die Geschwindigkeit der Inferenz bei gleichzeitiger Beibehaltung einer effizienten Leistung, insbesondere auf Qualcomm Snapdragon- und Intel-Plattformen. Benutzer können diese Modelle über Huggingface, ModelScope usw. herunterladen und verwenden und die Modellinferenz über verschiedene Inferenz-Backends (z. B. Transformers, OpenVINO, vLLM) durchführen.

GLM Randständiges Textmodell

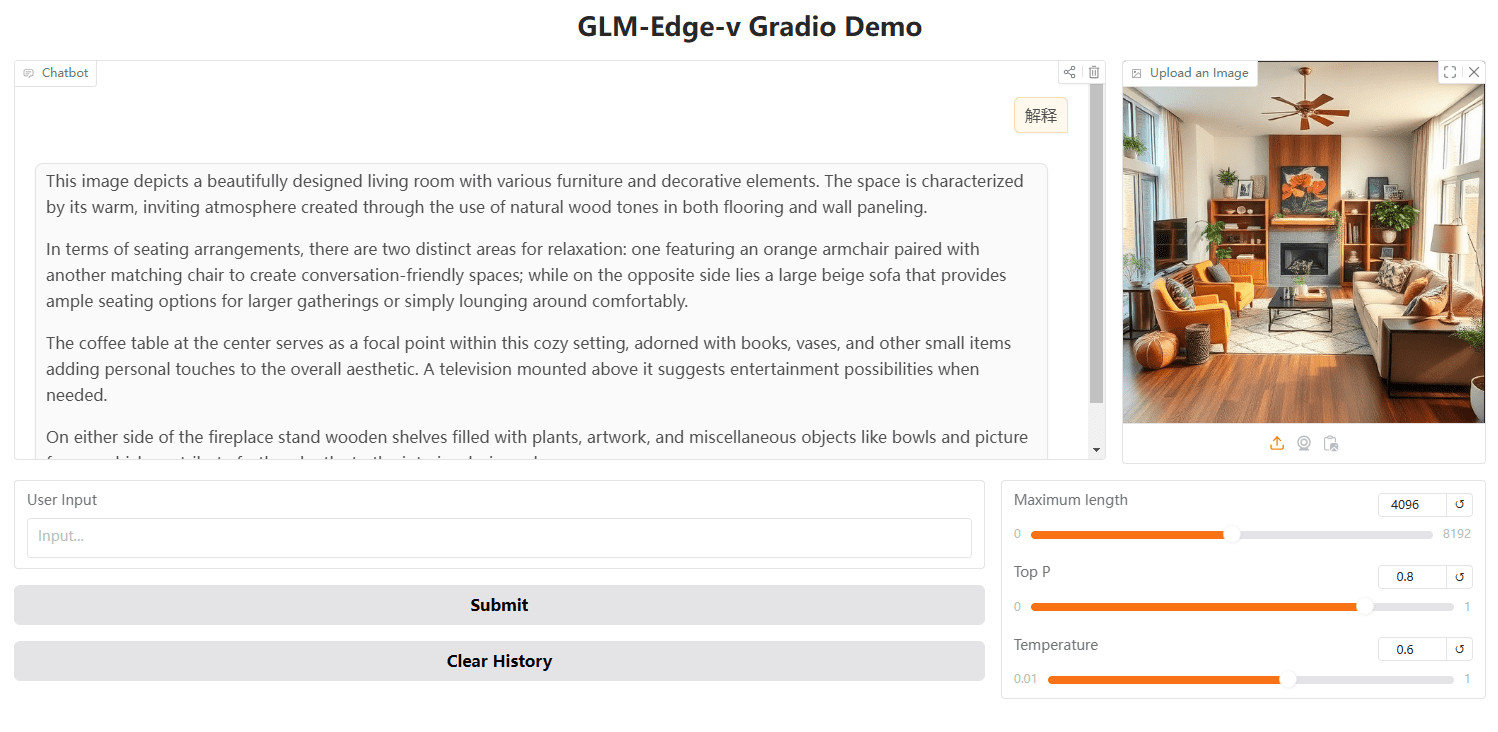

GLM Edge end-side visuelles Modell

Funktionsliste

- Mehrere ModelloptionenDialogmodelle und multimodale Verstehensmodelle auf verschiedenen Parameterskalen für eine breite Palette von Endgeräten.

- Effizientes ReasoningEffiziente Inferenzgeschwindigkeiten auf Qualcomm Snapdragon und Intel-Plattformen mit Unterstützung für hybride Quantisierungsverfahren.

- Unterstützung mehrerer PlattformenModelle können von Huggingface, ModelScope und anderen Plattformen heruntergeladen werden und unterstützen eine breite Palette von Inferenz-Backends.

- Einfacher EinsatzDetaillierte Installations- und Gebrauchsanweisungen für einen schnellen Einstieg.

- Unterstützung bei der FeinabstimmungFeinabstimmung: Bereitstellung von Tutorials und Konfigurationsdateien zur Unterstützung der Benutzer bei der Feinabstimmung ihrer Modelle entsprechend ihren spezifischen Bedürfnissen.

Hilfe verwenden

Installation von Abhängigkeiten

Stellen Sie sicher, dass Sie Python Version 3.10 oder höher haben. Und installieren Sie die Abhängigkeiten wie folgt:

pip install -r anforderungen.txt

modellhafte Argumentation

Wir stellen vLLM, OpenVINO und Transformatoren für die Back-End-Inferenz zur Verfügung, und Sie können die Modelle mit den folgenden Befehlen ausführen:

python cli_demo.py --backend transformers --model_path THUDM/glm-edge-1.5b-chat --precision bfloat16

python cli_demo.py --backend vllm ---model_path THUDM/glm-edge-1.5b-chat --precision bfloat16

python cli_demo.py --backend ov --model_path THUDM/glm-edge-1.5b-chat-ov --precision int4

Hinweis: Das OpenVINO-Versionsmodell muss konvertiert werden. Bitte gehen Sie auf die entsprechende Seite, um den Konvertierungscode auszuführen:

python convert_chat.py --model_path THUDM/glm-edge-1.5b-chat --precision int4

python convert.py --model_path THUDM/glm-edge-v-2b --precision int4

Feinabstimmung des Modells

Wir stellen Code für die Feinabstimmung des Modells zur Verfügung, bitte lesen Sie die Anleitung zur Feinabstimmung. Im Folgenden werden die grundlegenden Schritte für die Feinabstimmung beschrieben:

- Bereiten Sie den Datensatz vor und konfigurieren Sie die Trainingsparameter.

- Führen Sie das Feinabstimmungsskript aus:

OMP_NUM_THREADS=1 torchrun --standalone --nnodes=1 --nproc_per_node=8 finetune.py data/AdvertiseGen/ THUDM/glm-edge-4b-chat configs/lora. yaml

- Wenn Sie die Feinabstimmung vom Speicherpunkt aus fortsetzen wollen, können Sie einen vierten Parameter hinzufügen:

python finetune.py data/AdvertiseGen/ THUDM/glm-edge-4b-chat configs/lora.yaml yes

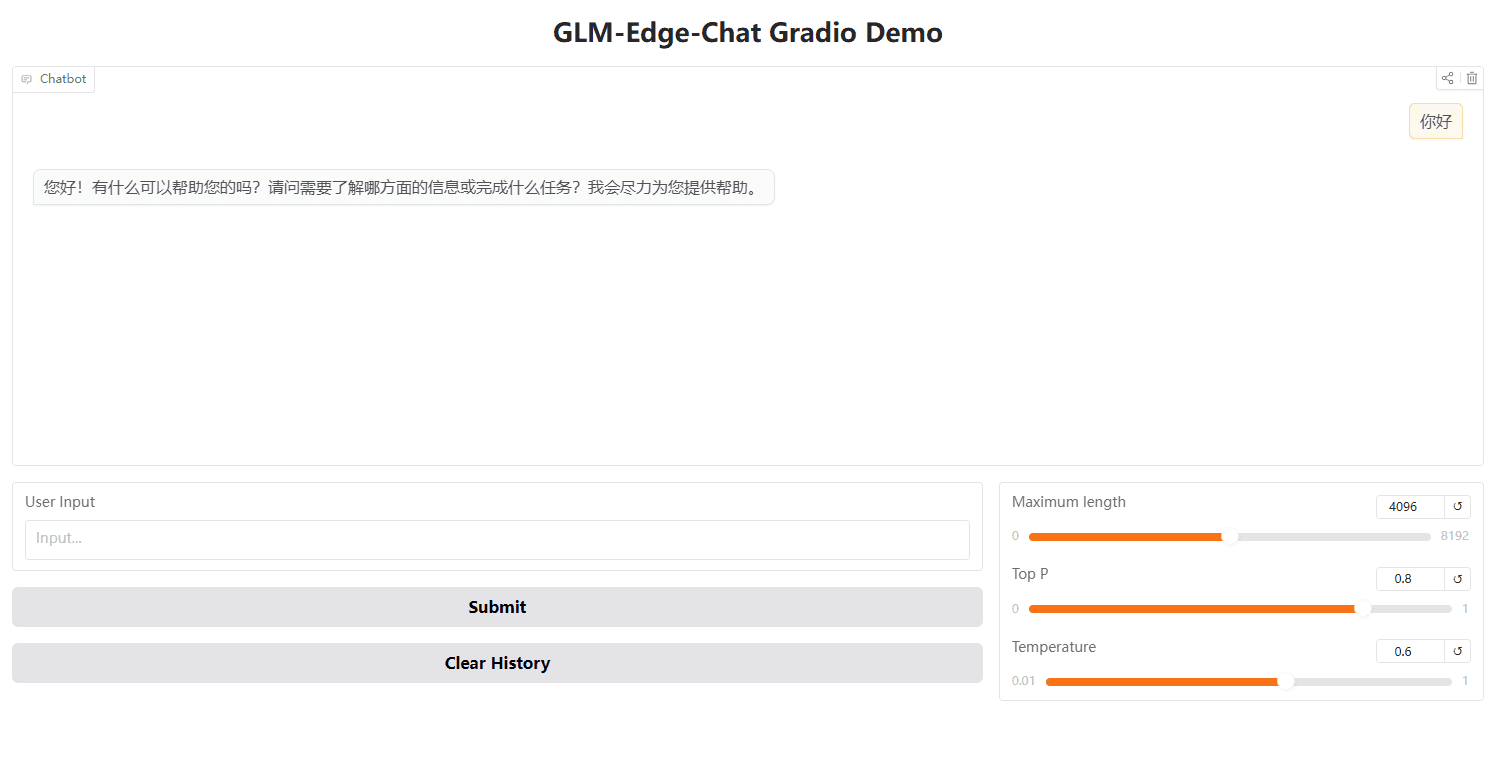

Starten der WebUI mit Gradio

Sie können auch Gradio verwenden, um die WebUI zu starten:

python cli_demo.py --backend transformers --model_path THUDM/glm-edge-1.5b-chat --precision bfloat16

Reasoning mit der OpenAI API

importieren openai

client = openai.Client(api_key="your_api_key", base_url="http://:/v1")

output = client.chat.completions.create(

model="glm-edge-v",

messages=[

{"role": "image_url", "image_url": {"url": "img.png"}}

],

max_tokens=512,

temperatur=0.7

)

print(output)