GLM-4.1V-Thinking - eine Familie von quelloffenen visuellen Sprachmodellen von Smart Spectrum AI

Was bedeutet GLM-4.1V-Thinking?

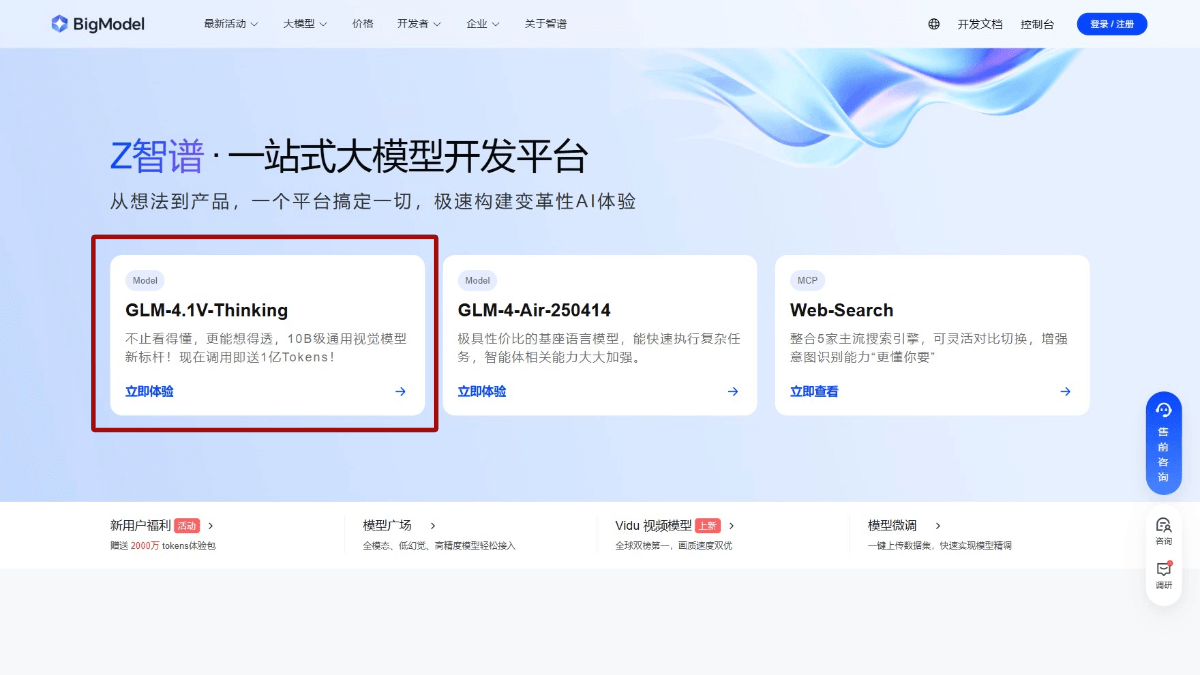

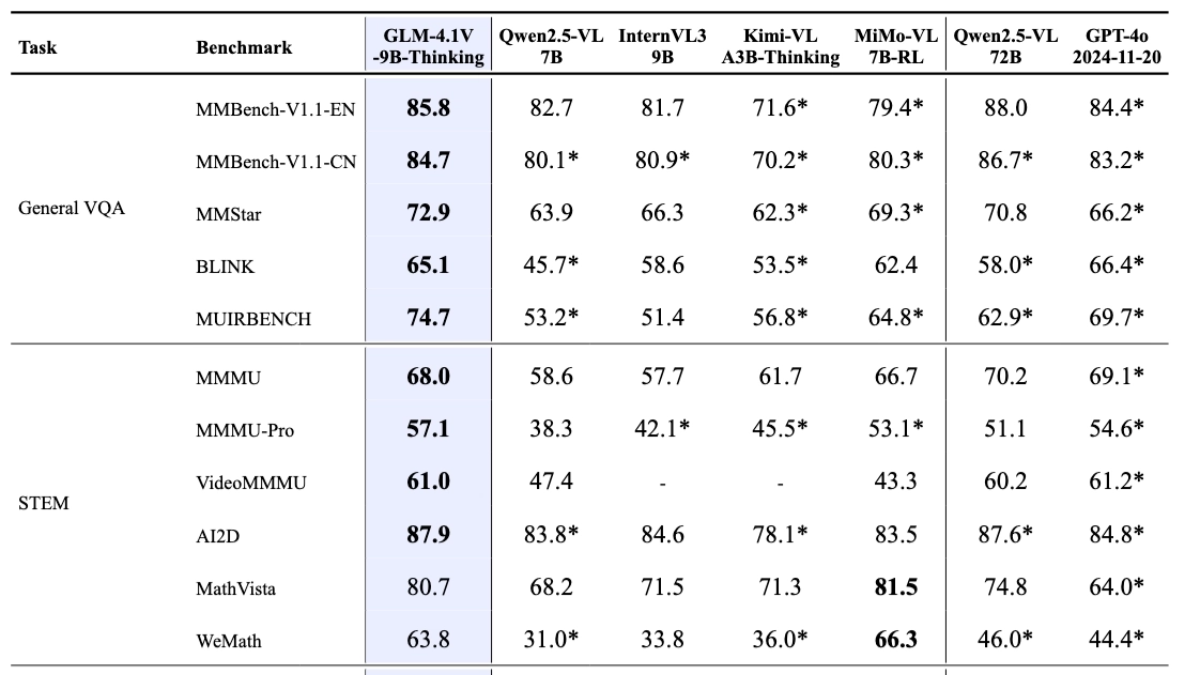

GLM-4.1V-Thinking ist ein quelloffenes visuelles Sprachmodell von Smart Spectrum AI, das für komplexe kognitive Aufgaben entwickelt wurde. GLM-4.1V-Thinking unterstützt multimodale Eingaben, die Bilder, Videos und Dokumente umfassen. Basierend auf der GLM-4V-Architektur führt das Modell einen Chain-of-Thinking-Mechanismus ein, verstärkt Lernstrategien mit Course Sampling und verbessert signifikant das cross-modale kausale Denken und die Stabilität. Die leichtgewichtige Version von GLM-4.1V-9B-Thinking (GLM-4.1V-9B-Basismodell und GLM-4.1V-9B-Thinking mit tiefgreifenden Denk- und Schlussfolgerungsfähigkeiten) hat 10B-Parameter und hat die beste Bewertung von Modellen auf 10B-Ebene in 23 von 28 maßgeblichen Bewertungen erhalten, von denen 18 der 72B-Parameteranzahl von Qwen- 2.5-VL entsprechen, was die hervorragende Leistung des kleinen Modells unterstreicht. Das Modell bietet eine breite Palette von Anwendungsmöglichkeiten in verschiedenen Bereichen wie Bildungsberatung, Erstellung von Inhalten, intelligente Interaktion, Industrieanwendungen sowie Unterhaltung und Leben.

Hauptmerkmale von GLM-4.1V-Thinking

- Starkes visuelles VerständnisGenaues Erkennen und Analysieren eines breiten Spektrums von Bildinhalten, einschließlich einfacher Zielerkennung, komplexerer Bildklassifizierungsaufgaben oder visueller Quizfragen, die ein umfassendes Verständnis des Bildes und die Beantwortung von Fragen erfordern.

- Hohes Niveau der VideoverarbeitungHervorragende Timing-Analyse- und Ereignislogik-Modellierungsfähigkeiten zur Unterstützung einer detaillierten Verarbeitung von Video-Inputs für das Videoverständnis, die Erstellung genauer Videobeschreibungen und die Beantwortung von Fragen zum Videoinhalt.

- Voll funktionsfähige DokumentenanalyseEs unterstützt die gleichzeitige Verarbeitung von Bildern und Textinhalten in Dokumenten, das Verstehen langer Dokumente, die genaue Analyse von Diagrammen und Grafiken sowie Fragen und Antworten auf der Grundlage des Dokumentinhalts - und das alles auf effiziente Weise.

- Ausgezeichnete ArgumentationsfähigkeitIn Mathematik und Naturwissenschaften: Lösen komplexer logischer Probleme, einschließlich des Lösens mehrstufiger mathematischer Probleme, Verstehen von Formeln und logischem Denken in den Naturwissenschaften, was das Lernen und Forschen in verwandten Disziplinen stark unterstützt.

- Logisches Denken ist präziseUnterstützung für komplexe logische Schlussfolgerungen und Kausalanalysen, die Aufgaben wie mehrstufige Schlussfolgerungen und logische Urteile erfüllen und den Benutzern helfen, eine Vielzahl komplexer Situationen besser zu verstehen und zu analysieren.

- Modalübergreifendes Denken ist effizientOrganische Verknüpfung von visuellen und verbalen Informationen für effizientes cross-modales Denken, Erledigung von Aufgaben wie grafisches Verständnis, visuelles Quiz und visuelle Verankerung sowie leistungsstarke Unterstützung bei der integrierten Verarbeitung multimodaler Informationen.

Leistungsvorteile von GLM-4.1V-Thinking

In 28 maßgeblichen Bewertungen wie MMStar, MMMU-Pro, ChartQAPro, OSWorld usw. hat GLM-4.1V-Thinking hervorragende Ergebnisse erzielt, von denen 23 Elemente die beste Leistung von Modellen der Klasse 10B erreicht haben und 18 Elemente gleichauf liegen oder sogar von Qwen-2.5-VL übertroffen werden, das eine Parameteranzahl von 72B hat, was die starke Leistung von Modellen mit kleinem Volumen voll und ganz unter Beweis stellt. Dies zeigt, wie leistungsfähig ein kleines Modell ist.

GLM-4.1V-Thinking's offizielle Website-Adresse

- GitHub-Repository:: https://github.com/THUDM/GLM-4.1V-Thinking

- HuggingFace-Modellbibliothek:: https://huggingface.co/collections/THUDM/glm-41v-thinking-6862bbfc44593a8601c2578d

- arXiv Technisches Papier:: https://arxiv.org/pdf/2507.01006v1

- Online-Erlebnis-Demo:: https://huggingface.co/spaces/THUDM/GLM-4.1V-9B-Thinking-Demo

Wie man GLM-4.1V-Thinking verwendet

- Verwendung der API-Schnittstelle::

- API-Schlüssel abrufenErstellen Sie eine App, um einen exklusiven API-Schlüssel für die Smart Spectrum AI-Plattform zu erhalten: https://bigmodel.cn/注册账号.

- Aufrufen der APIGemäß der API-Dokumentation rufen Sie die Modellschnittstelle mit einer HTTP-Anforderung auf, um Eingabedaten (z. B. Bild-URLs oder Base64-kodierte Daten, Text usw.) an das Modell zu senden und die Ausgabe des Modells zu erhalten. Beispiel: Aufruf mit Python-Code:

import requests

import json

api_url = "https://api.zhipuopen.com/v1/glm-4.1v-thinking"

api_key = "your_api_key"

input_data = {

"image": "image_url_or_base64_encoded_data",

"text": "your_input_text"

}

headers = {

"Authorization": f"Bearer {api_key}",

"Content-Type": "application/json"

}

response = requests.post(api_url, headers=headers, data=json.dumps(input_data))

result = response.json()

print(result)- Verwendung von Open-Source-Modellen::

- Modelle herunterladenBesuchen Sie die Plattform Hugging Face, suchen Sie die Seite GLM-4.1V-Thinking Models, und laden Sie die erforderlichen Modelldateien herunter.

- Modelle ladenLaden Sie das heruntergeladene Modell mit einem Deep Learning Framework wie PyTorch. Beispiel:

from transformers import AutoModelForVision2Seq, AutoProcessor

import torch

model_name = "THUDM/glm-4.1v-thinking"

model = AutoModelForVision2Seq.from_pretrained(model_name)

processor = AutoProcessor.from_pretrained(model_name)- Rückschlüsse ziehenVorverarbeitung von Eingabedaten (z. B. Bildpfade oder URLs, Text usw.) in das Modell und Erhalt der Ausgabe des Modells. Beispiel:

image_url = "image_url_or_image_path"

text = "your_input_text"

inputs = processor(images=image_url, text=text, return_tensors="pt")

with torch.no_grad():

outputs = model(**inputs)

result = processor.decode(outputs.logits[0], skip_special_tokens=True)

print(result)- Nutzung der Online-Erlebnisplattform::

- Zugang Erfahrung LinksBesuchen Sie die GLM-4.1V-Thinking-Erfahrungsseite direkt auf der Hugging Face-Plattform.

- EingangsdatenUpload von Daten wie Bildern oder Eingabe von Text auf einer Webseite.

- Ergebnisse erzielenKlicken Sie auf die Schaltfläche "Ausführen", warten Sie auf die Verarbeitung des Modells und sehen Sie sich die Ausgabe an, ohne dass Sie komplizierten Code schreiben und das Modell einsetzen müssen.

Die wichtigsten Vorteile von GLM-4.1V-Thinking

- Multimodale EingabeunterstützungUnterstützt mehrere Eingaben wie Bilder, Videos, Dokumente usw. und ist in der Lage, Informationen aus mehreren Quellen umfassend zu verarbeiten, um den Anforderungen komplexer Aufgaben gerecht zu werden.

- Starke ArgumentationEinführung eines Denkkettenmechanismus, der einen detaillierten Denkprozess mit schrittweisem Denken erzeugt, um die Leistung und Interpretierbarkeit komplexer Aufgaben zu verbessern.

- Wirksame SchulungsstrategienEine kursbasierte Sampling-Verstärkungslernstrategie, die die Trainingsschwierigkeit dynamisch anpasst und ein umfangreiches Vortraining mit einer Feinabstimmung kombiniert, um Leistung und Effizienz zu verbessern.

- Ausgezeichnete LeistungDie 10B-Parameteranzahl ist ein Modell mit geringem Platzbedarf, das sich in mehreren maßgeblichen Tests durch hohe Effizienz und Stabilität ausgezeichnet hat.

- Open Source und BenutzerfreundlichkeitDie Open-Source-Funktion senkt die Schwelle für die Nutzung und bietet mehrere Nutzungsmöglichkeiten, was die schnelle Integration und die Sekundärentwicklung durch Entwickler erleichtert.

Personen, für die GLM-4.1V-Thinking bestimmt ist

- BildungsberatungLehrergestützter Unterricht, der den Schülern umfangreichere Lernressourcen und detailliertere Problemlösungsschritte bietet.

- Ersteller von InhaltenWerbetexter, Betreiber sozialer Medien, Nachrichtenredakteure und andere erstellen kreative Inhalte durch die Kombination von Bildern und Text, um die Effizienz und Qualität der Erstellung zu verbessern.

- Unternehmen und EntwicklerUnternehmen integrieren Modelle in intelligente Kundendienstsysteme, um die Qualität des Kundendienstes zu verbessern, multimodale Eingaben zu unterstützen, die Bedürfnisse der Benutzer besser zu verstehen und präzise Antworten zu geben.

- Entwicklung von IndustrieanwendungenFachkräfte im Finanzwesen, im Gesundheitswesen und in der Industrie führen Aufgaben wie Datenanalyse, Berichterstellung und Geräteüberwachung durch, um die Effizienz und Genauigkeit zu verbessern.

- (wissenschaftlicher) ForscherForscher analysieren und verarbeiten multimodale Daten, um komplexe logische Aufgaben zu unterstützen und die Forschung in verwandten Bereichen voranzutreiben.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...