FunClip: Intelligente Bearbeitung von Videoinhalten zu Kurzfilmen, einfaches und genaues Extrahieren/Zuschneiden von Videoclips

Allgemeine Einführung

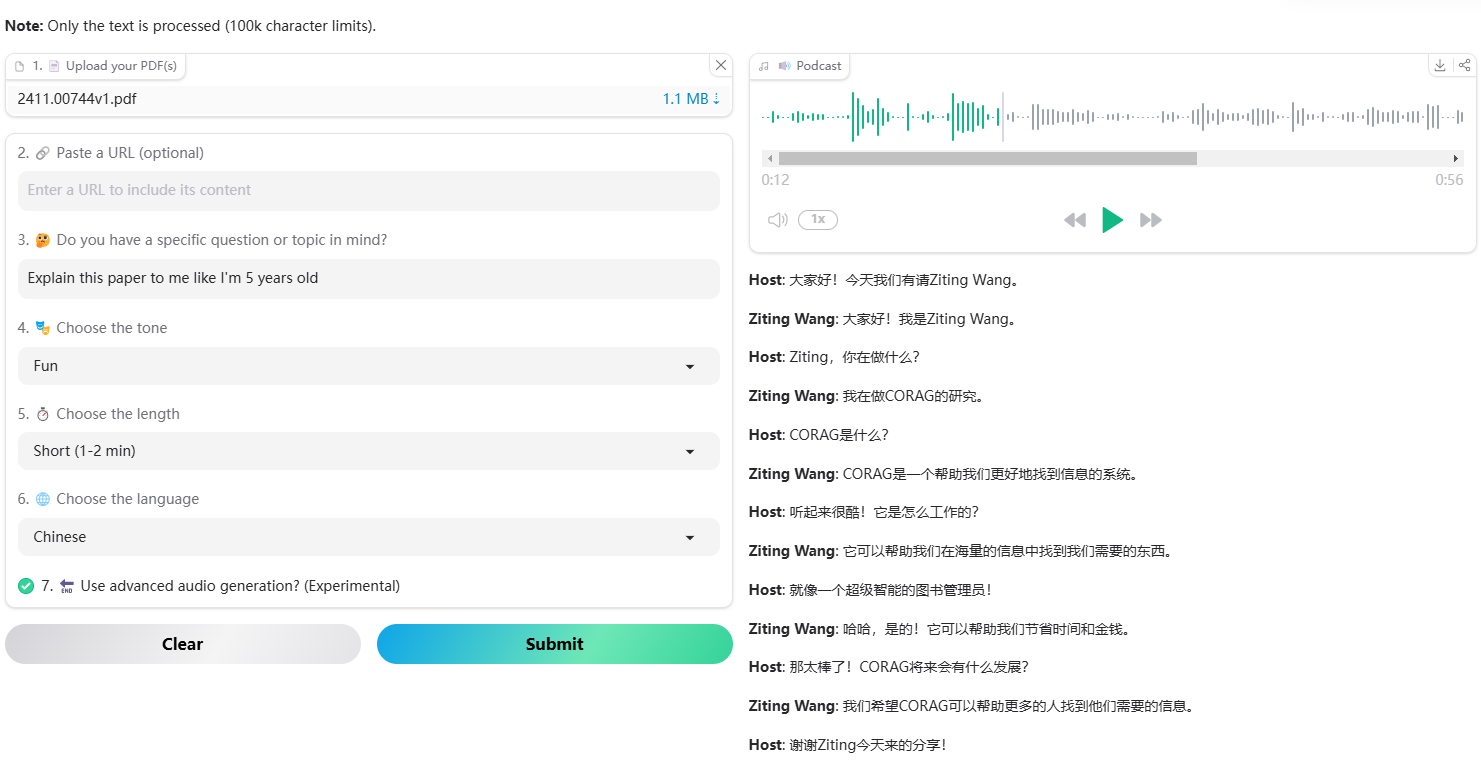

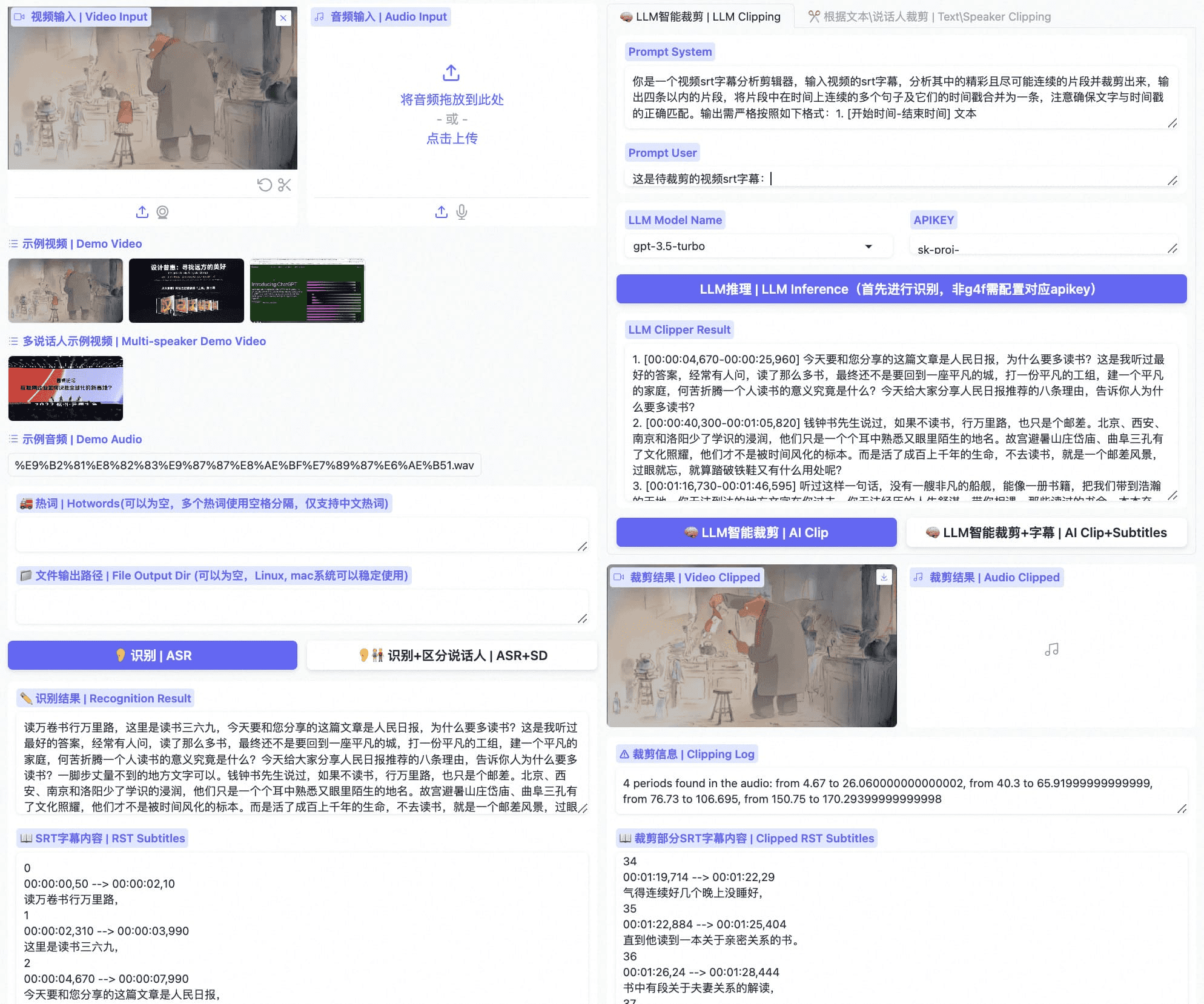

FunClip ist ein vollständig quelloffenes, lokalisiertes, automatisches Videobearbeitungstool, das vom TONGYI Speech Lab am Alibaba Dharma Institute entwickelt wurde. In das Tool ist das industrietaugliche Spracherkennungsmodell Paraformer-Large integriert, das den Sprachinhalt im Video genau identifizieren und in Text umwandeln kann. Das Besondere an FunClip ist, dass es intelligentes Editieren durch Large Language Modelling (LLM) unterstützt und eine Sprechererkennung integriert, um verschiedene Sprecher automatisch zu identifizieren. Die Benutzer können die gewünschten Textclips auswählen und die entsprechenden Videoclips mit einem Klick über eine einfache Benutzeroberfläche exportieren. Das Tool unterstützt die freie Bearbeitung von mehreren Segmenten und kann automatisch vollständige SRT-Untertiteldateien und Untertitel für die Zielsegmente generieren, was dem Benutzer eine einfache und bequeme Videobearbeitung ermöglicht. Die neueste Version unterstützt die zweisprachige Erkennung und bietet umfangreiche Funktionen zum Einbetten und Exportieren von Untertiteln - ein leistungsstarkes und benutzerfreundliches Open-Source-Videobearbeitungsprogramm.

FunClip Optimiert - Privat-ASR

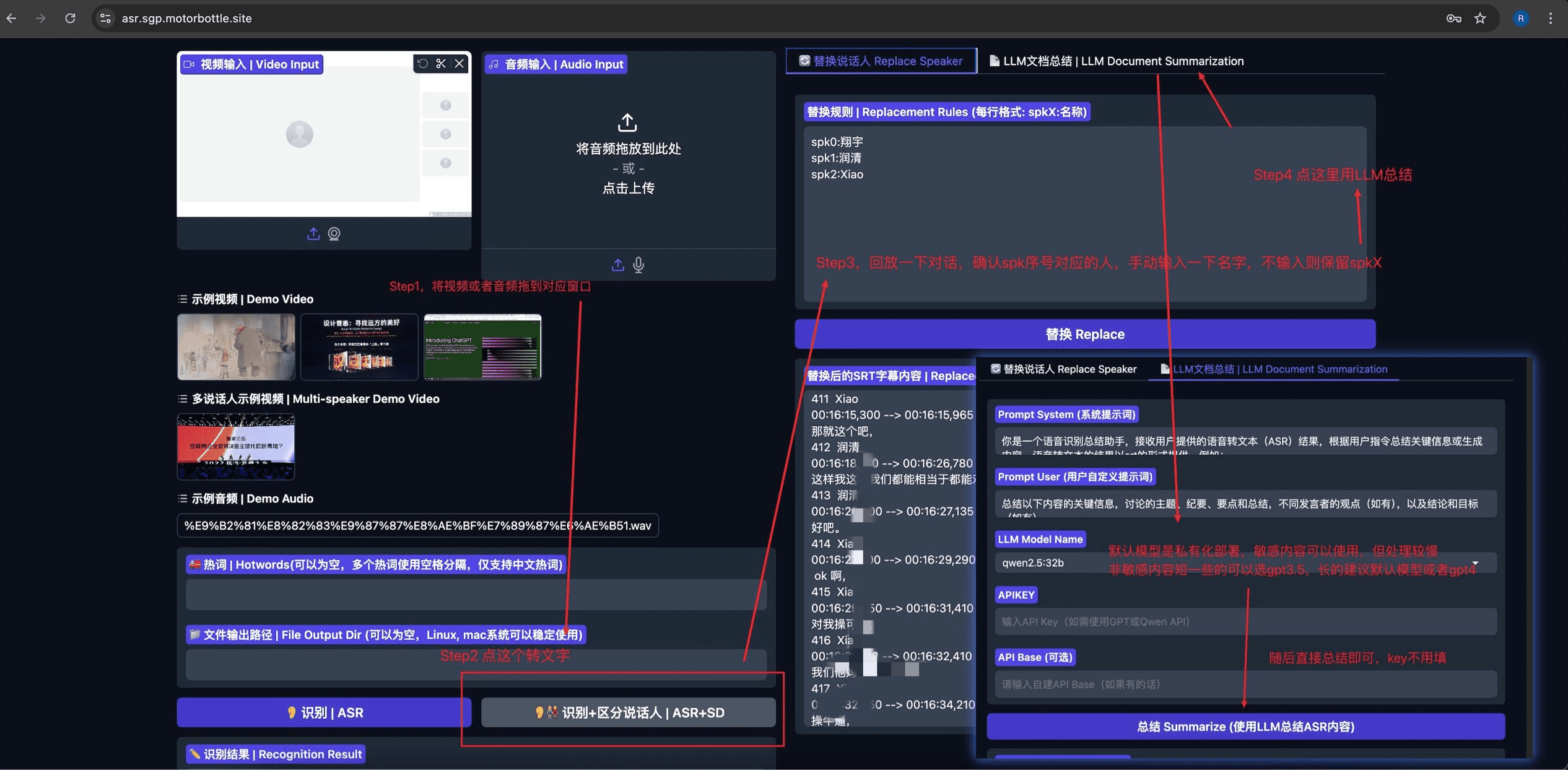

Privat-ASR Basierend auf Open-Source-Projekten FunClip Modifiziert, um automatische Spracherkennung (ASR), Sprechertrennung, SRT-Untertitelbearbeitung und LLM-basierte Zusammenfassung zu integrieren. Das Projekt verwendet Gradio Bietet eine intuitive und einfach zu bedienende Benutzeroberfläche.

Funktionsliste

- Präzise Spracherkennung: Integration des Open-Source-Modells Paraformer-Large von Alibaba, das chinesische und englische Spracherkennung unterstützt.

- LLM Intelligent Clip: Unterstützt die intelligente Analyse von Inhalten und die automatische Bestimmung von Clip-Punkten mit Hilfe eines umfangreichen Sprachmodells

- Sprechererkennung: Integration des CAM++ Sprechererkennungsmodells, das automatisch die Identität verschiedener Sprecher erkennen kann

- Hot-Word-Anpassung: Unterstützung der Hot-Word-Anpassungsfunktion von SeACo-Paraformer zur Verbesserung der Genauigkeit der Erkennung bestimmter Wörter.

- Bearbeitung mehrerer Segmente: Unterstützung der freien Auswahl mehrerer Textsegmente für die Stapelverarbeitung

- Untertitelgenerierung: Automatische Generierung von SRT-Vollvideountertiteln und Zielclipuntertiteln.

- Zweisprachige Unterstützung: unterstützt chinesische und englische Videoerkennung und -bearbeitung

- Lokale Bereitstellung: vollständig quelloffen, Unterstützung für lokale Bereitstellung, Schutz der Privatsphäre und Datensicherheit

- Benutzerfreundliche Schnittstelle: basiert auf der Gradio-Framework-Entwicklung und bietet eine einfache und intuitive Webschnittstelle

Hilfe verwenden

1. die Installation und der Einsatz

Grundlegende Installation der Umgebung

- Klonen Sie das Code-Repository:

git clone https://github.com/alibaba-damo-academy/FunClip.git

cd FunClip

- Installieren Sie die Python-Abhängigkeiten:

pip install -r ./requirements.txt

Optionale Funktionsinstallation (für eingebettete Untertitel)

Um die Funktion zum Einbetten von Untertiteln zu nutzen, müssen Sie ffmpeg und imagemagick installieren:

- Ubuntu:

apt-get -y update && apt-get -y install ffmpeg imagemagick

sed -i 's/none/read,write/g' /etc/ImageMagick-6/policy.xml

- MacOS:

brew install imagemagick

sed -i 's/none/read,write/g' /usr/local/Cellar/imagemagick/7.1.1-8_1/etc/ImageMagick-7/policy.xml

- Fenster:

- Laden Sie imagemagick von der offiziellen Website herunter und installieren Sie es: https://imagemagick.org/script/download.php#windows

- Suchen Sie den Python-Installationspfad und ändern Sie die

site-packages\moviepy\config_defaults.pyden Nagel auf den Kopf treffenIMAGEMAGICK_BINARYInstallationspfad für imagemagick - Laden Sie die Schriftartdatei herunter:

wget https://isv-data.oss-cn-hangzhou.aliyuncs.com/ics/MaaS/ClipVideo/STHeitiMedium.ttc -O font/STHeitiMedium.ttc

2. die Verwendungsmodalitäten

A. Nutzung des lokalen Gradio-Dienstes

- Starten Sie den Dienst:

python funclip/launch.py

# 使用 -l en 参数支持英文识别

# 使用 -p xxx 设置端口号

# 使用 -s True 开启公共访问

- Interviews

localhost:7860folgen Sie den nachstehenden Schritten:

- Schritt 1: Hochladen von Videodateien

- Schritt 2: Kopieren Sie den gewünschten Textclip in den Bereich "Text to Clip".

- Schritt 3: Untertiteleinstellungen nach Bedarf anpassen

- Schritt 4: Klicken Sie zum Bearbeiten auf "Ausschnitt" oder "Ausschnitt und Untertitel generieren".

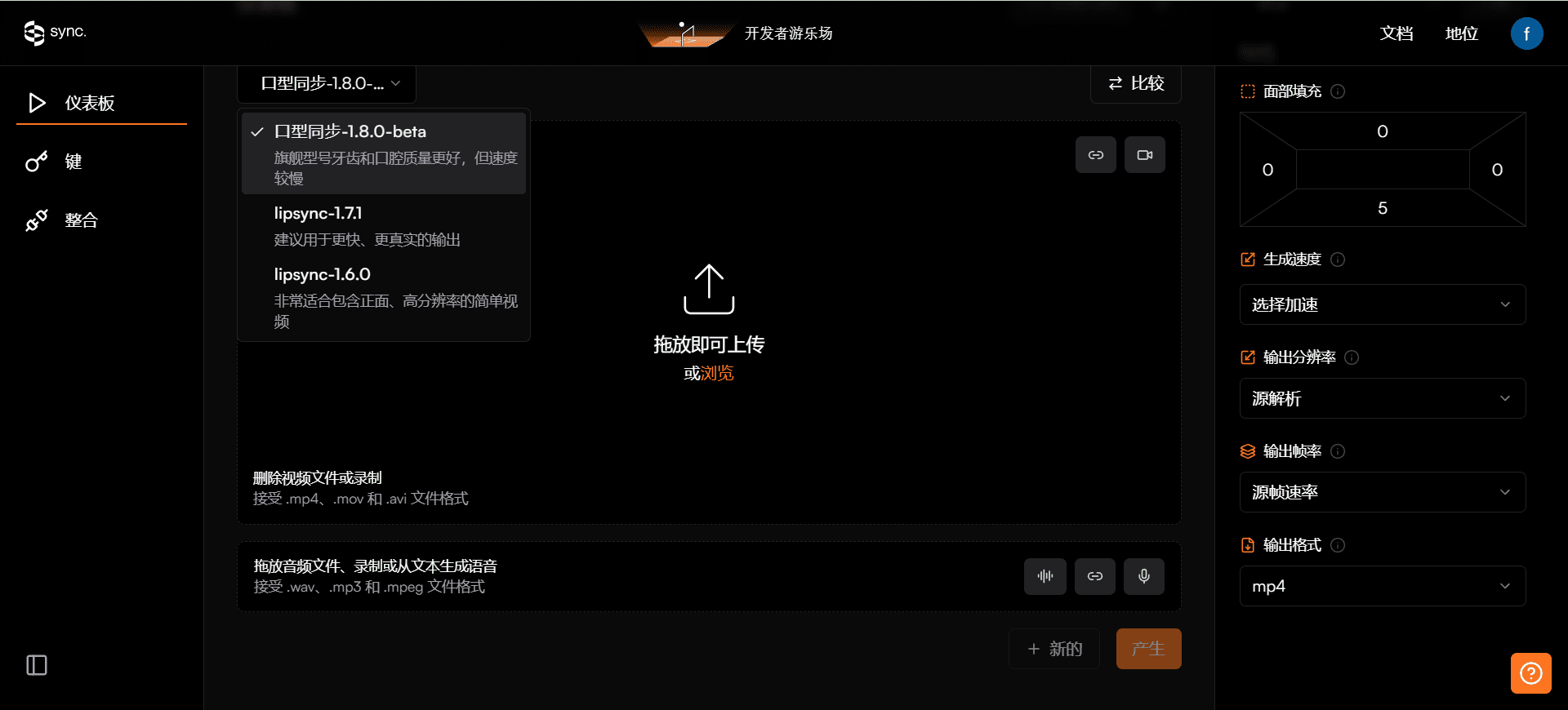

B. LLM Smart Clips

- Nachdem die Erkennung abgeschlossen ist, wählen Sie das große Sprachmodell aus und konfigurieren Sie apikey

- Klicken Sie auf die Schaltfläche "LLM-Inferenz", und das System wird die Videountertitel automatisch mit den voreingestellten Stichwörtern kombinieren.

- Klicken Sie auf die Schaltfläche "KI-Clip", um auf der Grundlage der Ausgabe des großen Sprachmodells automatisch Zeitstempel für die Bearbeitung zu extrahieren.

- Die Ausgabe eines großen Sprachmodells kann durch Änderung der Stichwortwörter optimiert werden

C. Verwendung der Befehlszeile

- Erkennung von Sprache:

python funclip/videoclipper.py --stage 1 \

--file examples/video.mp4 \

--output_dir ./output

- Videoclip:

python funclip/videoclipper.py --stage 2 \

--file examples/video.mp4 \

--output_dir ./output \

--dest_text '待剪辑文本' \

--start_ost 0 \

--end_ost 100 \

--output_file './output/res.mp4'

Außerdem können die Nutzer FunClip über die folgenden Online-Plattformen erleben:

- ModelScope Raum:FunClip@Modelscope Raum

- HuggingFace Space:FunClip@HuggingFace Space

Wenn Sie Probleme mit der Nutzung haben, können Sie über die Pinning-Gruppe oder die Weibo-Gruppe des Projekts Unterstützung von der Community erhalten.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...