FireRedASR: Ein Open-Source-Modell für mehrsprachige hochpräzise Spracherkennung

Allgemeine Einführung

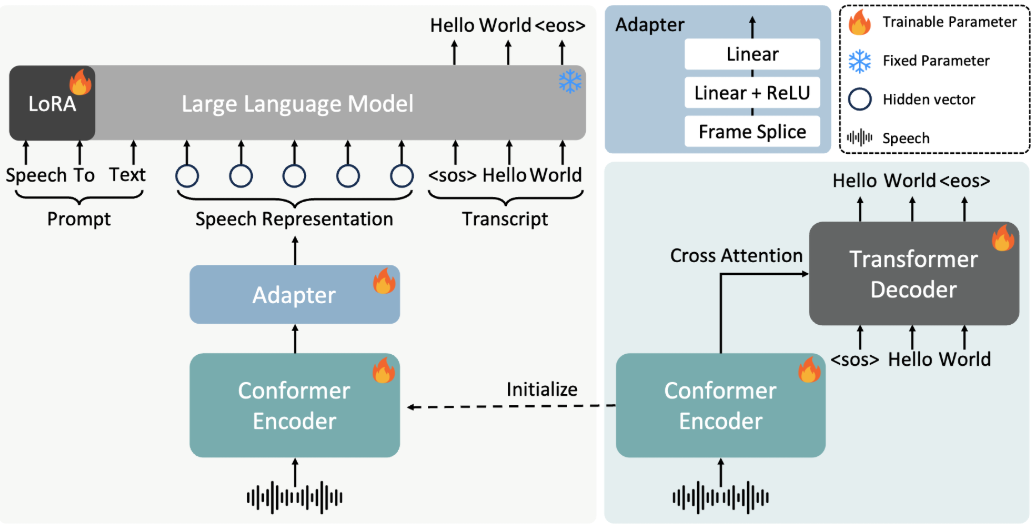

FireRedASR ist ein Spracherkennungsmodell, das vom Little Red Book FireRed-Team entwickelt und als Open Source zur Verfügung gestellt wird. Es konzentriert sich auf die Bereitstellung hochpräziser, mehrsprachiger Unterstützung für automatische Spracherkennungslösungen (ASR). Das auf GitHub gehostete Projekt richtet sich an Entwickler und Forscher, bietet ein industrietaugliches Design und unterstützt Szenarien wie die Erkennung von Mandarin, chinesischen Dialekten, Englisch und Lyrik.FireRedASR ist in zwei Hauptversionen unterteilt: FireRedASR-LLM strebt nach extremer Genauigkeit und ist für professionelle Anforderungen geeignet; FireRedASR-AED bietet ein Gleichgewicht zwischen Effizienz und Leistung und ist für Echtzeitanwendungen geeignet. Ab 2025 hat das Modell den optimalen Rekord im Chinesisch-Mandarin-Test (CER 3.05%) aufgestellt und in Tests mit mehreren Szenarien gut abgeschnitten, was für intelligente Assistenten, die Erstellung von Videountertiteln und andere Bereiche von großer Bedeutung ist.

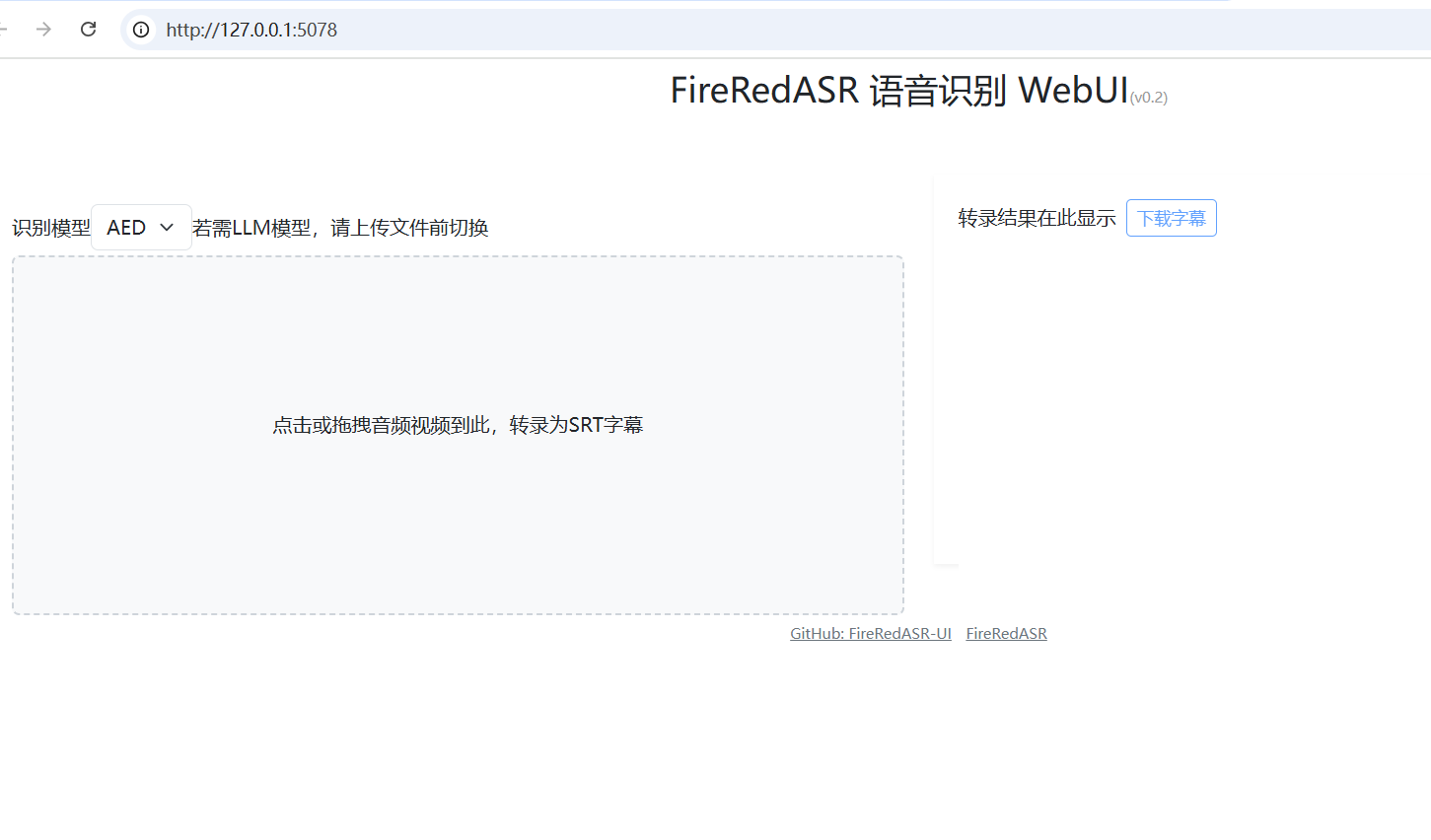

FireRedASR: WebUI Ein-Klick-Installationsprogramm: https://github.com/jianchang512/fireredasr-ui

Funktionsliste

- Unterstützt Sprache-zu-Text in Mandarin, chinesischen Dialekten und Englisch mit einer branchenführenden Erkennungsgenauigkeit.

- Bietet eine Funktion zur Erkennung von Liedtexten, besonders geeignet für die Verarbeitung von Multimedia-Inhalten.

- Zwei Versionen, FireRedASR-LLM und FireRedASR-AED, sind enthalten, um die Anforderungen an hochpräzise bzw. hocheffiziente Inferenz zu erfüllen.

- Open-Source-Modelle und Inferenzcode zur Unterstützung der sekundären Entwicklung durch die Gemeinschaft und kundenspezifischer Anwendungen.

- Es kann eine Vielzahl von Audioeingabeszenarien verarbeiten, z. B. kurze Videos, Live-Streaming, Spracheingabe usw.

- Unterstützt die Stapelverarbeitung von Audiodaten, geeignet für umfangreiche Datentranskriptionsaufgaben.

Hilfe verwenden

Einbauverfahren

FireRedASR erfordert bestimmte Konfigurationen der Entwicklungsumgebung, um zu laufen. Im Folgenden finden Sie die detaillierten Installationsschritte:

1.Projektlager klonen

Öffnen Sie ein Terminal und geben Sie den folgenden Befehl ein, um das FireRedASR-Projekt lokal zu klonen:

git clone https://github.com/FireRedTeam/FireRedASR.git

Wenn Sie fertig sind, gehen Sie zum Projektkatalog:

cd FireRedASR

- Erstellen einer Python-Umgebung

Es wird empfohlen, eine separate Python-Umgebung mit Conda zu erstellen, um die Isolierung von Abhängigkeiten zu gewährleisten. Führen Sie den folgenden Befehl aus:

conda create --name fireredasr python=3.10

Aktivieren Sie die Umwelt:

conda activate fireredasr

- Installation von Abhängigkeiten

Das Projekt bietet einerequirements.txtDatei, die alle erforderlichen Abhängigkeiten enthält. Der Installationsbefehl lautet wie folgt:

pip install -r requirements.txt

Warten Sie, bis die Installation abgeschlossen ist. Vergewissern Sie sich, dass das Netzwerk reibungslos funktioniert, eventuell benötigen Sie ein wissenschaftliches Internet-Tool, um den Download zu beschleunigen.

- Herunterladen des vortrainierten Modells

- FireRedASR-AED-L: Laden Sie das trainierte Modell direkt von GitHub oder Hugging Face herunter und fügen Sie es in die Datei

pretrained_models/FireRedASR-AED-LMappe. - FireRedASR-LLM-LZusätzlich zum Download des Modells ist es notwendig, das Qwen2-7B-Instruct-Modell in die Datenbank herunterzuladen.

pretrained_modelsund im OrdnerFireRedASR-LLM-LVerzeichnis, um Softlinks zu erstellen:

ln -s ../Qwen2-7B-Instruct

- Überprüfen der Installation

Führen Sie den folgenden Befehl aus, um zu prüfen, ob die Installation erfolgreich war:

python speech2text.py --help

Wenn eine Hilfemeldung angezeigt wird, ist die Umgebung korrekt konfiguriert.

Wie zu verwenden

FireRedASR bietet zwei Möglichkeiten, die Kommandozeile und die Python-API zu verwenden. Im Folgenden werden die Hauptfunktionen des Betriebsprozesses ausführlich beschrieben.

Befehlszeilenbetrieb

- Einzelne Dateiabschrift (Modell AED)

Verwenden Sie FireRedASR-AED-L, um Audiodateien zu verarbeiten (bis zu 60 Sekunden):

python speech2text.py --wav_path examples/wav/BAC009S0764W0121.wav --asr_type "aed" --model_dir pretrained_models/FireRedASR-AED-L

--wav_path: Gibt den Pfad der Audiodatei an.--asr_typeWählen Sie den Modelltyp, in diesem Fall "aed".--model_dir: Gibt den Modellordner an.

Die Ausgabe wird im Terminal angezeigt, z. B. der transkribierte Textinhalt.

- Transkription in einer Datei (LLM-Modell)

Verwenden Sie FireRedASR-LLM-L, um Audio zu verarbeiten (bis zu 30 Sekunden):

python speech2text.py --wav_path examples/wav/BAC009S0764W0121.wav --asr_type "llm" --model_dir pretrained_models/FireRedASR-LLM-L

Die Bedeutung des Parameters ist dieselbe wie oben, und die Ausgabe ist transkribierter Text.

Python-API-Operationen

- Modell laden und umschreiben

Rufen Sie das FireRedASR-Modell in einem Python-Skript auf:

from fireredasr.models.fireredasr import FireRedAsr

# 初始化 AED 模型

model = FireRedAsr.from_pretrained("aed", "pretrained_models/FireRedASR-AED-L")

batch_uttid = ["BAC009S0764W0121"]

batch_wav_path = ["examples/wav/BAC009S0764W0121.wav"]

results = model.transcribe(

batch_uttid, batch_wav_path,

{"use_gpu": 1, "beam_size": 3, "nbest": 1, "decode_max_len": 0}

)

print(results)

- von_ausgebildetLaden Sie das angegebene Modell.

- umschreiben.Transkription: Führt eine Transkriptionsaufgabe durch und gibt das Ergebnis als Liste von Texten zurück.

- Anpassung der Parameter zur Optimierung der Ergebnisse

- verwenden_gpu1, um GPU-Beschleunigung zu verwenden, 0, um CPU zu verwenden.

- strahlen_größeBreite des Suchbündels: Je größer die Breite des Suchbündels, desto höher die Genauigkeit, aber desto zeitaufwändiger ist die Suche, Standardwert 3.

- nbestGibt die optimale Anzahl von Ergebnissen zurück, Standardwert 1.

Featured Function Bedienung

- Lyrikerkennung

Der FireRedASR-LLM zeichnet sich durch seine Texterkennung aus. Geben Sie den Song ein (stellen Sie sicher, dass er nicht länger als 30 Sekunden dauert) und führen Sie ihn aus:python speech2text.py --wav_path your_song.wav --asr_type "llm" --model_dir pretrained_models/FireRedASR-LLM-L**Ausgabe als Liedtext mit branchenführenden Erkennungsraten. **

- Unterstützung mehrerer Sprachen

Für Dialekt- oder Englisch-Audio verwenden Sie die oben genannten Befehle oder APIs direkt und das Modell wird automatisch angepasst. Beispiel: Verarbeitung von englischem Audio:model = FireRedAsr.from_pretrained("llm","pretrained_models/FireRedASR-LLM-L") results = model.transcribe(["english_audio"],["path/to/english.wav"],{"use_gpu":1}) print(results)

caveat

- Begrenzung der AudiolängeAED wird bis zu 60 Sekunden lang unterstützt, danach können halluzinatorische Probleme auftreten; LLM wird bis zu 30 Sekunden lang unterstützt, darüber hinausgehendes Verhalten ist nicht definiert.

- StapeldateiAchten Sie darauf, dass die Länge des Eingangssignals ähnlich ist, um Leistungseinbußen zu vermeiden.

- Hardware-VoraussetzungEs wird empfohlen, für große Modelle den Grafikprozessor zu verwenden, da die CPU langsamer sein kann.

Durch die oben genannten Schritte können Benutzer einfach mit FireRedASR beginnen und den gesamten Prozess von der Installation bis zur Nutzung abschließen, was für eine Vielzahl von Spracherkennungsszenarien anwendbar ist.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...