Firecrawl MCP Server: Firecrawl-basierter Web Crawler MCP Dienst

Allgemeine Einführung

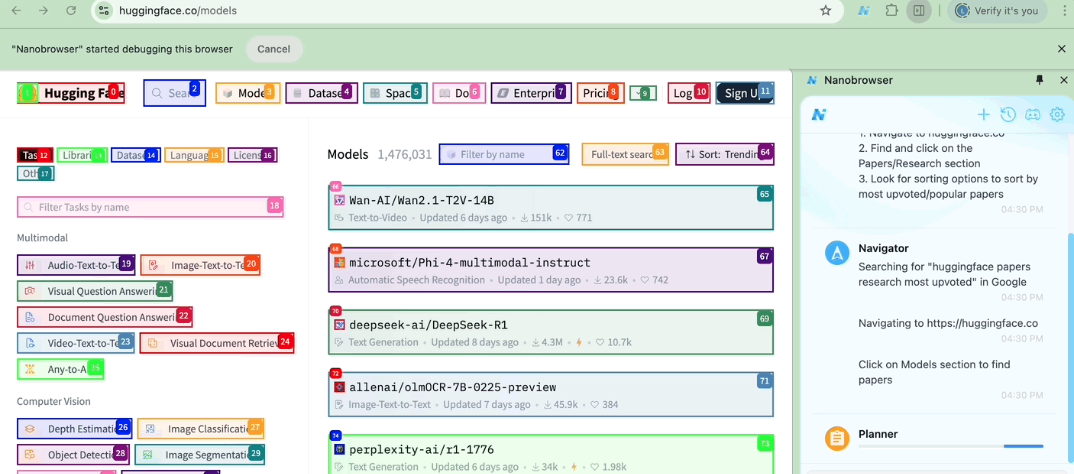

Firecrawl MCP Server ist ein von MendableAI entwickeltes Open-Source-Tool, das auf dem Modell-Kontext-Protokoll (MCP)-Protokollimplementierung, die in die Firecrawl-API integriert ist, bietet leistungsstarkes Web-Crawling und Datenextraktion. Sie wurde für KI-Modelle wie Cursor, Claude und andere LLM-Clients entwickelt und unterstützt eine breite Palette von Operationen, vom Crawling einzelner Seiten bis hin zum Batch-Crawling, der Suche und der Extraktion strukturierter Daten. Ob JavaScript-Rendering von dynamischen Webseiten, Deep Crawling und Content Filtering, Firecrawl MCP Server erledigt die Arbeit effizient. Das Tool unterstützt sowohl Cloud- als auch selbst gehostete Bereitstellungen mit automatischen Wiederholungsversuchen, Ratenbegrenzung und Protokollierungssystemen für Entwickler, Forscher und Dateningenieure. Ab März 2025 wird das Projekt kontinuierlich auf GitHub aktualisiert und ist in der Community weithin anerkannt.

Funktionsliste

- Einzelne Seite greifenExtrahiert Markdown oder strukturierte Daten aus einer angegebenen URL.

- Massen-CrawlerEffizienter Umgang mit mehreren URLs mit Unterstützung für Parallelbetrieb und eingebauter Ratenbegrenzung.

- Suche im InternetExtrahiert Inhalte aus Suchergebnissen auf der Grundlage einer Abfrage.

- tiefes KriechenUnterstützt URL-Erkennung und mehrstufiges Web-Crawling.

- DatenextraktionExtrahieren strukturierter Informationen aus Webseiten mit LLM.

- JavaScript-RenderingErfassen Sie den gesamten Inhalt einer dynamischen Webseite.

- Intelligente FiltrationInhaltsfilterung durch Einschluss/Ausschluss von Tags.

- ZustandsüberwachungBietet Abfragen zum Fortschritt von Batch-Aufgaben und zur Kreditnutzung.

- Protokoll-SystemAufzeichnung von Betriebsstatus, Leistung und Fehlermeldungen.

- Mobile/Desktop-UnterstützungAnpassung an unterschiedliche Geräteansichten.

Hilfe verwenden

Einbauverfahren

Der Firecrawl MCP Server bietet mehrere Installationsmethoden für unterschiedliche Einsatzszenarien. Im Folgenden werden die einzelnen Schritte beschrieben:

Weg 1: Schnelldurchlauf mit npx

- Holen Sie sich den Firecrawl-API-Schlüssel (registrieren Sie sich auf der Firecrawl-Website, um ihn zu erhalten).

- Öffnen Sie ein Terminal und setzen Sie die Umgebungsvariablen:

export FIRECRAWL_API_KEY="fc-YOUR_API_KEY"

Austauschbarkeit "fc-YOUR_API_KEY" für Ihren aktuellen Schlüssel.

3. den Auftrag ausführen:

npx -y firecrawl-mcp

- Nach erfolgreichem Start zeigt das Terminal

[INFO] FireCrawl MCP Server initialized successfully.

Modus 2: Manuelle Installation

- Globale Installation:

npm install -g firecrawl-mcp - Setzen Sie die Umgebungsvariablen (wie oben).

- Laufen:

firecrawl-mcp

Ansatz 3: Selbstgehostete Bereitstellung

- Klonen Sie ein GitHub-Repository:

git clone https://github.com/mendableai/firecrawl-mcp-server.git cd firecrawl-mcp-server - Installieren Sie die Abhängigkeit:

npm install - Projekt bauen:

npm run build - Setzen Sie die Umgebungsvariablen und führen Sie es aus:

node dist/src/index.js

Weg 4: Auf Cursor laufen

- sicher Cursor Version 0.45.6 oder höher.

- Öffnen Sie Cursor-Einstellungen > Funktionen > MCP-Server.

- Klicken Sie auf "+ Add New MCP Server" und geben Sie ein:

- Name.

firecrawl-mcp - Art.

command - Befehl.

env FIRECRAWL_API_KEY=your-api-key npx -y firecrawl-mcp - Windows-Benutzer, die Probleme haben, können es versuchen:

cmd /c "set FIRECRAWL_API_KEY=your-api-key && npx -y firecrawl-mcp"

- Name.

- Speichern und aktualisieren Sie die Liste der MCP-Server, die Composer Agent automatisch aufruft.

Weg 5: Laufen auf Windsurf

- Compiler

./codeium/windsurf/model_config.json::{ "mcpServers": { "mcp-server-firecrawl": { "command": "npx", "args": ["-y", "firecrawl-mcp"], "env": { "FIRECRAWL_API_KEY": "YOUR_API_KEY_HERE" } } } } - Speichern und starten Sie Windsurf.

Umgebungsvariablen konfigurieren

Erforderliche Konfiguration

FIRECRAWL_API_KEYCloud-API-Schlüssel, der bei der Nutzung von Cloud-Diensten festgelegt werden muss.

Optionale Konfigurationen

FIRECRAWL_API_URLAPI-Endpunkte für selbst gehostete Instanzen, wie z. B.https://firecrawl.your-domain.com.- Wiederholen Sie die Konfiguration:

FIRECRAWL_RETRY_MAX_ATTEMPTSMaximale Anzahl von Wiederholungsversuchen, Standardwert 3.FIRECRAWL_RETRY_INITIAL_DELAYErste Wiederholungsverzögerung (Millisekunden), Standardwert 1000.FIRECRAWL_RETRY_MAX_DELAYMaximale Verzögerung in Millisekunden, Standardwert 10000.FIRECRAWL_RETRY_BACKOFF_FACTORFallback-Faktor: Der Fallback-Faktor, Standardwert 2.

- Kreditüberwachung:

FIRECRAWL_CREDIT_WARNING_THRESHOLDWarnschwelle, Standardwert 1000.FIRECRAWL_CREDIT_CRITICAL_THRESHOLDNotfallschwelle, Standardwert 100.

Beispiel für eine Konfiguration

Cloud-Nutzung:

export FIRECRAWL_API_KEY="your-api-key"

export FIRECRAWL_RETRY_MAX_ATTEMPTS=5

export FIRECRAWL_RETRY_INITIAL_DELAY=2000

export FIRECRAWL_CREDIT_WARNING_THRESHOLD=2000

Hauptfunktionen

Funktion 1: Einzelne Seite scrapen (firecrawl_scrape)

- Verfahren::

- Nach dem Start des Servers senden Sie eine POST-Anfrage:

curl -X POST http://localhost:端口/firecrawl_scrape \ -H "Content-Type: application/json" \ -d '{"url": "https://example.com", "formats": ["markdown"], "onlyMainContent": true, "timeout": 30000}' - Gibt den Hauptinhalt im Markdown-Format zurück.

- Nach dem Start des Servers senden Sie eine POST-Anfrage:

- Beschreibung der Parameter::

onlyMainContent: Es werden nur die wichtigsten Elemente extrahiert.includeTags/excludeTags: Geben Sie an, welche HTML-Tags ein- oder ausgeschlossen werden sollen.

- AnwendungsszenarioSchnelles Extrahieren der Kerninformationen eines Artikels oder einer Seite.

Funktion 2: Batch Crawl (firecrawl_batch_scrape)

- Verfahren::

- Sendet eine Massenanfrage:

curl -X POST http://localhost:端口/firecrawl_batch_scrape \ -H "Content-Type: application/json" \ -d '{"urls": ["https://example1.com", "https://example2.com"], "options": {"formats": ["markdown"]}}' - Holen Sie sich die Vorgangs-ID, z.B.

batch_1. - Überprüfen Sie den Status:

curl -X POST http://localhost:端口/firecrawl_check_batch_status \ -H "Content-Type: application/json" \ -d '{"id": "batch_1"}'

- Sendet eine Massenanfrage:

- CharakterisierungEingebaute Ratenbegrenzung und Parallelverarbeitung für umfangreiche Datenerfassung.

Funktion 3: Websuche (firecrawl_search)

- Verfahren::

- Senden Sie einen Suchauftrag:

curl -X POST http://localhost:端口/firecrawl_search \ -H "Content-Type: application/json" \ -d '{"query": "AI tools", "limit": 5, "scrapeOptions": {"formats": ["markdown"]}}' - Gibt den Markdown-Inhalt der Suchergebnisse zurück.

- Senden Sie einen Suchauftrag:

- verwenden.Echtzeit-Zugang zu den für die Abfrage relevanten Webseitendaten.

Funktion 4: Tiefes Kriechen (firecrawl_crawl)

- Verfahren::

- Initiieren Sie eine Crawl-Anforderung:

curl -X POST http://localhost:端口/firecrawl_crawl \ -H "Content-Type: application/json" \ -d '{"url": "https://example.com", "maxDepth": 2, "limit": 100}' - Gibt die Ergebnisse des Crawls zurück.

- Initiieren Sie eine Crawl-Anforderung:

- Parameter::

maxDepthdie die Tiefe des Kriechvorgangs steuern.limitBegrenzen Sie die Anzahl der Seiten.

Funktion 5: Datenextraktion (firecrawl_extract)

- Verfahren::

- Sendet eine Extraktionsanfrage:

curl -X POST http://localhost:端口/firecrawl_extract \ -H "Content-Type: application/json" \ -d '{"urls": ["https://example.com"], "prompt": "Extract product name and price", "schema": {"type": "object", "properties": {"name": {"type": "string"}, "price": {"type": "number"}}}}' - Gibt strukturierte Daten zurück.

- Sendet eine Extraktionsanfrage:

- CharakterisierungUnterstützung für LLM-Extraktion, benutzerdefiniertes Schema zur Gewährleistung des Ausgabeformats.

Tipps und Tricks

- Log-Ansicht: Behalten Sie die Terminalprotokolle zur Laufzeit im Auge (z.B.

[INFO] Starting scrape) zu debuggen. - Fehlerbehandlung: Wenn Sie auf

[ERROR] Rate limit exceededdie Wiederholungsparameter anpassen oder warten. - Integration mit LLM: Im Cursor oder Claude Das Tool wird automatisch aufgerufen, indem die Crawling-Anforderungen direkt in der

Durch die oben genannten Vorgänge können Benutzer den Firecrawl MCP Server einfach einsetzen und nutzen, um die unterschiedlichsten Anforderungen an Webdaten zu erfüllen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...