Allgemeine Einführung

EchoMimic ist ein Open-Source-Projekt zur Erzeugung realistischer Porträtanimationen, die durch Audio gesteuert werden. Das von der Abteilung Terminal Technologies der Ant Group entwickelte Projekt nutzt editierbare Markerpunktbedingungen, um dynamische Porträtvideos zu generieren, die Audio- und Gesichtsmarkerpunkte kombinieren. EchoMimic wurde umfassend mit mehreren öffentlichen und proprietären Datensätzen verglichen und hat seine überlegene Leistung sowohl in quantitativen als auch in qualitativen Bewertungen bewiesen.

Die Version EchoMimicV2 optimiert die Inferenzgeschwindigkeit und fügt Gesten hinzu, empfohlen.

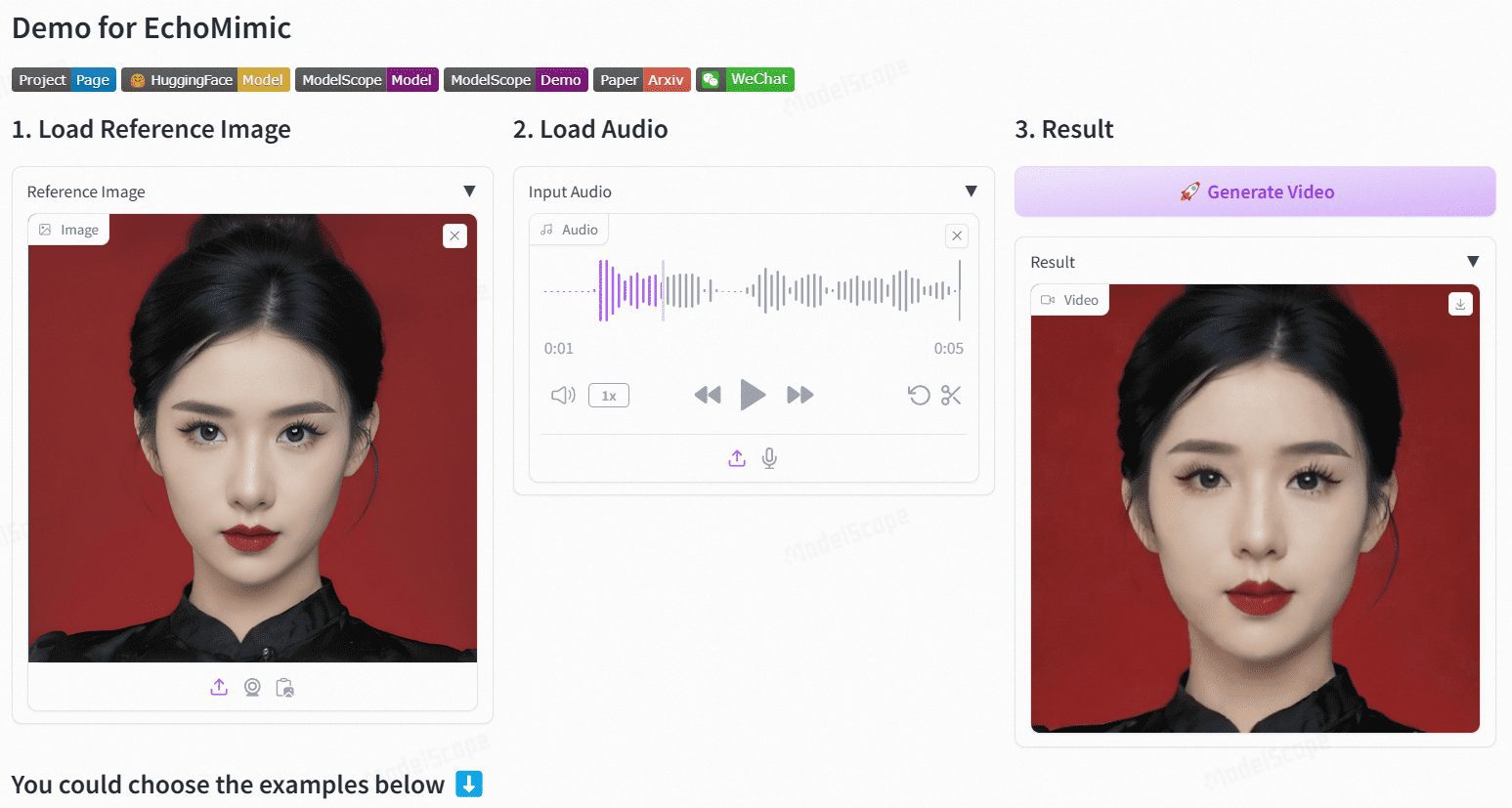

Demo-Adresse: https://www.modelscope.cn/studios/BadToBest/BadToBest V2: https://huggingface.co/spaces/fffiloni/echomimic-v2

Funktionsliste

- Audio-Treiber-AnimationGenerieren Sie realistische Porträtanimationen mit Audioeingabe.

- Markierungspunktgesteuerte AnimationGenerieren Sie stabile Porträtanimationen mit Hilfe von Gesichtsmarkierungspunkten.

- Audio + Marker-TreiberKombinieren Sie Audio und ausgewählte Gesichtsmarker, um natürlichere Porträtanimationen zu erstellen.

- Mehrsprachige UnterstützungUnterstützt die Audioeingabe in Chinesisch, Englisch und anderen Sprachen.

- Effizientes ReasoningOptimierte Modelle und Pipelines verbessern die Inferenzgeschwindigkeit erheblich.

Hilfe verwenden

Ablauf der Installation

- Code herunterladen::

git clone https://github.com/BadToBest/EchoMimic cd EchoMimic - Einrichten der Python-Umgebung::

- Es wird empfohlen, conda zur Erstellung einer virtuellen Umgebung zu verwenden:

conda create -n echomimic python=3.8 conda activate echomimic - Installieren Sie die Abhängigkeitspakete:

pip install -r anforderungen.txt

- Es wird empfohlen, conda zur Erstellung einer virtuellen Umgebung zu verwenden:

- ffmpeg-static herunterladen und entpacken::

- Laden Sie ffmpeg-static herunter und entpacken Sie es, dann setzen Sie die Umgebungsvariable:

export FFMPEG_PATH=/pfad/zu/ffmpeg-4.4-amd64-static

- Laden Sie ffmpeg-static herunter und entpacken Sie es, dann setzen Sie die Umgebungsvariable:

- Download Gewichte vor dem Training::

- Laden Sie die entsprechenden vortrainierten Modellgewichte gemäß der Projektbeschreibung herunter.

Verwendung Prozess

- Ausführen der Webschnittstelle::

- Starten Sie das Webinterface:

python webgui.py - Besuchen Sie den lokalen Server, um die Benutzeroberfläche anzuzeigen und Audiodateien für die Erstellung von Animationen hochzuladen.

- Starten Sie das Webinterface:

- Befehlszeilenargumentation::

- Verwenden Sie die folgenden Befehle für die Erstellung von audio-gesteuerten Porträtanimationen:

python infer_audio2vid.py --audio_pfad /pfad/zu/audio --output_pfad /pfad/zu/output - Begründungen in Verbindung mit Wegweisern:

python infer_audio2vid_pose.py --audio_pfad /path/to/audio --landmark_pfad /path/to/landmark --output_pfad /path/to/output

- Verwenden Sie die folgenden Befehle für die Erstellung von audio-gesteuerten Porträtanimationen:

- Modell-Optimierung::

- Die Verwendung des optimierten Modells und der Pipeline kann die Inferenzgeschwindigkeit erheblich verbessern, z. B. von 7 min/240 fps auf 50 sec/240 fps auf V100 GPUs.

caveat

- Stellen Sie sicher, dass die verwendete Python-Version und CUDA-Version mit den Projektanforderungen übereinstimmen.

- Wenn Sie bei der Verwendung auf Probleme stoßen, können Sie in der README-Datei des Projekts nachlesen oder auf GitHub eine Anfrage stellen.