Easy Dataset: Ein einfaches Tool zur Erstellung großer, fein abgestimmter Modelldatensätze

Allgemeine Einführung

Easy Dataset ist ein Open-Source-Tool, das speziell für die Feinabstimmung großer Modelle (LLMs) entwickelt wurde und auf GitHub gehostet wird. Es bietet eine einfach zu bedienende Schnittstelle, mit der Benutzer Dateien hochladen, Inhalte automatisch segmentieren, Fragen und Antworten generieren und schließlich strukturierte Datensätze ausgeben können, die für die Feinabstimmung geeignet sind. Der Entwickler Conard Li hat dieses Tool entwickelt, um Benutzern bei der Umwandlung von Domänenwissen in hochwertige Trainingsdaten zu helfen. Es unterstützt mehrere Exportformate, wie z. B. JSON und Alpaca, und ist mit allen LLM-APIs kompatibel, die dem OpenAI-Format folgen, was den Einstieg und die schnelle Erstellung von Datensätzen erleichtert, egal ob Sie ein technischer Experte oder ein Gelegenheitsnutzer sind.

Funktionsliste

- Intelligente DokumentenverarbeitungWenn Sie eine Markdown-Datei hochladen, teilt das Tool sie automatisch in kleinere Teile auf.

- Erzeugung von FragenAutomatisch relevante Fragen auf der Grundlage des segmentierten Textes generieren.

- Antwort GenerationAufruf der LLM-API, um detaillierte Antworten für jede Frage zu generieren.

- Flexible BearbeitungUnterstützung für die Änderung von Fragen, Antworten oder Datensatzinhalten in jeder Phase.

- Mehrere ExportformateDatensätze können in die Formate JSON, JSONL oder Alpaca exportiert werden.

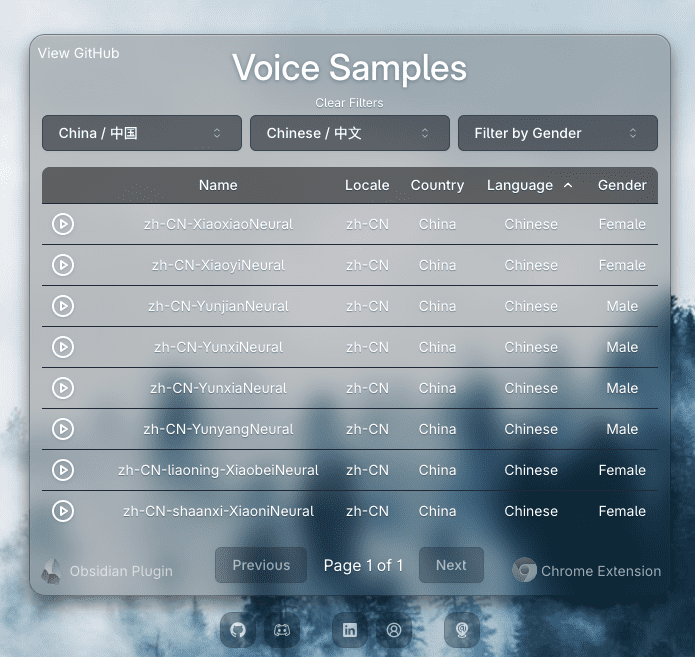

- Umfassende ModellunterstützungKompatibel mit allen LLM-APIs, die dem OpenAI-Format folgen.

- benutzerfreundliche SchnittstelleDas Design ist intuitiv und sowohl für technische als auch für nicht-technische Benutzer geeignet.

- Benutzerdefinierte TippsErlaubt dem Benutzer, Systemaufforderungen hinzuzufügen, die das Modell anweisen, eine bestimmte Art von Antwort zu generieren.

Hilfe verwenden

Einbauverfahren

Easy Dataset kann auf zwei Arten verwendet werden: über Docker oder von lokalen Quellen aus. Hier sind die detaillierten Schritte:

Installation über Docker

- Installation von Docker

Wenn Ihr Computer noch nicht über Docker verfügt, laden Sie Docker Desktop herunter und installieren Sie es. Sobald die Installation abgeschlossen ist, öffnen Sie ein Terminal, um den Erfolg zu überprüfen:

docker --version

Wenn die Versionsnummer angezeigt wird, bedeutet dies, dass sie installiert ist.

- Ziehen Sie das Image und führen Sie

Geben Sie den folgenden Befehl in das Terminal ein, um das offizielle Image zu ziehen und den Dienst zu starten:

docker run -d -p 3000:3000 -v {你的本地路径}:/app/local-db --name easy-dataset conardli17/easy-dataset:latest

{你的本地路径}Sie müssen ihn durch den Pfad zu dem Ordner auf Ihrem Computer ersetzen, den Sie zum Speichern der Daten verwenden, z. B.C:\data(Windows) oder/home/user/data(Linux/Mac).-p 3000:3000Gibt an, dass Port 3000 innerhalb des Containers lokal auf Port 3000 abgebildet wird.-vSie soll verhindern, dass die Daten nach dem Neustart des Containers verloren gehen.

- Zugangsschnittstelle

Nach dem erfolgreichen Start öffnen Sie Ihren Browser und geben Siehttp://localhost:3000Sie sehen die Easy Dataset-Startseite. Sie sehen die Easy Dataset-Startseite. Klicken Sie auf die Schaltfläche "Projekt erstellen", um zu beginnen.

Lokal durch den Quellcode laufen

- Vorbereiten der Umgebung

- Stellen Sie sicher, dass Sie Node.js (Version 18.x oder höher) und npm auf Ihrem Computer installiert haben.

- Prüfmethode: Eingabe in das Terminal

node -vim Gesang antwortennpm -vsehen Sie einfach die Versionsnummer.

- Klon-Lager

Geben Sie ihn in das Terminal ein:

git clone https://github.com/ConardLi/easy-dataset.git

cd easy-dataset

- Installation von Abhängigkeiten

Wird innerhalb des Projektordners ausgeführt:

npm install

- Neue Dienste

Geben Sie den folgenden Befehl zum Kompilieren und Ausführen ein:

npm run build

npm run start

Öffnen Sie anschließend Ihren Browser und besuchen Sie http://localhost:3000Die Werkzeugschnittstelle kann durch Anklicken der Schaltfläche "Werkzeuge" aufgerufen werden.

Hauptfunktionen

Ein Projekt erstellen

- Klicken Sie auf der Startseite auf die Schaltfläche "Projekt erstellen".

- Geben Sie den Namen des Projekts ein, z. B. "My Dataset".

- Klicken Sie auf "Bestätigen" und das System wird einen neuen Projektraum für Sie anlegen.

Hochladen und Bearbeiten von Dokumenten

- Auf der Projektseite finden Sie die Option "Text Split" oder "Text Split".

- Klicken Sie auf "Datei hochladen" und wählen Sie eine lokale Markdown-Datei (z. B.

example.md). - Nach dem Hochladen teilt das Tool den Dateiinhalt automatisch in kleine Segmente auf. Jedes Segment wird auf der Benutzeroberfläche angezeigt und Sie können das Teilungsergebnis manuell anpassen.

Fragen und Antworten generieren

- Rufen Sie den Bildschirm "Fragen" oder "Fragenverwaltung" auf.

- Klicken Sie auf die Schaltfläche "Fragen generieren" und das Tool generiert Fragen auf der Grundlage der einzelnen Texte.

- Prüfen Sie die erstellte Frage und wenn Sie nicht zufrieden sind, können Sie sie ändern, indem Sie auf die Schaltfläche Bearbeiten neben der Frage klicken.

- Klicken Sie auf "Antworten generieren", wählen Sie eine LLM-API aus (Sie müssen den API-Schlüssel im Voraus konfigurieren) und das Tool wird Antworten für jede Frage generieren.

- Sobald die Antworten erstellt sind, können Sie sie manuell bearbeiten, um sicherzustellen, dass der Inhalt den Anforderungen entspricht.

Exportieren eines Datensatzes

- Gehen Sie zum Bildschirm Datasets oder Dataset Management.

- Klicken Sie auf die Schaltfläche "Exportieren" und wählen Sie das Exportformat (z. B. JSON oder Alpaca).

- Das System generiert eine Datei, klicken Sie auf Download und speichern Sie sie lokal.

Featured Function Bedienung

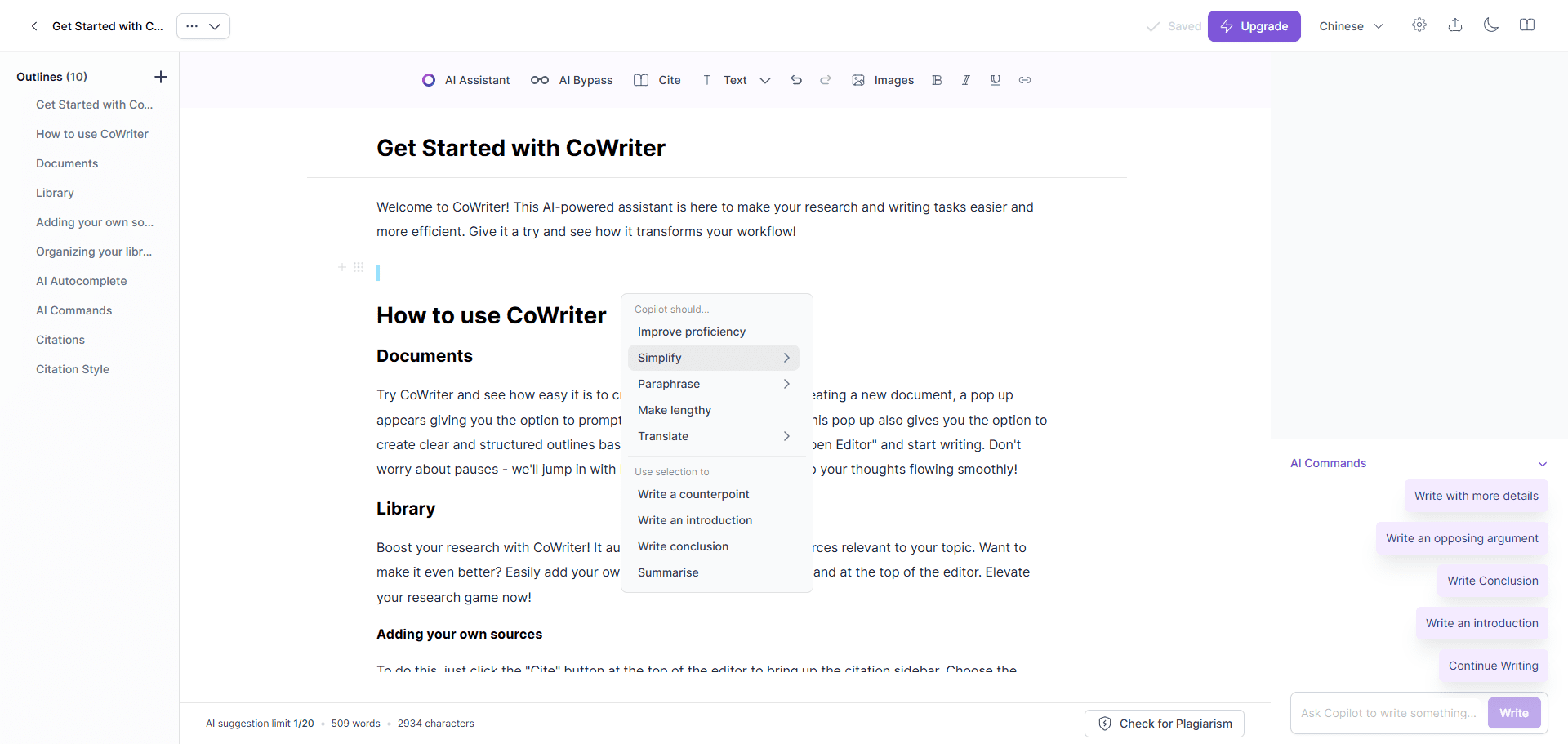

Konfigurieren der LLM-API

- Auf der Seite Einstellungen oder Einstellungen finden Sie Modellkonfiguration.

- Geben Sie Ihren LLM-API-Schlüssel ein (z. B. den API-Schlüssel von OpenAI).

- Wählen Sie den Modelltyp (viele gängige Modelle werden unterstützt) und speichern Sie die Konfiguration.

- Einmal konfiguriert, wird dieses Modell bei der Erstellung von Antworten aufgerufen.

Maßgeschneiderte Systemwarnungen

- Suchen Sie auf der Seite Einstellungen nach Prompts oder Prompt Templates.

- Geben Sie benutzerdefinierte Aufforderungen ein, z. B. "Bitte beantworten Sie die Frage in einfacher Sprache".

- Nach dem Speichern werden die Antworten generiert, wobei der Stil entsprechend Ihren Vorgaben angepasst wird.

Optimierung des Datensatzes

- Klicken Sie auf dem Bildschirm Datasets auf die Schaltfläche Optimieren.

- Das System analysiert den Datensatz und entfernt Duplikate oder optimiert das Format.

- Der optimierte Datensatz eignet sich besser für die direkte Verwendung bei der Modellfeinabstimmung.

caveat

- Wenn Sie mit Docker arbeiten, vergessen Sie nicht, regelmäßig Backups zu erstellen!

{你的本地路径}Die Daten darin. - Wenn Sie lokal arbeiten, stellen Sie sicher, dass das Netzwerk offen ist, da die Generierung von Antworten eine Internetverbindung erfordert, um die API aufzurufen.

- Wenn ein Fehler auftritt, können Sie auf der Seite "Releases" auf GitHub die neueste Version herunterladen, um das Problem zu beheben.

Anwendungsszenario

- Modellentwickler nehmen Feinabstimmung des LLM vor

Entwickler können Easy Dataset verwenden, um technische Dokumente zu verarbeiten, Q&A-Paare zu generieren, schnell Trainingssätze zu erstellen und die Modellleistung in bestimmten Bereichen zu verbessern. - Erstellung von Lernmaterialien durch Pädagogen

Lehrkräfte können Kursunterlagen hochladen und Fragen und Antworten zur Überprüfung durch die Schüler oder zur Erstellung von Online-Kursinhalten erstellen. - Forscher tragen Fachwissen zusammen

Forscher können Papiere oder Berichte hochladen, Schlüsselfragen und -antworten extrahieren und sie in strukturierten Daten für die Analyse organisieren.

QA

- Welche Dateiformate werden von Easy Dataset unterstützt?

Derzeit werden hauptsächlich Markdown-Dateien unterstützt (.md), andere Formate werden möglicherweise in Zukunft ebenfalls unterstützt. - Muss ich meine eigene LLM-API bereitstellen?

Ja, das Tool selbst bietet keine LLM-Dienste an und erfordert, dass der Nutzer seine eigenen API-Schlüssel konfiguriert, z. B. OpenAI oder andere kompatible Modelle. - Für welche Modelle kann der exportierte Datensatz verwendet werden?

Solange das Modell OpenAI-Formate (z.B. LLaMA, GPT, etc.) unterstützt, kann der exportierte Datensatz direkt verwendet werden.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Verwandte Beiträge

Keine Kommentare...