DragAnything: Steuerung der siliziumbasierten Videoerzeugung für feste Objekte in Bildern

Allgemeine Einführung

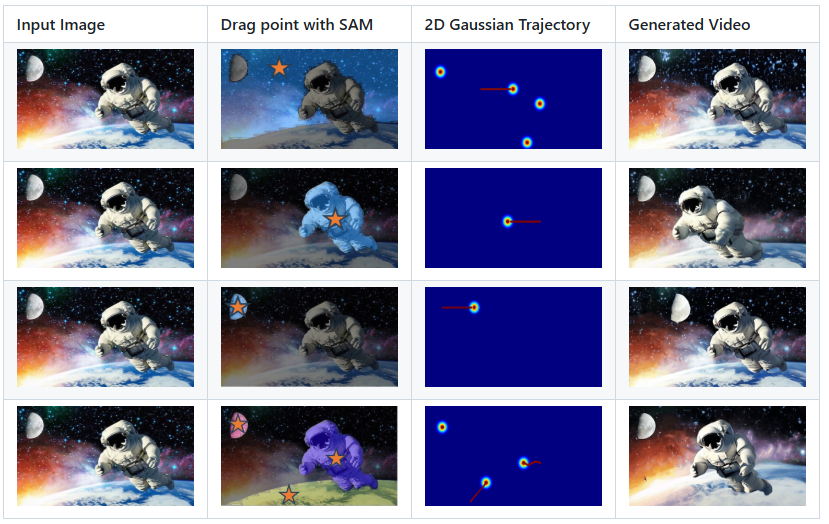

DragAnything ist ein Open-Source-Projekt, das darauf abzielt, die Bewegungssteuerung beliebiger Objekte durch die Darstellung von Entitäten zu ermöglichen. DragAnything wurde vom Showlab-Team entwickelt und vom ECCV 2024 akzeptiert. Es bietet eine benutzerfreundliche Möglichkeit, mit Objekten zu interagieren, indem man einfach eine Trajektorie zeichnet, um ihre Bewegung zu steuern. Das Projekt unterstützt die gleichzeitige Bewegungssteuerung mehrerer Objekte, einschließlich Vordergrund-, Hintergrund- und Kamerabewegungen. DragAnything übertrifft bestehende State-of-the-Art-Methoden in einer Reihe von Metriken, insbesondere bei der Bewegungssteuerung von Objekten.

Funktionsliste

- Entitätsdarstellung: Verwenden Sie die offene Feldeinbettung, um ein beliebiges Objekt darzustellen.

- Trajektoriensteuerung: Die Steuerung der Objektbewegung erfolgt durch das Zeichnen von Trajektorien.

- Multi-Objekt-Steuerung: unterstützt die gleichzeitige Bewegungssteuerung von Vordergrund, Hintergrund und Kamera.

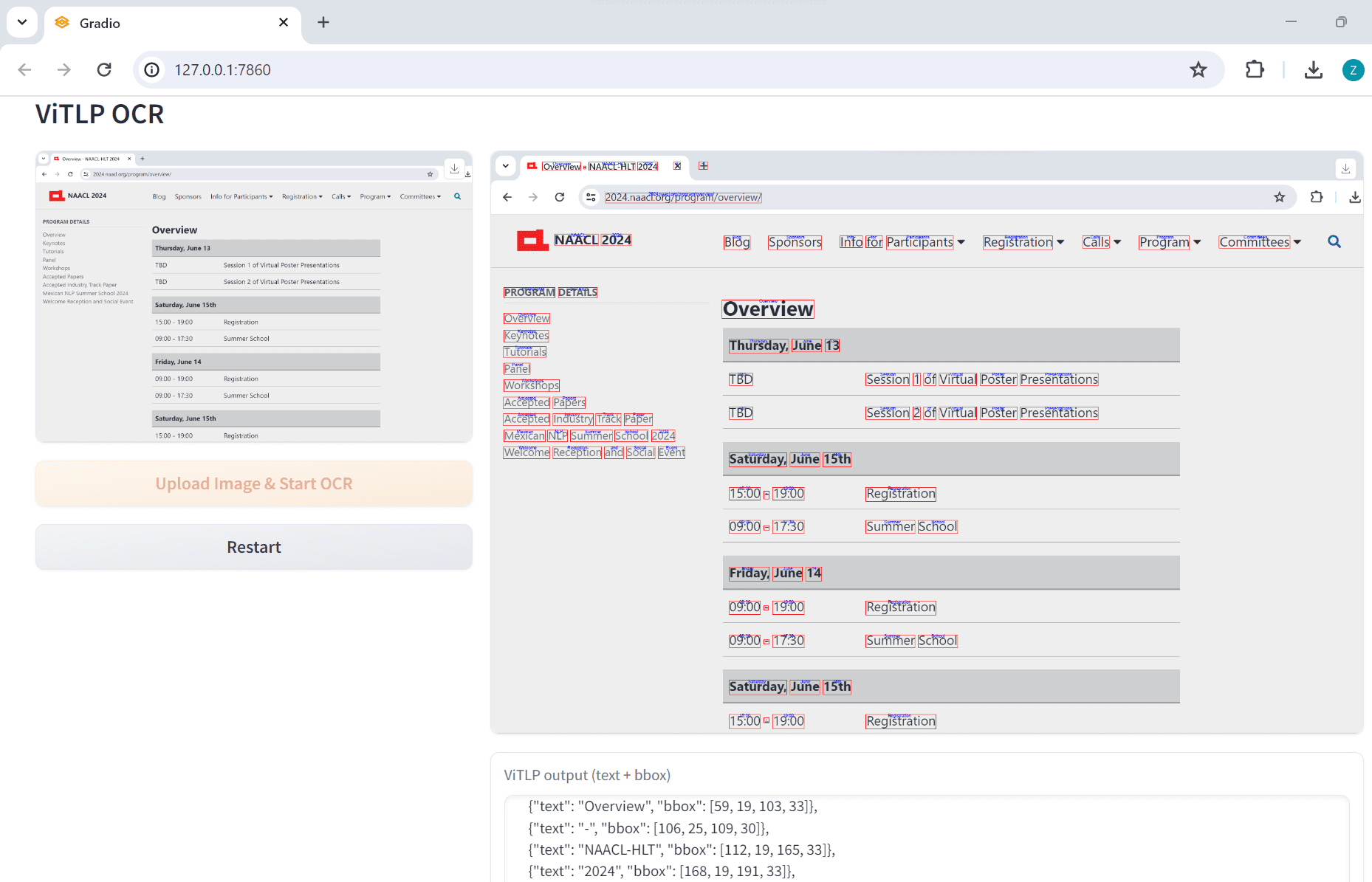

- Interaktive Demos: Unterstützung für interaktive Demos mit Gradio.

- Datensatzunterstützung: Unterstützt VIPSeg- und Youtube-VOS-Datensätze.

- Hohe Leistung: hervorragend bei FVD, FID und Anwenderstudien.

Hilfe verwenden

Einbauverfahren

- Klonen Sie den Projektcode:

git clone https://github.com/showlab/DragAnything.git

cd DragAnything

- Erstellen und aktivieren Sie eine Conda-Umgebung:

conda create -n DragAnything python=3.8

conda activate DragAnything

- Installieren Sie die Abhängigkeit:

pip install -r requirements.txt

- Bereiten Sie den Datensatz vor:

- VIPSeg- und Youtube-VOS-Datensätze herunterladen auf

./dataKatalog.

- VIPSeg- und Youtube-VOS-Datensätze herunterladen auf

Verwendung

- Führen Sie eine interaktive Demo durch:

python gradio_run.py

Öffnen Sie Ihren Browser und besuchen Sie die angegebene lokale Adresse, um mit der interaktiven Demo zu beginnen.

- Steuert die Objektbewegung:

- Zeichnen Sie eine Bahnlinie auf dem Eingabebild und wählen Sie das Objekt aus, das Sie steuern möchten.

- Führen Sie das Skript aus, um das Video zu erstellen:

python demo.py --input_image <path_to_image> --trajectory <path_to_trajectory>- Das erzeugte Video wird in dem angegebenen Verzeichnis gespeichert.

- Passen Sie die Bewegungsabläufe an:

- Verwenden Sie das Co-Track-Tool, um Ihre eigenen Bewegungsspur-Anmerkungsdateien zu verarbeiten.

- Legen Sie die verarbeiteten Dateien im angegebenen Verzeichnis ab und führen Sie das Skript aus, um das Video zu erstellen.

Hauptfunktionen

- physische DarstellungOpen Field Embedding: Darstellung beliebiger Objekte durch Einbettung in offene Felder, ohne dass der Benutzer das Objekt manuell beschriften muss.

- Kontrolle der FlugbahnDer Benutzer kann die Bewegung eines Objekts steuern, indem er einfach eine Trajektorie auf das Eingabebild zeichnet.

- Multi-Objekt-KontrolleUnterstützt die gleichzeitige Steuerung der Bewegung mehrerer Objekte, einschließlich Vordergrund, Hintergrund und Kamera.

- Interaktive PräsentationÜber die interaktive Schnittstelle von Gradio können die Benutzer die Auswirkungen der Bewegungssteuerung in Echtzeit verfolgen.

- hohe LeistungHervorragende Leistung bei FVD, FID und Anwenderstudien, insbesondere bei der Kontrolle von Objektbewegungen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...