DevDocs: ein MCP-Dienst zum schnellen Durchsuchen und Organisieren technischer Dokumentation

Allgemeine Einführung

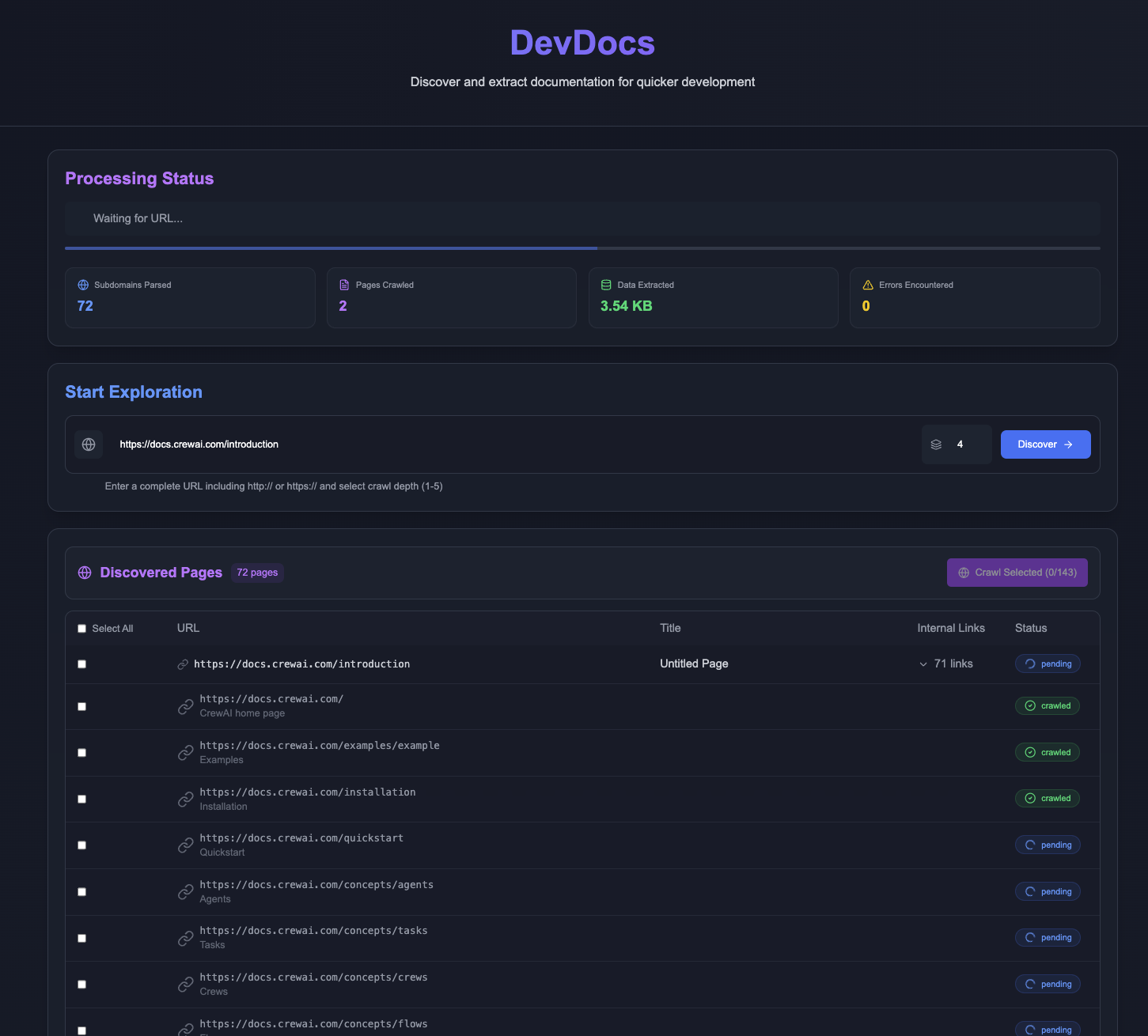

DevDocs ist ein völlig kostenloses und quelloffenes Tool, das vom CyberAGI-Team entwickelt und auf GitHub gehostet wird. Es wurde für Programmierer und Softwareentwickler entwickelt und beginnt mit der URL eines technischen Dokuments, durchsucht automatisch die relevante Seite und organisiert sie in einer prägnanten Markdown- oder JSON-Datei. Es verfügt über integrierte MCP Server, Unterstützung für die Verwendung des Claude Das Ziel von DevDocs ist es, die wochenlange Recherche nach Dokumenten auf wenige Stunden zu reduzieren und Entwicklern zu helfen, sich schnell in neue Technologien einzuarbeiten. DevDocs eignet sich für einzelne Entwickler, Teams und Unternehmensanwender und ist derzeit kostenlos, so dass jeder es herunterladen und nutzen kann.

Funktionsliste

- Intelligentes Crawling von DokumentenEingabe einer URL und automatisches Crawlen der relevanten Seiten, mit Unterstützung von 1-5 Tiefenebenen.

- Organisieren in mehreren FormatenKonvertierung der erfassten Inhalte in Markdown- oder JSON-Dateien zum einfachen Lesen und Weiterverarbeiten.

- MCP-Server-IntegrationEingebauter MCP-Server, der mit großen Modellen wie Claude arbeitet, um Dokumente auf intelligente Weise abzufragen.

- Automatische Erkennung von VerbindungenIdentifizieren und kategorisieren Sie Unterlinks innerhalb einer Seite, um die Integrität des Inhalts zu gewährleisten.

- Beschleunigung der ParallelverarbeitungCrawlen mehrerer Seiten in mehreren Threads, um die Effizienz zu erhöhen.

- selektives CrawlingBenutzer können angeben, was extrahiert werden soll, um irrelevante Informationen zu vermeiden.

- Mechanismus zur FehlerbehebungAutomatischer Wiederholungsversuch, wenn das Crawling fehlschlägt, um Stabilität zu gewährleisten.

- Vollständige Protokollierung: Zeichnen Sie jeden Schritt des Vorgangs auf, um die Fehlersuche zu erleichtern.

Hilfe verwenden

Einbauverfahren

DevDocs läuft mit Docker und ist einfach zu installieren. Hier sind die detaillierten Schritte:

- Vorbereiten der Umgebung

- Git und Docker müssen installiert werden:

- Git: Download und Installation von git-scm.com.

- Docker: Laden Sie Docker Desktop von docker.com herunter und installieren Sie es.

- Um zu überprüfen, ob Docker korrekt ausgeführt wird, geben Sie im Terminal Folgendes ein

docker --versionWenn Sie die Versionsnummer sehen, haben Sie es geschafft.

- Git und Docker müssen installiert werden:

- Klonen von Code

- Öffnen Sie ein Terminal (CMD oder PowerShell für Windows, Terminal für Mac/Linux).

- Geben Sie den Befehl zum Herunterladen von DevDocs ein:

git clone https://github.com/cyberagiinc/DevDocs.git - Rufen Sie den Projektkatalog auf:

cd DevDocs

- Neue Dienste

- Führen Sie das Startskript entsprechend dem Betriebssystem aus:

- Mac/Linux:

./docker-start.sh - Fenster:

docker-start.bat

- Mac/Linux:

- Windows-Benutzer können Ordnerberechtigungen manuell festlegen, wenn sie Probleme mit Berechtigungen haben:

icacls logs /grant Everyone:F /T icacls storage /grant Everyone:F /T icacls crawl_results /grant Everyone:F /T - Warten Sie nach dem Start einige Sekunden, bis das Terminal anzeigt, dass der Dienst erfolgreich ausgeführt wird.

- Führen Sie das Startskript entsprechend dem Betriebssystem aus:

- Zugriffswerkzeug

- Öffnen Sie Ihren Browser und geben Sie

http://localhost:3001um auf die DevDocs-Front-End-Schnittstelle zuzugreifen. - Andere Dienstadressen:

- Backend-API:

http://localhost:24125 - Crawl4AI Dienstleistungen:

http://localhost:11235

- Backend-API:

- Öffnen Sie Ihren Browser und geben Sie

Hauptfunktionen

1. die technische Dokumentation durchsuchen

- umziehen::

- Fügen Sie die Ziel-URL in das Eingabefeld der Schnittstelle ein, z. B.

https://docs.example.com. - Wählen Sie die Kriechtiefe (1-5 Ebenen, Standardwert 5).

- Klicken Sie auf "Crawling starten".

- Warten Sie auf die Fertigstellung, die Schnittstelle wird die Liste der gecrawlten Seiten anzeigen.

- Fügen Sie die Ziel-URL in das Eingabefeld der Schnittstelle ein, z. B.

- zur Kenntnis nehmen::

- Das Crawling ist schnell und verarbeitet bis zu 1000 Seiten pro Minute.

- Die Ergebnisse werden in der Datei

<项目目录>/crawl_resultsMappe.

- Erweiterte Optionen::

- Es besteht die Möglichkeit, zu kriechen und das Notwendige abzuhaken.

2. die Organisation des Inhalts von Dokumenten

- Rigg::

- Nach dem Crawlen werden die Inhalte automatisch in Markdown- oder JSON-Dateien organisiert.

- existieren

<项目目录>/crawl_resultsAnsicht, die standardmäßig im Markdown-Format vorliegt.

- Format umschalten::

- Wählen Sie in den Schnittstelleneinstellungen "Export nach JSON" für die Feinabstimmung großer Modelle.

3. die Verwendung von MCP-Servern und großen Modellen

- beabsichtigen::

- Laden Sie die Claude Desktop App herunter und installieren Sie sie (anthropic.com).

- Der MCP-Server von DevDocs läuft standardmäßig lokal und erfordert keine zusätzliche Konfiguration.

- umziehen::

- Öffnen Sie die Claude App.

- Geben Sie eine Frage ein, z. B. "Was steht in diesem Dokument".

- Claude liest die Daten vom MCP-Server und antwortet.

- Erweiterte Nutzung::

- Legen Sie das lokale Dokument in den

<项目目录>/storageClaude kann direkt aufgerufen werden. - Unterstützung bei komplexen Fragen wie "wie wird diese Technologie eingesetzt".

- Legen Sie das lokale Dokument in den

4. die Protokollierung und Überwachung

- Ansicht Log::

- Die Protokolldatei befindet sich im Verzeichnis

<项目目录>/logs, enthalten:frontend.logFront-End-Protokolle.backend.logBackend-Protokolle.mcp.logMCP-Server-Protokolle.

- Live-Protokolle mit Docker anzeigen:

docker logs -f devdocs-backend

- Die Protokolldatei befindet sich im Verzeichnis

- Einstellung von Dienstleistungen::

- Drücken Sie am Terminal

Ctrl+Cschalten Sie alle Dienste ab.

- Drücken Sie am Terminal

5. praktische Skripte

- Das Projekt bietet eine Reihe von Skripten, die in der

<项目目录>/scripts::check_mcp_health.shÜberprüfen Sie den Status des MCP-Servers.debug_crawl4ai.shDebugging des Crawling-Dienstes.view_result.sh: Crawl-Ergebnisse anzeigen.

- Betriebsmodus::

- Wechseln Sie im Terminal in das Skriptverzeichnis und geben Sie

./脚本名Umsetzung.

- Wechseln Sie im Terminal in das Skriptverzeichnis und geben Sie

Zusammenfassung des Betriebsablaufs

- Installieren Sie Docker und Git und laden Sie den Code herunter.

- Führen Sie das Startscript aus, um auf die Schnittstelle zuzugreifen.

- Geben Sie die URL ein, crawlen und organisieren Sie das Dokument.

- Abfrage von Inhalten mit Claude für mehr Effizienz.

Anwendungsszenario

- Schnelles Erlernen neuer Technologien

Geben Sie die URL der technischen Dokumentation ein, und DevDocs durchsucht und ordnet alle Seiten. Sie können sie direkt lesen oder Claude verwenden, um Fragen zu bestimmten Anwendungen zu stellen, und sich in wenigen Tagen mit der neuen Technologie vertraut machen. - Teamarbeit

Durchsuchen Sie interne Unternehmensdokumente und erzeugen Sie Markdown-Dateien. Teammitglieder fragen über den MCP-Server ab, um Wissen schnell zu teilen. - Entwicklung von großen Modellanwendungen

Sammeln Sie technische Daten mit DevDocs und geben Sie JSON-Dateien aus. Beschleunigen Sie die Entwicklung von KI-Anwendungen durch die Kombination von MCP-Servern und großen Modellen. - Individuelle Projektentwicklung

Indie-Entwickler durchforsten die Dokumentation mit DevDocs, arbeiten mit VSCode und Claude und erstellen Prototypen innerhalb weniger Tage.

QA

- Ist die Nutzung von DevDocs kostenpflichtig?

Es ist kostenlos. Es handelt sich um ein Open-Source-Tool, das kostenlos genutzt werden kann, und es sind weitere API-Funktionen geplant. - Programmiererfahrung erforderlich?

Nicht erforderlich. Die Installation erfolgt mit ein paar Zeilen von Befehlen, gefolgt von der Schnittstelle. - Was ist, wenn der Kriechgang scheitert?

Überprüfen Sie das Netzwerk, oder zeigen Sie die<项目目录>/logsProtokoll. Das häufigste Problem sind unzureichende Berechtigungen, folgen Sie einfach den Installationsschritten, um diese anzupassen. - Unterstützung für private Websites?

Unterstützung, solange die Website zugänglich ist. Interne Websites müssen die Netzanbindung gewährleisten. - Was ist der Unterschied zu FireCrawl?

DevDocs ist kostenlos, crawlt schnell (1000 Seiten/Minute), unterstützt 5 Tiefenstufen und MCP-Server, während FireCrawl kostenpflichtig ist und nur begrenzte Funktionen hat.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...