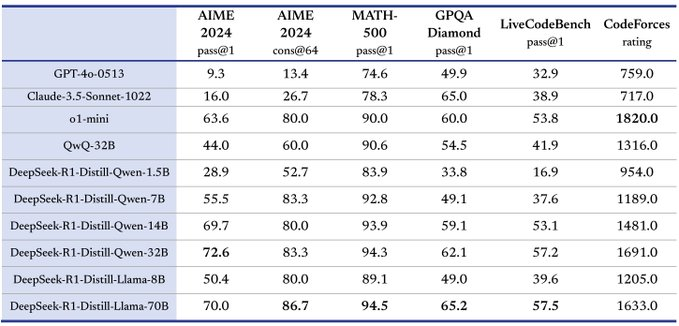

DeepSeek-V3/R1 Überblick über Reasoning-Systeme (DeepSeek Open Source Woche Tag 6)

Grundsätze der Systemgestaltung

Das Optimierungsziel des DeepSeek-V3/R1-Inferenzdienstes lautet:Höherer Durchsatz und geringere Latenzzeit.

Um diese beiden Ziele zu optimieren, setzt DeepSeek eine Lösung ein, die als knotenübergreifende Expertenparallelität (EP) bezeichnet wird.

- Erstens skaliert EP die Stapelgröße erheblich, wodurch die Effizienz der GPU-Matrixberechnung verbessert und der Durchsatz erhöht wird.

- Zweitens verringert EP die Latenzzeit, indem es die Experten auf mehrere GPUs verteilt, wobei jede GPU nur einen kleinen Teil der Experten verarbeitet (was den Speicherbedarf reduziert).

EP erhöht jedoch die Systemkomplexität in zweierlei Hinsicht:

- EP führt eine knotenübergreifende Kommunikation ein. Um den Durchsatz zu optimieren, müssen geeignete Berechnungsabläufe so gestaltet werden, dass sich Kommunikation und Berechnung überschneiden.

- EP umfasst mehrere Knoten und erfordert daher die Datenparallelität (DP) selbst und den Lastausgleich zwischen verschiedenen DP-Instanzen.

Dieser Artikel befasst sich mit DeepSeek Wie können diese Herausforderungen bewältigt werden?

- Verwenden Sie EP, um die Chargengröße zu erweitern.

- Verstecken von Kommunikationsverzögerungen hinter Berechnungen, und

- Lastausgleich durchführen.

Groß angelegte knotenübergreifende Expertenparallelität (EP)

Aufgrund der großen Anzahl von Experten in DeepSeek-V3/R1 (nur 8 von 256 Experten pro Schicht sind aktiviert) erfordert die hohe Sparsamkeit des Modells eine sehr große Gesamtstapelgröße. Dies gewährleistet eine ausreichende Stapelgröße pro Experte, was zu einem höheren Durchsatz und einer geringeren Latenz führt. Knotenübergreifende EP in großem Maßstab ist entscheidend.

Da DeepSeek eine getrennte Architektur für die Vorbevölkerung und die Dekodierung verwendet, werden in der Vorbevölkerungs- und der Dekodierungsphase unterschiedliche Parallelitätsgrade verwendet:

- Vorbesetzungsphase [Routing Expert EP32, MLA/Shared Expert DP32]Jede Bereitstellungseinheit erstreckt sich über 4 Knoten und verfügt über 32 redundante Routing-Experten, wobei jede GPU 9 Routing-Experten und 1 gemeinsamen Experten verwaltet.

- Dekodierungsphase [Routing Expert EP144, MLA/Sharing Expert DP144]Jede Bereitstellungseinheit umfasst 18 Knoten und hat 32 redundante Routing-Experten, wobei jede GPU 2 Routing-Experten und 1 gemeinsamen Experten verwaltet.

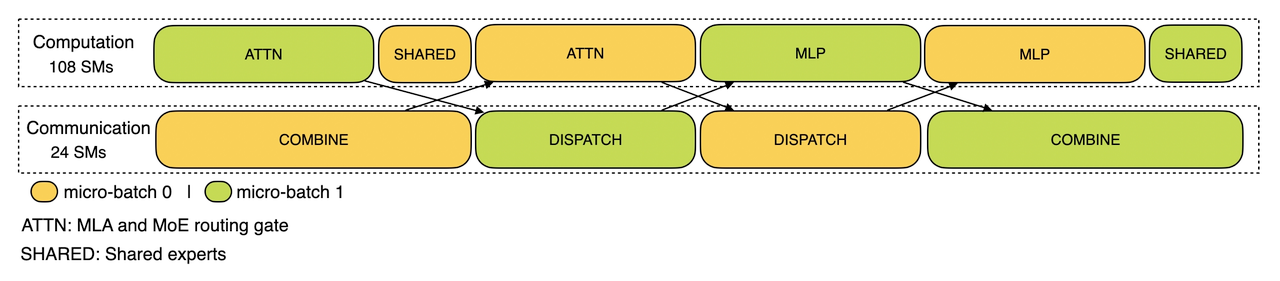

Überschneidung von Datenverarbeitung und Kommunikation

Groß angelegte knotenübergreifende EP führt zu einem erheblichen Kommunikations-Overhead. Um dies abzumildern, verwendet DeepSeek eine Strategie der doppelten Stapelüberlappung, um die Kommunikationskosten zu verbergen und den Gesamtdurchsatz zu verbessern, indem ein Stapel von Anfragen in zwei Mikrostapel aufgeteilt wird. In der Vorbevölkerungsphase werden diese beiden Mikrostapel abwechselnd ausgeführt, und die Kommunikationskosten des einen Mikrostapels werden hinter der Berechnung des anderen versteckt.

Berechnung der Vorbevölkerungsphase - Kommunikationsüberschneidung

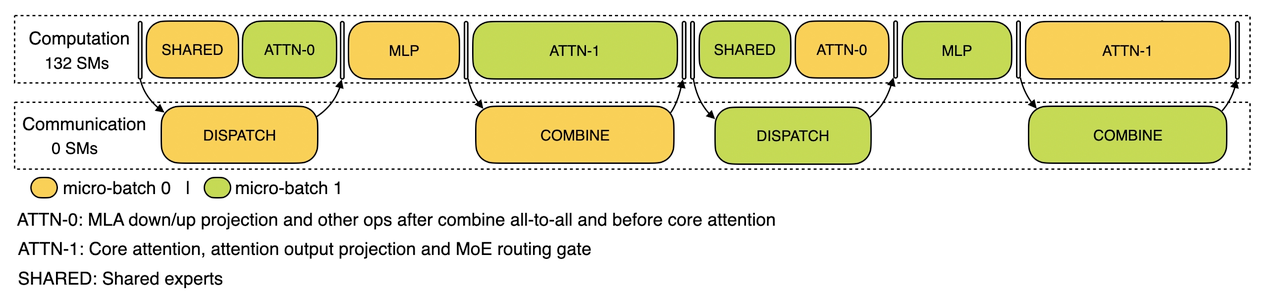

In der Dekodierungsphase ist die Ausführungszeit der verschiedenen Stufen ungleichmäßig. Daher unterteilt DeepSeek die Aufmerksamkeitsebene in zwei Schritte und verwendet eine 5-Phasen-Pipeline, um eine nahtlose Überlappung von Berechnung und Kommunikation zu erreichen.

Überschneidung von Datenverarbeitung und Kommunikation in der Dekodierungsphase

Weitere Einzelheiten zum DeepSeek-Mechanismus der Überschneidung von Berechnung und Kommunikation finden Sie unter https://github.com/deepseek-ai/profile-data.

Optimalen Lastausgleich erreichen

Massive Parallelität (einschließlich DP und EP) stellt eine große Herausforderung dar: Wenn eine einzelne GPU mit Berechnungen oder Kommunikation überlastet ist, wird sie zu einem Leistungsengpass und verlangsamt das gesamte System, während die anderen GPUs im Leerlauf sind. Um die Ressourcenauslastung zu maximieren, strebt DeepSeek danach, die Rechen- und Kommunikationslast auf alle GPUs zu verteilen.

1. vorbesetzter Load Balancer

- Hauptproblem: Die unterschiedliche Anzahl von Anfragen und Sequenzlängen zwischen den DV-Instanzen führt zu einem Ungleichgewicht bei der Berechnung des Kerns der Aufmerksamkeit und der Planung der Sendelast.

- Optimierungsziele:

- Verteilen Sie die Kernaufmerksamkeitsberechnungen auf die GPUs (Lastausgleich für Kernaufmerksamkeitsberechnungen).

- Entzerrung der Eingänge zu jeder GPU Token Anzahl (Scheduling Send Load Balancing), um lange Verarbeitungszeiten auf bestimmten GPUs zu vermeiden.

2. die Entschlüsselung von Lastverteilern

- Hauptproblem: Ungleiche Anzahl von Anfragen und Sequenzlängen zwischen den DV-Instanzen führen zu Unterschieden bei der Berechnung der Kernaufmerksamkeit (im Zusammenhang mit der KVCache-Nutzung) und der Scheduling-Send-Last.

- Optimierungsziele:

- Ausgleich der KVCache-Nutzung zwischen den GPUs (Core Attention Computing Lastausgleich).

- Ausgleich der Anzahl der Anfragen pro GPU (Scheduling Send Load Balancing).

3. fachkundiger paralleler Lastausgleicher

- Hauptproblem: Für ein bestimmtes MoE-Modell gibt es eine inhärent hohe Anzahl von Experten, was zu einer unausgewogenen Expertenberechnungslast zwischen verschiedenen GPUs führt.

- Optimierungsziele:

- Ausgleich der Expertenberechnungen auf jeder GPU (d. h. Minimierung der maximalen Empfangslast auf allen GPUs).

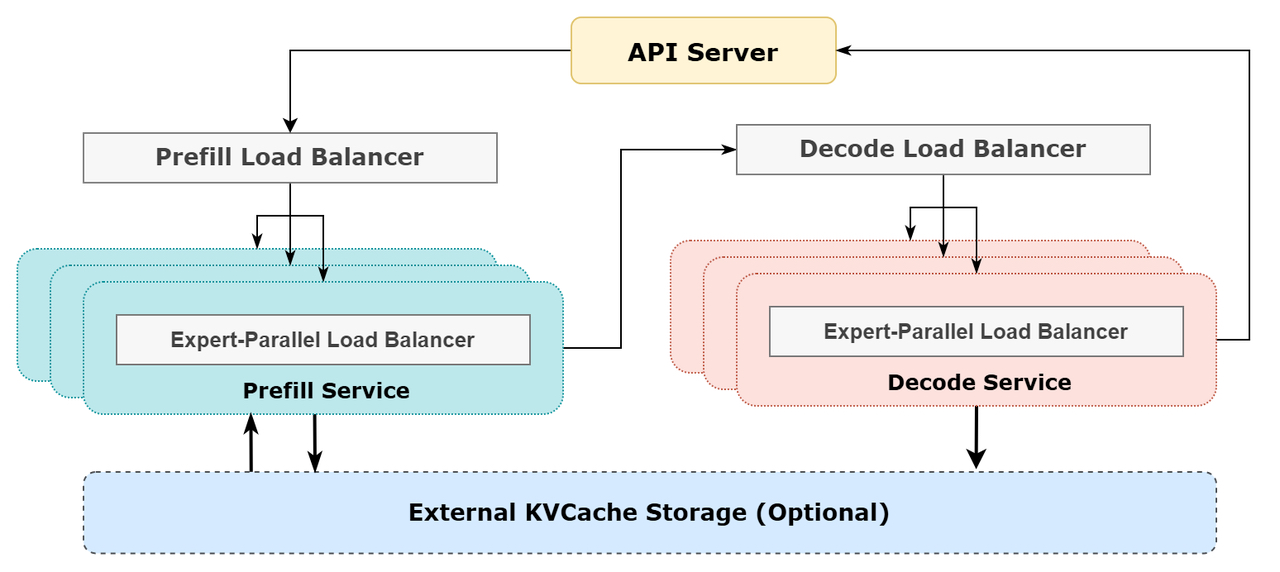

Schematische Darstellung des DeepSeek Online-Reasoning-Systems

Schematische Darstellung des DeepSeek Online-Reasoning-Systems

DeepSeek Online-Dienststatistiken

Alle DeepSeek-V3/R1-Inferenzdienste werden auf H800-GPUs mit einer dem Training entsprechenden Genauigkeit bereitgestellt. Insbesondere Matrixmultiplikation und Scheduling-Transfers sind im FP8-Format, das mit dem Training übereinstimmt, während Kern-MLA-Berechnungen und kombinatorische Transfers das BF16-Format verwenden, um eine optimale Serviceleistung zu gewährleisten.

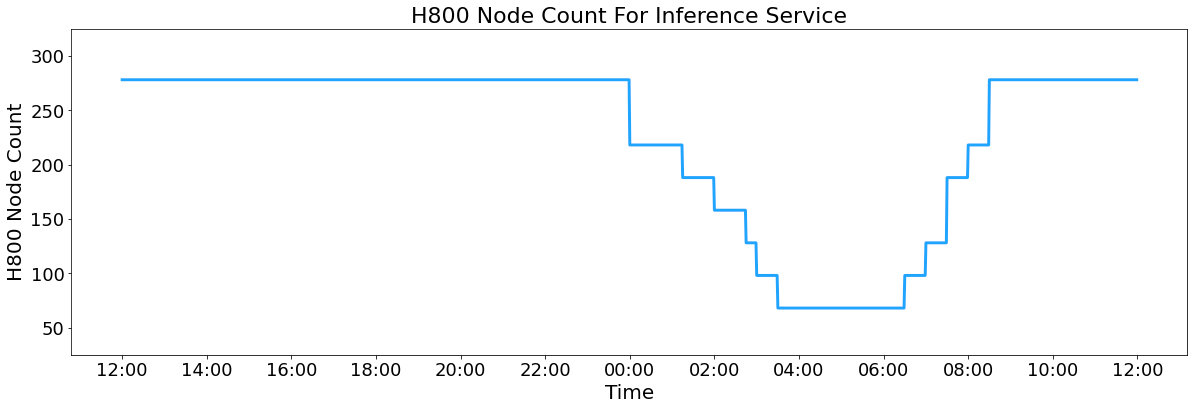

Außerdem hat DeepSeek aufgrund der hohen Auslastung des Dienstes am Tag und der geringen Auslastung in der Nacht einen Mechanismus implementiert, der den Inferenzdienst während der Spitzenzeiten am Tag auf allen Knoten bereitstellt. Bei geringer Auslastung in der Nacht reduziert DeepSeek die Inferenzknoten und weist die Ressourcen der Forschung und Schulung zu. In den vergangenen 24 Stunden (27. Februar 2025, 12:00 Uhr UTC+8 bis 28. Februar 2025, 12:00 Uhr UTC+8) belief sich die Spitzenknotenbelegung für die Inferenzdienste V3 und R1 auf insgesamt 278 Knoten mit einer durchschnittlichen Belegung von 226,75 Knoten (mit jeweils 8 H800-GPUs). Geht man von Mietkosten in Höhe von 2 $ pro Stunde für einen H800-GPU aus, so belaufen sich die täglichen Gesamtkosten auf 87.072 $.

H800 Anzahl der Knotenpunkte für Inferenzdienste

V3 und R1 während des 24-stündigen statistischen Zeitraums (12:00 Uhr UTC+8 27. Februar 2025 bis 12:00 Uhr UTC+8 28. Februar 2025):

- Eingabe-Token insgesamt: 608B, davon 342B Token (56,3%) im KV-Cache auf der Festplatte.

- Total Output Token: 168 B. Die durchschnittliche Ausgabegeschwindigkeit beträgt 20-22 Token pro Sekunde, und die durchschnittliche Kvcache-Länge jedes Output-Tokens beträgt 4.989 Token.

- Jeder H800-Knoten bietet einen durchschnittlichen Eingabedurchsatz von ~73,7k Token/s (einschließlich Cache-Treffern) während der Vorbelegung oder ~14,8k Token/s Ausgabedurchsatz während der Dekodierung.

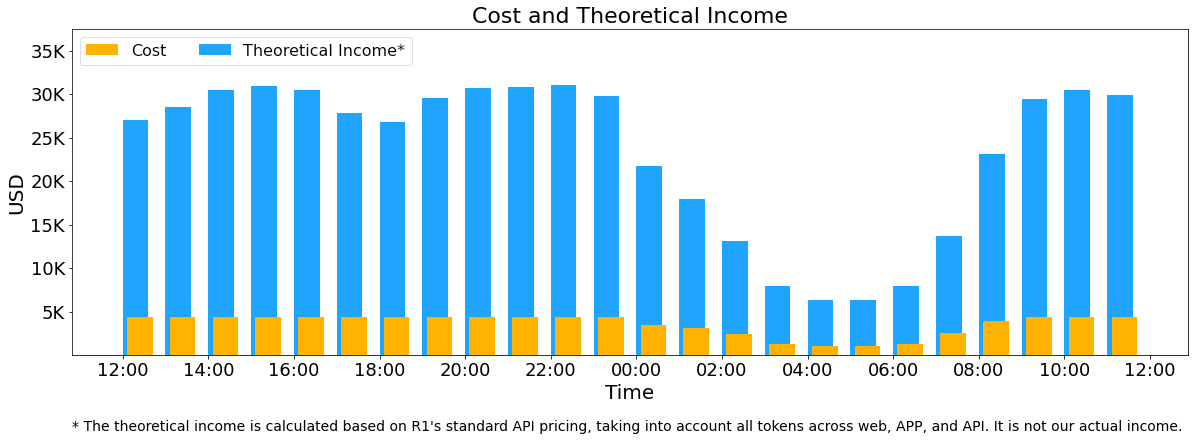

Die obigen Statistiken umfassen alle Nutzeranfragen aus dem Web, der App und der API. Wenn alle Token in Übereinstimmung mit der DeepSeek-R1 Die täglichen Gesamteinnahmen belaufen sich auf 562.027 $ mit einer Kostenspanne von 545% auf der Grundlage der Preisgestaltung (*).

() R1 Preisgestaltung: $0,14/M für Eingabe-Token (Cache-Treffer), $0,55/M für Eingabe-Token (Cache-Fehler), $2,19/M für Ausgabe-Token.

Die tatsächlichen Einnahmen von DeepSeek sind jedoch aus den folgenden Gründen viel niedriger:

- Der DeepSeek-V3 liegt preislich deutlich unter dem R1, dem

- Nur einige der Dienste sind kostenpflichtig (der Web- und APP-Zugang bleibt kostenlos).

- Nächtliche Ermäßigungen werden automatisch außerhalb der Hauptverkehrszeiten gewährt.

Kosten und theoretische Einnahmen

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...