Deep Searcher: Effiziente Suche nach privaten Unternehmensdokumenten und intelligente Fragen und Antworten

Allgemeine Einführung

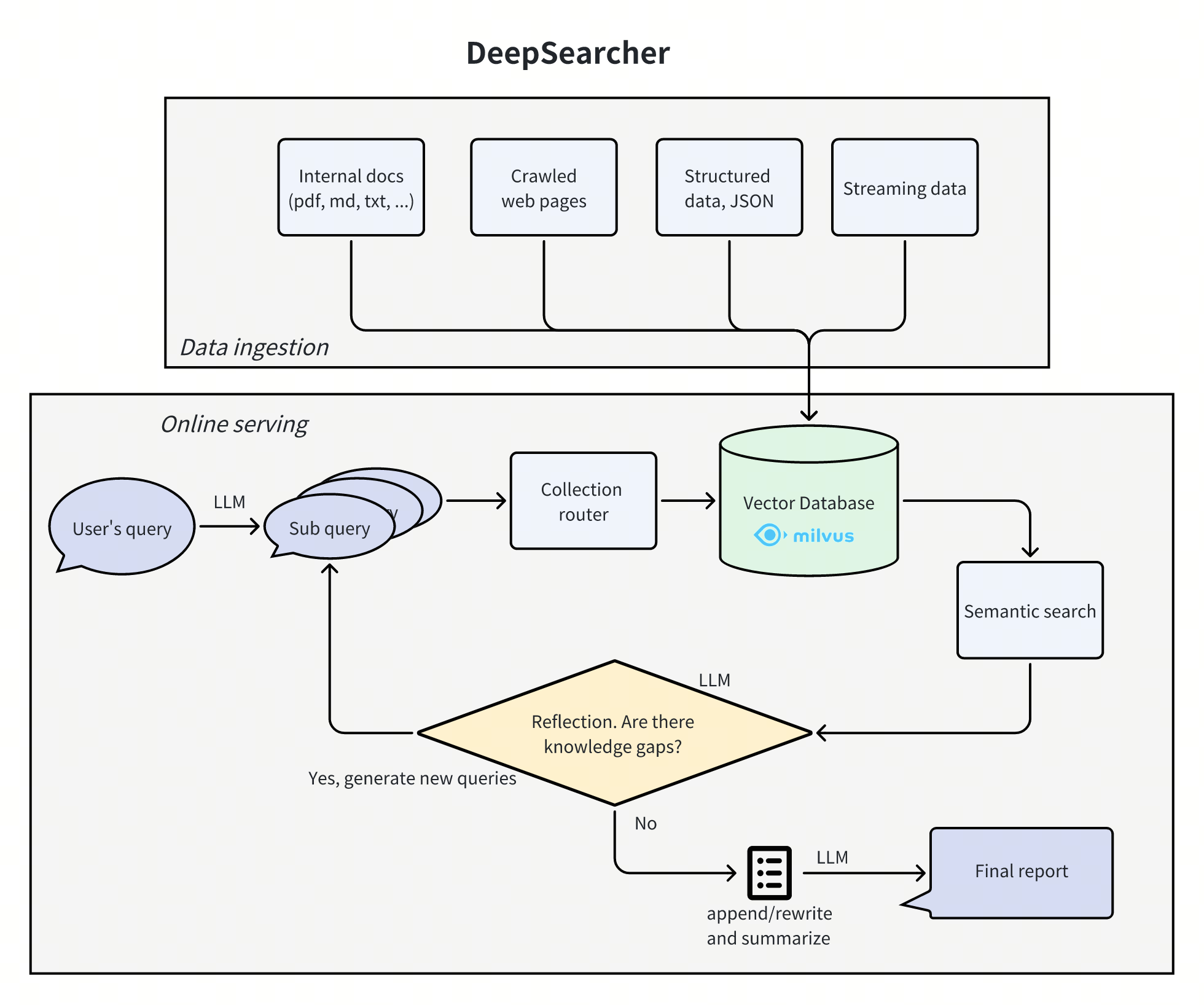

Deep Searcher ist eine Kombination aus leistungsstarken großen Sprachmodellen (wie dem DeepSeek und OpenAI) und Vektordatenbanken (z. B. Milvus) sind Werkzeuge, die für die Suche, Auswertung und Schlussfolgerung auf der Grundlage privater Daten entwickelt wurden und hochpräzise Antworten und umfassende Berichte liefern. Deep Searcher unterstützt eine breite Palette von Einbettungsmodellen und großen Sprachmodellen und ist in der Lage, Vektordatenbanken zu verwalten, um ein effizientes Abrufen und eine sichere Nutzung von Daten zu gewährleisten.

Funktionsliste

- Suche nach privaten DatenMaximale Nutzung von Daten innerhalb des Unternehmens und Gewährleistung der Datensicherheit.

- Verwaltung von VektordatenbankenUnterstützung für Vektordatenbanken wie Milvus, die eine Datenpartitionierung für eine effizientere Suche ermöglichen.

- Flexible EinbettungsoptionenKompatibel mit mehreren Einbettungsmodellen zur einfachen Auswahl der besten Option.

- Unterstützung mehrsprachiger ModelleUnterstützung für große Modelle wie DeepSeek, OpenAI, etc. für intelligente Q&A und Inhaltsgenerierung.

- Dokumenten-LaderLokales Laden von Dateien wird unterstützt und Web-Crawling wird in Zukunft hinzugefügt.

Hilfe verwenden

Einbauverfahren

- Klon-Lagerhaus:

git clone https://github.com/zilliztech/deep-searcher.git

- Erstellen Sie eine virtuelle Python-Umgebung (empfohlen):

python3 -m venv .venv

source .venv/bin/activate

- Installieren Sie die Abhängigkeit:

cd deep-searcher

pip install -e .

- LLM oder Milvus konfigurieren: Bearbeiten

examples/example1.pyDatei, um LLM oder Milvus nach Bedarf zu konfigurieren. - Bereiten Sie die Daten vor und führen Sie das Beispiel aus:

python examples/example1.py

Anweisungen für den Gebrauch

- LLM konfigurieren: In

deepsearcher.configurationModul, verwenden Sie dieset_provider_configMethoden zur Konfiguration des LLM. z.B. Konfiguration eines OpenAI-Modells:

config.set_provider_config("llm", "OpenAI", {"model": "gpt-4o"})

- Lokale Daten laden: Verwendung

deepsearcher.offline_loadingim Modulload_from_local_filesMethode, um lokale Daten zu laden:

load_from_local_files(paths_or_directory="your_local_path")

- Daten abfragen: Verwendung

deepsearcher.online_queryim ModulqueryMethoden werden abgefragt:

result = query("Write a report about xxx.")

Detaillierte Funktionsabläufe

- Suche nach privaten Daten::

- Maximieren Sie die Nutzung von Daten in Ihrem Unternehmen und gewährleisten Sie gleichzeitig die Datensicherheit.

- Online-Inhalte können integriert werden, wenn genauere Antworten benötigt werden.

- Verwaltung von Vektordatenbanken::

- Unterstützt Vektordatenbanken wie Milvus, die eine Partitionierung der Daten für einen effizienteren Abruf ermöglichen.

- Die Unterstützung für weitere Vektordatenbanken (z.B. FAISS) ist für die Zukunft geplant.

- Flexible Einbettungsoptionen::

- Kompatibel mit einer breiten Palette von Embedded-Modellen für eine einfache Auswahl der besten Lösung.

- Unterstützung mehrsprachiger Modelle::

- Unterstützt große Modelle wie DeepSeek, OpenAI usw. für intelligente Fragen und die Erstellung von Inhalten.

- Dokumenten-Lader::

- Das Laden lokaler Dateien wird unterstützt, und Web-Crawling wird in Zukunft hinzugefügt werden.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...