CogAgent: Smart Spectrums quelloffenes intelligentes visuelles Sprachmodell für die Automatisierung grafischer Oberflächen

Allgemeine Einführung

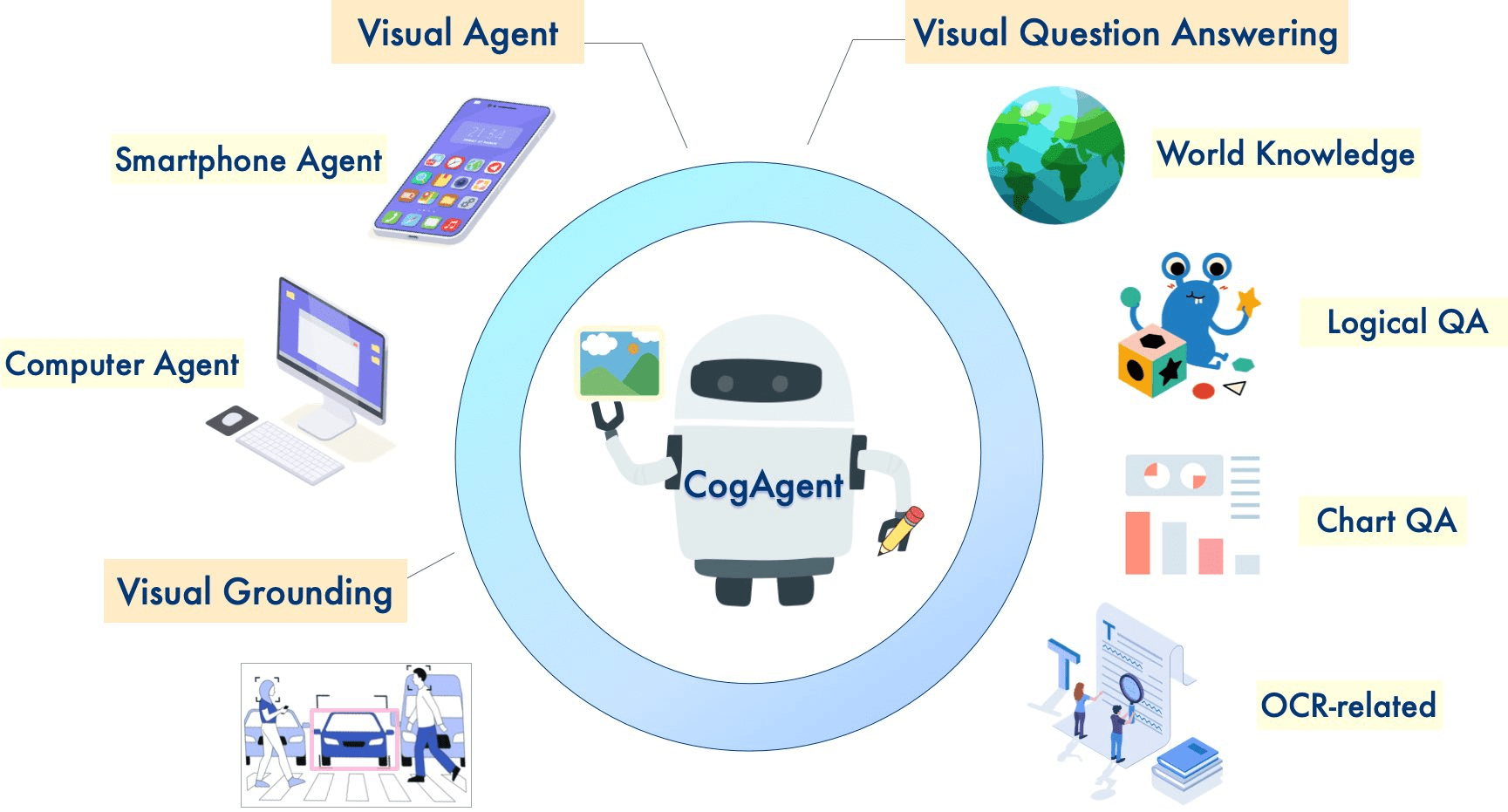

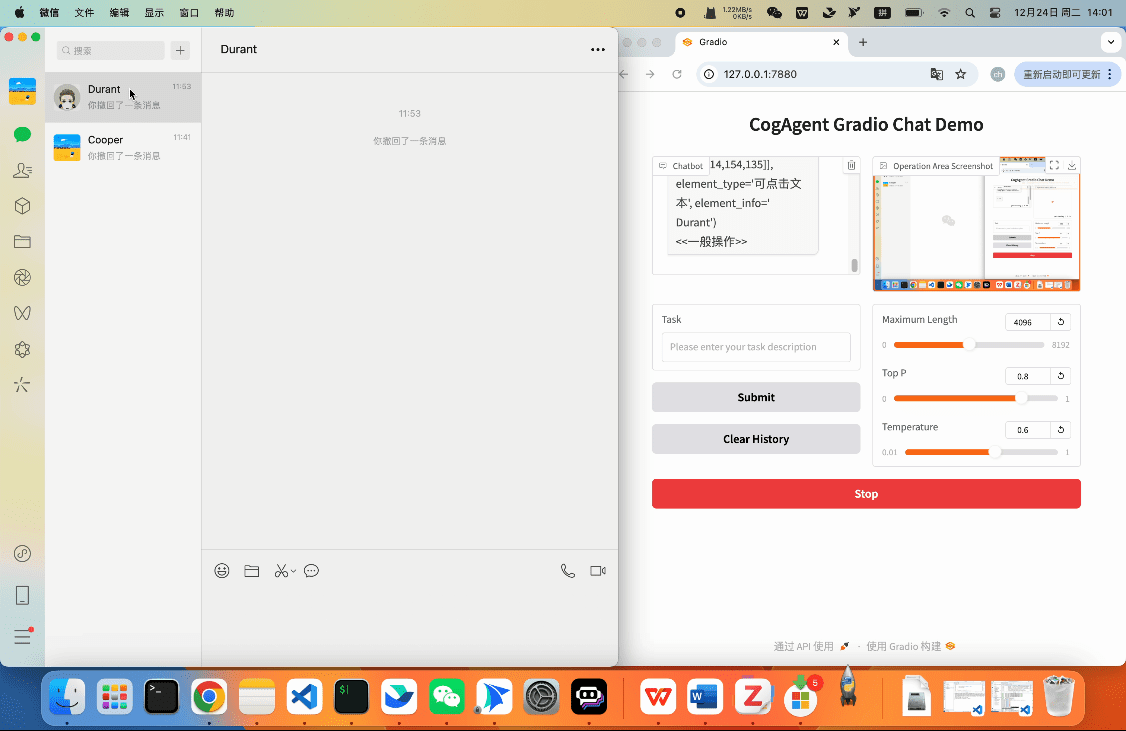

CogAgent ist ein quelloffenes visuelles Sprachmodell, das von der Tsinghua University Data Mining Research Group (THUDM) entwickelt wurde und darauf abzielt, plattformübergreifende grafische Benutzeroberflächen (GUI) zu automatisieren. Das Modell basiert auf CogVLM (GLM-4V-9B), unterstützt zweisprachige Interaktionen in Englisch und Chinesisch und ist in der Lage, Aufgaben über Screenshots und natürliche Sprache auszuführen.CogAgent hat führende Leistungen bei GUI-Aufgaben über mehrere Plattformen und Kategorien hinweg erzielt und eignet sich für eine breite Palette von Computergeräten wie Windows, macOS und Android. Die neueste Version, CogAgent-9B-20241220, bietet erhebliche Verbesserungen bei der GUI-Wahrnehmung, der Genauigkeit der Schlussfolgerungen, der Vollständigkeit des Operationsraums und der Generalisierbarkeit von Aufgaben.

CogAgent-9B-20241220Das Modell basiert auf GLM-4V-9B, einem zweisprachigen Open-Source-VLM-Basismodell. Durch Datenerfassung und -optimierung, mehrstufiges Training und Strategieverbesserung wird dasCogAgent-9B-20241220Erhebliche Fortschritte wurden bei der GUI-Wahrnehmung, der Vorhersagegenauigkeit, der Vollständigkeit des Aktionsraums und der aufgabenübergreifenden Generalisierungsfähigkeit erzielt. Das Modell unterstützt zweisprachige Interaktion (Chinesisch und Englisch), einschließlich Screenshots und verbaler Eingaben. Diese Version des CogAgent-Modells wurde im GLM-PC-Produkt von Smart Spectrum AI verwendet.

Funktionsliste

- Hochauflösendes Bildverständnis und -verarbeitung (unterstützt eine Auflösung von 1120x1120)

- Automatisierungsfähigkeit der GUI-Schnittstelle

- Plattformübergreifend kompatible Schnittstelleninteraktion

- Visuelle Frage und Antwort (VQA) Aufgabenbearbeitung

- Verstehen und Analysieren von Diagrammen (ChartQA)

- Dokument Visuelle Frage und Antwort (DocVQA)

- Information Visuelle Frage und Antwort (InfoVQA)

- Verstehen von Szenentexten (ST-VQA)

- Visuelles Quiz zum Allgemeinwissen (OK-VQA)

Hilfe verwenden

1. ökologische Konfiguration

1.1 Anforderungen an das Fundament:

- Python 3.8 oder höher

- Von CUDA unterstützte GPU-Geräte

- Ausreichend Videospeicherplatz (mindestens 16 GB empfohlen)

1.2 Installationsschritte:

# 克隆项目仓库

git clone https://github.com/THUDM/CogAgent.git

cd CogAgent

# 安装依赖

pip install -r requirements.txt

2. das Laden und die Verwendung des Modells

2.1 Modell-Download:

- Laden Sie die Datei mit den Modellgewichten von der Plattform Hugging Face herunter

- Zwei Versionen werden unterstützt: cogagent-18b und cogagent-9b.

2.2 Grundlegendes Nutzungsverfahren:

from cogagent import CogAgentModel

# 初始化模型

model = CogAgentModel.from_pretrained("THUDM/CogAgent")

# 加载图像

image_path = "path/to/your/image.jpg"

response = model.process_image(image_path)

# 执行GUI操作

gui_command = model.generate_gui_command(image_path, task_description)

model.execute_command(gui_command)

3. eine Beschreibung der Nutzung der Hauptfunktionen

3.1 Bildverarbeitungsfunktion:

- Unterstützt die Eingabe mehrerer Bildformate

- Verarbeitet Bilder mit einer Auflösung von bis zu 1120x1120

- Bietet eine detaillierte Beschreibung und Analyse des Bildinhalts

3.2 GUI-Automatisierung:

- Unterstützung bei der Erkennung von Oberflächenelementen

- Klicken, Ziehen und Ablegen, Eingabe und andere Operationen durchführen.

- Bereitstellung von Mechanismen zur Validierung von Operationen und zur Fehlerbehandlung

3.3 Visuelle Frage- und Antwortfunktion:

- Unterstützung für natürlichsprachliche Befragungen

- Detaillierte bildbezogene Antworten geben

- Kann mit komplexen Argumentationsproblemen umgehen

4 Empfehlungen zur Leistungsoptimierung

4.1 Speicherverwaltung:

- Verwenden Sie die geeignete Chargengröße

- Bereinigung nicht verwendeter Modellinstanzen in angemessener Zeit

- Kontrolle der Anzahl gleichzeitiger Verarbeitungsaufgaben

4.2 Optimierung der Argumentationsgeschwindigkeit:

- Beschleunigte Inferenz mit FP16-Präzision

- Ermöglichung der Modellquantifizierung zur Reduzierung des Ressourcenverbrauchs

- Optimierung des Bildvorverarbeitungsprozesses

5. die Lösung gemeinsamer Probleme

5.1 Speicherprobleme:

- Überprüfung der Nutzung des Videospeichers

- Angemessene Größenänderung der Chargen

- Verwendung der Gradient Checkpoint Technik

5.2 Probleme mit der Genauigkeit:

- Sicherstellung der Qualität des Eingangsbildes

- Anpassung der Konfiguration der Modellparameter

- Überprüfen Sie, ob die Vorverarbeitungsschritte korrekt sind

Hauptfunktionen

- Ein-Schritt-BetriebAusführen von Einzelschrittaktionen wie das Öffnen einer Anwendung, Anklicken einer Schaltfläche usw. durch einfache Befehle in natürlicher Sprache.

- MehrschrittbetriebUnterstützung komplexer mehrstufiger betrieblicher Aufgaben und automatisierter Arbeitsabläufe durch sequenzielle Anweisungen.

- Aufgabenaufzeichnung und -wiedergabeAufzeichnung des Benutzerbetriebsverlaufs und Unterstützung der Wiedergabefunktion zur Fehlersuche und Optimierung.

- FehlerbehandlungEingebauter Fehlerbehandlungsmechanismus, der häufige Betriebsfehler erkennt und behandelt, um eine reibungslose Aufgabenerfüllung zu gewährleisten.

Ausgewählte Funktionen

- Effizientes ReasoningBei BF16-Genauigkeit erfordert die Modellinferenz mindestens 29 GB GPU-Speicher, und es wird ein A100- oder H100-GPU empfohlen.

- Flexibler EinsatzUnterstützt den Einsatz auf einer breiten Palette von Hardware-Plattformen, einschließlich HuggingFace, ModelScope und WiseModel.

- Unterstützung der GemeinschaftEine aktive Open-Source-Community, die technischen Support und Antworten auf Fragen bietet, um Entwicklern einen schnellen Einstieg zu ermöglichen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...