ChatTTS: ein Spracherzeugungsmodell, das die Stimme eines echten Sprechers imitiert (ChatTTS-Beschleunigungspaket mit einem Klick)

Allgemeine Einführung

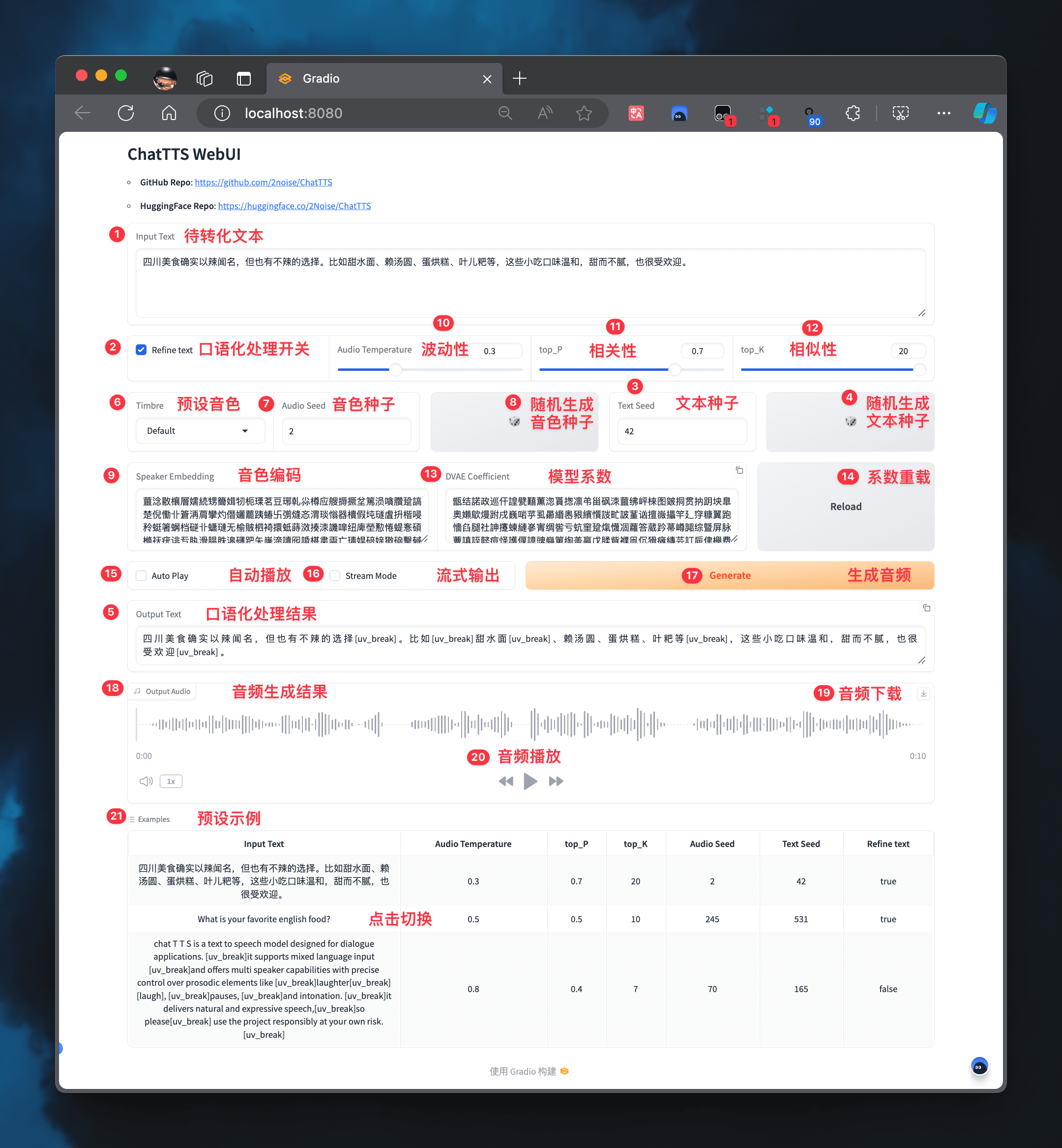

ChatTTS ist ein generatives Sprachmodell, das für Dialogszenarien entwickelt wurde. Es erzeugt natürliche und ausdrucksstarke Sprache, unterstützt mehrere Sprachen und mehrere Sprecher und ist für interaktive Dialoge geeignet. Das Modell übertrifft die meisten Open-Source-Sprachsynthesemodelle, indem es feinkörnige rhythmische Merkmale wie Lachen, Pausen und Zwischenrufe vorhersagt und kontrolliert.ChatTTS bietet vortrainierte Modelle zur Unterstützung weiterer Forschung und Entwicklung, hauptsächlich für akademische Zwecke.

Funktionsliste

- Unterstützung mehrerer SprachenChinesisch und Englisch werden unterstützt, und weitere Sprachen werden in Zukunft hinzukommen.

- Multi-Talker-UnterstützungDie Fähigkeit, die Stimmen mehrerer Sprecher zu erzeugen, macht es für interaktive Dialoge geeignet.

- Feinkörnige rhythmische KontrolleRhythmische Merkmale wie Lachen, Pausen und Zwischenrufe können vorhergesagt und kontrolliert werden.

- Pre-Training ModellBietet 40.000 Stunden an vortrainierten Modellen zur Unterstützung weiterer Forschung und Entwicklung.

- offene QuelleDer Code ist Open Source auf GitHub für akademische und wissenschaftliche Zwecke.

Hilfe verwenden

Einbauverfahren

- Projektcode klonen::

git clone https://github.com/2noise/ChatTTS.git - Installation von Abhängigkeiten::

cd ChatTTS pip install -r requirements.txt - Herunterladen des vortrainierten ModellsDownloaden Sie das trainierte Modell von HuggingFace oder ModelScope und legen Sie es im angegebenen Verzeichnis ab.

Verwendung

- Modelle laden::

from chattts import ChatTTS model = ChatTTS.load_model('path/to/pretrained/model') - Sprache generieren::

text = "你好,欢迎使用ChatTTS!" audio = model.synthesize(text) - Speichern von Audiodateien::

with open('output.wav', 'wb') as f: f.write(audio)

Detaillierte Funktionsweise

- TexteingabeUnterstützt gemischte chinesische und englische Texteingabe.

- Rhythmische KontrolleReimeigenschaften wie Lachen, Pausen und Zwischenrufe werden durch die Einstellung von Parametern gesteuert.

- KlangregelungDer erzeugte Ton kann durch einen voreingestellten Ton-Seed-Wert oder Ton-Code gesteuert werden.

- emotionale KontrolleSteuerung der emotionalen Eigenschaften der generierten Sprache durch die Einstellung der Parameter Emotionsschwankung und Relevanz.

- Streaming-AusgangUnterstützt lange Audiogenerierung und zeichenbasiertes Lesen für komplexe Dialogszenarien.

Beispielcode (Rechnen)

from chattts import ChatTTS

# 加载模型

model = ChatTTS.load_model('path/to/pretrained/model')

# 设置文本和韵律参数

text = "你好,欢迎使用ChatTTS!"

params = {

'laugh': True,

'pause': True,

'interjection': True

}

# 生成语音

audio = model.synthesize(text, params)

# 保存音频文件

with open('output.wav', 'wb') as f:

f.write(audio)

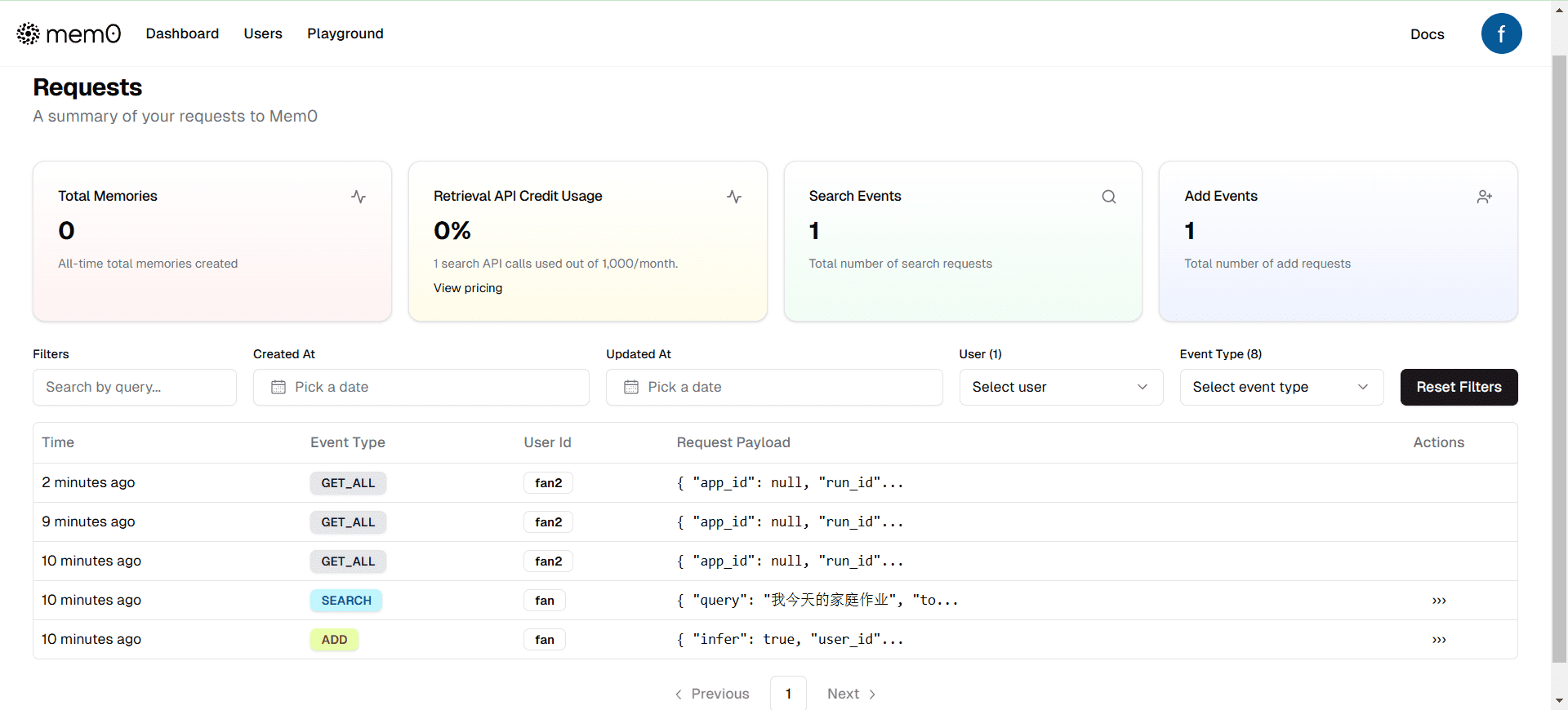

ChatTTS-Klient

Schnelle Erfahrung

| Internetadresse | Typologie |

|---|---|

| Original Web | Original Web-Erlebnis |

| Web schmieden | Verbessertes Erlebnis formen |

| Linux | Python-Installationsprogramm |

| Proben | Beispiele für Tonsamen |

| Klonen | Tone Cloning Erfahrung |

Funktionserweiterung

| Sportereignis | Lichtblick |

|---|---|

| jianchang512/ChatTTS-ui | Bietet eine API-Schnittstelle, die in Anwendungen von Drittanbietern aufgerufen werden kann |

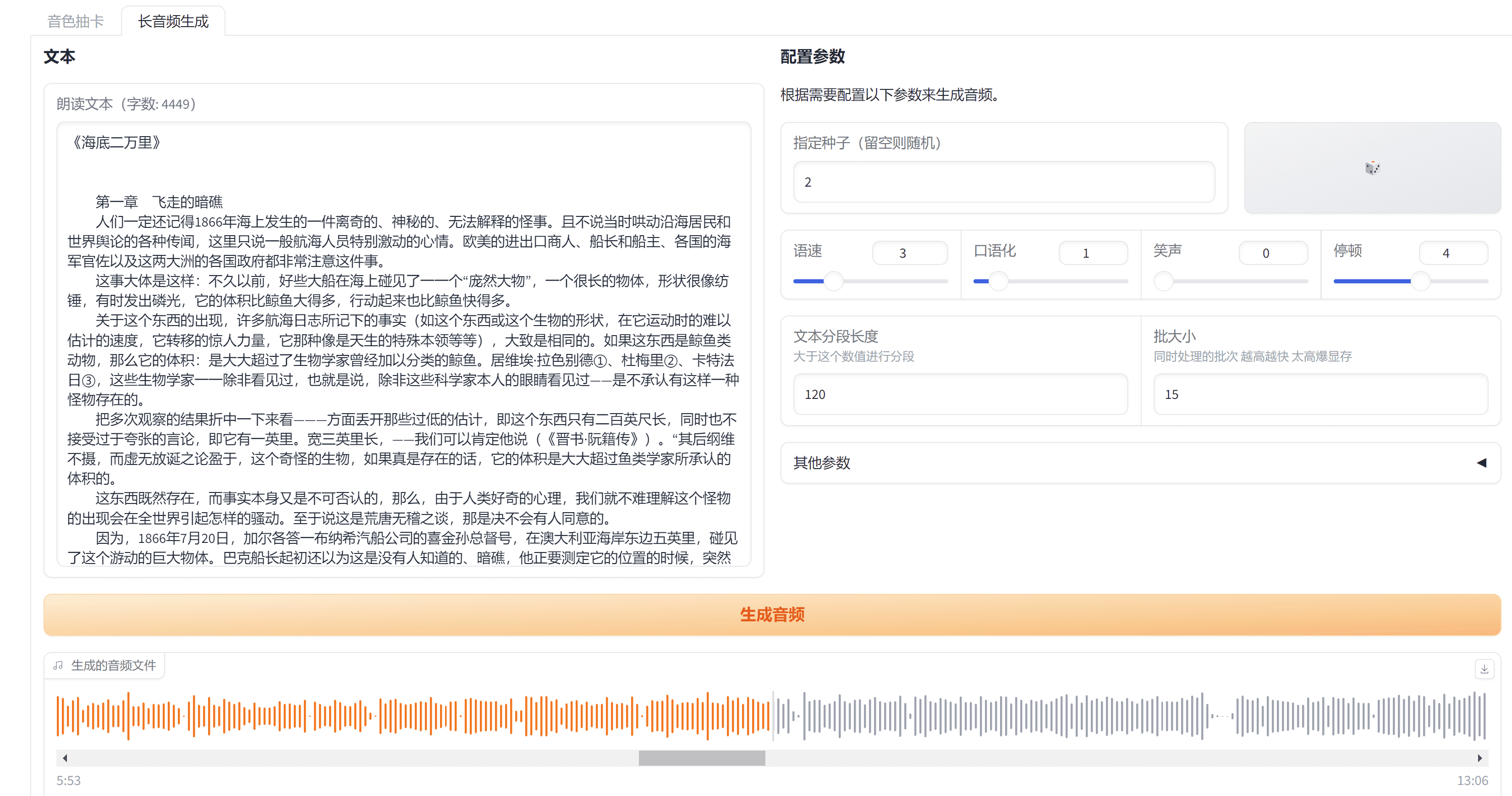

| 6drf21e/ChatTTS_colab | Bietet eine Streaming-Ausgabe mit Unterstützung für die Erzeugung langer Audiodaten und das Lesen in mehreren Rollen |

| lenML/ChatTTS-Forge | Bietet Stimmverbesserung und Reduzierung von Hintergrundgeräuschen mit zusätzlichen Stichworten |

| CCmahua/ChatTTS-Enhanced | Unterstützt die Stapelverarbeitung von Dateien und den Export von SRT-Dateien. |

| HKoon/ChatTTS-OpenVoice | fit OpenVoice Klonen von Ton durchführen |

Erweiterung der Funktionalität

| Sportereignis | Lichtblick |

|---|---|

| 6drf21e/ChatTTS_Lautsprecher | Kennzeichnung von Klangcharakteren und Stabilitätsbewertung |

| AIFSH/ComfyUI-ChatTTS | ComfyUi Version, die als Workflow-Knoten eingeführt werden kann |

| MaterialSchatten/ChatTTS-manager | Ein Tonmanagementsystem und eine WebUI-Schnittstelle sind vorhanden. |

ChatTTSPlus Beschleunigtes Ein-Klick-Installationspaket

ChatTTSPlus ist eine erweiterte Version von ChatTTS, die die TensorRT-Beschleunigung, das Klonen von Sprache und die Bereitstellung von mobilen Modellen zum Original hinzufügt. Es ist einfach zu benutzen, bietet ein Windows Ein-Klick-Installationsprogramm und erreicht eine mehr als dreifache Leistungssteigerung mit TensorRT (von 28 Token/s auf 110 Token/s auf Windows 3060 GPUs). Es unterstützt das Klonen von Sprache mit LoRA und entwickelt Modellkompressions- und Beschleunigungstechniken für den mobilen Einsatz.ChatTTSPlus ist ein leistungsfähiges und einfach zu bedienendes Sprachsynthesewerkzeug für eine Vielzahl von Szenarien, mit besonderen Stärken bei Anwendungen, die eine hohe Leistung und Fähigkeiten zum Klonen von Sprache erfordern.

Anschrift: https://github.com/warmshao/ChatTTSPlus

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...