ChatMCP: AI-Chat-Client, der das MCP-Protokoll implementiert und mehrere LLM-Modelle unterstützt

Allgemeine Einführung

ChatMCP ist ein quelloffener AI-Chat-Client zur Implementierung des Model Context Protocol (MCP). Das vom GitHub-Benutzer daodao97 entwickelte Projekt unterstützt eine Vielzahl von Large Language Models (LLMs) wie OpenAI, Claude und OLLama usw. ChatMCP bietet nicht nur Chat-Funktionen mit dem MCP-Server, sondern umfasst auch eine Reihe nützlicher Funktionen wie die automatische Installation des MCP-Servers, die Chat-Protokollverwaltung und eine bessere Gestaltung der Benutzeroberfläche. Das Projekt steht unter der GNU General Public Licence v3.0 (GPL-3.0), die es den Benutzern erlaubt, es frei zu benutzen, zu verändern und zu verbreiten.

Funktionsliste

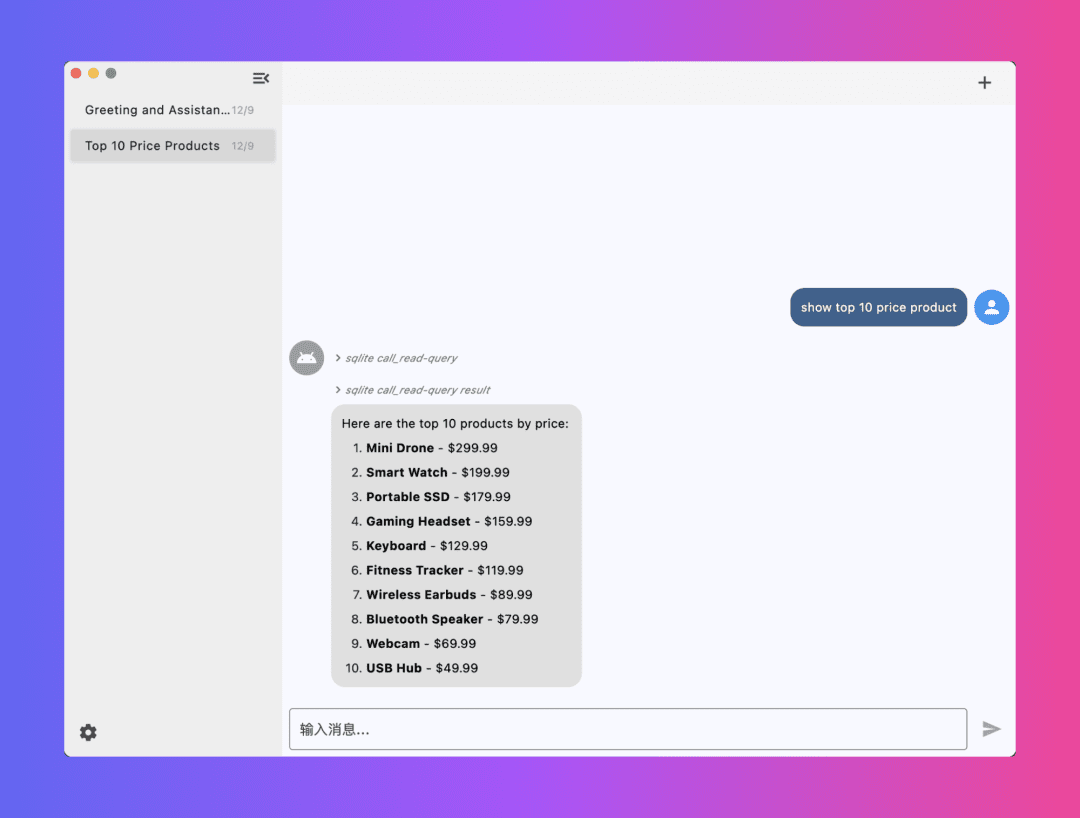

- Unterstützung für das Chatten mit MCP-Servern

- Automatische Installation des MCP-Servers

- Unterstützung der SSE MCP-Übertragung

- Automatische Auswahl des MCP-Servers

- Chat Records Management

- Unterstützung für mehrere LLM-Modelle (OpenAI, Claude, OLLama, usw.)

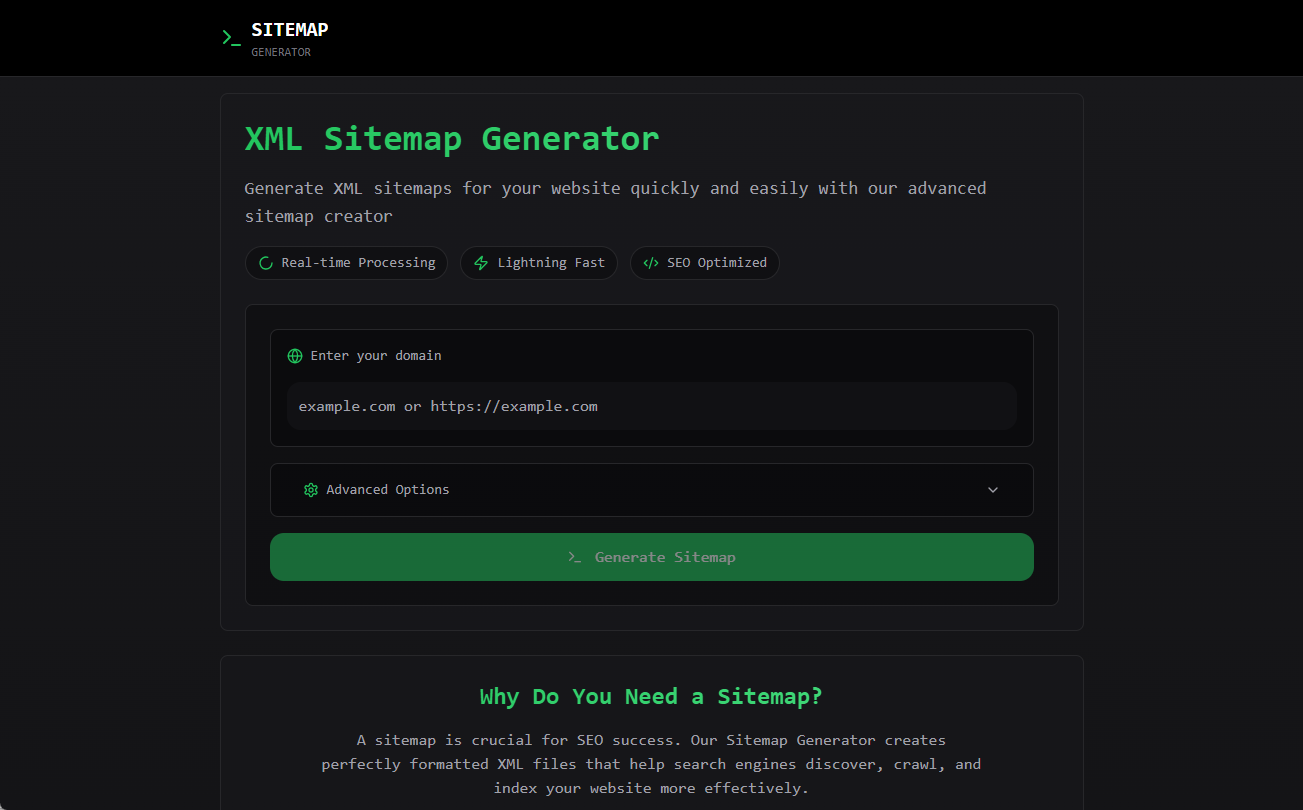

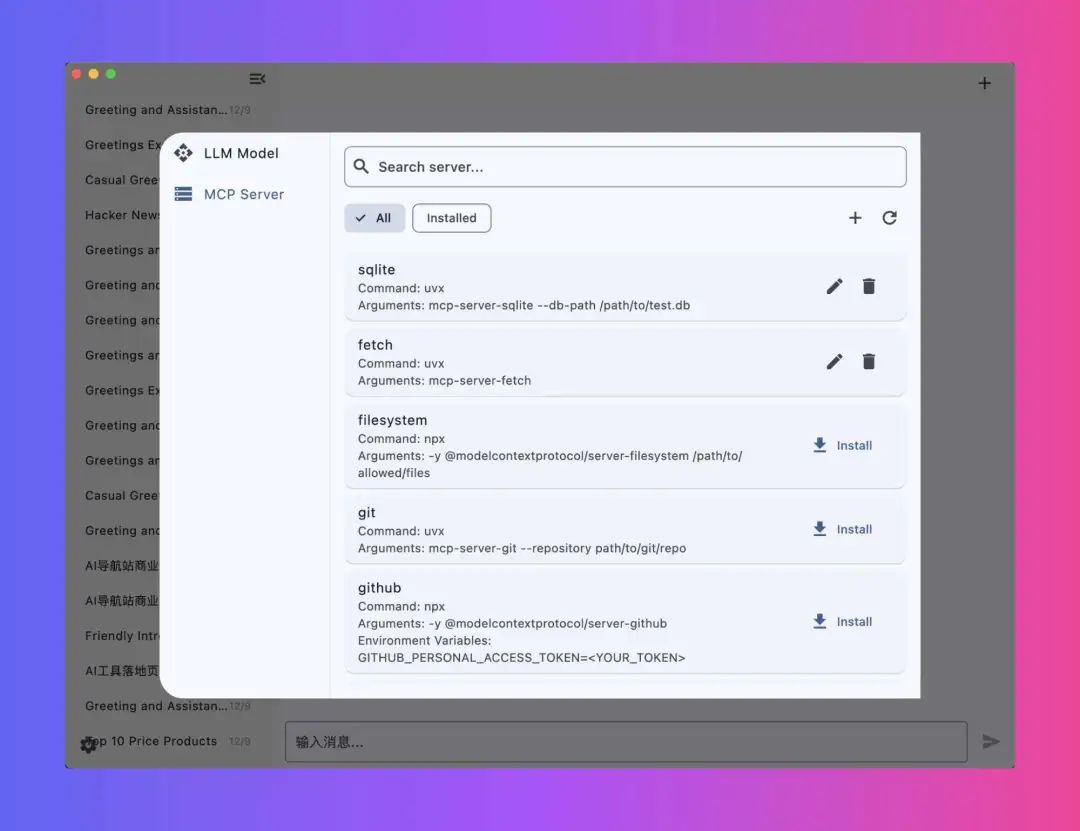

- Bereitstellung eines MCP-Server-Marktplatzes für die einfache Installation verschiedener MCP-Server

- Bessere Gestaltung der Benutzeroberfläche

- Unterstützung mehrerer Plattformen (MacOS, Windows, Linux, usw.)

Hilfe verwenden

Einbauverfahren

- Installation von AbhängigkeitenStellen Sie sicher, dass uvx oder npx auf Ihrem System installiert ist.

- Installieren Sie uvx:

brew install uv - npx installieren:

brew install node

- Installieren Sie uvx:

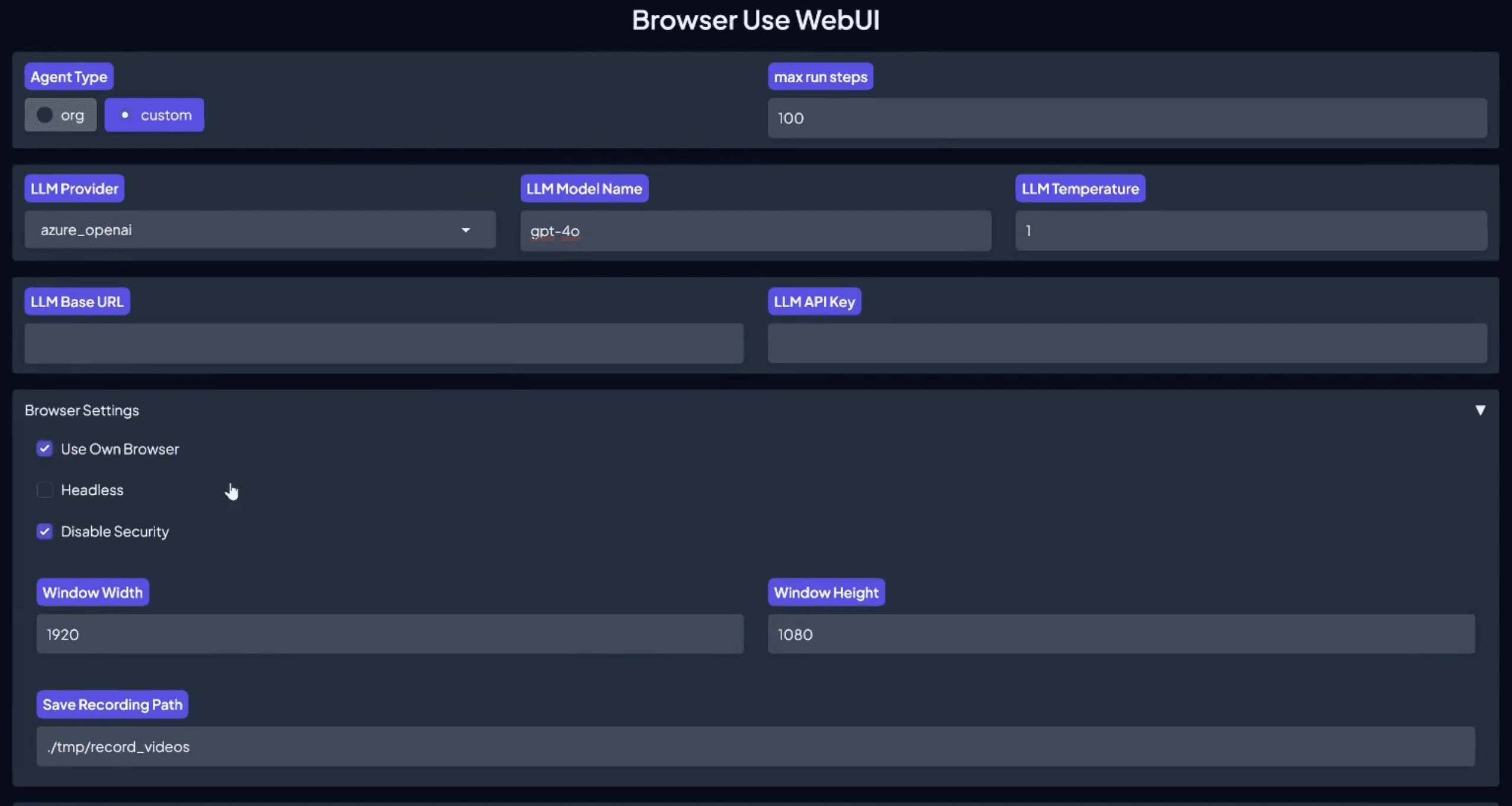

- Konfigurieren von LLM-API-Schlüsseln und -Endpunkten: Konfigurieren Sie Ihre LLM-API-Schlüssel und -Endpunkte auf der Seite Einstellungen.

- Installation des MCP-ServersInstallieren Sie den MCP-Server über die Seite MCP-Server.

- Client herunterladenWählen Sie je nach Betriebssystem, ob Sie die MacOS- oder die Windows-Version herunterladen möchten.

- Debugging-Protokoll: Die Protokolldatei befindet sich im Verzeichnis

~/Library/Application Support/run.daodao.chatmcp/logs. - Datenbank und Konfigurationsdateien::

- Chat-Protokoll-Datenbank:

~/Documents/chatmcp.db - MCP-Server-Konfigurationsdatei:

~/Documents/mcp_server.json

- Chat-Protokoll-Datenbank:

- Anwendung zurücksetzen: Verwenden Sie den folgenden Befehl, um die Anwendung zurückzusetzen:

rm -rf ~/Library/Application\ Support/run.daodao.chatmcp

rm -rf ~/Documents/chatmcp.db

rm -rf ~/Documents/mcp_server.json

Verwendungsfunktionen

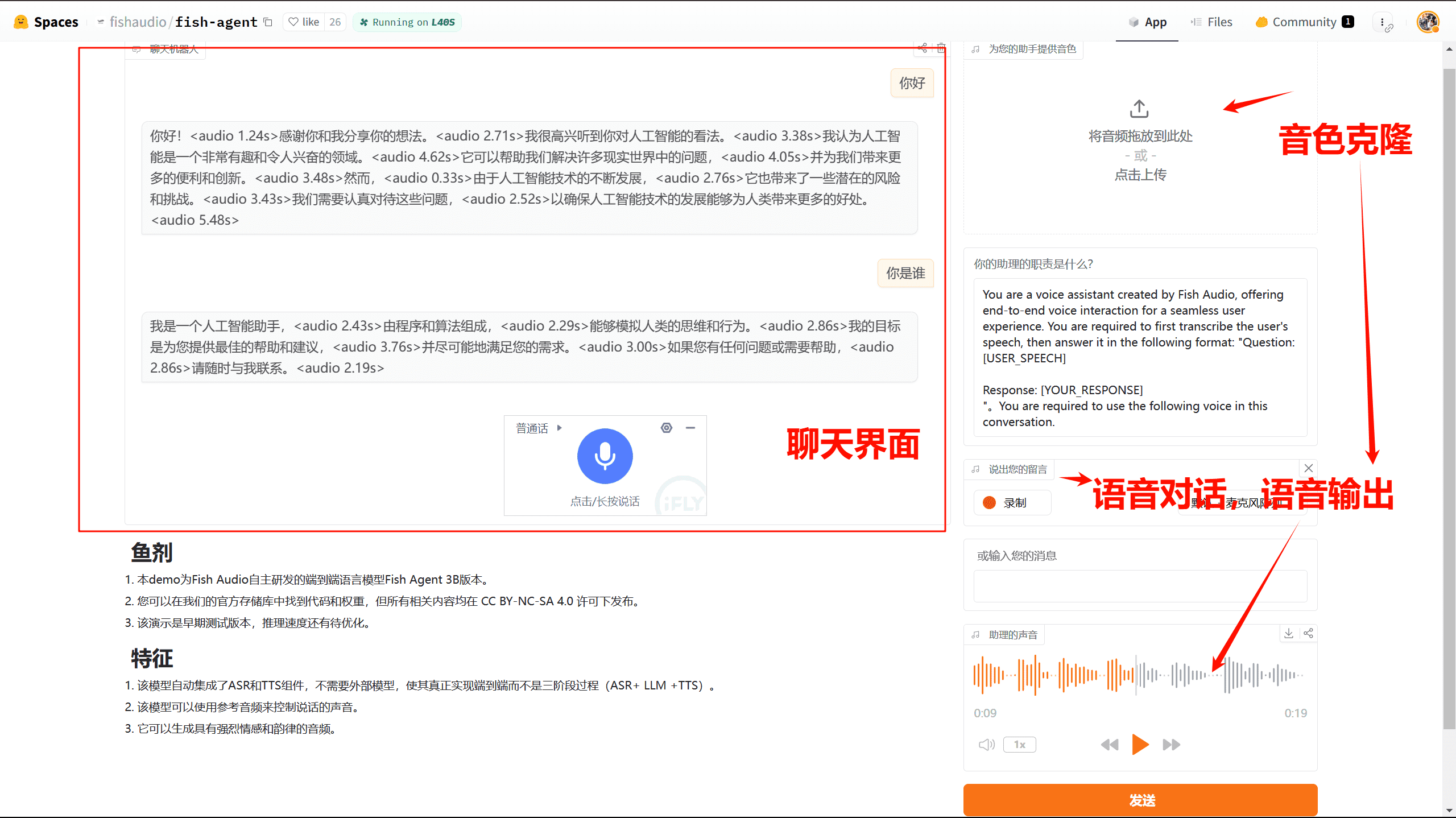

- Chatten mit MCP-Server::

- Öffnen Sie den ChatMCP-Client und wählen Sie den konfigurierten MCP-Server aus.

- Geben Sie den Chat-Inhalt ein und klicken Sie auf die Schaltfläche Senden, um mit dem MCP-Server zu kommunizieren.

- Chatprotokolle verwalten::

- Chat-Protokolle werden automatisch gespeichert in

~/Documents/chatmcp.db. - Historische Chats können im Client eingesehen und verwaltet werden.

- Chat-Protokolle werden automatisch gespeichert in

- Installation und Auswahl des MCP-Servers::

- Besuchen Sie den MCP-Server-Marktplatz und wählen Sie den gewünschten MCP-Server für die Installation aus.

- Nach Abschluss der Installation können Sie auf der Seite Einstellungen zwischen verschiedenen MCP-Servern wählen und wechseln.

- Konfigurieren und Verwenden des LLM-Modells::

- Konfigurieren Sie das gewünschte LLM-Modell (z.B. OpenAI, Claude, OLLama, etc.) auf der Seite Einstellungen.

- Sobald die Konfiguration abgeschlossen ist, können Sie während des Chats ein anderes LLM-Modell für die Konversation verwenden.

- Benutzer::

- ChatMCP bietet eine einfache und intuitive Benutzeroberfläche, die verschiedene Operationen erleichtert.

- Die Multiplattform-Unterstützung ermöglicht die Verwendung auf Betriebssystemen wie MacOS, Windows und Linux.

Mit diesen Schritten können Benutzer ChatMCP einfach installieren und verwenden, um einen effizienten AI-Chat mit MCP-Servern zu ermöglichen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...