BrowserAI: Lokale Ausführung von KI-Modellen im Browser mit WebGPUs

Allgemeine Einführung

BrowserAI ist ein Open-Source-Tool, mit dem Benutzer native KI-Modelle direkt im Browser ausführen können. Es wurde vom Cloud-Code-AI-Team entwickelt und unterstützt Sprachmodelle wie Llama, DeepSeek und Kokoro. Benutzer können Aufgaben wie Texterstellung, Spracherkennung und Text-to-Speech über den Browser ausführen, ohne dass ein Server oder eine komplexe Einrichtung erforderlich ist. BrowserAI ist einfach und leicht zu bedienen, so dass Entwickler damit KI-Apps erstellen können und auch normale Nutzer die KI-Funktionen nutzen können. Das Projekt ist kostenlos und offen auf GitHub, so dass jeder den Code herunterladen und verwenden oder verbessern kann.

BrowserAI Text-Dialog

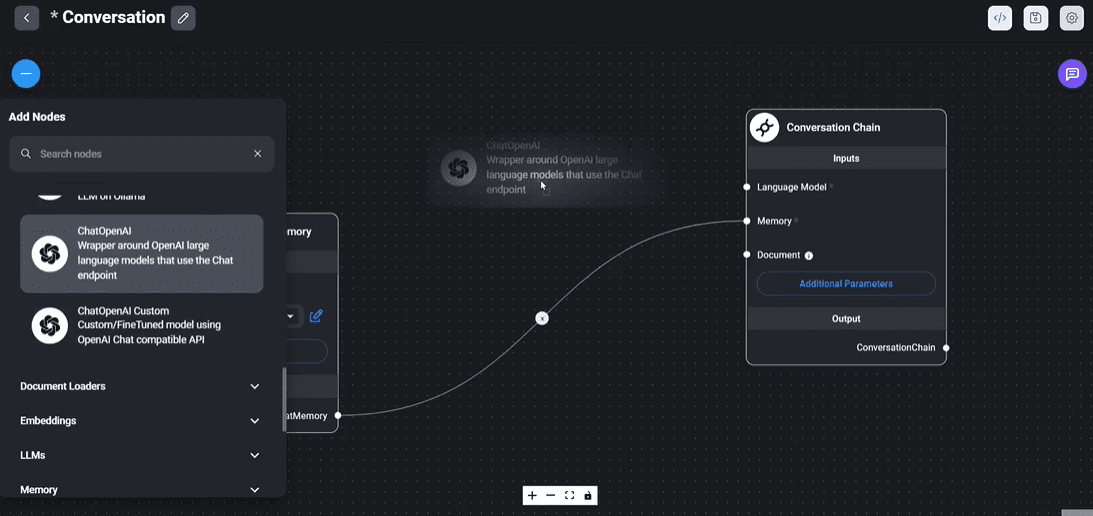

BrowserAI Sprachdialog

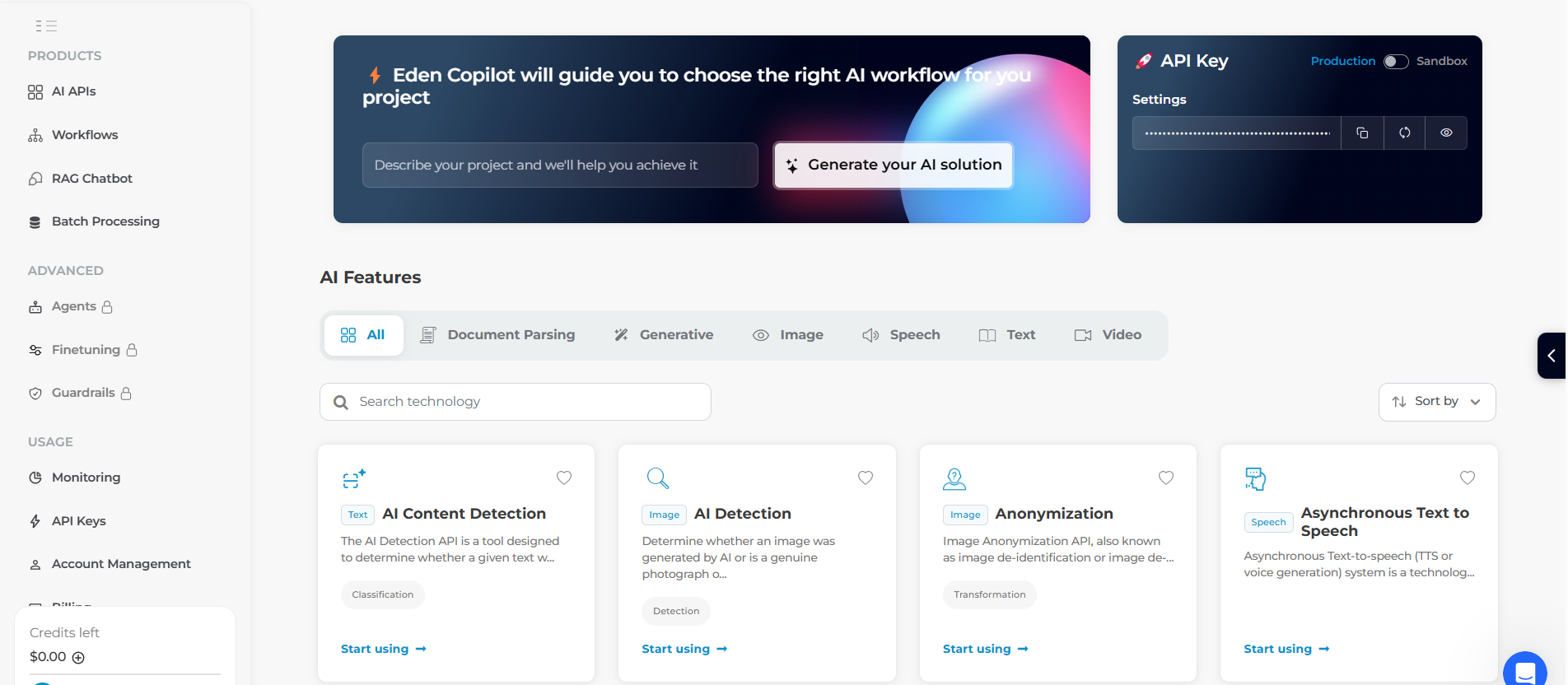

BrowserAI Text-to-Speech

Funktionsliste

- Führen Sie lokale KI-Modelle in Ihrem Browser ohne Serverunterstützung aus.

- Die Texterstellung wird unterstützt, so dass Benutzer Text eingeben können und eine Antwort in natürlicher Sprache erhalten.

- Bietet Spracherkennung zur Umwandlung von Audio in Text.

- Unterstützt Text-to-Speech und wandelt Text in abspielbaren Ton um.

- Mit WebGPU beschleunigt, läuft es mit nahezu nativer Leistung.

- Nach dem ersten Download ist keine Internetverbindung mehr erforderlich.

- Offener Quellcode, Unterstützung für Entwickler bei der Anpassung von Modellen und Funktionen.

Hilfe verwenden

Einbauverfahren

BrowserAI erfordert keine traditionelle Installation, aber es erfordert die Vorbereitung der Umgebung und des Codes zur Ausführung. Hier sind die genauen Schritte:

- Prüfen Sie Ihren Browser

- Verwenden Sie einen WebGPU-fähigen Browser, z. B. Chrome 113+ oder Edge 113+. Geben Sie in der Adressleiste Ihres Browsers Folgendes ein

chrome://gpuPrüfen Sie, ob WebGPU aktiviert ist. - Vergewissern Sie sich, dass Ihre Computer-Hardware 16-Bit-Gleitkomma unterstützt (einige Modelle erfordern dies), und dass eine normale CPU das Programm ausführen kann, aber eine GPU ist schneller.

- Verwenden Sie einen WebGPU-fähigen Browser, z. B. Chrome 113+ oder Edge 113+. Geben Sie in der Adressleiste Ihres Browsers Folgendes ein

- Code herunterladen

- Besuchen Sie https://github.com/Cloud-Code-AI/BrowserAI.

- Klicken Sie auf die Schaltfläche "Code" und wählen Sie "Download ZIP", um den Code herunterzuladen, oder verwenden Sie den Befehl

git clone https://github.com/Cloud-Code-AI/BrowserAI.git. - Entpacken Sie die Datei oder rufen Sie den Ordner auf.

- Installation von Node.js und Abhängigkeiten

- Installieren Sie zunächst Node.js, laden Sie es von der offiziellen Node.js-Website herunter und installieren Sie es, und geben Sie anschließend Folgendes ein

node -vBestätigen Sie die Version. - Öffnen Sie ein Terminal und wechseln Sie in den Ordner BrowserAI (z.B.

cd BrowserAI). - Einfuhr

npm installInstallieren Sie die Abhängigkeiten. Dieser Vorgang kann einige Minuten dauern.

- Installieren Sie zunächst Node.js, laden Sie es von der offiziellen Node.js-Website herunter und installieren Sie es, und geben Sie anschließend Folgendes ein

- Initiierung von Projekten

- Geben Sie in das Terminal

npm run devstarten Sie den lokalen Server. - Öffnen Sie Ihren Browser und geben Sie

http://localhost:3000(die Portnummer finden Sie in der Terminal-Eingabeaufforderung) und rufen Sie die BrowserAI-Schnittstelle auf.

- Geben Sie in das Terminal

Verwendung der wichtigsten Funktionen

Der Kern von BrowserAI ist die Ausführung von KI-Modellen im Browser, die im Folgenden ausführlich beschrieben wird.

Funktion 1: Textgenerierung

- Verfahren

- Nach dem Start zeigt die Benutzeroberfläche das Modellauswahlfeld an, das standardmäßig die Option

llama-3.2-1b-instructund andere Optionen. - Klicken Sie auf "Modell laden" und warten Sie, bis das Modell geladen ist (einige Sekunden bis einige Minuten, je nach Leistung des Computers).

- Geben Sie einen Text in das Eingabefeld ein, z. B. "Wie ist das Wetter heute?" und klicken Sie auf "Generieren".

- Das System erzeugt Antworten wie "Es ist ein schöner Tag zum Ausgehen". .

- Nach dem Start zeigt die Benutzeroberfläche das Modellauswahlfeld an, das standardmäßig die Option

- Tipps und Tricks

- Kleine Modelle (z.B.

TinyLlama-1.1B) wird schnell geladen und ist für Computer der unteren Leistungsklasse geeignet. - Geben Sie eine spezifische Frage ein, um eine genauere Antwort zu erhalten, z. B. "Schreiben Sie einen technischen Artikel mit 50 Wörtern".

- Kleine Modelle (z.B.

- Anwendungsszenario

- Schreiben Sie erste Entwürfe von Artikeln, entwickeln Sie Dialoge oder testen Sie modellhafte Sprachkenntnisse.

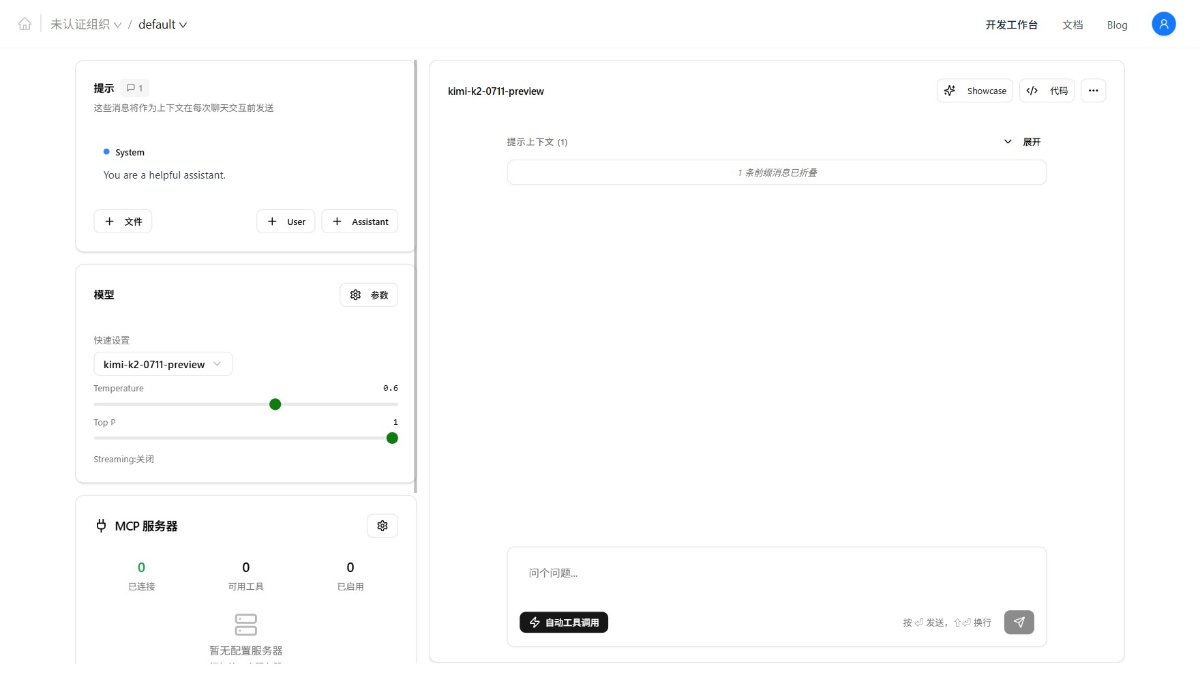

Funktion 2: Spracherkennungsfunktion

- Verfahren

- Wählen Sie ein Modell, das Spracherkennung unterstützt, z. B.

whisper-tiny-en. - Klicken Sie auf "Modell laden", um das Modell zu laden.

- Klicken Sie auf "Aufnahme starten" und sprechen Sie in das Mikrofon, z.B. "Hallo, BrowserAI".

- Klicken Sie auf "Aufnahme stoppen", warten Sie ein paar Sekunden und die Schnittstelle zeigt den transkribierten Text an, z. B. "Hallo, BrowserAI".

- Wählen Sie ein Modell, das Spracherkennung unterstützt, z. B.

- Tipps und Tricks

- Vergewissern Sie sich, dass das Mikrofon ordnungsgemäß funktioniert und wenig Hintergrundgeräusche vorhanden sind, um bessere Ergebnisse zu erzielen.

- Optionale Parameter

return_timestampsZeigen Sie den Zeitstempel eines jeden Absatzes an.

- Anwendungsszenario

- Aufzeichnung von Besprechungen, Transkription von Sprachnotizen oder Entwicklung von Spracheingabeanwendungen.

Funktion 3: Text-to-Speech

- Verfahren

- Option

kokoro-ttsModell, klicken Sie auf "Modell laden". - Geben Sie einen Text ein, z. B. "Willkommen beim BrowserAI-Erlebnis".

- Wählen Sie die Stimme (z. B.

af_bella) und Geschwindigkeit (Standard 1.0), klicken Sie auf "Text in Sprache". - Erzeugen Sie Audio und spielen Sie es automatisch ab oder laden Sie die Datei herunter.

- Option

- Tipps und Tricks

- Die Sätze sind natürlicher, und langsamere Geschwindigkeiten (z. B. 0,8) sind klarer.

- Testen Sie verschiedene Sprachoptionen, um den am besten geeigneten Ton zu finden.

- Anwendungsszenario

- Erstellen Sie Sprachansagen, generieren Sie Podcast-Clips oder synchronisieren Sie Videos.

Funktion 4: Anpassung für Entwickler

- Verfahren

- Laden Sie die gewünschte Modelldatei herunter (z. B. von Hugging Face) und legen Sie sie in das Projektverzeichnis (siehe

README.md). - Compiler

src/index.tsfügen Sie den Modellpfad hinzu. - in Bewegung sein

npm run devladen Sie das neue Modell.

- Laden Sie die gewünschte Modelldatei herunter (z. B. von Hugging Face) und legen Sie sie in das Projektverzeichnis (siehe

- Tipps und Tricks

- Stellen Sie sicher, dass das Modell mit WebGPU und WebAssembly kompatibel ist.

- Wenn Sie den Code nicht kennen, können Sie eine Anfrage auf GitHub stellen.

- Anwendungsszenario

- Testen neuer Modelle, Entwicklung kundenspezifischer KI-Anwendungen.

Der Beispielcode verwendet

Textgenerierung

- Einführung von BrowserAI in das Projekt:

import { BrowserAI } from '@browserai/browserai'; const ai = new BrowserAI(); await ai.loadModel('llama-3.2-1b-instruct'); const response = await ai.generateText('你好,今天天气如何?'); console.log(response);

Sprache-zu-Text

- Aufnahme und Transkription von Audiodaten:

const ai = new BrowserAI(); await ai.loadModel('whisper-tiny-en'); await ai.startRecording(); const audio = await ai.stopRecording(); const text = await ai.transcribeAudio(audio); console.log(text);

caveat

- LeistungenGroße Modelle (z. B.

Llama-3.2-3b) High-End-Computer sind erforderlich, während für Low-End-Computer kleine Modelle empfohlen werden. - Offline-NutzungEs funktioniert auch, wenn Sie die Internetverbindung nach dem ersten Laden trennen, aber Sie müssen das Modell vorher herunterladen.

- Unterstützung der Gemeinschaft: Probleme können hinzugefügt werden Diskord Sondierung (Computer-)Datei.

BrowserAI ist einfach und leistungsstark. Folgen Sie einfach den Schritten, um Ihre Umgebung einzurichten und erleben Sie den Komfort der lokalen KI in Ihrem Browser.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...