BiliNote: Das KI-Tool, das automatisch Markdown-Notizen aus Videos erstellt

Allgemeine Einführung

BiliNote ist ein quelloffenes KI-Tool für Videonotizen, das die Extraktion von Inhalten aus BiliBili- und YouTube-Videolinks unterstützt, um automatisch klar strukturierte Notizen im Markdown-Format zu erstellen. Es verwendet lokale Audiotranskription und eine Vielzahl von großen Modellen (wie OpenAI, DeepSeek, Qwen) für die Zusammenfassung von Inhalten, Unterstützung für das Einfügen von Video-Screenshots und Zeitstempel-Sprunglinks. Das Projekt wird auf GitHub unter der MIT-Lizenz gehostet und ist als Docker-Implementierung und als Windows-Paket für Studenten, Kreative und Forscher verfügbar, um Materialien für Studium oder Arbeit zu organisieren. Das offizielle Online-Erlebnis wird auf Cloudflare Pages bereitgestellt, auf die der Zugriff aufgrund von Netzwerkbedingungen langsam sein kann.

Funktionsliste

- Extrahiert automatisch Inhalte aus Beep- und YouTube-Videolinks, um Markdown-Notizen zu erstellen.

- Native Audiotranskription unter Verwendung des Fast-Whisper-Modells mit Unterstützung der Privatsphäre.

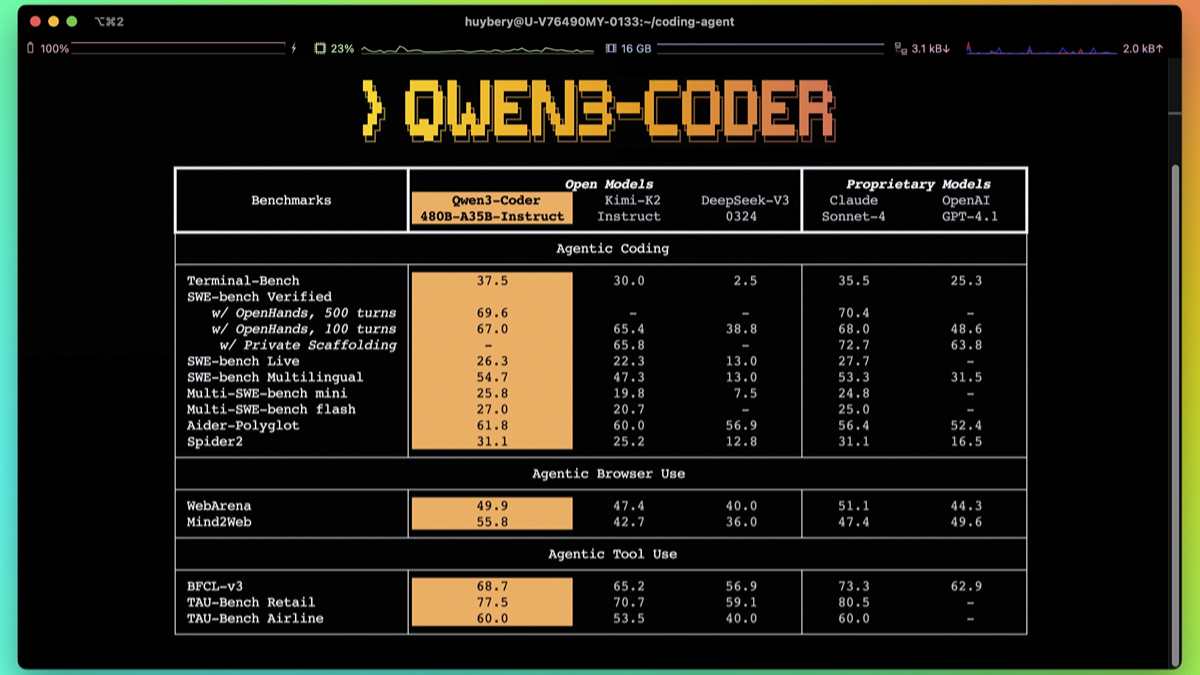

- Unterstützung von OpenAI, DeepSeek, Qwen und anderen großen Modellen, um den Kerninhalt des Videos zusammenzufassen.

- Optionales Einfügen von Video-Keyframe-Screenshots zur besseren Visualisierung von Notizen.

- Generieren Sie zeitgestempelte Notizen mit Unterstützung für den Sprung zum entsprechenden Zeitpunkt des Originalvideos.

- Mit der Aufgabenprotokollierungsfunktion können Sie die Historie der Notizen einsehen, um Aufzeichnungen zu erstellen.

- Unterstützt die Ein-Klick-Bereitstellung von Docker, um lokale oder Cloud-Installationen zu vereinfachen.

- Für Windows ist eine gepackte Version (exe-Datei) verfügbar, die keine komplexe Konfiguration erfordert.

- Es ist geplant, weitere Videoplattformen wie Jitterbug und Shutterbug zu unterstützen.

Hilfe verwenden

Installation und Einsatz

BiliNote bietet drei Möglichkeiten der Nutzung: manuelle Bereitstellung, Docker-Bereitstellung und Windows-Paketversion. Hier sind die detaillierten Schritte:

Manuelle Bereitstellung

- Projektcode klonen

Führen Sie den folgenden Befehl aus, um den Quellcode zu erhalten:git clone https://github.com/JefferyHcool/BiliNote.git cd BiliNote mv .env.example .env - FFmpeg installieren

BiliNote basiert auf FFmpeg für die Audioverarbeitung und muss installiert sein:- Mac: Lauf

brew install ffmpeg - Ubuntu/Debian: Lauf

sudo apt install ffmpeg - Windows (Computer)Downloaden und installieren Sie FFmpeg von der offiziellen FFmpeg-Website und stellen Sie sicher, dass der Pfad zur ausführbaren FFmpeg-Datei zur Systemumgebungsvariablen PATH hinzugefügt wird.

- Mac: Lauf

- Konfigurieren des Backends

Wechseln Sie in das Backend-Verzeichnis, installieren Sie die Abhängigkeiten und starten Sie den Dienst:cd backend pip install -r requirements.txt python main.pyCompiler

.envDatei, um zum Beispiel den API-Schlüssel und den Port zu konfigurieren:API_BASE_URL=http://localhost:8000 OUT_DIR=note_results IMAGE_BASE_URL=/static/screenshots MODEL_PROVIDER=openai OPENAI_API_KEY=sk-xxxxxx DEEP_SEEK_API_KEY=xxx QWEN_API_KEY=xxx - Konfigurieren des Frontends

Wechseln Sie in das Front-End-Verzeichnis, installieren Sie die Abhängigkeiten und starten Sie den Dienst:cd BiliNote_frontend pnpm install pnpm devInterviews

http://localhost:5173Zeigen Sie die Front-End-Schnittstelle an. - Optimierte Audiotranskription (optional)

Wenn Sie einen NVIDIA-Grafikprozessor verwenden, können Sie die CUDA-beschleunigte Version von Fast-Whisper aktivieren, siehe die Fast-Whisper-Projekt Konfiguration.

Docker-Bereitstellung

- Sicherstellen, dass Docker und Docker Compose installiert sind

Informationen zur Installation finden Sie auf der Docker-Website. - Klonen und konfigurieren Sie das Projekt

git clone https://github.com/JefferyHcool/BiliNote.git cd BiliNote mv .env.example .env - Neue Dienste

Führen Sie den folgenden Befehl aus, um den Container zu erstellen und zu starten:docker compose up --buildDer Standardanschluss ist das Frontend

http://localhost:${FRONTEND_PORT}und Back-Endhttp://localhost:${BACKEND_PORT}Im Folgenden finden Sie ein Beispiel für die Art von Daten, die in der Datei.envin der Datei angepasst werden.

Windows-Verpackung

- Exe-Datei herunterladen

Besuchen Sie die GitHub Release-Seite, um das Windows-Paket (exe-Datei) herunterzuladen. - laufendes Programm

Zum Starten doppelklicken Sie auf die Exe-Datei. Sie müssen FFmpeg nicht installieren oder Umgebungsvariablen manuell konfigurieren. Wenn Sie das Programm zum ersten Mal ausführen, müssen Sie den API-Schlüssel eingeben. - API-Schlüssel konfigurieren

Geben Sie den API-Schlüssel für OpenAI, DeepSeek oder Qwen in der Programmoberfläche ein, speichern Sie ihn und verwenden Sie ihn.

Verwendungsschritte

- BiliNote besuchen

- Lokale Bereitstellung: Öffnen Sie einen Browser und besuchen Sie

http://localhost:5173. - Online-Erfahrung: Besuchen Sie

https://www.bilinote.app(möglicherweise aufgrund des langsamen Ladens von Cloudflare Pages). - Windows-Paketversion: Doppelklicken Sie auf die Exe-Datei, um das Programm zu starten.

- Lokale Bereitstellung: Öffnen Sie einen Browser und besuchen Sie

- Video-Link eingeben

Geben Sie einen Link zu einem öffentlich zugänglichen Bleep- oder YouTube-Video in die Schnittstelle ein, z. B.https://www.bilibili.com/video/xxxKlicken Sie auf "Absenden", um den Vorgang zu starten. Klicken Sie auf "Absenden", um mit der Bearbeitung zu beginnen. - Optionen für die Konfigurationserstellung

- AI-ModellOpenAI, DeepSeek oder Qwen für die Zusammenfassung von Inhalten wählen.

- Screenshot einfügenAnkreuzen, ob Video-Screenshots automatisch eingefügt werden sollen.

- Link überspringenWählen Sie, ob ein Sprunglink mit einem Zeitstempel erstellt werden soll oder nicht.

- AufnahmestilWählen Sie zwischen Academic Style, Spoken Style oder Focused Extraction Mode (einige Stile werden erst in zukünftigen Updates unterstützt).

- Notizen generieren

Nachdem Sie auf "Generieren" geklickt haben, lädt BiliNote das Video-Audio herunter, transkribiert es mit Fast-Whisper in Text und erstellt Markdown-Notizen unter Verwendung des ausgewählten Makromodells. Die Generierungszeit hängt von der Videolänge und der Hardwareleistung ab. - Anzeigen und Exportieren von Notizen

- Die Notizen werden im Markdown-Format mit Überschriften, Absätzen, Zeitstempeln und Screenshots (falls aktiviert) angezeigt.

- Klicken Sie auf den Zeitstempel, um zum entsprechenden Zeitpunkt des Originalvideos zu springen.

- Unterstützung für den Export in Markdown-Dateien, mit zukünftigen Plänen zur Unterstützung von PDF, Word und Begriff Format.

- Historische Notizen können auf dem Bildschirm Aufgabenhistorie eingesehen werden, wobei die Anzeige und Bearbeitung unterstützt wird.

Featured Function Bedienung

- Native Audio-TranskriptionFast-Whisper-Modelle werden lokal ausgeführt, um den Datenschutz zu gewährleisten. Unterstützt CUDA-Beschleunigung für schnellere Transkription.

- Unterstützung mehrerer ModelleUmschalten zwischen OpenAI, DeepSeek oder Qwen für verschiedene Sprachen und Szenarien (z. B. ist Qwen besser für chinesische Videos geeignet).

- Screenshot einfügenAutomatisches Abfangen von Video-Keyframes und Einfügen an den entsprechenden Stellen der Notizen, um die Lesbarkeit zu verbessern.

- Geschichte der MissionJede erstellte Aufgabe wird automatisch für eine spätere Überprüfung oder Änderung gespeichert.

- Windows-VerpackungBieten Sie nicht-technischen Anwendern eine sofort einsatzbereite Lösung und vereinfachen Sie den Installationsprozess.

caveat

- Videolinks müssen öffentlich zugänglich sein, private Videos dürfen nicht verarbeitet werden.

- Die Inhaltszusammenfassungsfunktion muss mit einem gültigen API-Schlüssel (OpenAI, DeepSeek oder Qwen) konfiguriert werden.

- FFmpeg muss korrekt installiert sein (außer für Windows-Pakete).

- Das Online-Erlebnis kann aufgrund der Beschränkungen von Cloudflare Pages langsam geladen werden. Wir empfehlen daher, lokal zu installieren oder die Windows-Paketversion zu verwenden.

- Stellen Sie die Netzwerkstabilität sicher, um Ausfälle beim Herunterladen von Audiodaten oder bei API-Aufrufen zu vermeiden.

Anwendungsszenario

- Schüler organisieren ihre Notizen für den Online-Unterricht

Die Schüler können Markdown-Notizen von Beep- oder YouTube-Videos anfertigen und die wichtigsten Punkte und Zeitstempel extrahieren, um die Wiederholung und Orientierung zu erleichtern. - Ersteller von Inhalten stellen Material zusammen

Ersteller können Videoskripte oder Schlüsselinformationen extrahieren, um Notizen mit Screenshots für die Inhaltserstellung oder das Verfassen von Texten zu erstellen. - Archivierung von Unternehmensschulungsinhalten

Unternehmen können Schulungsvideos in strukturierte Notizen umwandeln, die von den Mitarbeitern überprüft oder archiviert werden können, und so die Lerneffizienz verbessern. - Forscher stellen akademische Vorträge zusammen

Forscher können akademische Konferenzvideos in Notizen umwandeln, Kernideen und Daten extrahieren und eine Wissensdatenbank aufbauen. - Persönliches Wissensmanagement

Nutzer können Videos von Interesse (z. B. Tutorials, Podcasts) in Notizen umwandeln und sie in ihrer persönlichen Wissensdatenbank speichern, um jederzeit darauf zugreifen zu können.

QA

- Welche Videoplattformen werden von BiliNote unterstützt?

Derzeit werden Beili und YouTube unterstützt, in Zukunft sollen auch Jieyin und Qunjie unterstützt werden. - Was ist der Unterschied zwischen einer paketierten Version von Windows und einer lokalen Bereitstellung?

Die Windows-Paketversion macht die manuelle Installation von FFmpeg oder die Konfiguration der Umgebung für technisch nicht versierte Benutzer überflüssig. Die lokale Bereitstellung ist flexibler und bietet Unterstützung für benutzerdefinierte Konfigurationen und GPU-Beschleunigung. - Wie kann ich die Geschwindigkeit der Audiotranskription erhöhen?

Eine CUDA-beschleunigte Version, die ein NVIDIA-GPU-Gerät mit aktiviertem Fast-Whisper verwendet, finden Sie im Fast-Whisper-Projekt. - Muss ich einen kostenpflichtigen API-Schlüssel verwenden?

Für die Inhaltszusammenfassung ist ein API-Schlüssel für OpenAI, DeepSeek oder Qwen erforderlich (es können Kosten anfallen). Die Audiotranskription kann lokal und kostenlos ausgeführt werden. - Warum lädt die Online-Erlebnisversion so langsam?

Die Online-Version wird auf Cloudflare Pages bereitgestellt und unterliegt Netzwerk- und Serverbeschränkungen. Wir empfehlen eine lokale Bereitstellung oder Windows-Paketversionen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...