Archon: ein Entwicklungsrahmen für den autonomen Aufbau und die Optimierung von KI-Intelligenzen

Allgemeine Einführung

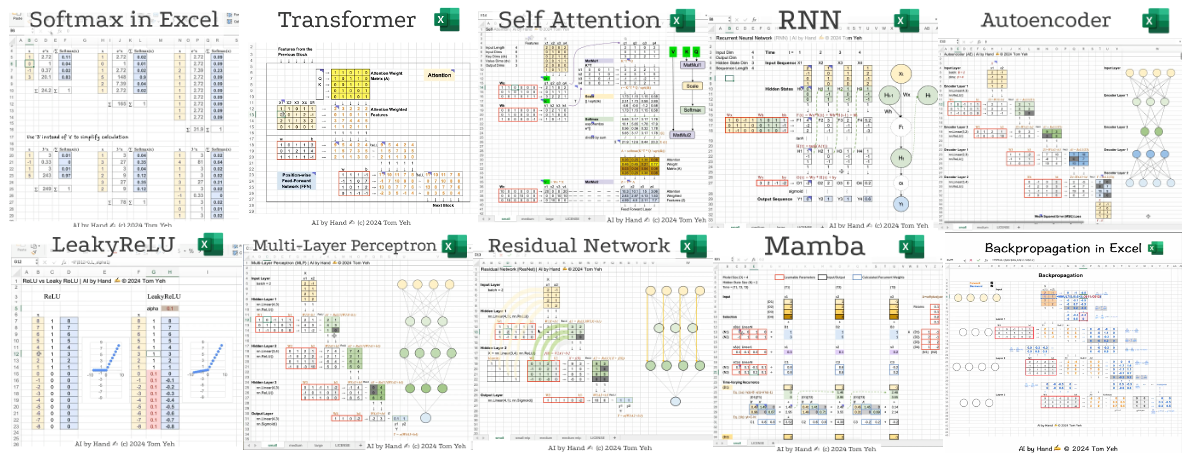

Archon ist das weltweit erste "Agenteer"-Projekt des Entwicklers Cole Medin (GitHub-Benutzername coleam00) - ein Open-Source-Framework, das sich auf die autonome Erstellung, Optimierung und Iteration von KI-Intelligenzen konzentriert. Es ist ein Open-Source-Framework, das sich auf den autonomen Aufbau und die Iteration von KI-Intelligenzen konzentriert. Es ist sowohl ein praktisches Werkzeug für Entwickler als auch eine Bildungsplattform, um die Entwicklung intelligenter Körpersysteme zu demonstrieren.Archon, derzeit in der Version V4, verwendet eine vollständig optimierte Streamlit-Oberfläche, um eine intuitive Verwaltungsschnittstelle zu bieten. Das in Python entwickelte Projekt integriert Technologien wie Pydantic AI, LangGraph und Supabase, um sich von der einfachen Generierung von Intelligenz bis hin zu komplexer Workflow-Kollaboration zu entwickeln. Archon demonstriert die drei Prinzipien moderner KI-Entwicklung: intelligentes Denken, Wissenseinbettung und erweiterbare Architektur durch Planung, Feedback-Schleifen und Integration von Domänenwissen.

Archon ist, wie ich es gerne nenne, ein "Parasit" auf anderen Frameworks für die Entwicklung von Intelligenz. Archon kann andere Frameworks für die Entwicklung von Intelligenz aufbauen und optimieren, aber er ist auch selbst eine Intelligenz.

Funktionsliste

- Automatische Generierung von IntelligenzenGenerierung von kundenspezifischen KI-Intelligenz-Bodycodes auf der Grundlage von Benutzereingaben.

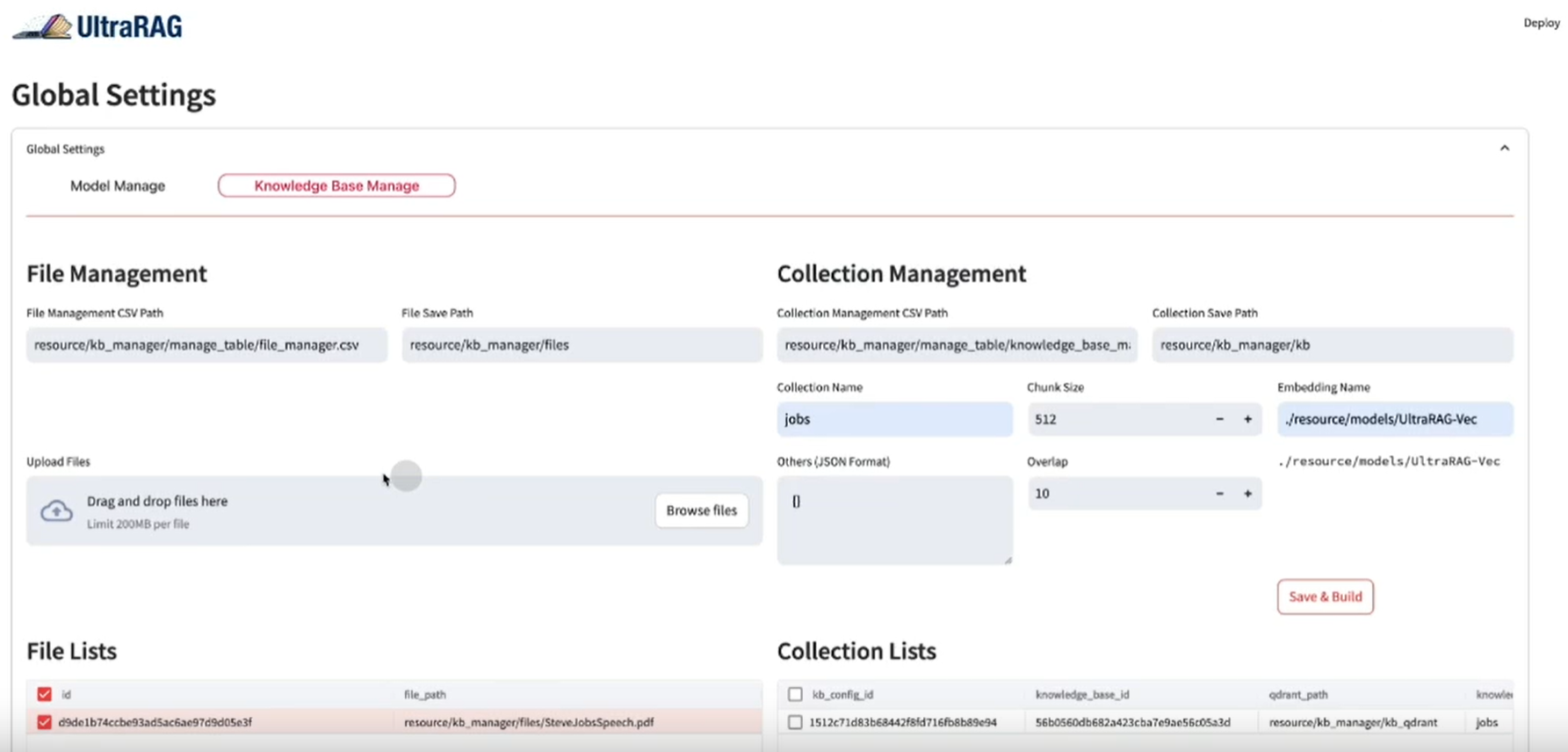

- Crawling und Indizierung von DokumentenCrawling von Dokumenten wie Pydantic AI, Erzeugung von Vektoreinbettungen und Speicherung in Supabase.

- RAG-SystemunterstützungNutzung von suchgestützten Generierungstechniken, um genaue Code-Vorschläge und Optimierungen zu liefern.

- Streamlit UI ManagementKonfiguration von Umgebungsvariablen, Datenbanken und intelligenten Körperdiensten über eine visuelle Schnittstelle.

- Multi-Intelligenz-Zusammenarbeit: Basierend auf LangGraph Ermöglichung koordinierter Arbeitsabläufe für Argumentation, Codierung und Aufgabenverteilung.

- Lokal und Cloud-kompatibelUnterstützung für OpenAI, Anthropic, OpenRouter APIs oder nativ Ollama Modelle.

- Docker-Container-Bereitstellung: Bietet den Hauptcontainer und MCP Container, um sicherzustellen, dass Produktionsumgebungen sofort einsatzbereit sind.

- MCP-IntegrationUnterstützung für die Integration mit AI-IDEs (z.B. Windsurf, Cursor) zur Verwaltung von Dateien und Abhängigkeiten.

- Unterstützung der GemeinschaftBereitstellung einer Plattform für die Kommunikation mit den Nutzern durch das oTTomator Think Tank Forum.

Hilfe verwenden

Archon ist ein funktionsreiches Open-Source-Framework, das Benutzern helfen soll, schnell KI-Intelligenzen zu entwickeln und zu verwalten. Hier finden Sie eine detaillierte Installations- und Nutzungsanleitung, damit Sie problemlos loslegen können.

Einbauverfahren

Archon V4 unterstützt zwei Installationsmethoden: Docker (empfohlen) und lokale Python-Installation. Hier sind die Schritte:

Weg 1: Docker-Installation (empfohlen)

- Vorbereiten der Umgebung

- Stellen Sie sicher, dass Docker und Git installiert sind.

- Besorgen Sie sich ein Supabase-Konto (für Vektordatenbanken).

- Bereiten Sie den OpenAI/Anthropic/OpenRouter API-Schlüssel vor, oder führen Sie Ollama lokal aus.

- Klon-Lager

Läuft im Terminal:git clone https://github.com/coleam00/archon.git cd archon

- Ausführen eines Docker-Skripts

Führen Sie den folgenden Befehl aus, um den Container zu erstellen und zu starten:python run_docker.py- Das Skript erstellt automatisch zwei Container: den Archon-Hauptcontainer (auf dem die Streamlit-Benutzeroberfläche und die Graph-Dienste laufen) und den MCP-Container (der die KI-IDE-Integration unterstützt).

- falls vorhanden

.envDatei, werden die Umgebungsvariablen automatisch geladen.

- Zugangsschnittstelle

Öffnen Sie Ihren Browser und besuchen Siehttp://localhost:8501Rufen Sie dazu die Streamlit-Benutzeroberfläche auf.

Weg 2: Lokale Python-Installation

- Vorbereiten der Umgebung

- Stellen Sie sicher, dass Python 3.11+ installiert ist.

- Rufen Sie das Supabase-Konto und den API-Schlüssel ab.

- Klon-Lager

git clone https://github.com/coleam00/archon.git cd archon - Erstellen einer virtuellen Umgebung und Installieren von Abhängigkeiten

python -m venv venv source venv/bin/activate # Windows: venv\Scripts\activate pip install -r requirements.txt - Streamlit UI starten

streamlit run streamlit_ui.py - Zugangsschnittstelle

Öffnen Sie Ihren Browser und besuchen Siehttp://localhost:8501.

Konfiguration der Umgebungsvariablen

Wenn Sie Docker oder eine lokale Installation zum ersten Mal ausführen, müssen Sie Umgebungsvariablen konfigurieren. Erstellen Sie eine .env Datei mit Beispielinhalten:

OPENAI_API_KEY=your_openai_api_key

SUPABASE_URL=your_supabase_url

SUPABASE_SERVICE_KEY=your_supabase_service_key

PRIMARY_MODEL=gpt-4o-mini

REASONER_MODEL=o3-mini

Diese Informationen sind auf dem Supabase Dashboard und beim API-Anbieter verfügbar.

Funktion Betriebsablauf

Nach der Installation bietet Streamlit UI fünf Hauptfunktionsmodule, die Sie Schritt für Schritt durch die Einrichtung und Nutzung führen.

1. die Umwelt

- Verfahren::

- Gehen Sie auf die Registerkarte "Umgebung".

- Geben Sie den API-Schlüssel (z.B. OpenAI oder OpenRouter) und die Modelleinstellungen (z.B.

gpt-4o-mini). - Klicken Sie auf "Speichern" und die Konfiguration wird in der Datei

env_vars.json.

- zur Kenntnis nehmenWenn Sie Ollama lokal verwenden, müssen Sie sicherstellen, dass der Dienst auf dem

localhost:11434UI-Streaming wird nur von OpenAI unterstützt.

2. datenbankeinstellungen (Datenbank)

- Verfahren::

- Gehen Sie auf die Registerkarte "Datenbank".

- Geben Sie die Supabase-URL und den Dienstschlüssel ein.

- Klicken Sie auf "Datenbank initialisieren", das System wird die Datenbank automatisch erstellen.

site_pagesTabelle. - Überprüfen Sie den Verbindungsstatus, um den Erfolg zu bestätigen.

- Tabellenstruktur::

CREATE TABLE site_pages ( id UUID PRIMARY KEY DEFAULT uuid_generate_v4(), url TEXT, chunk_number INTEGER, title TEXT, summary TEXT, content TEXT, metadata JSONB, embedding VECTOR(1536) );

3. das Crawlen und Indizieren der Dokumentation (Dokumentation)

- Verfahren::

- Gehen Sie auf die Registerkarte "Dokumentation".

- Geben Sie die URL des Zieldokuments ein (z. B. das Pydantic AI-Dokument).

- Klicken Sie auf "Start Crawling" und das System chunked die Dokumente, erzeugt Einbettungen und speichert sie in der Supabase.

- Sie können den Fortschritt der Indizierung in der Benutzeroberfläche sehen, wenn Sie fertig sind.

- verwenden.für RAG Das System stellt die Wissensbasis zur Verfügung.

4) Dienst für intelligente Stellen (Agentendienst)

- Verfahren::

- Gehen Sie auf die Registerkarte "Agentendienst".

- Klicken Sie auf Dienst starten, um den LangGraph-Workflow zu starten.

- Überwachen Sie den Dienststatus anhand von Protokollen.

- FunktionalitätKoordinierung von Argumentation, Kodierung und Aufgabenverteilung, um sicherzustellen, dass die Kernlogik der Generierung von Intelligenz richtig funktioniert.

5. die Schaffung eines intelligenten Körpers (Chat)

- Verfahren::

- Gehen Sie auf die Registerkarte "Chat".

- Geben Sie eine Anforderung ein, z. B. "Generieren Sie eine Intelligenz, die JSON-Dateien analysiert".

- Das System kombiniert das vom RAG-System abgerufene Wissen, um Codes zu generieren und sie anzuzeigen.

- Kopieren Sie den Code, um ihn lokal auszuführen, oder stellen Sie ihn über einen Dienst bereit.

- typisches Beispiel::

Eingabe: "Erstellen Sie einen intelligenten Körper, der das Wetter in Echtzeit abfragt".

Beispielhafte Ausgabe:from pydantic_ai import Agent, OpenAIModel agent = Agent(OpenAIModel("gpt-4o-mini"), system_prompt="查询实时天气") result = agent.run("获取北京今天的天气") print(result.data)

Optional: MCP-Konfiguration

- Verfahren::

- Gehen Sie auf die Registerkarte "MCP".

- Konfigurieren Sie die Integration mit einer KI-IDE wie z. B. Cursor.

- Starten Sie den MCP-Container und verbinden Sie sich mit dem Graph-Dienst.

- verwenden.Unterstützung für automatische Dateierstellung und Abhängigkeitsmanagement in der IDE für Smartbody-Code.

Anwendungsbeispiel

Angenommen, Sie wollen eine "Log Analysis Intelligence" entwickeln:

- Geben Sie in Chat ein: "Generate a Pydantic AI intelligence that parses Nginx logs".

- Archon ruft die relevante Dokumentation ab und generiert Code:

from pydantic_ai import Agent, OpenAIModel

agent = Agent(OpenAIModel("gpt-4o-mini"), system_prompt="解析Nginx日志")

result = agent.run("分析access.log并提取IP地址")

print(result.data)

- Speichern Sie den Code lokal und stellen Sie sicher, dass Sie den API-Schlüssel vor der Ausführung konfigurieren.

caveat

- Kompatibilität der ModelleNur OpenAI unterstützt Streaming-Ausgaben von der Streamlit UI, andere Modelle (z.B. Ollama) unterstützen nur Non-Streaming.

- NetzanforderungCrawlen von Dokumenten und Aufrufen von APIs erfordert ein stabiles Netz.

- Komponenten während der Prüfung anpassenWenn etwas schief läuft, überprüfen Sie das UI-Protokoll oder die Terminalausgabe.

Mit diesen Schritten können Sie die Fähigkeit von Archon, KI-Intelligenzen schnell zu generieren und zu verwalten, sowohl für das Lernen als auch für die tatsächliche Entwicklung voll ausnutzen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...