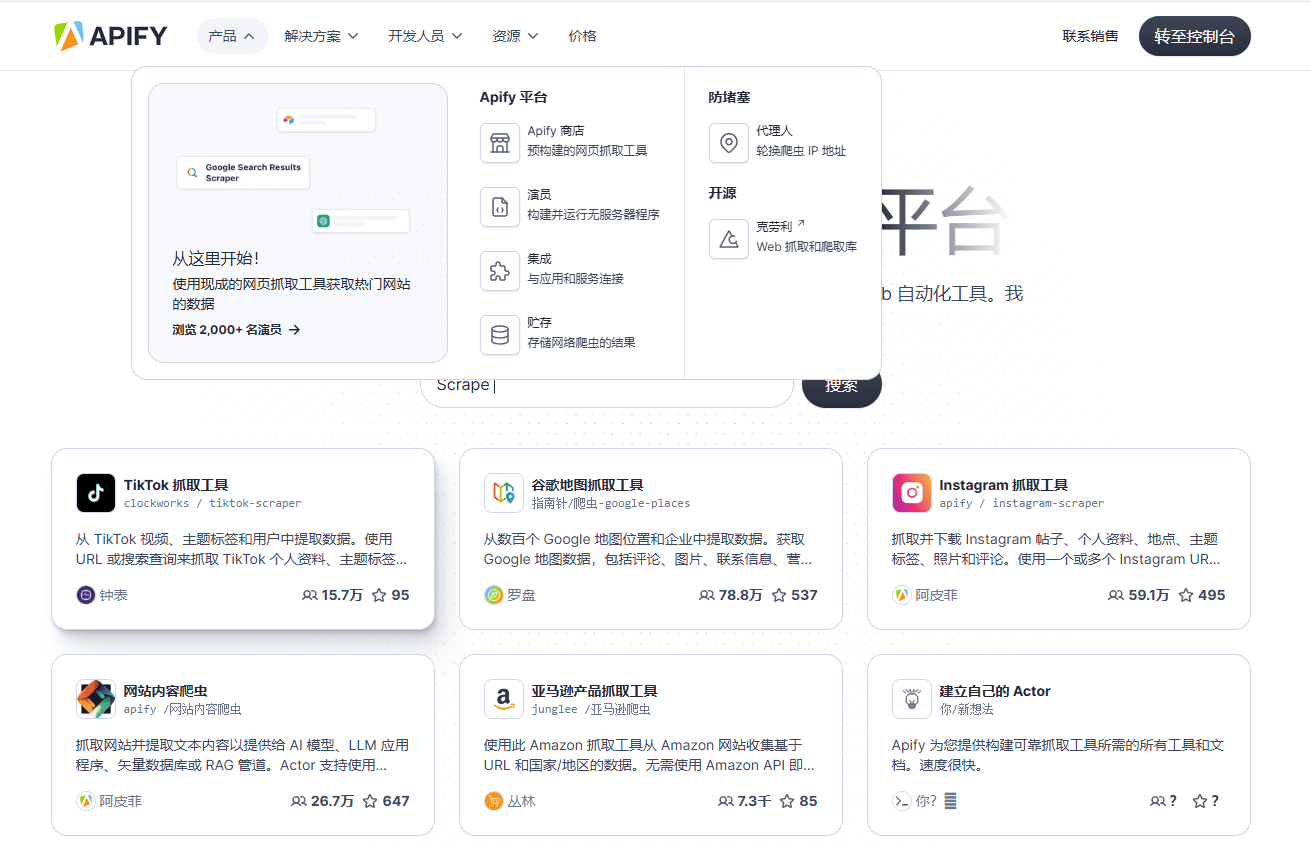

Apify: umfassende Web-Crawling- und Datenextraktionsplattform, automatisierte Datenerfassung, Erstellung benutzerdefinierter Crawler, Integration mehrerer APIs

Allgemeine Einführung

Apify ist eine umfassende Web-Crawling- und Datenextraktionsplattform, die eine Vielzahl von Tools und Diensten bereitstellt, mit denen Benutzer die Datenextraktion aus beliebigen Websites automatisieren können. Apify unterstützt mehrere Programmiersprachen und Frameworks und bietet umfangreiche API- und Integrationsoptionen für eine Vielzahl von Datenerfassungs- und Automatisierungsanforderungen.

Das stärkste Datenerfassungstool, das sich schnell in gängige Workflow-Tools integrieren lässt und schnell eine Wissensdatenbank aufbauen kann.

Funktionsliste

- Web-CrawlerCrawlen einer beliebigen Webseite mit Chrome, mit Unterstützung für rekursives Crawlen und URL-Listen.

- DatenextraktionExtrahiert strukturierte Daten aus Webseiten und unterstützt JSON, XML, CSV und andere Formate.

- Custom CrawlerErstellen und Veröffentlichen von benutzerdefinierten Datenextraktionstools, genannt Actors.

- API-EinbindungIntegration mit einer Vielzahl von Diensten und Tools von Drittanbietern, wie Zapier, Google Sheets, Slack und anderen.

- Professionelle DienstleistungenBietet maßgeschneiderte Web-Crawling-Lösungen, die von einem Team von Fachleuten entworfen und implementiert werden.

- Open-Source-WerkzeugUnterstützung für eine breite Palette von Open-Source-Tools und -Bibliotheken wie Puppeteer, Playwright, Selenium und andere.

- DatenverarbeitungDatenbereinigung, Formatkonvertierung und andere Funktionen zur Unterstützung der Datenverarbeitung in großem Maßstab bereitstellen.

- Überwachung und TerminplanungEchtzeit-Überwachung von Erfassungsaufgaben, Unterstützung für zeitliche Planung und Automatisierung.

Hilfe verwenden

Installation und Nutzung

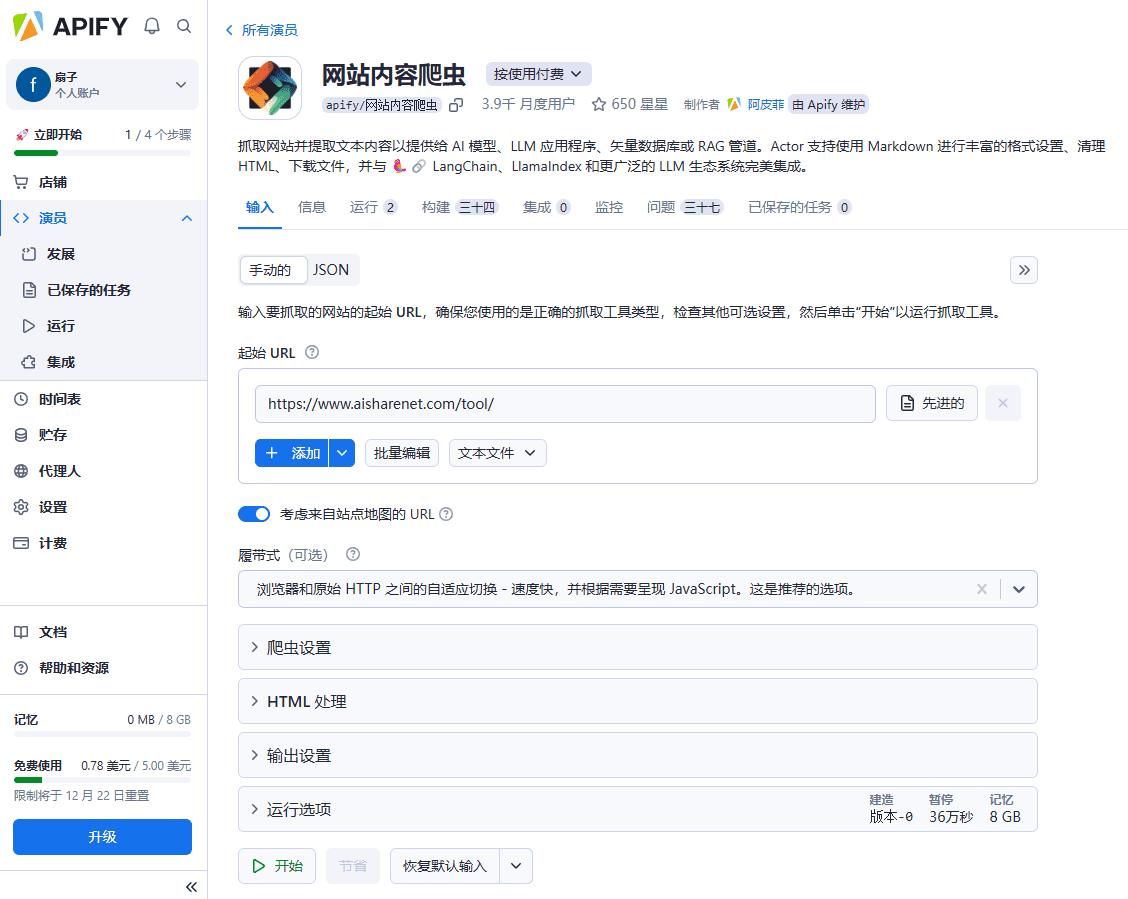

- Registrieren & AnmeldenBesuchen Sie die offizielle Apify-Website, registrieren Sie ein Konto und melden Sie sich an.

- Auswahl-ToolsDurchsuchen Sie den Apify Store nach vorgefertigten Crawling-Tools und wählen Sie das richtige Tool aus.

- Konfigurieren Sie die Erfassungsaufgabe::

- URL eingebenURL: Geben Sie die URL der Webseite, die gecrawlt werden soll, auf der Konfigurationsseite des Tools ein.

- Einrichten von Crawl-RegelnEinrichten von Crawling-Regeln nach Bedarf, z. B. rekursives Crawling, Datenextraktionsfelder usw.

- Laufende AufgabenKlicken Sie auf die Schaltfläche "Ausführen", um die Erfassungsaufgabe zu starten und den Fortschritt und die Ergebnisse in Echtzeit anzuzeigen.

- Daten exportierenNach Abschluss der Erfassung können die Daten in JSON-, XML-, CSV- und andere Formate exportiert, lokal heruntergeladen oder direkt in andere Systeme importiert werden.

- Bau eines benutzerdefinierten Crawlers::

- Einen Akteur erstellenErstellen Sie einen neuen Actor auf der Apify-Plattform, um eine benutzerdefinierte Crawling- und Datenextraktionslogik zu schreiben.

- Prüfung und FehlersucheVerwenden Sie die von Apify bereitgestellten Entwicklungswerkzeuge und Debugging-Funktionen, um die Crawl-Logik zu testen und Fehler zu beheben.

- Veröffentlichen und ausführenVeröffentlichen Sie Actor im Apify Store, richten Sie zeitgesteuerte Aufgaben ein oder führen Sie sie manuell aus.

- API-Einbindung::

- API-Schlüssel abrufenAPI-Schlüssel: Holen Sie sich den API-Schlüssel in Ihren Kontoeinstellungen für den Aufruf der Apify-API.

- Aufrufen der APIIntegrieren Sie die Apify-API in Ihre eigenen Anwendungen, um die Datenextraktion und -verarbeitung mithilfe des Beispielcodes in der API-Dokumentation zu automatisieren.

- Professionelle Dienstleistungen::

- Kontaktieren Sie das Apify-TeamWenn Sie eine maßgeschneiderte Lösung benötigen, können Sie sich mit dem Professional Services Team von Apify in Verbindung setzen, um Ihre Anforderungen zu formulieren.

- Durchführung des ProjektsDas Apify-Team entwirft und implementiert eine maßgeschneiderte Crawling-Lösung auf der Grundlage der Anforderungen, um die Genauigkeit und Effizienz der Datenextraktion zu gewährleisten.

Detaillierte Funktionsabläufe

- Web-Crawler::

- Auswahl eines GrabberwerkzeugsWählen Sie das Tool "Web Scraper" aus dem Apify Store.

- Konfigurieren Sie die ErfassungsaufgabeGeben Sie die URL der zu crawlenden Webseite ein und legen Sie die Regeln für das rekursive Crawling und die Datenextraktion fest.

- Ausführen der ErfassungsaufgabeKlicken Sie auf die Schaltfläche "Ausführen", um den Fortschritt und die Ergebnisse der Erfassung in Echtzeit zu sehen.

- Daten exportierenNach Abschluss der Erfassung exportieren Sie die Daten in das gewünschte Format.

- Datenextraktion::

- Datenextraktionswerkzeug auswählenWählen Sie das entsprechende Datenextraktionstool aus dem Apify Store, z. B. "Google Maps Scraper".

- Konfigurieren von ExtraktionsaufgabenGeben Sie die URL der Webseite ein, aus der Sie Daten extrahieren möchten, und legen Sie die Datenextraktionsfelder und -regeln fest.

- Ausführen der ExtraktionsaufgabeKlicken Sie auf die Schaltfläche "Ausführen", um den Fortschritt und die Ergebnisse der Extraktion in Echtzeit zu sehen.

- Daten exportierenNach Abschluss der Extraktion exportieren Sie die Daten in das gewünschte Format.

- Custom Crawler::

- Einen Akteur erstellenErstellen Sie einen neuen Actor auf der Apify-Plattform, um eine benutzerdefinierte Crawling- und Datenextraktionslogik zu schreiben.

- Prüfung und FehlersucheVerwenden Sie die von Apify bereitgestellten Entwicklungswerkzeuge und Debugging-Funktionen, um die Crawl-Logik zu testen und Fehler zu beheben.

- Veröffentlichen und ausführenVeröffentlichen Sie Actor im Apify Store, richten Sie zeitgesteuerte Aufgaben ein oder führen Sie sie manuell aus.

- API-Einbindung::

- API-Schlüssel abrufenAPI-Schlüssel: Holen Sie sich den API-Schlüssel in Ihren Kontoeinstellungen für den Aufruf der Apify-API.

- Aufrufen der APIIntegrieren Sie die Apify-API in Ihre eigenen Anwendungen, um die Datenextraktion und -verarbeitung mithilfe des Beispielcodes in der API-Dokumentation zu automatisieren.

- Professionelle Dienstleistungen::

- Kontaktieren Sie das Apify-TeamWenn Sie eine maßgeschneiderte Lösung benötigen, können Sie sich mit dem Professional Services Team von Apify in Verbindung setzen, um Ihre Anforderungen zu formulieren.

- Durchführung des ProjektsDas Apify-Team entwirft und implementiert eine maßgeschneiderte Crawling-Lösung auf der Grundlage der Anforderungen, um die Genauigkeit und Effizienz der Datenextraktion zu gewährleisten.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...