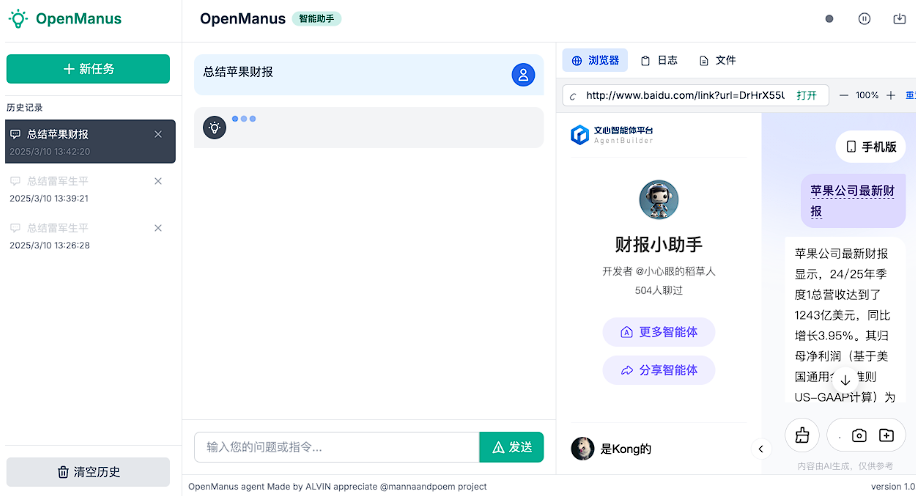

O OpenManus tem sido bastante atualizado ultimamente, além de oferecer suporte a Ollama e provedores de API da Web, e também adicionou suporte a mecanismos de pesquisa domésticos e várias adaptações de WebUI. Neste artigo, apresentaremos algumas WebUIs do OpenManus distribuídas pela comunidade e como configurá-las para mecanismos de pesquisa nacionais.

Introdução à WebUI do OpenManus

Há vários projetos de WebUI na comunidade que são adaptados ao OpenManus, alguns dos quais estão listados abaixo para referência:

Cada um desses itens da WebUI tem suas próprias características, portanto, você pode optar por usá-los de acordo com suas próprias preferências.

O site oficial do OpenManus também foi atualizado (https://openmanus.github.io/). No entanto, clicar do lado direito do repositório do GitHub para o site oficial e, em seguida, clicar no link da documentação leva de volta ao repositório do GitHub, o que é um pouco confuso.

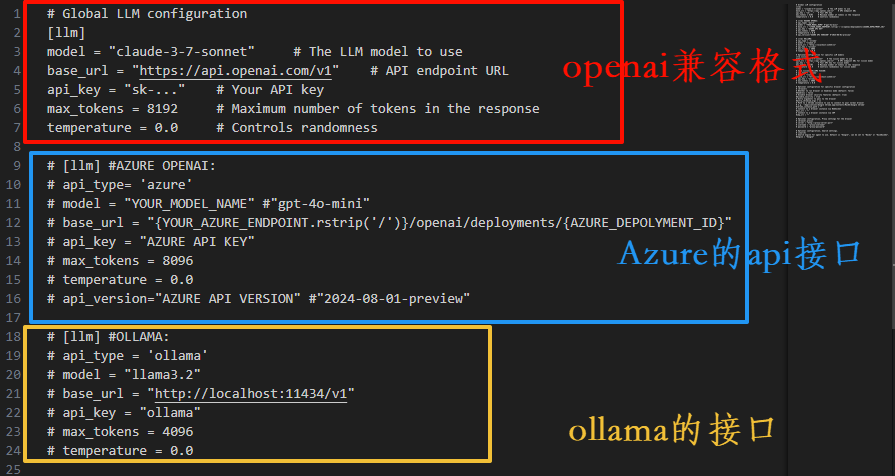

Atualização da interface de configuração

A nova versão da interface de configuração aumentou as anotações, a interface do usuário, o URL, o mecanismo de pesquisa e outros itens de configuração são explicados de forma mais clara e mais amigável para usuários iniciantes.

A configuração do modelo visual é semelhante e não será repetida aqui.

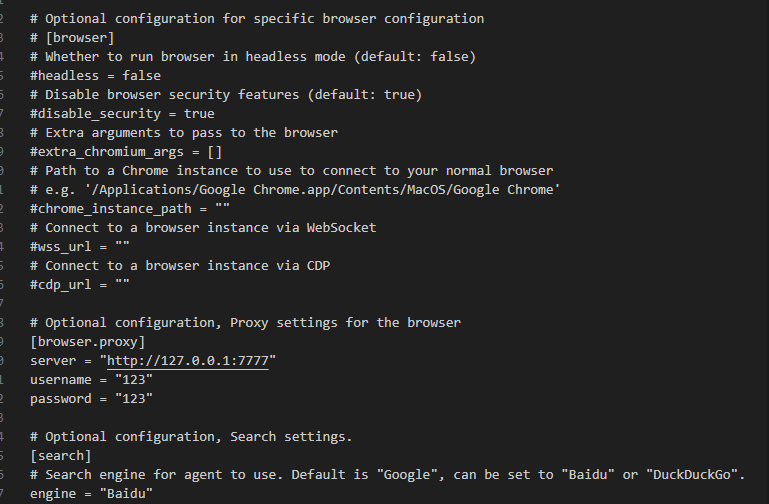

Configuração do mecanismo de pesquisa e do navegador

O OpenManus agora oferece suporte à configuração de mecanismos de pesquisa e navegadores. Os usuários podem escolher de acordo com suas necessidades. Se você não estiver familiarizado com as opções em inglês, poderá usar uma ferramenta de tradução para ajudar na sua compreensão.

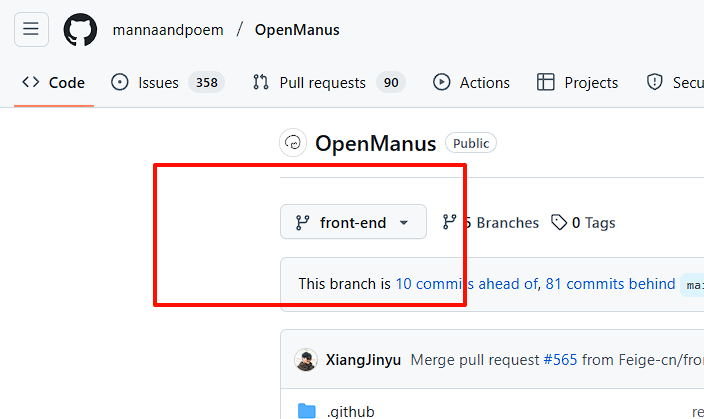

Usando a WebUI

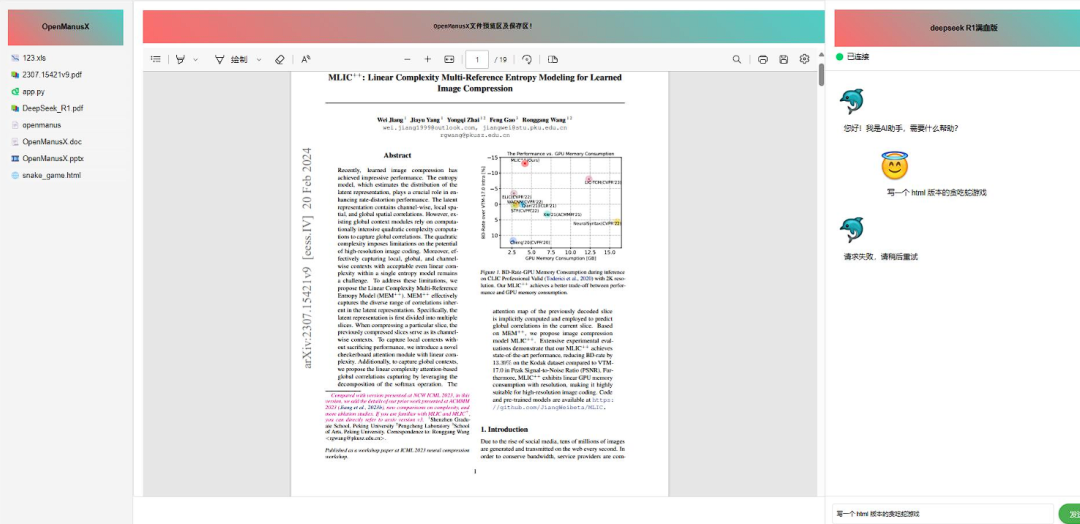

Para usar a WebUI, você precisa selecionar o front-end Ramificação.

Configuração do ambiente

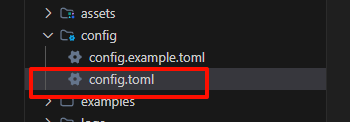

Antes de iniciar, as variáveis de ambiente precisam ser configuradas. Aqui está um exemplo de um Ollama local. Primeiro, faça uma cópia do config Documentação:

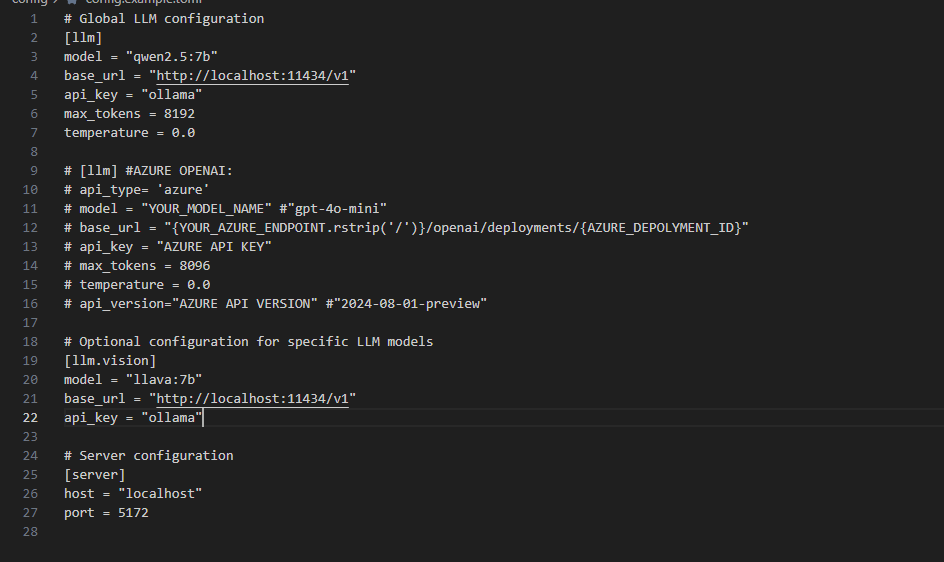

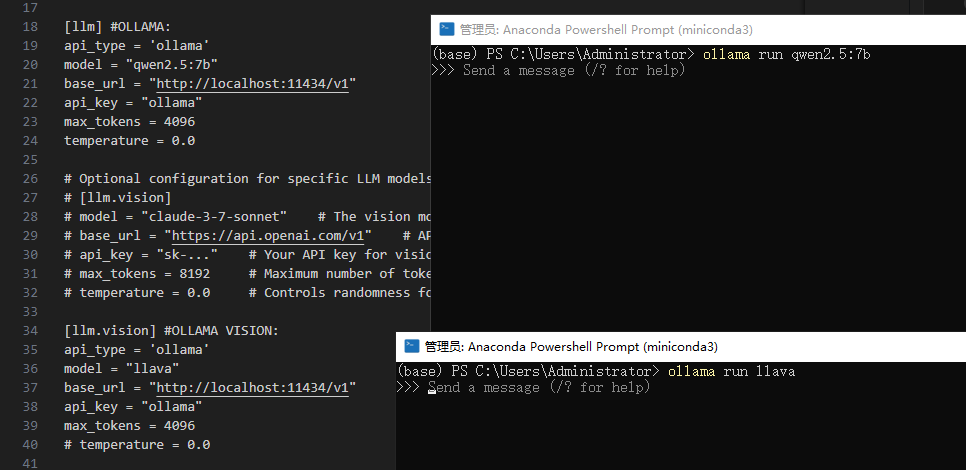

Em seguida, faça alterações no arquivo copiado. Exclua a configuração original da API e configure-a de acordo com a porta Ollama:

Atenção:api_key Não pode ser nulo e pode ser preenchido com um valor arbitrário.

Ao selecionar um modelo, escolha um que ofereça suporte a ferramentas de função; o site da Ollama lista os modelos que oferecem suporte a chamadas de ferramentas.

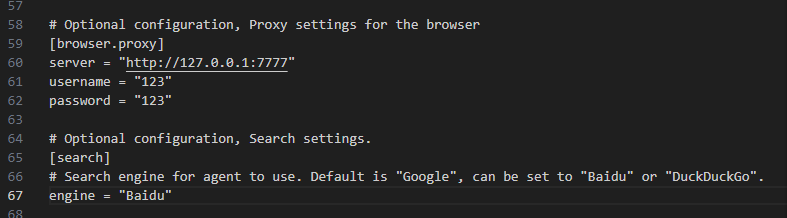

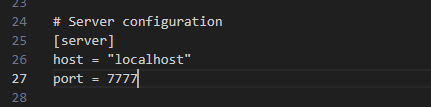

Defina a porta e o mecanismo de pesquisa (o ramo da interface do usuário ainda não está totalmente adaptado aos mecanismos de pesquisa nacionais). Veja o Baidu, por exemplo, preencha Baidu.

Configuração da versão Black Window:

Configuração da versão da interface do usuário:

Salve o arquivo de configuração.

Lançamento do Ollama

Para iniciar o Ollama a partir da linha de comando, o exemplo usa o comando qwen2.5:7b responder cantando llava Dois modelos:

Instalação de dependências

Instale os pacotes de dependência adicionados, como fastapieduckduckgo responder cantando baidusearch. Execute no diretório raiz do projeto:

pip install -r requirements.txt

Início de projetos

Após a conclusão da instalação, inicie o projeto.

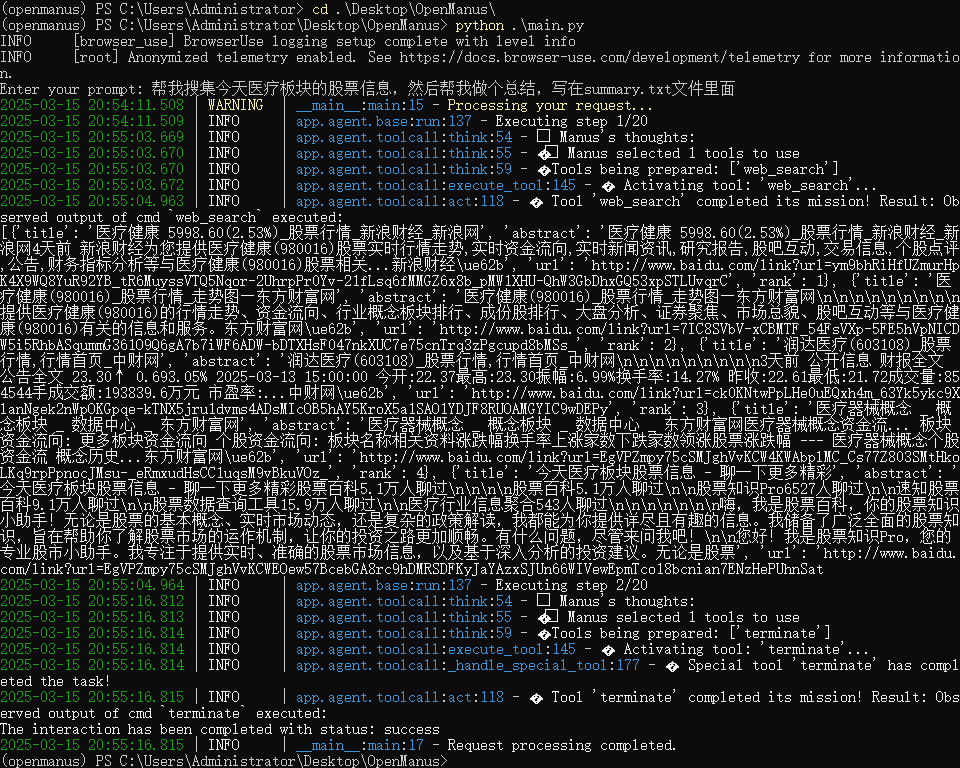

A versão Black Window pode ser usada run_flow.py talvez main.py Documentação:

python run_flow.py

# 或者

python main.py

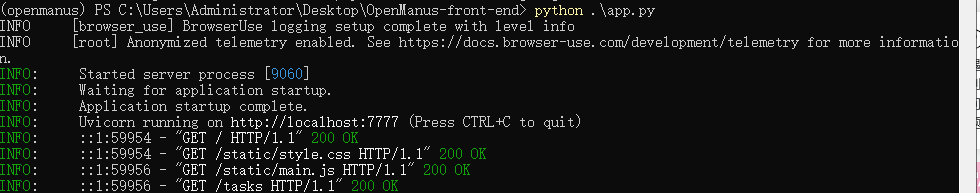

A versão da interface do usuário é iniciada com o seguinte comando:

python app.py

Início da missão

A versão com janela preta executa o efeito:

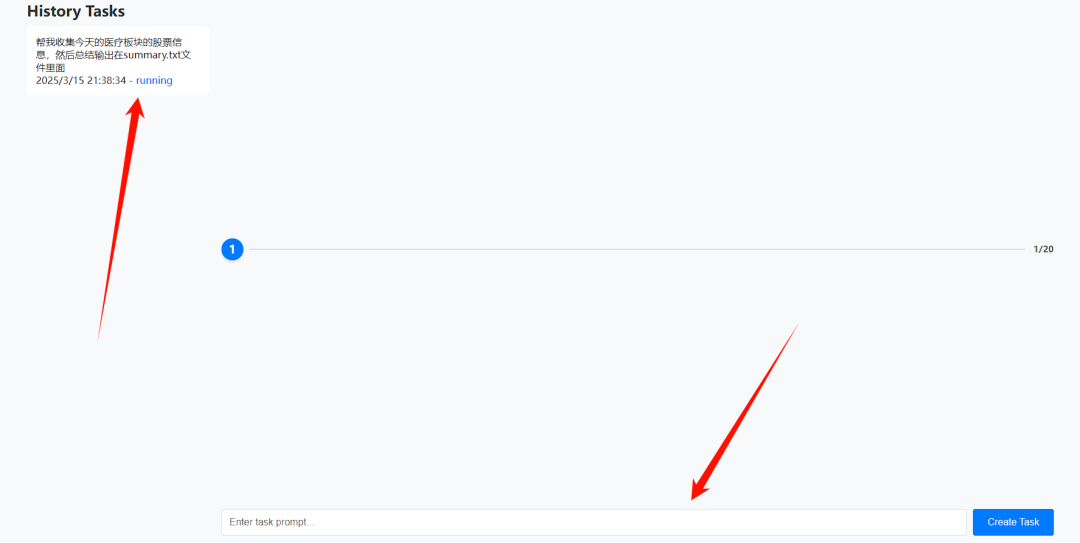

Quando a versão da interface do usuário é iniciada, ela salta automaticamente para a página da Web:

Digite a tarefa na caixa de entrada e clique em "Create Task" (Criar tarefa) para criar a tarefa.

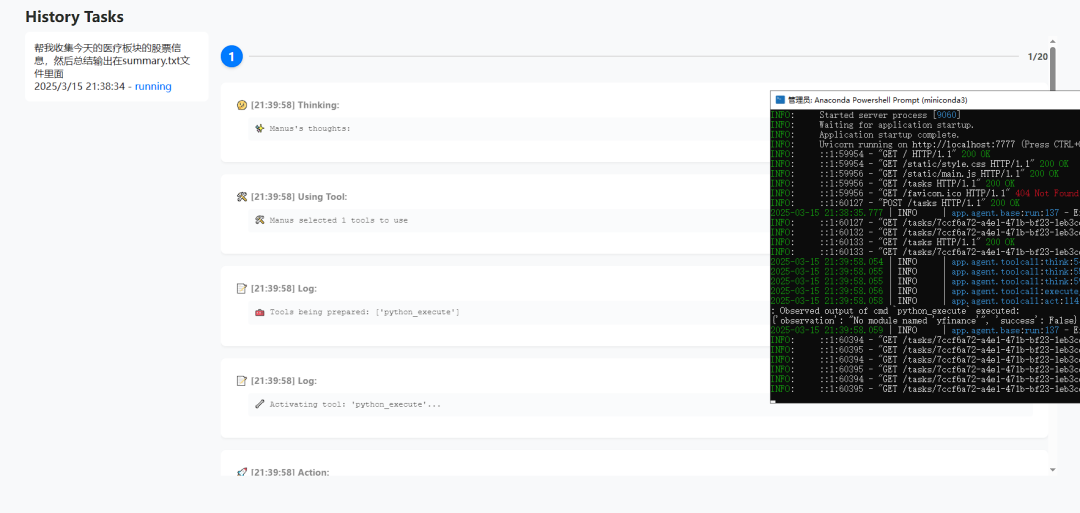

As execuções de tarefas podem ser visualizadas nas interfaces back-end e front-end:

Suporte à pesquisa do WeChat (experimental)

Um desenvolvedor enviou um Pull Request para o WeChat Search:https://github.com/mannaandpoem/OpenManus/pull/483

Esse recurso é implementado com base na tecnologia de pesquisa e rastreamento do Sogou WeChat. Devido à otimização da interface de pesquisa do OpenManus, talvez seja necessário reconfigurar o caminho original. Os usuários interessados podem tentar adaptá-lo por conta própria.