Introdução geral

O II-Researcher é uma ferramenta de pesquisa de IA de código aberto desenvolvida pela equipe da Intelligent-Internet e hospedada no GitHub, projetada para pesquisa profunda e raciocínio complexo, capaz de responder a perguntas complexas por meio de pesquisa inteligente na Web e análise em várias etapas. Lançado em 27 de março de 2025, o projeto é compatível com várias ferramentas de pesquisa e rastreamento (por exemplo, Tavily, SerpAPI, Firecrawl) e integra o LiteLLM para chamar diferentes modelos de IA. Os usuários podem obter o código gratuitamente e implantá-lo ou modificá-lo por conta própria, o que é adequado para pesquisadores, desenvolvedores e outras pessoas que precisam de processamento eficiente de informações. Sua essência está na operação de código aberto, configurável e assíncrona, fornecendo suporte transparente à pesquisa.

Lista de funções

- Pesquisa inteligente na Web: via Tavily e SerpAPI para obter informações precisas.

- Rastreamento e extração de páginas da Web: suporte a Firecrawl, Browser, BS4 e outras ferramentas para extrair conteúdo.

- Raciocínio em várias etapas: a capacidade de decompor um problema e raciocinar passo a passo para chegar a uma resposta.

- Modelos configuráveis: suporte para ajuste de LLMs para diferentes tarefas (por exemplo, GPT-4o, DeepSeek).

- Operações assíncronas: melhorando a eficiência da pesquisa e do processamento.

- Gerar respostas detalhadas: fornecer relatórios abrangentes com referências.

- Pipelines personalizados: os usuários podem ajustar o processo de pesquisa e raciocínio.

Usando a Ajuda

Processo de instalação

Para usar o II-Researcher, você precisa instalar e configurar o ambiente. Veja a seguir as etapas específicas:

- Clonagem da base de código

Digite o seguinte comando no terminal para fazer o download do código:

git clone https://github.com/Intelligent-Internet/ii-researcher.git

cd ii-researcher

- Instalação de dependências

O projeto requer o Python 3.7+. Execute o seguinte comando para instalar as dependências:

pip install -e .

- Definição de variáveis de ambiente

Configure as chaves e os parâmetros de API necessários. Exemplo:

export OPENAI_API_KEY="your-openai-api-key"

export TAVILY_API_KEY="your-tavily-api-key"

export SEARCH_PROVIDER="tavily"

export SCRAPER_PROVIDER="firecrawl"

Configuração opcional (para compressão ou inferência):

export USE_LLM_COMPRESSOR="TRUE"

export FAST_LLM="gemini-lite"

export STRATEGIC_LLM="gpt-4o"

export R_TEMPERATURE="0.2"

- Execução do servidor de modelo local LiteLLM

Instale o LiteLLM:

pip install litellm

Criação de arquivos de configuração litellm_config.yaml::

model_list:

- model_name: gpt-4o

litellm_params:

model: gpt-4o

api_key: ${OPENAI_API_KEY}

- model_name: r1

litellm_params:

model: deepseek-reasoner

api_key: ${OPENAI_API_KEY}

litellm_settings:

drop_params: true

Inicie o servidor:

litellm --config litellm_config.yaml

O padrão é executar no http://localhost:4000.

- Implantação do Docker (opcional)

Depois de configurar as variáveis de ambiente, execute:

docker compose up --build -d

Endereço de serviço:

- Front-end:

http://localhost:3000 - API de back-end:

http://localhost:8000 - LiteLLM:

http://localhost:4000

Funções principais

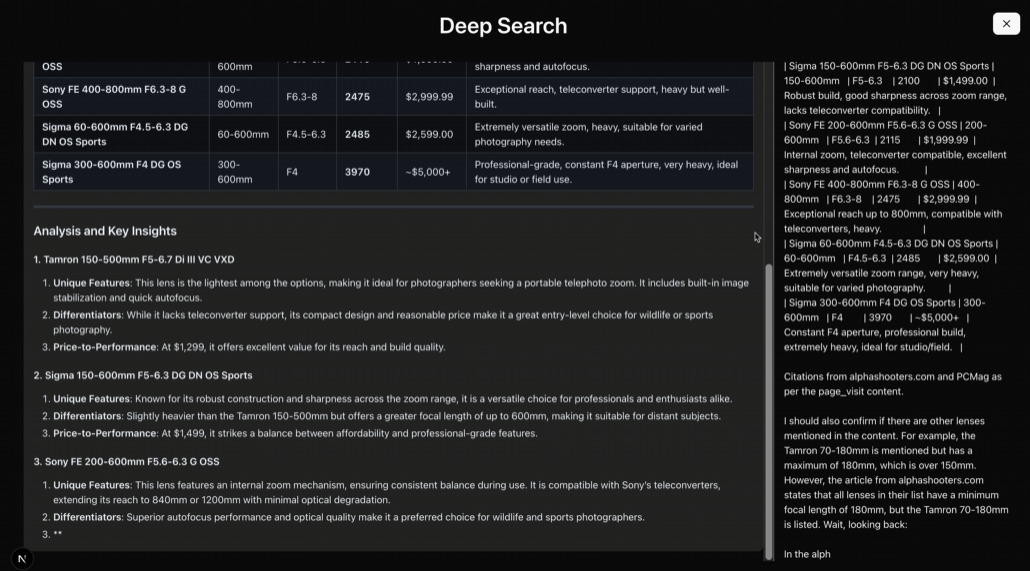

Pesquisa profunda inteligente

- procedimento::

- Execute-o na linha de comando:

python cli.py --question "AI如何改善教育质量?"

- O sistema chama o Tavily ou o SerpAPI para pesquisar e retornar resultados.

- Descrição funcionalSuporte a pesquisas de várias fontes, adequado para problemas complexos.

raciocínio em várias etapas

- procedimento::

- Use o modelo de inferência:

python cli.py --question "AI在教育中的优缺点" --use-reasoning --stream

- O sistema analisa e emite conclusões passo a passo.

- Descrição funcionalCapacidade de lidar com tarefas que exigem dedução lógica.

rastreador da web

- procedimento::

- configurar

SCRAPER_PROVIDER="firecrawl"e a chave da API. - Execute uma tarefa de pesquisa para rastrear automaticamente o conteúdo da Web.

- Descrição funcionalSuporte a várias ferramentas de rastreamento para garantir um conteúdo abrangente.

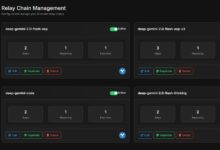

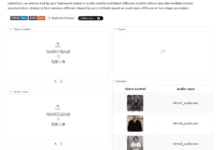

Uso da interface da Web

- procedimento::

- Inicie a API de backend:

python api.py

- entrar em

frontendinstale e execute o front-end:

npm install

npm run dev

- entrevistas

http://localhost:3000, problemas de entrada.

- Descrição funcionalInterface gráfica: Oferece uma interface gráfica para uma operação mais intuitiva.

advertência

- É necessária uma conexão de rede estável para acessar a API.

- Requisitos de hardware: 8 GB de RAM para funcionalidade básica, mais de 16 GB e GPU recomendados para inferência de modelos grandes.

- Verificação de registros: verifique os registros com o comando

docker compose logs -fVerifique o status de execução. - Configuração de tempo limite: Tempo limite de pesquisa padrão de 300 segundos, ajustável

SEARCH_PROCESS_TIMEOUT.

Com essas etapas, os usuários podem implementar e usar facilmente o II-Researcher para o processo completo, desde a pesquisa até a inferência.

cenário do aplicativo

- pesquisa acadêmica

Os pesquisadores podem usá-lo para pesquisar a literatura, analisar dados e gerar relatórios. - desenvolvimento de tecnologia

Os desenvolvedores podem desenvolver ferramentas de pesquisa personalizadas com base na estrutura. - Auxílios educacionais

Os alunos podem usá-lo para organizar informações e responder a perguntas. - análise de mercado

As empresas podem usá-lo para reunir informações do setor e gerar análises de tendências.

QA

- O II-Researcher é gratuito?

Sim, é um projeto de código aberto e o código é gratuito para os usuários. - Precisa de uma base de programação?

Requer conhecimento básico de operações em Python, mas a documentação é detalhada o suficiente para que os iniciantes possam começar. - Ele é compatível com o idioma chinês?

Suporte, configure o modelo e a ferramenta de pesquisa corretos para lidar com a tarefa chinesa. - Quais são os requisitos mínimos de hardware?

8 GB de RAM para executar funções básicas, mais de 16 GB e GPU recomendados para tarefas grandes.