Recentemente, o campo da modelagem de linguagem em larga escala tem recebido cada vez mais atenção do setor como um novo paradigma para a aprendizagem por reforço nos estágios finais do treinamento. Após a introdução de modelos da série O, como o GPT-4o da OpenAI e o DeepSeek-R1 do lançamento, o excelente desempenho do modelo demonstra o papel fundamental do aprendizado por reforço no processo de otimização.

A equipe do Tencent Mixed Meta Model também fez progressos significativos recentemente. Em meados de fevereiro deste ano, a equipe lançou o modelo de inferência Mixed Yuan T1-Preview com base em uma base Mixed Yuan de tamanho médio no aplicativo Tencent Yuanbao. Agora, o modelo Deep Thinking da série Mixed Meta Model foi atualizado para a versão oficial do Mixed Meta-T1.

Endereço de experiência:

https://llm.hunyuan.tencent.com/#/chat/hy-t1

https://huggingface.co/spaces/tencent/Hunyuan-T1

O Hybrid-T1 é baseado na versão do início de março do TurboS O TurboS é o primeiro Modelo Misto de Especialização (MoE) em hiperescala do mundo, que incorpora o modelo de especialização de alta qualidade. Transformador e as arquiteturas Mamba. Com o pós-treinamento em larga escala, os recursos de inferência do Mamba-T1 são significativamente ampliados e mais bem alinhados com as preferências humanas.

O Hybrid-T1 tem vantagens exclusivas no raciocínio profundo. Em primeiro lugar, o recurso de captura de textos longos do TurboS ajuda a resolver com eficácia os problemas comuns de perda de contexto e dependência de informações remotas na inferência de textos longos. Em segundo lugar, a arquitetura Mamba é especificamente otimizada para sequências longas e reduz significativamente o consumo de recursos computacionais por meio de métodos computacionais eficientes, garantindo a capacidade de capturar informações textuais longas. Sob as mesmas condições de implantação, a velocidade de decodificação é aumentada em um fator de 2.

Na fase posterior de treinamento do modelo, 96,7% dos recursos computacionais são investidos no treinamento de aprendizado por reforço, com foco no aprimoramento da inferência pura e na otimização do alinhamento com as preferências humanas.

Para atingir esse objetivo, a equipe de pesquisa coletou problemas científicos e de raciocínio de classe mundial, abrangendo as áreas de matemática, raciocínio lógico, ciência e código. Esses conjuntos de dados abrangem uma ampla gama de tarefas, desde o raciocínio matemático básico até a solução de problemas científicos complexos. Isso, combinado com feedback real (ground-truth), garante que o modelo tenha um bom desempenho diante de uma ampla gama de tarefas de raciocínio.

O treinamento foi conduzido usando uma abordagem de aprendizagem curricular (CLE), que aumenta progressivamente a dificuldade dos dados e, ao mesmo tempo, expande progressivamente o comprimento do contexto do modelo, de modo que o modelo aprende a utilizar efetivamente a capacidade de raciocínio e, ao mesmo tempo, melhora a token Raciocínio.

Em termos de estratégias de treinamento, as estratégias clássicas de aprendizado por reforço, como repetição de dados e redefinição periódica de políticas, são emprestadas para melhorar a estabilidade de longo prazo do treinamento do modelo em mais de 50%. Na fase de alinhamento com as preferências humanas, um esquema unificado de feedback do sistema de recompensa, incluindo auto-recompensa (avaliação abrangente e pontuação da saída do modelo com base em uma versão anterior do T1-Preview) e modos de recompensa, é usado para orientar o modelo para o auto-aperfeiçoamento. Os modelos mostram detalhes de conteúdo mais ricos e informações mais eficientes em suas respostas.

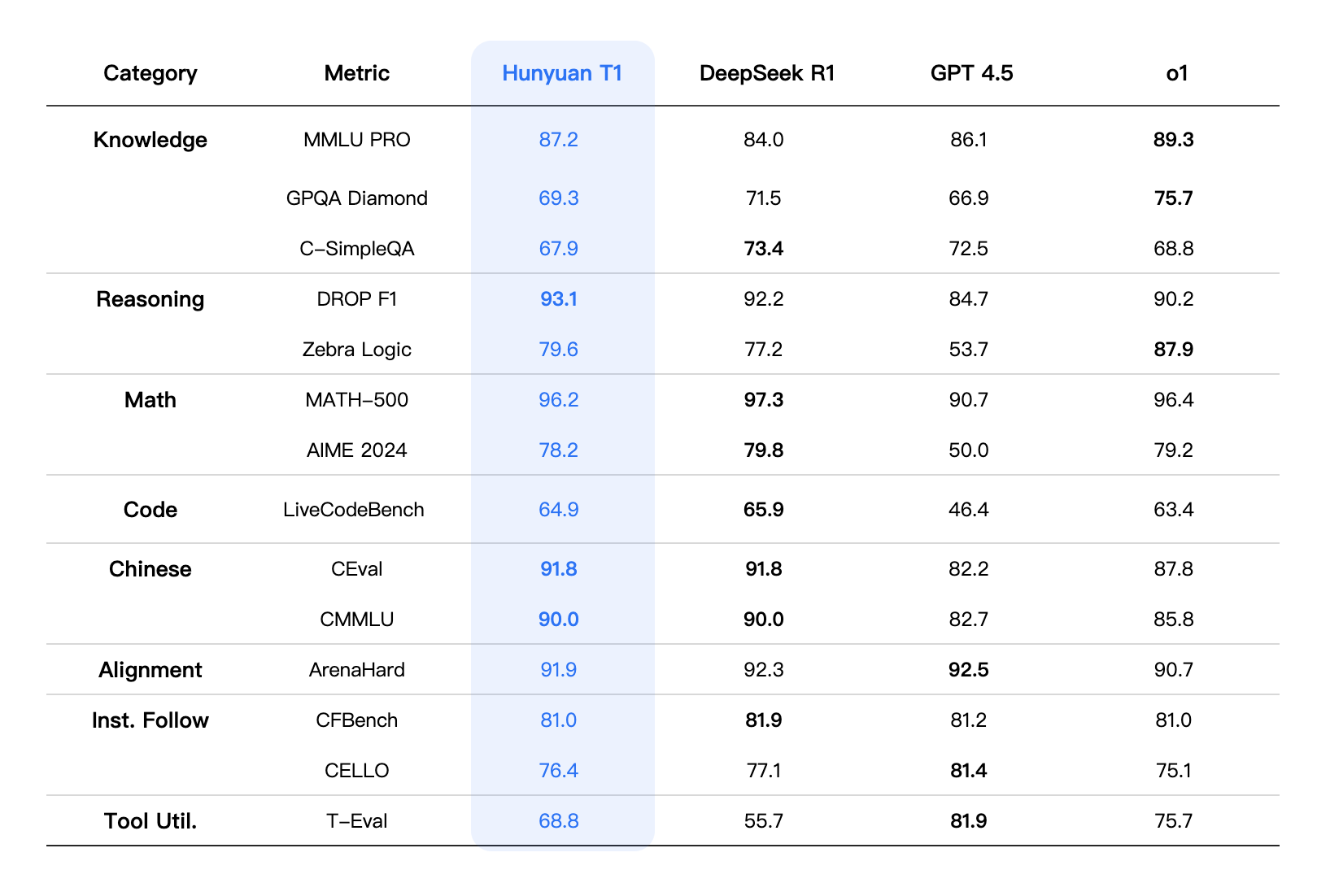

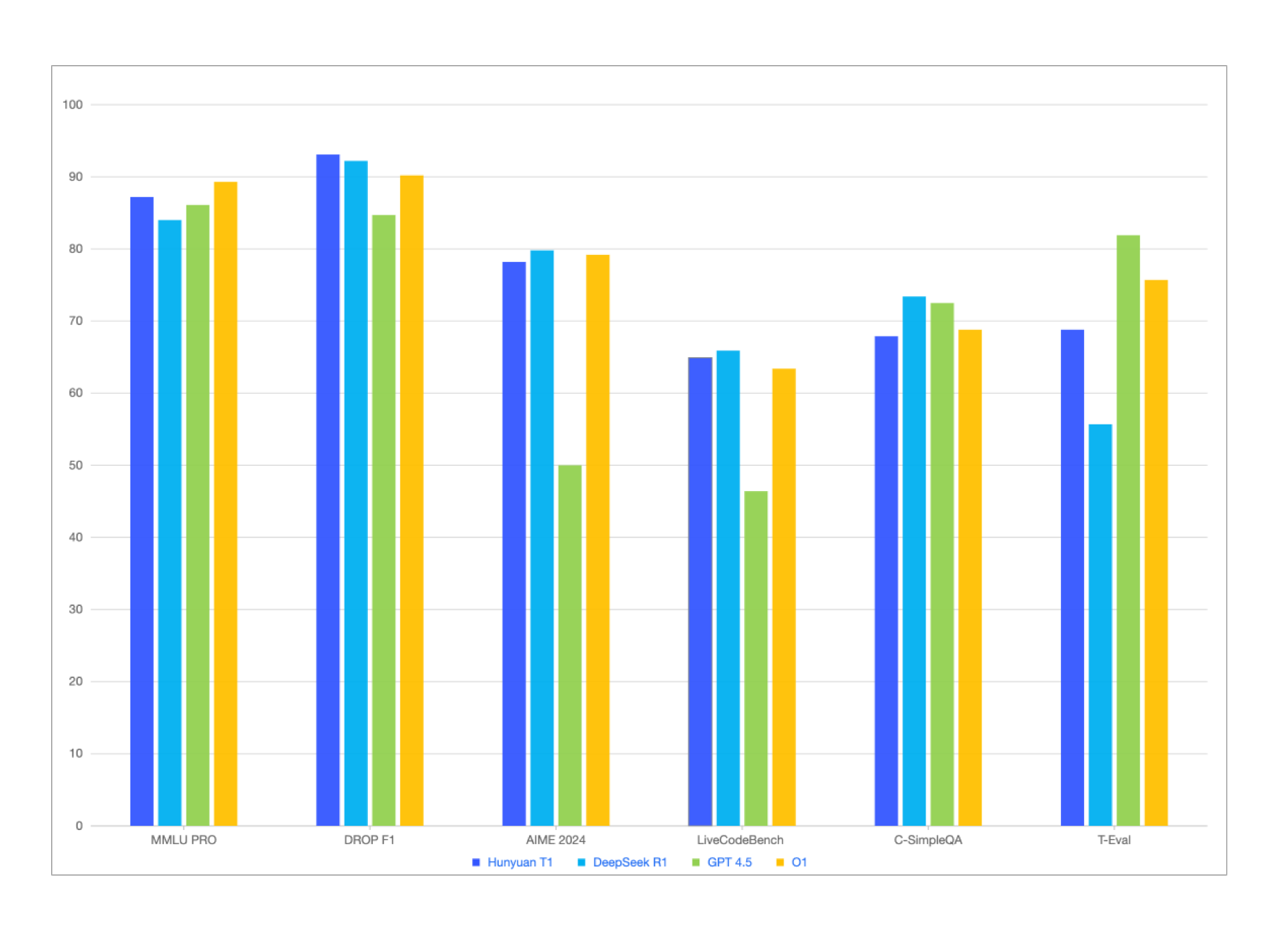

Além de obter resultados comparáveis ou ligeiramente melhores do que o DeepSeek-R1 em testes públicos de benchmark de conhecimento de chinês e inglês, matemática em nível de competição e raciocínio lógico, como MMLU-pro, CEval, AIME, Zebra Logic e outros, o Mixed Elements-T1 também tem um bom desempenho em conjuntos de dados de avaliação humana interna, com ligeiras vantagens no acompanhamento de instruções culturais e criativas, resumo de texto e competência de corpo inteligente. .

Em termos de métricas de avaliação abrangentes, o desempenho geral do Hybrid-T1 é comparável ao de um modelo de inferência de fronteira de primeira classe. Na avaliação de capacidade abrangente, o T1 está em MMLU-PRO Em segundo lugar na lista, apenas o O1, ganhando 87.2 de pontuações altas. O conjunto de testes abrange perguntas em 14 áreas de humanidades, ciências sociais, ciências e engenharia, e se concentra em testar a memória e a compreensão do modelo de uma ampla gama de conhecimentos. Além disso, ao se concentrar no conhecimento de domínio especializado e no raciocínio científico complexo GPQA-diamante(T1 obteve os seguintes resultados (principalmente problemas de nível de doutorado em física, química e biologia) 69.3 O placar.

Os cenários que exigem fortes habilidades de raciocínio, como codificação, matemática e raciocínio lógico, foram testados em ciências e engenharia. Na LiveCodeBench Na avaliação do código, T1 alcançou 64.9 Pontuação. Enquanto isso, T1 se destacou em matemática. Particularmente em MATH-500 Além disso, ele fez 96.2 Os excelentes resultados, após o DeepSeek-R1, demonstraram a capacidade abrangente de T1 em resolver problemas matemáticos. Além disso, T1 demonstrou forte adaptabilidade em várias tarefas de alinhamento, tarefas de acompanhamento de comandos e tarefas de utilização de ferramentas. Por exemplo, o desempenho de T1 na tarefa ArenaHard A missão foi premiada com o 91.9 O placar.

efeito de modelagem

Observação: Os indicadores de avaliação dos outros modelos da tabela são provenientes dos resultados oficiais da avaliação. Para as partes que não estão incluídas nos resultados da avaliação oficial, os dados são provenientes da plataforma de avaliação interna da Hybrid.